1.本公开属于语音分离技术领域,尤其涉及一种多模态语音分离方法及系统。

背景技术:

2.本部分的陈述仅仅是提供了与本公开相关的背景技术信息,不必然构成在先技术。

3.在生活中经常需要接触各种各样的混合声音,其中人与人的混合声音是最常需要处理的。在多种声音混杂的环境中,人们有能力将注意力集中到某一个人的声音而忽略其他人的声音和环境噪声,这种现象被称为鸡尾酒会效应。由于人耳听觉系统具有强大的声音信号处理能力,因此可以很轻松地对混合声音进行分离。随着生活的智能化,语音分离技术在各种语音交互设备中起到了重要的作用,然而对于计算机而言,如何能够高效实现语音分离,一直是一个比较困难的问题。

4.目前语音分离技术具有非常广泛的应用,例如在语音识别的前端加上语音分离技术,把目标说话人的声音和其它干扰声音分开,从而提高语音识别系统的鲁棒性。正是由于语音分离技术可以给后续的语音信号处理带来帮助,因此越来越多的人将注意力放在了语音分离上。在过去的几十年里各种各样的语音分离算法被提出,它们被证实可以有效提升语音分离的性能。尽管如此,语音分离技术仍然有较大的发展空间。

5.大多数人只利用了声音特征信息进行语音分离。其中有一些传统的方法,例如基于独立成分分析(ica)的方法、基于计算听觉场景分析(casa)的方法、基于高斯混合模型(gmm)的方法等。ica是一种用于将多元信号分离为加性子分量的计算方法,通过寻找多维数组中的统计独立和非高斯成分来实现对语音信号的分离,可以实现对语音信号的快速分析和处理,因此广泛应用到了盲源分离上[blind equalisation using approximate maximum likelihood source separation][adaptive blind source separation with hrtfs beamforming preprocessing][convolutive blind source separation applied to the wireless communication]。casa利用计算机技术,通过计算机模仿人类对听觉信号的处理过程进行建模,从而仿照人类从复杂的混合声源中感知声音、处理声音、解释声音。

[0006]

参考文献[speech segregation based on sound localization]将理想二值掩蔽(ideal binary mask,ibm)与casa方法相结合,构建了一个新的语音分离模型,提高了分离后语音的可懂度。gmm是一种使用了高斯分布作为参数模型的聚类算法,它在单通道语音分离方法中得到了广泛的应用。

[0007]

参考文献[soft mask methods for single

‑

channel speaker separation]提出了用gmm解决单通道语音分离的方法,利用em(expectation maximization,简称em)算法学习gmm的参数。但它仍然具有缺点,源分布的阶数难以选择,对初始化依赖比较大,实现起来十分复杂。

[0008]

随着深度学习的快速发展,一些优秀的算法被提出,如卷积神经网络(cnn)、循环

神经网络(rnn)等。人工神经网络由于其强大的非线性映射能力,大大提高了监督学习任务的性能,因此被越来越多的人所关注。目前,在已经被提出的基于深度学习的语音分离算法中,大多数在数据预处理过程中使用短时傅里叶变换(stft)等时频分解技术将声音转化为语谱图,而在最近几年出现了直接将原始声音信号作为输入的端到端语音分离方法。

[0009]

参考文献[joint optimization of masks and deep recurrent neural networks for monaural source separation]提出一种基于深度循环神经网络的语音分离方法,通过利用共同优化多目标源的时频掩蔽,实现了更稳健的分离性能。由于传统的rnn存在梯度消失问题,一种有效的解决方法是引入门控机制来控制信息的累积速度,lstm便是典型的代表之一。

[0010]

文献[long short

‑

term memory for speaker generalization in supervised speech separation]在语音分离算法中使用lstm网络代替rnn网络,结果发现分离性能得到了提升。另外,与使用声音语谱图作为输入不同的是,文献[tasnet:time

‑

domain audio separation network for real

‑

time,single

‑

channel speech separation]提出了一种在时域上进行端到端语音分离的模型tasnet,以声音时序信号作为输入,结合一维卷积和lstm,最终直接输出干净的声音信号。最近,人们发现使用时间卷积网络(tcn)在序列建模中十分有效,而tcn可以直接作用于一维的时序信号,因此一些基于tcn的端到端语音分离方法被提出。

[0011]

文献[furcanext:end

‑

to

‑

end monaural speech separation with dynamic gated dilated temporal convolutional networks]在tasnet的基础上提出了基于tcn的单声道端到端语音分离的四种改进模型,其中的furcapy模型使用了多流tcn提取声音的特征,而其他三种模型直接修改tcn的内部结构,从而在语音分离任务中提升性能。

[0012]

前面的方法仅利用了声音信号。然而,在人类语音感知过程中,通常会自动或者无意识地利用视觉信息[visual speech recognition:lip segmentation and mapping]。在听说话人讲话时,人们不仅会将注意力专注于说话人发出的声音,同时还会看说话人的嘴唇,从而更好地倾听说话人的声音。并且只用声音进行语音分离还存在置换问题。随着智能设备的不断发展,获取说话人的视觉信息也变得越来越便捷。视觉信息可以对语音分离模型进行信息补充,由于一些音素在视觉上更容易区分[cochleanet:arobust language

‑

independent audio

‑

visual model for real

‑

time speech enhancement],并且当某个说话人处于无声状态时,视觉信息更容易判断。因此,相比于只用声音,将视频与音频相结合,避免了单一模态获得信息的片面性以及不确定性,从而提升语音分离的性能。近年来,许多人充分利用视觉信息,提出了一些音视频融合语音分离算法。google在2018年提出一种基于深度学习的音视频融合语音分离算法[looking to listen at the cocktail party:a speaker

‑

independent audio

‑

visual model for speech separation],其中将cnn与lstm网络相结合来提取声音和视频特征,以复数域理想比值掩蔽(complex ideal ratio mask,cirm)作为训练目标,并通过cirm与混合声音语谱图相乘得到干净的说话人声音。该模型实现了说话人独立,相比于只用语音的算法,性能有明显的提升。由于网络参数过多,在训练过程中难免会出现过拟合的现象。为了解决这个问题,文献[two stage audio

‑

video speech separation using multimodal convolutional neural networks]提出一种具有两个av模型的系统,以分离所需的语音信号。对两个模型分开训练,第一个av模型训练完成

后,其输出和视频特征将被用于训练第二个av模型。此外,文献[audio

‑

visual deep clustering for speech separation]采用了无监督学习方法,提出一种具有两次特征融合的语音分离模型(avdc),其中利用视觉信息可以更好地帮助时频单元的聚类,相比于只用声音的语音分离模型,avdc的分离效果更好,并且解决了跨帧的源置换问题。除了声音频域处理的方法,也有一些人在端到端语音分离的基础上融入了视觉信息。

[0013]

文献[time domain audio visual speech separation]在tasnet的基础上结合了视觉信息,实现了多模型学习,通过实验证明该模型相比于只使用声音的方法效果更好。

[0014]

综上所述,以上文献中只使用一个特征提取器来提取全频段的声音,即在每个频率上使用的特征提取器是相同的,获得数据效果不够好,另外,现有的说话人个数是在设计网络参数时已经固定好的,即模型是静态的,训练和测试的过程中必须使用固定的说话人个数,无法灵活改变输入的数量,因此,现有的语音分离技术有待进一步的改进。

技术实现要素:

[0015]

为克服上述现有技术的不足,本公开提供了一种多模态语音分离方法,所选的模型相比其他模型更加有效。

[0016]

为实现上述目的,本公开的一个或多个实施例提供了如下技术方案:

[0017]

第一方面,公开了一种多模态语音分离方法,包括:

[0018]

接收待识别对象的混合声音及待识别对象的面部视觉信息,并通过人脸检测得出说话人的数量;

[0019]

将上述数据进行预处理获得混合语音的复语谱图以及说话人的人脸图像并传输至多模态语音分离模型中,根据说话人的数量动态调整模型的结构,其中,所述多模态语音分离模型在训练过程中,使用复数域理想比值掩蔽cirm作为训练目标,cirm在复数域中定义为干净声音语谱图与混合声音语谱图之间的比率,由实部与虚部组成并且包含了声音的幅值与相位信息;

[0020]

所述多模态语音分离模型输出对应说话人的数量的cirm;

[0021]

将输出的cirm与混合声音的语谱图进行复数相乘便得到干净声音的语谱图,对干净声音的语谱图作短时傅里叶逆变换计算得到干净声音的时域信号,从而完成语音分离。

[0022]

进一步的技术方案,所述混合声音可以看作是将多个说话人的干净声音通过相加得到的,对于时域上的混合声音信号,通过stft将其转化为可以作为语音分离模型的输入的复语谱图。

[0023]

进一步的技术方案,当每个实例输入所述多模态语音分离模型之前,根据说话人的数量动态调整模型的结构;

[0024]

进一步的技术方案,所述多模态语音分离模型由声音特征提取网络、视觉特征提取网络以及音视频融合网络组成;

[0025]

声音特征提取网络中使用不同的cnn分别提取高频与低频声音特征;

[0026]

将低频声音特征和高频声音特征连接起来,实现第一阶段融合,接着使用tcn继续提取声音特征;

[0027]

视觉特征提取网络,对于输入的人脸图像,使用多个卷积层提取视觉特征,并且给每个卷积核插入“空洞”来变相增加其大小,以此来增加感受野;

[0028]

音视频融合网络,将经过声音特征提取网络和视觉特征提取网络后得到的声音特征与视觉特征进行连接,得到音视频融合特征,实现特征的第二阶段的融合。

[0029]

优选的,使用不同的特征提取器分别提取高频与低频声音特征,具体为:

[0030]

通过stft将混合声音的时域信号转化为复语谱图,接着在频率维度上将复语谱图分割成高频部分和低频部分;

[0031]

分别使用两流cnn提取低频声音特征和高频声音特征,其中每个流包含了两个卷积层,对于提取高频特征的网络层和提取低频特征的网络层,使用不同的膨胀参数。

[0032]

将高频声音特征与低频声音特征进行融合,实现特征的第一阶段融合。

[0033]

优选的,将tcn内的一维卷积网络层修改为二维卷积网络层,使得tcn能够处理声音特征提取网络的输出数据;

[0034]

优选的,对视觉特征提取网络的输出进行上采样以补偿音频和视频信号之间的采样率差异。

[0035]

将声音特征与视觉特征进行融合,实现特征的第二阶段融合。

[0036]

进一步的技术方案,所述多模态语音分离模型将音视频融合后的特征输入到全连接层,全连接层输出对应说话人数量个cirm,其中每个cirm都对应一个识别对象,这些掩蔽对应说话人的顺序与在视觉特征提取网络中的说话人顺序相同。

[0037]

第二方面,公开了一种多模态语音分离系统,包括:

[0038]

数据接收模块,接收待识别对象的混合声音及待识别对象的面部视觉信息;

[0039]

多模态语音分离模型处理模块,将上述信息进行处理获得复语谱图以及人脸图像并传输至多模态语音分离模型中,利用说话人的数量动态调整模型的结构,其中,所述多模态语音分离模型在训练过程中,使用复数时频掩蔽作为训练目标;

[0040]

所述多模态语音分离模型输出对应人脸的数量的复数时频掩蔽;

[0041]

语音分离模块,将输出的掩蔽与混合声音的语谱图进行复数相乘便得到干净声音的语谱图,对干净声音的语谱图作短时傅里叶逆变换计算得到干净声音的时域信号,从而完成语音分离。

[0042]

以上一个或多个技术方案存在以下有益效果:

[0043]

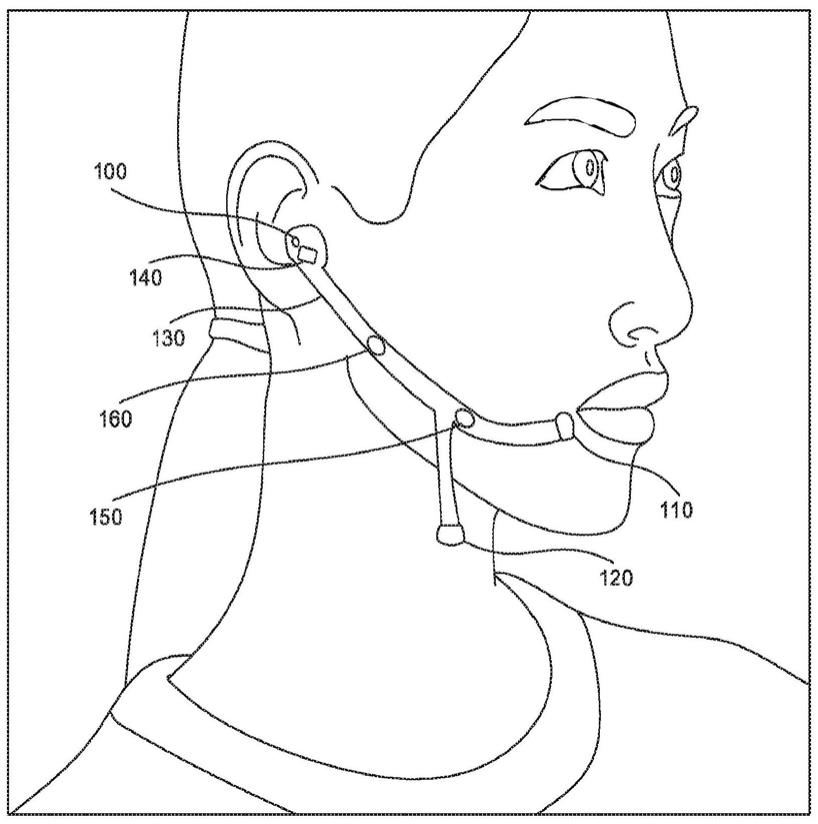

在本公开技术方案中,公开了一个多模态语音分离系统来解决鸡尾酒会问题,如图1所示。基于人的听觉系统具有强大的语音分离能力,因此本公开技术方案的语音分离系统时参考了人的相关生理特征。人耳接受声音的部位是耳蜗,它可以将不同频率的声音映射到基底膜的不同位置。基于耳蜗的这一特性,在声音特征提取网络中使用多流卷积网络模拟耳蜗在不同频率范围的特征提取滤波器,分别提取声音的高频部分和低频部分的特征。同时本公开技术方案的模型包含了针对特征的两个阶段的融合:高频声音特征与低频声音特征的融合、声音特征与视觉特征的融合。其中,使用改进后的tcn处理高频与低频声音的融合特征,并且将视觉信息加入语音分离模型中以提升语音分离的性能。对于每个实例,模型的网络结构以及最终输出的声音个数由视频中的说话人数量来决定,因此模型具有灵活性,适用于任意数量说话人的语音分离。

[0044]

由于耳蜗中基底膜的不同部位可以处理不同频率的声音,本公开技术方案使用了两个不同的特征提取器分别提取声音的高频部分特征和低频部分特征。

[0045]

本公开技术方案将语音分离模型与人脸检测结合起来,使得系统可以识别出视频

中有多少个说话人,因此可以动态调整模型的结构。

[0046]

针对只利用了声音信息进行语音分离的现有技术存在置换问题,本公开技术方案将音视频结合来固定多个输出的顺序,从而解决了置换问题,并且视觉信息可以作为语音分离系统的补充部分,使得性能进一步提升。

[0047]

针对现有技术使用rnn进行时间序列建模,需要训练的参数数量大,耗时长,还可能存在梯度爆炸和梯度消失问题。本公开技术方案使用tcn代替lstm,tcn的优点主要有:并行性、灵活的感受野、稳定的梯度、内存更低。

[0048]

本公开技术方案选择sdr为评价指标,通过实验,将本公开技术方案的模型与其他优越的模型进行比较,并通过一些辅助实验验证模型的可行性。

[0049]

本发明附加方面的优点将在下面的描述中部分给出,部分将从下面的描述中变得明显,或通过本发明的实践了解到。

附图说明

[0050]

构成本公开的一部分的说明书附图用来提供对本公开的进一步理解,本公开的示意性实施例及其说明用于解释本公开,并不构成对本公开的不当限定。

[0051]

图1为本公开实施例语音分离系统图;

[0052]

图2为本公开实施例多模态语音分离模型结构图;

[0053]

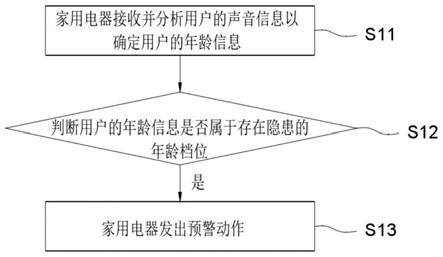

图3为本公开实施例tcn网络的改进图。

具体实施方式

[0054]

应该指出,以下详细说明都是示例性的,旨在对本公开提供进一步的说明。除非另有指明,本文使用的所有技术和科学术语具有与本公开所属技术领域的普通技术人员通常理解的相同含义。

[0055]

需要注意的是,这里所使用的术语仅是为了描述具体实施方式,而非意图限制根据本公开的示例性实施方式。如在这里所使用的,除非上下文另外明确指出,否则单数形式也意图包括复数形式,此外,还应当理解的是,当在本说明书中使用术语“包含”和/或“包括”时,其指明存在特征、步骤、操作、器件、组件和/或它们的组合。

[0056]

在不冲突的情况下,本公开中的实施例及实施例中的特征可以相互组合。

[0057]

整体构思:

[0058]

在多种声音混杂的环境中,往往需要分离出自己感兴趣的声音,便于进行后续的语音处理。然而,对于计算机而言,如何能够高效实现语音分离,一直是一个比较困难的问题。在本公开技术方案中,提出了一个基于深度学习的多模态语音分离模型来解决鸡尾酒会问题。模型充分利用了声音信息和说话人的视觉信息,并采用了两阶段特征融合的策略:高频率声音特征与低频率声音特征融合、声音特征与视频特征的融合。其中,使用多流卷积分别处理高频和低频声音,并将它们的输出连接起来作为时间卷积网络的输入从而实现声音特征提取。得到的声音特征与空洞卷积层输出的视觉特征相结合,经过全连接层后完成语音分离。另外,在数据预处理阶段,通过dlib库检测视频中说话人的数量并动态调整网络结构,因此可以自动判断出需要输出多少个干净声音。本公开使用的数据集为grid,为了充分利用声音的相位信息,选择cirm作为模型的训练目标。通过一系列实验,证明本公开模型

的性能要比其它方法更优越。另外,通过额外的实验证明本公开的模型相比于谷歌提出的模型在不影响性能的条件下训练速度更快,同时验证了视觉信息确实对语音分离性能的提升有所帮助。

[0059]

实施例一

[0060]

参见附图1所示,本实施例公开了一种多模态语音分离方法,包括:

[0061]

接收待识别对象的混合声音及待识别对象的面部视觉信息,并通过人脸检测得出说话人的数量;

[0062]

将上述信息进行处理获得复语谱图以及人脸图像并传输至多模态语音分离模型中,利用说话人的数量动态调整模型的结构,其中,所述多模态语音分离模型在训练过程中,使用复数域理想比值掩蔽cirm作为训练目标,cirm在复数域中定义为干净声音语谱图与混合声音语谱图之间的比率,由实部与虚部组成并且包含了声音的幅值与相位信息;

[0063]

所述多模态语音分离模型输出对应待识别对象的数量的cirm;

[0064]

将输出的cirm与混合声音的语谱图进行复数相乘得到干净声音的语谱图,对干净声音的语谱图作短时傅里叶逆变换计算得到干净声音的时域信号,从而完成语音分离。

[0065]

在具体实施例子中,语音分离可以看做是通过多个说话人的声音组成的混合声音x(t),估计出每个说话人的声音s1(t),

…

,s

c

(t)。其中混合声音x(t)可以看做是c个说话人的干净声音通过相加得到:

[0066][0067]

对于时域上的混合声音信号,通过短时傅里叶变换将其转化为可以作为语音分离模型的输入的复语谱图x,它包含了实部与虚部。对于视频流,首先将视频转化为视频帧,然后使用dlib判断视频中人脸的个数c,并将所有人脸提取出来作为模型的输入。

[0068]

在模型的训练过程中,使用了时频掩蔽作为训练目标,即对于每个说话人,模型都将预测一个时频掩蔽。从文献中可以看出,相比于直接预测干净声音的语谱图或者时域波形,将掩蔽作为训练目标会使语音分离系统具有更好的性能[on training targets for supervised speech separation][supervised speech separation based on deep learning:an overview]。同时,文献[the importance of phase in speech enhancement]中指出,声音的相位信息对语音分离也有很大的帮助。使用的时频掩蔽为cirm(complex ideal ratio mask),它在复数域中定义为干净声音语谱图与混合声音语谱图之间的比率,由实部与虚部组成[complex ratio masking for monaural speech separation],并且包含了声音的幅值与相位信息。由于检测到c个说话人的人脸,因此模型输出c个cirm,使用m1、m2、

…

、m

c

表示每个说话人对应的cirm。然后,将它们与混合声音的语谱图进行复数相乘便得到干净声音的语谱图:

[0069]

y

n

(t)=m

n

*x,n=1,2,...,c

[0070]

其中,

‘

*’表示复数乘法,x表示输入的混合声音信号通过stft转换得到的复语谱图,最终,对这些干净声音的语谱图作短时傅里叶逆变换(istft)计算就可以得到干净声音的时域信号,从而完成语音分离。

[0071]

下面详细介绍多模态语音分离模型,它由声音特征提取网络、视觉特征提取网络

以及音视频融合网络组成,模型结构如图2所示,以两个人为例,下面将对模型进行详细介绍。

[0072]

关于声音特征提取网络,在声音特征提取网络的设计中参考了耳蜗的特征。由于人类通过听觉系统可以识别并分离不同频率的声音,因此可以很轻易的解决鸡尾酒效应问题。耳蜗在声音处理过程中扮演着重要的角色,它可以将不同频率的声音映射到不同位置的基底膜,其中耳蜗底部的基底膜可以处理高频声音,耳蜗顶部的基底膜可以处理低频声音。另外在文献[tasnet:time

‑

domain audio separation network for real

‑

time,single

‑

channel speech separation]中,作者设计并训练了基于cnn的特征提取滤波器,使网络自己寻找适合于语音分离的滤波器,并通过特征的频率响应图发现,滤波器在低频和高频处的频率分辨率不同,具体来说就是低频部分分辨率高,高频部分分辨率低,从而说明提取低频声音和高频声音特征所对应的最佳滤波器在性质方面有所不同。因此,考虑使用不同的cnn分别提取高频与低频声音特征。首先通过stft将混合声音的时域信号转化为复语谱图,接着在频率维度上将复语谱图分割成高频部分和低频部分。受到耳蜗的启发,分别使用两流cnn提取低频声音特征和高频声音特征,其中每个流包含了两个卷积层,每个卷积层包含了32个大小为25

×

5的卷积核。对于提取高频特征的网络层,第一个卷积层的膨胀参数设置为1

×

1,第二个卷积层的膨胀系数设置为2

×

1。对于提取低频特征的网络层,统一将膨胀参数设置为1

×

1。

[0073]

本公开技术方案将低频声音特征和高频声音特征连接起来,实现第一阶段融合,接着使用tcn继续提取特征。tcn不仅可以并行处理数据,有效防止梯度爆炸,同时还具有较强的灵活性[an empirical evaluation of generic convolutional and recurrent networks for sequence modeling],因此越来越多的人考虑将tcn代替lstm处理序列数据。由于传统的tcn内部采用了一维卷积,只能以一维数据作为输入,在端到端语音分离模型中比较常用。在这里,由于并没有直接采用原始声音信号作为输入,而是将其通过stft转化为复语谱图,这就需要使用二维卷积处理数据。将tcn内的一维卷积修改为二维卷积,使得tcn可以正常处理前面网络层的输出数据。tcn的内部结构改进如图3所示。一共使用了8层tcn,并在每层tcn后面使用批标准化来防止过拟合。

[0074]

关于视觉特征提取网络,对于输入的人脸图像,使用6个卷积层提取视觉特征,并且给每个卷积核插入“空洞”来变相增加其大小,以此来增加感受野。其中,卷积层中包含的卷积核个数分别为32,48,64,128,256,256,每个卷积核的大小为5

×

1。与声音特征提取网络类似,在每个卷积层后面使用批标准化来防止过拟合。最后,为了补偿音频和视频信号之间的采样率差异,对视觉特征提取网络的输出进行上采样。

[0075]

需要提出的是,由于混合声音是由至少两个人的声音组成,因此在视觉特征提取的过程中需要输入多个说话人的人脸。为了实现说话人无关,在提取不同说话人的视觉特征的过程中,实现了权重共享,即使用参数相同的网络提取人脸特征,这使得视觉特征提取网络具有泛化性。

[0076]

关于音视频融合网络,当混合声音和说话人的视觉信息分别经过声音特征提取网络和视觉特征提取网络后,得到了声音特征与视觉特征。接下来将它们进行连接,得到音视频融合特征,实现了特征的第二阶段的融合。然后将融合后的特征输入到全连接层(fc),其中在全连接层中使用非线性的relu激活函数。这里使用3个全连接层处理融合特征,每个全

连接层包含了500个单元。全连接层输出c个cirm,其中每个掩蔽都对应一个说话人。这些掩蔽对应说话人的顺序与在音视频融合过程中视觉特征的连接所对应的说话人顺序相同,这样就解决了只用声音进行语音分离的过程中因标签排列而存在的置换问题。分别将cirm与混合声音的复语谱图进行复数相乘,得到对应说话人的干净声音的复语谱图。最后,通过istft,将每个人对应的复语谱图转化为干净的声音信号。

[0077]

实施例二

[0078]

本实施例的目的是提供一种计算装置,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现上述方法的步骤。

[0079]

实施例三

[0080]

本实施例的目的是提供一种计算机可读存储介质。

[0081]

一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时执行上述方法的步骤。

[0082]

实施例四

[0083]

本实施例的目的是提供了一种多模态语音分离系统,包括:

[0084]

数据接收模块,接收待识别对象的混合声音及待识别对象的面部视觉信息;

[0085]

多模态语音分离模型预处理模块,将上述数据进行预处理获得复语谱图以及人脸图像并传输至多模态语音分离模型中,利用说话人的数量动态调整模型的结构,其中,所述多模态语音分离模型在训练过程中,使用cirm作为训练目标,它由实部与虚部组成并且包含了声音的幅值与相位信息;

[0086]

所述多模态语音分离模型输出对应人脸的数量的cirm;

[0087]

语音分离模块,将输出的时频掩蔽与混合声音的语谱图进行复数相乘便得到干净声音的语谱图,对干净声音的语谱图作短时傅里叶逆变换计算得到干净声音的时域信号,从而完成语音分离。

[0088]

以上实施例二、三和四的装置中涉及的各步骤与方法实施例一相对应,具体实施方式可参见实施例一的相关说明部分。术语“计算机可读存储介质”应该理解为包括一个或多个指令集的单个介质或多个介质;还应当被理解为包括任何介质,所述任何介质能够存储、编码或承载用于由处理器执行的指令集并使处理器执行本公开中的任一方法。

[0089]

实验与结果

[0090]

这一部分介绍了所使用的数据集以及搭建实验过程中参数的设置,然后给出实验结果,并对结果进行了分析,其中,为了方便与其他文献中的模型结果作比较,将说话人的数量固定为2,即混合声音中包含两个说话人的声音,模型最终输出两个声音信号。

[0091]

关于数据集:

[0092]

使用grid数据集来训练本公开提出的多模态语音分离模型。其中,grid数据集记录了34个说话人的面部视频与音频信息。其中对于每个说话人,数据集包含了1000个面部视频和对应的音频。每个视频的时长为3s,帧率是25fps。仿照[audio

‑

visual deep clustering for speech separation]进一步构建混合声音数据集。由于部分说话人对应的数据信息不完整,因此将这些数据删除。经过预处理,最终选择的数据集中包含了17个男性和15个女性说话人。模型选择两个男性说话人和两个女性说话人数据构建验证集,选择另外两个男性说话人和两个女性说话人数据构建测试集,其余的数据构建训练集。将所有

的音频降采样为16khz。在构建混合声音时,随机选取不同说话人的声音,然后直接对这些干净声音相加得到混合声音。在这次实验中,考虑的是两个人的混合声音,最终一共得到了41847个混合声音。

[0093]

数据预处理:

[0094]

对所有的混合声音使用stft来计算复语谱图,其中汉明窗的长度为25ms,滑动距离为10ms,fft的窗口大小为512。由于计算得到的复语谱图包含了实部与虚部,因此最终通过stft得到的语谱图大小为257

×

298

×

2。然后在频率维度上将其分为高频部分和低频部分。经过多次尝试,发现在频率维度上的分割点为180时最合适。具体来说,低频声音特征大小为180

×

298

×

2,高频声音特征大小为77

×

298

×

2。

[0095]

对于视频数据,由于每个视频为25fps,一共3s,因此转化为视频帧后,可以得到75张图片。使用opencv和dlib得出人脸的个数并定位每一帧的人脸区域,将人脸区域提取出来。最终得到的每张人脸图片大小为160

×

160。

[0096]

实验设置:

[0097]

在实验中,使用的深度学习框架是keras,而nvidia rtx 2080ti图形卡用于训练模型。该网络训练了300个epoch,并使用了adam优化器。将初始学习率设置为0.00001,为了防止过拟合,当每训练100个epoch,将学习率降低到之前的十分之一。

[0098]

实验结果:

[0099]

使用的评价指标为sdr,由于不同的混合声音对应的sdr不同,因此不能简单通过比较输出的干净声音的sdr来判断模型的好坏。为了方便比较,将模型最终输出声音的sdr减去混合声音的sdr,可以得到实际提升的sdr,即

△

sdr。在只有两个说话人的情况下对不同方法的

△

sdr结果进行对比与分析。将输入的混合声音分成男

‑

男混合、男

‑

女混合、女

‑

女混合三种情况。得出了当输入分别为男

‑

男混合、男

‑

女混合、女

‑

女混合声音时,不同方法的语音分离模型的性能,结果如表1所示。可以看出,相比于其他的语音分离算法,本公开的算法具有优越的性能。其中,由于男声和女声的频率有较大差异,因此对异性混合声音进行语音分离的效果最好,本公开的模型实现了11.14db的提升。当输入为同性混合声音时,相比于异性混合声音,所有的模型分离效果有所下降,不过本公开的模型同样比其他模型表现得更加优越,在男

‑

男混合时实现了6.31db的提升,在女

‑

女混合时实现了8.47db的提升。

[0100]

表1当混合声音只包含两个说话人时,不同模型的语音分离结果比较

[0101][0102]

同时,本公开的模型还解决了神经网络模型中常出现的参数多、训练时间慢的问题。在声音的特征提取中使用tcn来代替lstm进行时间序列建模,大大减少训练参数和训练

时间。由于使用lstm的模型与谷歌模型比较类似,因此一开始考虑到使用相同的数据集将本公开的模型与谷歌模型进行对比,在实验过程中,发现由于谷歌提出的avspeech数据集太大,训练时间特别长,不利于进行实验,因此使用grid数据集训练谷歌提出的模型来与本公开的模型进行对比。为了节约时间成本并保证公正性,对两个模型的训练参数epoch都设置为100,此时虽然两个模型的loss还没有达到最低点,但不影响对两个模型的比较。对比结果如表2所示。可以看出,在相同的条件下,相比于谷歌模型,本公开的模型可以大大节省训练时间,同时分离性能不仅没有受到影响,反而还得到了提升。因此本公开的模型更加适用于大多数应用场景。

[0103]

表2本公开的模型与谷歌模型结果比较

[0104][0105][0106]

如前所述,本申请使用两流cnn分别提取模型音频特征网络中的高频和低频音频特征。设计了一个辅助实验,以证明使用多个流提取特征确实有助于语音分离。在新模型中,删除了高频特征提取网络,并且可以将混合语谱图直接馈送到低频特征提取网络,而无需进行分段。比较结果如表3所示。从表中可以看出,使用多流cnn可以比使用单流cnn高1.34db。因此,最好的方法是使用不同的网络分别提取高频特征和低频特征,因为对应于声音的不同频率的理想特征提取器是不同的。

[0107]

表3两流cnn与单流cnn提取声音特征对结果的影响

[0108][0109]

为了观察视觉信息是否对语音分离的性能有帮助,将只用声音的语音分离模型与音视频融合模型进行对比。具体来说,本公开技术方案在提出的模型中只使用声音流而删除视频特征提取网络,其他保持不变,这样便得到了只以混合声音作为输入的语音分离模型。对比结果如表3所示。从表中可以看出,加入视频特征信息对语音分离性能的提升具有一定的作用。

[0110]

表4只使用声音的模型与音视频融合模型结果比较

[0111][0112]

本公开技术方案提出了一个新的音视频融合语音分离模型。它结合了声音与视频特征,在声音的特征提取过程中仿照了耳蜗的生理特征,使用不同的网络分别提取声音的高频与低频特征,并通过人脸检测器可以自动判断模型的输出个数。从实验结果中可以看出,当使用相同的数据集时,相比于最近人们提出的几种模型,本公开的模型具有更好的性能。同时,通过做的一些实验,来验证本公开技术方案提出想法的可行性。后续的技术方案中可以尝试将语音分离技术运用到更复杂的场景中,并且将应用拓展到语音增强上面,实现背景噪声的抑制。

[0113]

本领域技术人员应该明白,上述本公开的各模块或各步骤可以用通用的计算机装置来实现,可选地,它们可以用计算装置可执行的程序代码来实现,从而,可以将它们存储在存储装置中由计算装置来执行,或者将它们分别制作成各个集成电路模块,或者将它们中的多个模块或步骤制作成单个集成电路模块来实现。本公开不限制于任何特定的硬件和软件的结合。

[0114]

以上所述仅为本公开的优选实施例而已,并不用于限制本公开,对于本领域的技术人员来说,本公开可以有各种更改和变化。凡在本公开的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本公开的保护范围之内。

[0115]

上述虽然结合附图对本公开的具体实施方式进行了描述,但并非对本公开保护范围的限制,所属领域技术人员应该明白,在本公开的技术方案的基础上,本领域技术人员不需要付出创造性劳动即可做出的各种修改或变形仍在本公开的保护范围以内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。