1.本发明实施例涉及分布式计算技术领域,尤其涉及一种深度学习模型的horovod分布式训练方法、装置、设备及存储介质。

背景技术:

2.目前人工智能领域分布式计算主要采用数据并行方式,有两种工程实现方法:参数服务器(parameter server)和ring

‑

allreduce架构。其中,horovod是基于ring

‑

allreduce方法的深度分布式学习插件,由uber构建并开源,兼容tensorflow、pytorch等深度学习主流计算框架,能够简化并加速分布式深度学习项目的启动与运行。通过利用消息传递接口(简称mpi)实现应用环状规约,显著提升tensorflow等模型框架的实用性与性能表现。

3.然而,horovod的问题在于对异构加速平台功能的支持不完善,例如,对rocm平台(radeon open compute platform,radeon开放计算平台)功能的支持不完善,且在tensorflow代码背景下,无法自动地实现深度学习模型的horovod分布式训练计算。

技术实现要素:

4.本发明实施例提供一种深度学习模型的horovod分布式训练方法、装置、设备及存储介质,以自动地实现深度学习模型的horovod分布式训练计算。

5.第一方面,本发明实施例提供了一种深度学习模型的horovod分布式训练方法,包括:

6.获取目标深度学习模型的tensorflow训练代码;

7.确定所述tensorflow训练代码的目标逻辑及封装类型;

8.根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整;

9.运行调整后的tensorflow训练代码,以实现对所述目标深度学习模型的horovod分布式训练。

10.可选的,所述目标逻辑及封装类型至少包括:逻辑简单非高度封装、逻辑复杂非高度封装、逻辑简单高度封装和逻辑复杂高度封装。

11.上述技术方案,创造性地将目标深度学习模型的tensorflow训练代码按照逻辑复杂程度和封装程度进行类型划分,进而可以采用不同的方式针对不同类型的目标深度学习模型实现horovod分布式训练的自动化。

12.可选的,当所述目标逻辑及封装类型为逻辑简单非高度封装时,根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整,包括:

13.在训练主文件中导入配置tensorflow接口的horovod模块;

14.初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定;

15.根据加速卡总数量按倍数增大学习率;

16.在与计算汇总操作对应的目标进程上保存检测点,并重新定义tensorflow会话。

17.上述技术方案,针对tensorflow训练代码逻辑简单且非高度封装的目标深度学习模型提供了自动化实现深度学习模型的horovod分布式训练计算的方式。

18.可选的,当所述目标逻辑及封装类型为逻辑复杂非高度封装时,根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整,包括:

19.在训练主文件中导入配置tensorflow接口的horovod模块;

20.初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定;

21.广播初始变量值到与各加速卡绑定的所有进程,并重新定义tensorflow会话;

22.根据加速卡总数量按倍数增大学习率。

23.上述技术方案,针对tensorflow训练代码逻辑复杂且非高度封装的目标深度学习模型提供了自动化实现深度学习模型的horovod分布式训练计算的方式。

24.可选的,当所述目标逻辑及封装类型为逻辑复杂非高度封装时,在运行调整后的tensorflow训练代码时,还包括:

25.若存在会话实体没有会话属性的报错函数,则在所述报错函数的定义行下方一行以与所述报错函数内部原代码段相同的缩进添加获取默认计算图的代码,并对所述报错函数内部原代码段整体增加缩进;

26.若存在指示图形已完成且无法修改的报错,则在导入的所述配置tensorflow接口的horovod模块的下方一行添加清除默认图形堆栈并重置全局默认图形的代码段,并在会话定义处下方一行以相同缩进添加禁止图冻结的代码段;

27.若存在指示会话类型错误的报错,则在类定义内部构造方法函数外部以相同缩进添加新的会话函数代码段,并将报错代码段中的已有会话函数定义关键字替换为与所述新的会话函数代码段对应的会话函数定义关键字。

28.上述技术方案,提供了在调整后的tensorflow训练代码运行时几种报错的解决方案,包括会话实体没有会话属性的报错、指示“图形已完成,无法修改”的报错和会话类型错误的报错。

29.可选的,当所述目标逻辑及封装类型为逻辑简单高度封装或逻辑复杂高度封装时,根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整,包括:

30.在训练主文件中导入配置tensorflow接口的horovod模块;

31.初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定;

32.查找引用高度封装应用程序接口的关键字,并使用重新设置的配置参数对所述关键字涉及的配置参数进行替换;

33.根据加速卡总数量按倍数增大学习率。

34.可选的,当所述目标逻辑及封装类型为逻辑简单高度封装时,在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定,包括:

35.在基于定义主函数的关键字对各加速卡进行配置参数设置之后,将各加速卡与进

程进行一对一绑定;

36.当所述目标逻辑及封装类型为逻辑复杂高度封装时,在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定,包括:

37.在基于定义类中定义构造方法的关键字对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定。

38.第二方面,本发明实施例还提供了一种深度学习模型的horovod分布式训练装置,该装置包括:

39.训练代码获取模块,用于获取目标深度学习模型的tensorflow训练代码;

40.逻辑及封装类型确定模块,用于确定所述tensorflow训练代码的目标逻辑及封装类型;

41.训练代码调整模块,用于根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整;

42.训练代码运行模块,用于运行调整后的tensorflow训练代码,以实现对所述目标深度学习模型的horovod分布式训练。

43.第三方面,本发明实施例还提供了一种计算机设备,所述计算机设备包括:

44.一个或多个处理器;

45.存储器,用于存储一个或多个程序,

46.当所述一个或多个程序被所述一个或多个处理器执行,使得所述一个或多个处理器实现如本发明任一实施例所述的方法。

47.第四方面,本发明实施例还提供了一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现如本发明任一实施例所述的方法。

48.本发明实施例的技术方案,获取目标深度学习模型的tensorflow训练代码之后,对训练代码的逻辑及封装类型进行分析,并根据与训练代码所属的逻辑及封装类型匹配的处理策略对训练代码进行调整,此时运行调整后的训练代码即可实现目标深度学习模型horovod分布式训练,由此达到了在tensorflow代码背景下,自动实现深度学习模型的horovod分布式训练计算的技术效果,极大地减小了人工参与工作量,提高了工作效率。

附图说明

49.图1是本发明实施例一中的一种深度学习模型的horovod分布式训练方法的流程图;

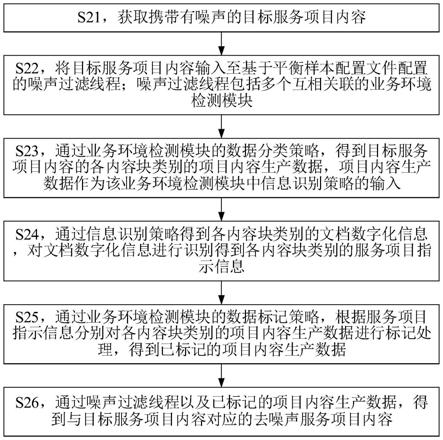

50.图2是本发明实施例二中的一种深度学习模型的horovod分布式训练方法的流程图;

51.图3是本发明实施例三中的一种深度学习模型的horovod分布式训练方法的流程图;

52.图4是本发明实施例四中的一种深度学习模型的horovod分布式训练方法的流程图;

53.图5是本发明实施例五中的一种深度学习模型的horovod分布式训练装置的结构示意图;

54.图6是本发明实施例六中的一种计算机设备的结构示意图。

具体实施方式

55.下面结合附图和实施例对本发明作进一步的详细说明。可以理解的是,此处所描述的具体实施例仅仅用于解释本发明,而非对本发明的限定。另外还需要说明的是,为了便于描述,附图中仅示出了与本发明相关的部分而非全部结构。

56.实施例一

57.图1为本发明实施例一提供的一种深度学习模型的horovod分布式训练方法的流程图,本实施例可适用于使深度学习模型自动实现horovod分布式训练的情况,该方法可以由深度学习模型的horovod分布式训练装置来执行,该装置可采用硬件和/或软件的方式实现,并一般可以集成在计算机设备中。

58.如图1所示,本实施例提供的深度学习模型的horovod分布式训练方法,包括如下步骤:

59.s110、获取目标深度学习模型的tensorflow训练代码。

60.目标深度学习模型,指的是一种基于深度学习技术的人工智能模型,例如可以是yolo(you only look once)模型、transformer模型等。

61.在本实施例中,目标深度学习模型的训练代码是基于tensorflow实现的。

62.s120、确定所述tensorflow训练代码的目标逻辑及封装类型。

63.逻辑及封装类型,是根据训练代码的逻辑复杂程度以及封装程度划分的。其中,逻辑复杂程度可以分为逻辑简单和逻辑复杂,封装程度可以分为高度封装和非高度封装。

64.可选的,逻辑及封装类型可以包括逻辑简单非高度封装、逻辑复杂非高度封装、逻辑简单高度封装和逻辑复杂高度封装。

65.在获取到目标深度学习模型的tensorflow训练代码,对tensorflow训练代码进行分析,确定tensorflow训练代码所属的目标逻辑及封装类型。

66.作为一种可选的实施方式,可以根据tensorflow训练代码中是否包括高阶tensorflow api(application programming interface,应用程序接口)来确定tensorflow训练代码的封装程度。若tensorflow训练代码中包括高阶tensorflow api,则可以确定tensorflow训练代码为高度封装;若tensorflow训练代码中不包括高阶tensorflow api,则可以确定tensorflow训练代码为非高度封装。本实施例对高阶tensorflow api不做具体限定。

67.可选的,高阶tensorflow api可以具体为estimator。其中,estimator会封装训练、评估、预测、导出等操作以供使用。estimator可以在本地主机上或分布式多服务器环境中运行基于estimator的模型,而无需更改模型。无论是预创建的还是自定义的,所有estimator都是基于tf.estimator.estimator类的类。

68.作为一种可选的实施方式,遍历目标深度学习模型的tensorflow训练代码,查找estimator训练模式的关键字“tf.estimator.modekeys.train”,若遍历到该关键字,则确定目标深度学习模型的tensorflow训练代码为高度封装,若未遍历到该关键字,则确定目标深度学习模型的tensorflow训练代码为非高度封装。

69.作为一种可选的实施方式,可以根据tensorflow训练代码是否面向对象编程来确定tensorflow训练代码的逻辑复杂程度,例如可以为根据是否用类来描述一个对象(实例)并建立实例与实例的关联关系来确定tensorflow训练代码的逻辑复杂程度。若tensorflow

训练代码面向对象编程,例如用类来描述一个对象(实例)并建立实例与实例的关联关系,则可以确定tensorflow训练代码逻辑复杂;若tensorflow训练代码未面向对象编程,例如未用类来描述一个对象(实例)并建立实例与实例的关联关系,则可以确定tensorflow训练代码逻辑简单。

70.作为一种可选的实施方式,遍历目标深度学习模型的tensorflow训练代码,查找定义类的关键字,如“class*:”、查找定义构造方法的关键字,如“def__init__”、查找参数关键字,如“self”,其中,*可以指代任意字符。示例性的,定义类的通用语法格式如下:

71.class类名(继承列表):

72.def__init__(self[,参数列表]):

[0073]

语句块

[0074]

(其中,[]代表可省略)

[0075]

若遍历到上述关键字,则确定目标深度学习模型的tensorflow训练代码逻辑复杂;若未遍历到上述关键字,则确定目标深度学习模型的tensorflow训练代码逻辑简单。

[0076]

在上述技术方案的基础上,可以根据tensorflow训练代码中是否包括高阶tensorflow api,以及是否面向对象编程来确定目标深度学习模型的tensorflow训练代码的目标逻辑及封装类型。由此,可以确定目标深度学习模型的tensorflow训练代码属于逻辑简单非高度封装、逻辑复杂非高度封装、逻辑简单高度封装和逻辑复杂高度封装中的一种。示例性的,yolov3模型的tensorflow训练代码的目标逻辑及封装类型为逻辑复杂非高度封装,transformer模型的tensorflow训练代码的目标逻辑及封装类型为逻辑简单高度封装。

[0077]

上述技术方案,创造性地将目标深度学习模型的tensorflow训练代码按照逻辑复杂程度和封装程度进行类型划分,进而可以采用不同的方式针对不同类型的目标深度学习模型实现horovod分布式训练的自动化。

[0078]

s130、根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整。

[0079]

在本实施例中,针对不同逻辑及封装类型的目标深度学习模型的tensorflow训练代码采用不同的处理策略进行代码调整,以使调整后的tensorflow训练代码适用于分布式训练。

[0080]

其中,与目标逻辑及封装类型的各种处理策略均依据的是horovod分布式训练的实现流程,用于实现horovod分布式训练代码的改写。但由于针对的目标深度学习模型的逻辑及封装类型不同,不同处理策略之间是存在差异的。

[0081]

s140、运行调整后的tensorflow训练代码,以实现对所述目标深度学习模型的horovod分布式训练。

[0082]

调整后的tensorflow训练代码,是适用于进行基于数据并行的分布式训练的。运行调整后的tensorflow训练代码,即可自动实现目标深度学习模型的horovod分布式训练。

[0083]

本发明实施例的技术方案,获取目标深度学习模型的tensorflow训练代码之后,对训练代码的逻辑及封装类型进行分析,并根据与训练代码所属的逻辑及封装类型匹配的处理策略对训练代码进行调整,此时运行调整后的训练代码即可实现目标深度学习模型horovod分布式训练,由此达到了在tensorflow代码背景下,自动实现深度学习模型的

horovod分布式训练计算的技术效果,极大地减小了人工参与工作量,提高了工作效率。

[0084]

需要指出的是,上述技术方案中进行horovod分布式训练是可以基于异构加速平台实现的,如rocm平台,以此能够促进和完善rocm平台在人工智能分布式训练领域的发展。

[0085]

实施例二

[0086]

图2为本发明实施例二提供的一种深度学习模型的horovod分布式训练方法的流程图,本实施例针对目标逻辑及封装类型为逻辑简单非高度封装的深度学习模型进行解释说明。其中,当所述目标逻辑及封装类型为逻辑简单非高度封装时,根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整,可以具体为:

[0087]

在训练主文件中导入配置tensorflow接口的horovod模块;

[0088]

初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定;

[0089]

根据加速卡总数量按倍数增大学习率;

[0090]

在与计算汇总操作对应的目标进程上保存检测点,并重新定义tensorflow会话。

[0091]

如图2所示,本实施例提供的深度学习模型的horovod分布式训练方法,包括如下步骤:

[0092]

s210、获取目标深度学习模型的tensorflow训练代码。

[0093]

s220、如果确定所述tensorflow训练代码的目标逻辑及封装类型为逻辑简单非高度封装,则在训练主文件中导入配置tensorflow接口的horovod模块。

[0094]

响应于训练主文件选择指令,在工程文件夹中确定目标深度学习模型的训练主文件,进而可以以训练主文件为基础进行horovod分布式训练代码的改写。

[0095]

在确定目标深度学习模型的训练主文件之后,打开训练主文件,并在训练主文件中导入配置tensorflow接口的horovod模块。

[0096]

其中,打开训练主文件可以通过vim或vi等指令实现。

[0097]

执行在训练主文件中导入配置tensorflow接口的horovod模块的操作时,首先获取import导入模块代码段的位置,并在import导入模块代码段之后添加以下代码段:import horovod.tensorflow as hvd,以此完成配置tensorflow接口的horovod模块的导入操作。

[0098]

s230、初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定。

[0099]

针对多个加速卡的情况,需要分别对每个加速卡进行配置参数设置,主要指的是config参数进行设置,并将每个加速卡与不同的进程进行一对一的绑定。

[0100]

可选的,在训练主文件中查询定义主函数的关键字,如“def main():”,并获取其所在行下方一行代码的缩进,并按照相同缩进插入以下代码段,实现对对每个加速卡的配置参数设置以及与进程的一对一绑定。

[0101]

hvd.init()

[0102]

config=tf.configproto()

[0103]

config.gpu_options.allow_growth=true//用于实现对加速卡的配置参数设置

[0104]

config.gpu_options.visible_device_list=str(hvd.local_rank())//用于实现对加速卡与进程的一对一绑定

[0105]

若未查询到定义主函数的关键字,则可以根据主函数定义行确定指令确定主函数定义行,并获取主函数定义行下方一行代码的缩进,按照相同缩进插入以下代码段。

[0106]

若未查询到定义主函数的关键字,也为接收到主函数定义行确定指令,则可以在import导入模块代码段之后插入上述用于实现对每个加速卡的配置参数设置以及与进程的一对一绑定的代码段。

[0107]

s240、根据加速卡总数量按倍数增大学习率。

[0108]

在本步骤中,更改优化器的设置,以实现增大学习率的效果,具体的,可以学习率的增大倍数可以按照加速卡的总数量确定。

[0109]

作为一种可选的实施方式,在主训练文件中查找所有定义优化器的关键字,如“opt=tf.*optimizer(*)”(不分区空格)。确定定义优化器的关键字,如“opt=tf.*optimizer(*)”,出现的首个位置,将其作为该变量的定义位置,并获取当前行的缩进。

[0110]

如果定义优化器的关键字有多个,则可以确定目标深度学习模型为多阶段训练,需要对在每个定义优化器的关键字处执行下述操作:

[0111]

首先,在当前代码片段中查找学习率参数的关键字,如“self.learning_rate”或“self.lr”,并在学习率参数的关键字之后添加“*hvd.size()”,使学习率参数的关键字变为self.learning_rate*hvd.size()或self.lr*hvd.size()。

[0112]

如果在当前代码片段中未查找到学习率参数的关键字,如“self.learning_rate”或“self.lr”,则获取tensorflow优化器中默认的学习率参数,如tf.*optimizer(*)括号中的第一个参数字符串,假设第一个参数字符串为str,则将第一个参数字符串替换为str*hvd.size()。

[0113]

如果在当前代码片段中未查找到学习率参数的关键字,如“self.learning_rate”或“self.lr”,也未在tensorflow优化器中获取到默认的学习率参数,则根据接收到的学习率参数指令,对相关学习率参数的关键字添加后缀“*hvd.size()”。

[0114]

其次,在当前代码片段中获取定义优化器的关键字前面的字符串,如“=tf.*optimizer(*)”前面的字符串,假设为opt。

[0115]

最后,使用horovod分布式优化器hvd.distributedoptimizer封装原有的优化器optimizer,并广播初始变量值到与各个加速卡一对一绑定的所有进程。

[0116]

可选的,可以在当前代码片段的下一行以相同缩进添加以下代码段实现优化器封装以及初始变量值的广播:

[0117]

opt=hvd.distributedoptimizer(opt)//使用horovod分布式优化器hvd.distributedoptimizer封装原有的优化器optimizer

[0118]

hooks=[hvd.broadcastglobalvariableshook(0)]//广播初始变量值到与各个加速卡一对一绑定的所有进程

[0119]

s250、在与计算汇总操作对应的目标进程上保存检测点,并重新定义tensorflow会话。

[0120]

在本实施例中,只需要在与计算汇总操作(即allgather和allreduce操作)对应的目标进程或目标加速卡上保存检测点,如在worker 0上保存checkpoint。

[0121]

作为一种可选的实施方式,查找检测点关键字,如“checkpoint_dir=”(不区分空格),并在当前代码行的末尾添加代码if hvd.rank()==0else none,以此实现仅在

worker 0上保存checkpoint。

[0122]

重新定义tensorflow会话,使目标深度学习模式的计算图适于进行基于数据并行的分布式训练。

[0123]

作为一种可选的实施方式,查找定义会话的关键字,如“self.sess=”(不区分空格),并将定义会话的关键字“self.sess=”后的代码段进行替换,以实现对tensorflow会话的重定义,如“self.sess=”后的代码段进行替换为为“tf.train.monitoredtrainingsession(config=config,hooks=hooks)”。

[0124]

s260、运行调整后的tensorflow训练代码,以实现对所述目标深度学习模型的horovod分布式训练。

[0125]

本实施例未尽详细解释之处请参见前述实施例,在此不再赘述。

[0126]

上述技术方案,针对tensorflow训练代码逻辑简单且非高度封装的目标深度学习模型提供了自动化实现深度学习模型的horovod分布式训练计算的方式。

[0127]

实施例三

[0128]

图3为本发明实施例三提供的一种深度学习模型的horovod分布式训练方法的流程图,本实施例针对目标逻辑及封装类型为逻辑复杂非高度封装的深度学习模型进行解释说明。其中,当所述目标逻辑及封装类型为逻辑复杂非高度封装时,根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整,可以具体为:

[0129]

在训练主文件中导入配置tensorflow接口的horovod模块;

[0130]

初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定;

[0131]

广播初始变量值到与各加速卡绑定的所有进程,并重新定义tensorflow会话;

[0132]

根据加速卡总数量按倍数增大学习率。

[0133]

如图3所示,本实施例提供的深度学习模型的horovod分布式训练方法,包括如下步骤:

[0134]

s310、获取目标深度学习模型的tensorflow训练代码。

[0135]

s320、如果确定所述tensorflow训练代码的目标逻辑及封装类型为逻辑复杂非高度封装,则在训练主文件中导入配置tensorflow接口的horovod模块。

[0136]

响应于训练主文件选择指令,在工程文件夹中确定目标深度学习模型的训练主文件,进而可以以训练主文件为基础进行horovod分布式训练代码的改写。

[0137]

在确定目标深度学习模型的训练主文件之后,打开训练主文件,并在训练主文件中导入配置tensorflow接口的horovod模块。

[0138]

其中,打开训练主文件可以通过vim或vi等指令实现。

[0139]

执行在训练主文件中导入配置tensorflow接口的horovod模块的操作时,首先获取import导入模块代码段的位置,并在import导入模块代码段之后添加以下代码段:import horovod.tensorflow as hvd,以此完成配置tensorflow接口的horovod模块的导入操作。

[0140]

s330、初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定。

[0141]

针对多个加速卡的情况,需要分别对每个加速卡进行配置参数设置,主要指的是

config参数进行设置,并将每个加速卡与不同的进程进行一对一的绑定。

[0142]

可选的,在训练主文件中查询定义类的关键字,如“class*:”,并进一步在类结构中查找定义构造方法的关键字,如“def__init__(*):”,并获取其所在行下方一行代码的缩进,并按照相同缩进插入以下代码段,实现对对每个加速卡的配置参数设置以及与进程的一对一绑定。

[0143]

hvd.init()

[0144]

config=tf.configproto()

[0145]

config.gpu_options.allow_growth=true//用于实现对加速卡的配置参数设置

[0146]

config.gpu_options.visible_device_list=str(hvd.local_rank())//用于实现对加速卡与进程的一对一绑定

[0147]

s340、广播初始变量值到与各加速卡绑定的所有进程,并重新定义tensorflow会话。

[0148]

广播初始变量值到与各加速卡一对一绑定的所有进程,并执行重新定义tensorflow会话的操作,使目标深度学习模式的计算图适于进行基于数据并行的分布式训练。

[0149]

作为一种可选的实施方式,查找定义会话的关键字,如“self.sess=”(不区分空格),确定其出现的首个位置(默认为该变量的定义位置),并在该位置处获取当前行的缩进。

[0150]

可选的,广播初始变量值到与各加速卡一对一绑定的所有进程的操作,可以通过在当前行的上一行按同样缩进添加代码段hooks=[hvd.broadcastglobalvariableshook(0)]来实现。

[0151]

可选的,重新定义tensorflow会话的操作,可以通过替换定义会话的关键字的值来实现,例如可以是将“self.sess=”(不区分空格)后的代码段替换为“tf.train.monitoredtrainingsession(config=config,hooks=hooks)”。

[0152]

s350、根据加速卡总数量按倍数增大学习率。

[0153]

在本步骤中,更改优化器的设置,以实现增大学习率的效果,具体的,可以学习率的增大倍数可以按照加速卡的总数量确定。

[0154]

作为一种可选的实施方式,在主训练文件中查找所有定义优化器的关键字,如“opt=tf.*optimizer(*)”(不分区空格)。确定定义优化器的关键字,如“opt=tf.*optimizer(*)”,出现的首个位置,将其作为该变量的定义位置,并获取当前行的缩进。

[0155]

如果定义优化器的关键字有多个,则可以确定目标深度学习模型为多阶段训练,需要对在每个定义优化器的关键字处执行下述操作:

[0156]

首先,在当前代码片段中查找学习率参数的关键字,如“self.learning_rate”或“self.lr”,并在学习率参数的关键字之后添加“*hvd.size()”,使学习率参数的关键字变为self.learning_rate*hvd.size()或self.lr*hvd.size()。

[0157]

如果在当前代码片段中未查找到学习率参数的关键字,如“self.learning_rate”或“self.lr”,则获取tensorflow优化器中默认的学习率参数,如tf.*optimizer(*)括号中的第一个参数字符串,假设第一个参数字符串为str,则将第一个参数字符串替换为str*hvd.size()。

[0158]

如果在当前代码片段中未查找到学习率参数的关键字,如“self.learning_rate”或“self.lr”,也未在tensorflow优化器中获取到默认的学习率参数,则根据接收到的学习率参数指令,对相关学习率参数的关键字添加后缀“*hvd.size()”。

[0159]

其次,在当前代码片段中获取定义优化器的关键字前面的字符串,如“=tf.*optimizer(*)”前面的字符串,假设为opt。

[0160]

最后,使用horovod分布式优化器hvd.distributedoptimizer封装原有的优化器optimizer。

[0161]

可选的,可以在当前代码片段的下一行以相同缩进添加以下代码段实现优化器封装:

[0162]

opt=hvd.distributedoptimizer(opt)//使用horovod分布式优化器hvd.distributedoptimizer封装原有的优化器optimizer

[0163]

s360、运行调整后的tensorflow训练代码,以实现对所述目标深度学习模型的horovod分布式训练。

[0164]

进一步的,作为一种可选的实施方式,在运行调整后的tensorflow训练代码时,还可以包括:若存在会话实体没有会话属性的报错函数,则在所述报错函数的定义行下方一行以与所述报错函数内部原代码段相同的缩进添加获取默认计算图的代码,并对所述报错函数内部原代码段整体增加缩进。

[0165]

在运行调整后的tensorflow训练代码时,若有函数报错会话实体没有会话属性(_session),如“session

‘

object has no attribute’_session_”,则可以在报错函数定义行下方一行以与函数内部原代码段相同缩进添加获取默认计算图的代码,如“with self.sess.graph.as_default():”,并将原函数内部代码段整体增加缩进,由此解决了调整后的tensorflow训练代码运行时存在会话实体没有会话属性的报错。

[0166]

作为一种可选的实施方式,在运行调整后的tensorflow训练代码时,还可以包括:若存在指示图形已完成且无法修改的报错,则在导入的所述配置tensorflow接口的horovod模块的下方一行添加清除默认图形堆栈并重置全局默认图形的代码段,并在会话定义处下方一行以相同缩进添加禁止图冻结的代码段。

[0167]

在运行调整后的tensorflow训练代码时,若有报错指示“图形已完成,无法修改”,如“graph is finalized and cannot be modified”,则可以在导入的所述配置tensorflow接口的horovod模块的下方一行,如“import horovod.tensorflow as hvd”的下方一行,添加清除默认图形堆栈并重置全局默认图形的代码段,如“tf.reset_default_graph()”,并在会话定义处方一行,如代码“self.sess=tf.train.monitoredtrainingsession(config=config,hooks=hooks)”的下方一行以相同缩进添加禁止图冻结的代码段,如添加代码段“self.sess.graph._unsafe_unfinalize()”指示禁止图冻结,由此解决了调整后的tensorflow训练代码运行时指示“图形已完成,无法修改”的报错。

[0168]

作为一种可选的实施方式,在运行调整后的tensorflow训练代码时,还可以包括:若存在指示会话类型错误的报错,则在类定义内部构造方法函数外部以相同缩进添加新的会话函数代码段,并将报错代码段中的已有会话函数定义关键字替换为与所述新的会话函数代码段对应的会话函数定义关键字。

[0169]

在运行调整后的tensorflow训练代码时,若有会话类型错误的报错,如

“

typeerror:

‘

sess’must be a session;”,则可以在类定义”class*:”内部构造方法函数“def__init__(*):”外部以相同缩进添加新的会话函数代码段,并将报错代码段中的已有会话函数定义关键字替换为与所述新的会话函数代码段对应的会话函数定义关键字。

[0170]

例如,新的会话函数代码段可以为:

[0171][0172][0173]

进而,可以将报错代码段中的“self.sess”替换为“self.get_session()”,由此解决了调整后的tensorflow训练代码运行时会话类型错误的报错。

[0174]

上述技术方案,提供了在调整后的tensorflow训练代码运行时几种报错的解决方案,包括会话实体没有会话属性的报错、指示“图形已完成,无法修改”的报错和会话类型错误的报错。

[0175]

本实施例未尽详细解释之处请参见前述实施例,在此不再赘述。

[0176]

上述技术方案,针对tensorflow训练代码逻辑复杂且非高度封装的目标深度学习模型提供了自动化实现深度学习模型的horovod分布式训练计算的方式。

[0177]

实施例四

[0178]

图4为本发明实施例四提供的一种深度学习模型的horovod分布式训练方法的流程图,本实施例针对目标逻辑及封装类型为逻辑简单高度封装或逻辑复杂高度封装的深度学习模型进行解释说明。其中,当所述目标逻辑及封装类型为逻辑简单高度封装或逻辑复杂高度封装时,根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整,可以具体为:

[0179]

在训练主文件中导入配置tensorflow接口的horovod模块;

[0180]

初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定;

[0181]

查找引用高度封装应用程序接口的关键字,并使用重新设置的配置参数对所述关键字涉及的配置参数进行替换;

[0182]

根据加速卡总数量按倍数增大学习率。

[0183]

如图4所示,本实施例提供的深度学习模型的horovod分布式训练方法,包括如下步骤:

[0184]

s410、获取目标深度学习模型的tensorflow训练代码。

[0185]

s420、如果确定所述tensorflow训练代码的目标逻辑及封装类型为逻辑简单高度封装或逻辑复杂高度封装,在训练主文件中导入配置tensorflow接口的horovod模块。

[0186]

在本实施例中,由于tensorflow训练代码是高度封装的,可以根据训练主文件的标志性代码识别工程文件夹中的训练主文件。

[0187]

以使用estimators高阶tensorflow api确定tensorflow训练代码为高度封装为

例,是使用estimators高阶tensorflow api通过统一标准模式设置不同的值表示当前任务执行训练、验证或者预测。在项目工程文件夹中,训练主文件的标志性代码为tf.estimator.modekeys.train,进而可以根据该志性代码在项目工程文件夹中定位训练主文件。

[0188]

作为一种可选的实施方式,在工程文件夹中,可以查找estimators训练模式来定位训练主文件。可选的,可以通过指令find grep

–

rn“tf.estimator.modekeys.train”,查找文件名为“*train*.py”或“*main*.py”的文件作为训练主文件。若查找出多个文件,可通过筛查关键字的方法最终定位为唯一的训练主文件,若筛查后仍存在多个文件,则根据训练主文件选择指令定位训练主文件。

[0189]

在确定目标深度学习模型的训练主文件之后,打开训练主文件,并在训练主文件中导入配置tensorflow接口的horovod模块。

[0190]

其中,打开训练主文件可以通过vim或vi等指令实现。

[0191]

执行在训练主文件中导入配置tensorflow接口的horovod模块的操作时,首先获取import导入模块代码段的位置,并在import导入模块代码段之后添加以下代码段:import horovod.tensorflow as hvd,以此完成配置tensorflow接口的horovod模块的导入操作。

[0192]

s430、初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定。

[0193]

针对多个加速卡的情况,需要分别对每个加速卡进行配置参数设置,主要指的是config参数进行设置,并将每个加速卡与不同的进程进行一对一的绑定。

[0194]

作为一种可选的实施方式,当所述目标逻辑及封装类型为逻辑简单高度封装时,在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定,可以具体为:在基于定义主函数的关键字对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定。

[0195]

可选的,在训练主文件中查询定义主函数的关键字,如“def main():”,并获取其所在行下方一行代码的缩进,并按照相同缩进插入以下代码段,实现对对每个加速卡的配置参数设置以及与进程的一对一绑定。

[0196]

hvd.init()

[0197]

config=tf.configproto()

[0198]

config.gpu_options.allow_growth=true//用于实现对加速卡的配置参数设置

[0199]

config.gpu_options.visible_device_list=str(hvd.local_rank())//用于实现对加速卡与进程的一对一绑定

[0200]

若未查询到定义主函数的关键字,则可以根据主函数定义行确定指令确定主函数定义行,并获取主函数定义行下方一行代码的缩进,按照相同缩进插入以下代码段。

[0201]

若未查询到定义主函数的关键字,也为接收到主函数定义行确定指令,则可以在import导入模块代码段之后插入上述用于实现对每个加速卡的配置参数设置以及与进程的一对一绑定的代码段。

[0202]

作为一种可选的实施方式,当所述目标逻辑及封装类型为逻辑复杂高度封装时,在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定,可以具体为:在

基于定义类中定义构造方法的关键字对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定。

[0203]

在训练主文件中查询定义类的关键字,如“class*:”,并进一步在类结构中查找定义构造方法的关键字,如“def__init__(*):”,并获取其所在行下方一行代码的缩进,并按照相同缩进插入以下代码段,实现对对每个加速卡的配置参数设置以及与进程的一对一绑定。

[0204]

hvd.init()

[0205]

config=tf.configproto()

[0206]

config.gpu_options.allow_growth=true//用于实现对加速卡的配置参数设置

[0207]

config.gpu_options.visible_device_list=str(hvd.local_rank())//用于实现对加速卡与进程的一对一绑定

[0208]

s440、查找引用高度封装应用程序接口的关键字,并使用重新设置的配置参数对所述关键字涉及的配置参数进行替换。

[0209]

由于tensorflow训练代码高度封装,会话在高阶tensorflow api中被定义,每个加速卡的配置参数变量(config)需要对应到tensorflow api中的运行配置实例,并作为会话配置对象传入高阶tensorflow api。

[0210]

以高阶tensorflow api采用estimator为例,由于tensorflow训练代码高度封装,session在tfestimator.estimator中被定义,每个加速卡的配置参数变量(config)需要对应到tf.estimator中的runconfig实例,并作为session_config对象传入tf.estimator内部。

[0211]

在本实施例中,查找引用高度封装应用程序接口的关键字,如查找引用tf.estimator的关键字“tf.estimator.estimator(*)”,确定其括号内部config参数的关键字“config”,若括号内部不存在config参数的关键字“config”,则将引用tf.estimator的关键字“tf.estimator.estimator(*)”内的第三个参数字符串默认为config参数的关键字。进而,将基于引用tf.estimator的关键字“tf.estimator.estimator(*)”确定的config参数的字符串修改为s430中重新设置的配置参数,如修改为“config=tf.estimator.runconfig(session_config=config)”,以此实现了将每个加速卡的配置参数变量(config)对应到tf.estimator中的runconfig实例,并作为session_config对象传入tf.estimator内部。

[0212]

s450、根据加速卡总数量按倍数增大学习率。

[0213]

在本步骤中,更改优化器的设置,以实现增大学习率的效果,具体的,可以学习率的增大倍数可以按照加速卡的总数量确定。

[0214]

作为一种可选的实施方式,在主训练文件中查找所有定义优化器的关键字,如“opt=tf.*optimizer(*)”(不分区空格)。确定定义优化器的关键字,如“opt=tf.*optimizer(*)”,出现的首个位置,将其作为该变量的定义位置,并获取当前行的缩进。

[0215]

当所述目标逻辑及封装类型为逻辑简单高度封装时,如果定义优化器的关键字有多个,则可以确定目标深度学习模型为多阶段训练,需要对在每个定义优化器的关键字处执行下述操作:

[0216]

首先,在当前代码片段中查找学习率参数的关键字,如“self.learning_rate”或

“

self.lr”,并在学习率参数的关键字之后添加“*hvd.size()”,使学习率参数的关键字变为self.learning_rate*hvd.size()或self.lr*hvd.size()。

[0217]

如果在当前代码片段中未查找到学习率参数的关键字,如“self.learning_rate”或“self.lr”,则获取tensorflow优化器中默认的学习率参数,如tf.*optimizer(*)括号中的第一个参数字符串,假设第一个参数字符串为str,则将第一个参数字符串替换为str*hvd.size()。

[0218]

如果在当前代码片段中未查找到学习率参数的关键字,如“self.learning_rate”或“self.lr”,也未在tensorflow优化器中获取到默认的学习率参数,则根据接收到的学习率参数指令,对相关学习率参数的关键字添加后缀“*hvd.size()”。

[0219]

其次,在当前代码片段中获取定义优化器的关键字前面的字符串,如“=tf.*optimizer(*)”前面的字符串,假设为opt。

[0220]

最后,使用horovod分布式优化器hvd.distributedoptimizer封装原有的优化器optimizer,并广播初始变量值到与各个加速卡一对一绑定的所有进程。

[0221]

可选的,可以在当前代码片段的下一行以相同缩进添加以下代码段实现优化器封装以及初始变量值的广播:

[0222]

opt=hvd.distributedoptimizer(opt)//使用horovod分布式优化器hvd.distributedoptimizer封装原有的优化器optimizer

[0223]

hooks=[hvd.broadcastglobalvariableshook(0)]//广播初始变量值到与各个加速卡一对一绑定的所有进程

[0224]

当所述目标逻辑及封装类型为逻辑复杂高度封装时,如果定义优化器的关键字有多个,则可以确定目标深度学习模型为多阶段训练,需要对在每个定义优化器的关键字处执行下述操作:

[0225]

首先,在当前代码片段中查找学习率参数的关键字,如“self.learning_rate”或“self.lr”,并在学习率参数的关键字之后添加“*hvd.size()”,使学习率参数的关键字变为self.learning_rate*hvd.size()或self.lr*hvd.size()。

[0226]

如果在当前代码片段中未查找到学习率参数的关键字,如“self.learning_rate”或“self.lr”,则获取tensorflow优化器中默认的学习率参数,如tf.*optimizer(*)括号中的第一个参数字符串,假设第一个参数字符串为str,则将第一个参数字符串替换为str*hvd.size()。

[0227]

如果在当前代码片段中未查找到学习率参数的关键字,如“self.learning_rate”或“self.lr”,也未在tensorflow优化器中获取到默认的学习率参数,则根据接收到的学习率参数指令,对相关学习率参数的关键字添加后缀“*hvd.size()”。

[0228]

其次,在当前代码片段中获取定义优化器的关键字前面的字符串,如“=tf.*optimizer(*)”前面的字符串,假设为opt。

[0229]

最后,使用horovod分布式优化器hvd.distributedoptimizer封装原有的优化器optimizer,并广播初始变量值到与各个加速卡一对一绑定的所有进程。

[0230]

可选的,可以在当前代码片段的下一行以相同缩进添加以下代码段实现优化器封装以及初始变量值的广播:

[0231]

opt=hvd.distributedoptimizer(opt)//使用horovod分布式优化器

hvd.distributedoptimizer封装原有的优化器optimizer

[0232]

hooks=[hvd.broadcastglobalvariableshook(0)]//广播初始变量值到与各个加速卡一对一绑定的所有进程

[0233]

s460、运行调整后的tensorflow训练代码,以实现对所述目标深度学习模型的horovod分布式训练。

[0234]

本实施例未尽详细解释之处请参见前述实施例,在此不再赘述。

[0235]

上述技术方案,针对tensorflow训练代码逻辑简单且高度封装的目标深度学习模型,以及逻辑复杂且高度封装的目标深度学习模型提供了自动化实现深度学习模型的horovod分布式训练计算的方式。

[0236]

实施例五

[0237]

图5为本发明实施例五提供的一种深度学习模型的horovod分布式训练装置的结构示意图,本实施例可适用于使深度学习模型自动实现horovod分布式训练的情况,该装置可采用软件和/或硬件的方式实现,并一般可以集成在计算机设备中。如图5所示,该深度学习模型的horovod分布式训练装置具体包括:训练代码获取模块510、逻辑及封装类型确定模块520、训练代码调整模块530和训练代码运行模块540。其中,

[0238]

训练代码获取模块510,用于获取目标深度学习模型的tensorflow训练代码;

[0239]

逻辑及封装类型确定模块520,用于确定所述tensorflow训练代码的目标逻辑及封装类型;

[0240]

训练代码调整模块530,用于根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整;

[0241]

训练代码运行模块540,用于运行调整后的tensorflow训练代码,以实现对所述目标深度学习模型的horovod分布式训练。

[0242]

本发明实施例的技术方案,获取目标深度学习模型的tensorflow训练代码之后,对训练代码的逻辑及封装类型进行分析,并根据与训练代码所属的逻辑及封装类型匹配的处理策略对训练代码进行调整,此时运行调整后的训练代码即可实现目标深度学习模型horovod分布式训练,由此达到了在tensorflow代码背景下,自动实现深度学习模型的horovod分布式训练计算的技术效果,极大地减小了人工参与工作量,提高了工作效率。

[0243]

可选的,所述目标逻辑及封装类型至少包括:逻辑简单非高度封装、逻辑复杂非高度封装、逻辑简单高度封装和逻辑复杂高度封装。

[0244]

可选的,当所述目标逻辑及封装类型为逻辑简单非高度封装时,训练代码调整模块530,具体用于在训练主文件中导入配置tensorflow接口的horovod模块;初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定;根据加速卡总数量按倍数增大学习率;在与计算汇总操作对应的目标进程上保存检测点,并重新定义tensorflow会话。

[0245]

可选的,当所述目标逻辑及封装类型为逻辑复杂非高度封装时,训练代码调整模块530,具体用于在训练主文件中导入配置tensorflow接口的horovod模块;初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定;广播初始变量值到与各加速卡绑定的所有进程,并重新定义tensorflow会话;根据加速卡总数量按倍数增大学习率。

[0246]

进一步的,当所述目标逻辑及封装类型为逻辑复杂非高度封装时,上述装置还包括:报错调整模块,用于在运行调整后的tensorflow训练代码时,若存在会话实体没有会话属性的报错函数,则在所述报错函数的定义行下方一行以与所述报错函数内部原代码段相同的缩进添加获取默认计算图的代码,并对所述报错函数内部原代码段整体增加缩进;若存在指示图形已完成且无法修改的报错,则在导入的所述配置tensorflow接口的horovod模块的下方一行添加清除默认图形堆栈并重置全局默认图形的代码段,并在会话定义处下方一行以相同缩进添加禁止图冻结的代码段;若存在指示会话类型错误的报错,则在类定义内部构造方法函数外部以相同缩进添加新的会话函数代码段,并将报错代码段中的已有会话函数定义关键字替换为与所述新的会话函数代码段对应的会话函数定义关键字。

[0247]

可选的,当所述目标逻辑及封装类型为逻辑简单高度封装或逻辑复杂高度封装时,训练代码调整模块530,具体用于在训练主文件中导入配置tensorflow接口的horovod模块;初始化所述horovod模块,并在对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定;查找引用高度封装应用程序接口的关键字,并使用重新设置的配置参数对所述关键字涉及的配置参数进行替换;根据加速卡总数量按倍数增大学习率。

[0248]

可选的,当所述目标逻辑及封装类型为逻辑简单高度封装时,训练代码调整模块530,具体用于在基于定义主函数的关键字对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定;当所述目标逻辑及封装类型为逻辑复杂高度封装时,训练代码调整模块530,具体用于在基于定义类中定义构造方法的关键字对各加速卡进行配置参数设置之后,将各加速卡与进程进行一对一绑定。

[0249]

本发明实施例所提供的深度学习模型的horovod分布式训练装置可执行本发明任意实施例所提供的深度学习模型的horovod分布式训练方法,具备执行方法相应的功能模块和有益效果。

[0250]

实施例六

[0251]

图6为本发明实施例六提供的一种计算机设备的结构示意图,如图6所示,该计算机设备包括处理器610、存储器620、输入装置630和输出装置640;计算机设备中处理器610的数量可以是一个或多个,图6中以一个处理器610为例;计算机设备中的处理器610、存储器620、输入装置630和输出装置640可以通过总线或其他方式连接,图6中以通过总线连接为例。

[0252]

存储器620作为一种计算机可读存储介质,可用于存储软件程序、计算机可执行程序以及模块,如本发明实施例中的深度学习模型的horovod分布式训练方法对应的程序指令/模块(例如,深度学习模型的horovod分布式训练装置中的训练代码获取模块510、逻辑及封装类型确定模块520、训练代码调整模块530和训练代码运行模块540)。处理器610通过运行存储在存储器620中的软件程序、指令以及模块,从而执行计算机设备的各种功能应用以及数据处理,即实现上述的深度学习模型的horovod分布式训练方法。

[0253]

存储器620可主要包括存储程序区和存储数据区,其中,存储程序区可存储操作系统、至少一个功能所需的应用程序;存储数据区可存储根据终端的使用所创建的数据等。此外,存储器620可以包括高速随机存取存储器,还可以包括非易失性存储器,例如至少一个磁盘存储器件、闪存器件、或其他非易失性固态存储器件。在一些实例中,存储器620可进一步包括相对于处理器610远程设置的存储器,这些远程存储器可以通过网络连接至计算机

设备。上述网络的实例包括但不限于互联网、企业内部网、局域网、移动通信网及其组合。

[0254]

输入装置630可用于接收输入的数字或字符信息,以及产生与计算机设备的用户设置以及功能控制有关的键信号输入。输出装置640可包括显示屏等显示设备。

[0255]

实施例七

[0256]

本发明实施例七还提供一种包含计算机可执行指令的存储介质,所述计算机可执行指令在由计算机处理器执行时用于执行一种深度学习模型的horovod分布式训练方法,该方法包括:

[0257]

获取目标深度学习模型的tensorflow训练代码;

[0258]

确定所述tensorflow训练代码的目标逻辑及封装类型;

[0259]

根据与所述目标逻辑及封装类型匹配的处理策略对所述tensorflow训练代码进行调整;

[0260]

运行调整后的tensorflow训练代码,以实现对所述目标深度学习模型的horovod分布式训练。

[0261]

当然,本发明实施例所提供的一种包含计算机可执行指令的存储介质,其计算机可执行指令不限于如上所述的方法操作,还可以执行本发明任意实施例所提供的深度学习模型的horovod分布式训练方法中的相关操作。

[0262]

通过以上关于实施方式的描述,所属领域的技术人员可以清楚地了解到,本发明可借助软件及必需的通用硬件来实现,当然也可以通过硬件实现,但很多情况下前者是更佳的实施方式。基于这样的理解,本发明的技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品可以存储在计算机可读存储介质中,如计算机的软盘、只读存储器(read

‑

only memory,rom)、随机存取存储器(random access memory,ram)、闪存(flash)、硬盘或光盘等,包括若干指令用以使得一台计算机设备(可以是个人计算机,服务器,或者网络设备等)执行本发明各个实施例所述的方法。

[0263]

值得注意的是,上述深度学习模型的horovod分布式训练装置的实施例中,所包括的各个单元和模块只是按照功能逻辑进行划分的,但并不局限于上述的划分,只要能够实现相应的功能即可;另外,各功能单元的具体名称也只是为了便于相互区分,并不用于限制本发明的保护范围。

[0264]

注意,上述仅为本发明的较佳实施例及所运用技术原理。本领域技术人员会理解,本发明不限于这里所述的特定实施例,对本领域技术人员来说能够进行各种明显的变化、重新调整和替代而不会脱离本发明的保护范围。因此,虽然通过以上实施例对本发明进行了较为详细的说明,但是本发明不仅仅限于以上实施例,在不脱离本发明构思的情况下,还可以包括更多其他等效实施例,而本发明的范围由所附的权利要求范围决定。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。