1.本发明涉及目标反演技术领域,尤其涉及联合叠前弹性反演参数及深度网络目标反演技术。

背景技术:

2.在页岩气工程甜点预测中(或者在目前勘探甜点预测中)有很多时候,我们可以从井数据通过拟合计算,获得与实际参数相吻合的曲线,比如地应力曲线,地层压力曲线,脆性曲线,往往是通过井上的各种弹性参数获得,包括纵横波速度、密度等参数;井是单点的预测,从点到面的预测就需要地震数据的处理,如果通过地震数据反演获得纵横波速度,密度等目标拟合需要的参数,再通过拟合获得目标参数,势必会增加计算过程中的累积误差,导致结果的不准性,同时通过拟合获得目标参数本来就是一种近似解,准确度就相对较低,在通过计算再拟合准确性必定会大大降低;所以引入深度神经网络算子,结合叠前反演,联合叠前数据共同建立非线性映射关系,获得我们需要的目标曲线,提高预测的准确性;

3.现有的目标反演技术通过地震数据反演获得纵横波速度,密度等目标拟合需要的参数,再通过拟合获得目标参数,势必增加计算过程中的累积误差,导致结果的不准性,拟合获得目标参数是一种近似解,准确度就相对较低,在通过计算再拟合准确性会大大降低;为此,我们提出联合叠前弹性反演参数及深度网络目标反演技术。

技术实现要素:

4.本发明的目的是为了解决现有技术中存在的缺陷,而提出的联合叠前弹性反演参数及深度网络目标反演技术。

5.为了实现上述目的,本发明采用了如下技术方案:

6.联合叠前弹性反演参数及深度网络目标反演技术,该目标反演技术具体步骤如下:

7.s1、对井数据进行计算,获得叠前弹性阻抗反演参数;

8.s2、对井旁道叠前地震数据进行一个角度划分,获得划分角度的叠前参数;

9.s3、将井旁道上每一个时间点对应的井旁道数据作为输入,该时间点上的井旁道目标数据作为输出约束;

10.s4、建立训练网络;

11.s5、通过训练获得映射网络,直接对全区数据进行映射计算;

12.s6、输入全区数据参数,并通过映射网络直接获得目标数据体。

13.作为本发明进一步方案,步骤s4中建立训练网络具体步骤为:

14.ss1、引入深度神经网络算法;

15.ss2、通过一个全连接多层网络,挖掘井旁道数据输入数据与井旁道目标数据之间的关系,获得非线性映射网络。

16.作为本发明进一步方案,步骤ss1中深度神经网络算法用于建立标签数据集与训

练数据集之间的关系,形成预测网络;

17.其中,深度神经网络算法按不同层的位置划分,其内部的神经网络层可以分为三类:输入层、隐藏层和输出层,层与层之间全连接,具体表现如下:

18.第i层的任意一个神经元一定与第i 1层的任意一个神经元相连,即存在一个线性关系;

19.z=∑w

i

x

i

b

20.ꢀꢀꢀꢀꢀꢀꢀ

(1)

21.其中,z为输出层,w为权重值,x为输入层,b为偏置;通过加上最终激活函数σ(z),形成了dnn的基本结构。

22.作为本发明进一步方案,所述深度神经网络算法为包含多层隐藏层的神经网络算法,前向传播阶段,隐藏层将前一层的输出作为后一层的输入,具体为:

[0023][0024][0025]

其中,代表dnn第l层第k个神经元激活前的输出,代表dnn第l层第k个神经元激活后的输出,代表到的线性传递系数,代表前向传播函数的偏倚常数,f为激活函数。

[0026]

作为本发明进一步方案,所述激活函数可采用relu函数,relu函数是常见的激活函数中的一种,表达形式如下:

[0027]

f(x)=max(0,x)

[0028]

ꢀꢀꢀꢀꢀꢀꢀꢀ

(4)。

[0029]

作为本发明进一步方案,步骤s1中叠前弹性阻抗反演参数包括纵波速度、横波速度与密度。

[0030]

作为本发明进一步方案,步骤s2中划分角度的叠前参数包括大角度数据、中角度数据与小角度数据。

[0031]

相比于现有技术,本发明的有益效果在于:

[0032]

本发明能够更好的针对地震目标参数进行预测,提高了预测的准确性,高效性,深度网络深度挖掘数据内部信息,提高信息的表征度,解决了通过拟合求解目标数据过程中存在的累积误差和近似误差,直接通过叠前反演获得的参数和不同角度数据增强了算法的可信度和真实性。

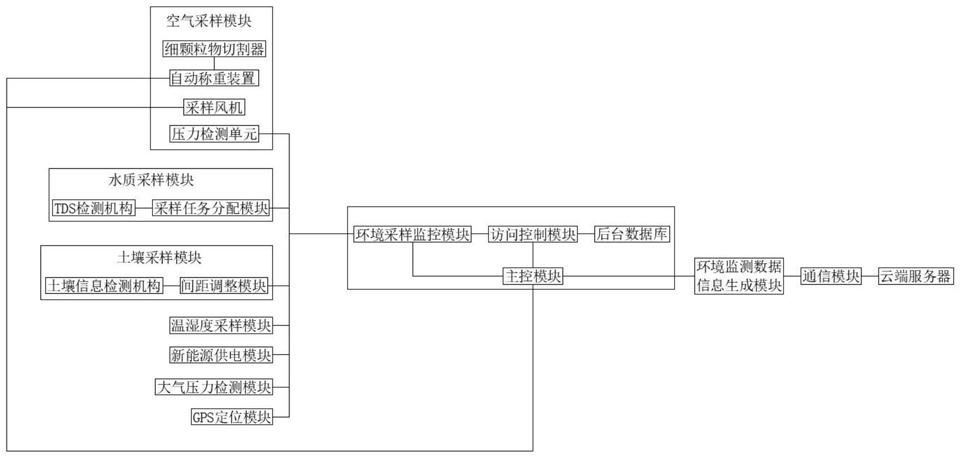

附图说明

[0033]

附图用来提供对本发明的进一步理解,并且构成说明书的一部分,与本发明的实施例一起用于解释本发明,并不构成对本发明的限制。

[0034]

图1为本发明提出的联合叠前弹性反演参数及深度网络目标反演技术的整体流程图;

[0035]

图2为本发明提出的联合叠前弹性反演参数及深度网络目标反演技术中深度神经网络算法的流程图。

具体实施方式

[0036]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。

[0037]

实施例1

[0038]

参照图1,本实施例公开了联合叠前弹性反演参数及深度网络目标反演技术,该目标反演技术具体步骤如下:

[0039]

s1、对井数据进行计算,获得叠前弹性阻抗反演参数;

[0040]

具体的,叠前弹性阻抗反演参数包括纵波速度、横波速度与密度。

[0041]

s2、对井旁道叠前地震数据进行一个角度划分,获得划分角度的叠前参数;

[0042]

具体的,划分角度的叠前参数包括大角度数据、中角度数据与小角度数据。

[0043]

s3、将井旁道上每一个时间点对应的井旁道数据作为输入,该时间点上的井旁道目标数据作为输出约束;

[0044]

s4、建立训练网络;

[0045]

另外,需要说明的是,在建立训练网络时,可引入深度神经网络算法,并通过一个全连接多层网络,挖掘输入数据与目标数据之间的关系,获得非线性映射网络;

[0046]

s5、通过训练获得映射网络,直接对全区数据进行映射计算;

[0047]

s6、输入全区数据参数,并通过映射网络直接获得目标数据体;

[0048]

具体的,全区数据参数包括纵波速度、横波速度、密度、大角度数据、中角度数据与小角度数据。

[0049]

实施例2

[0050]

参照图2,本实施例公开了联合叠前弹性反演参数及深度网络目标反演技术;本实施例除与实施例1相同步骤外,主要阐述深度神经网络算法;

[0051]

本实施例中,深度神经网络算法(dnn)用于建立标签数据集与训练数据集之间的关系,形成预测网络,其采用神经网络技术,该神经网络技术亦叫感知机,拥有输入层、输出层和一个隐含层,输入的特征向量通过隐含层变换达到输出层,在输出层得到分类结果,dnn可以理解为有很多隐藏层的神经网络;

[0052]

需要进一步说明的是,深度神经网络算法可按不同层的位置划分,其内部的神经网络层可以分为三类:输入层、隐藏层和输出层,层与层之间全连接,具体表现如下:

[0053]

第i层的任意一个神经元一定与第i 1层的任意一个神经元相连,即存在一个线性关系;

[0054]

z=∑w

i

x

i

b

[0055]

ꢀꢀꢀꢀꢀꢀꢀ

(1)

[0056]

其中,z为输出层,w为权重值,x为输入层,b为偏置;通过加上最终激活函数σ(z),形成了dnn的基本结构;

[0057]

另外,深度神经网络算法可为包含多层隐藏层的神经网络算法,前向传播阶段,隐藏层将前一层的输出作为后一层的输入,具体为:

[0058][0059][0060]

其中,代表dnn第l层第k个神经元激活前的输出,代表dnn第l层第k个神经元激活后的输出,代表到的线性传递系数,代表前向传播函数的偏倚常数,f为激活函数。

[0061]

具体的,上述激活函数可采用relu函数,relu函数是常见的激活函数中的一种,表达形式如下:

[0062]

f(x)=max(0,x)

[0063]

ꢀꢀꢀꢀꢀꢀꢀ

(4);

[0064]

本实施例中的relu其实就是个取最大值的函数,relu函数其实是分段线性函数,把所有的负值都变为0,而正值不变,这种操作被成为单侧抑制,在输入是负值的情况下,它会输出0,那么神经元就不会被激活,这意味着同一时间只有部分神经元会被激活,从而使得网络很稀疏,进而对计算来说是非常有效率的,尤其体现在深度神经网络模型(如cnn)中,当模型增加n层之后,理论上relu神经元的激活率将降低2

n

倍;因此,没有饱和区,不存在梯度消失问题;没有复杂的指数运算,计算简单、效率提高;实际收敛速度较快,比sigmoid/tanh快很多;比sigmoid更符合生物学神经激活机制。

[0065]

综上,通过针对地震目标参数进行预测,提高了预测的准确性,高效性,深度网络深度挖掘数据内部信息,提高信息的表征度,解决了通过拟合求解目标数据过程中存在的累积误差和近似误差,直接通过叠前反演获得的参数和不同角度数据增强了算法的可信度和真实性。

[0066]

以上所述,仅为本发明较佳的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,根据本发明的技术方案及其发明构思加以等同替换或改变,都应涵盖在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。