技术特征:

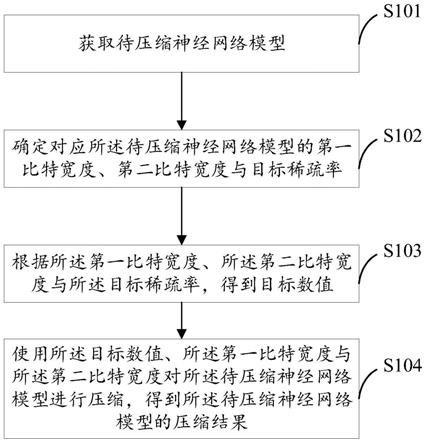

1.一种压缩神经网络模型的方法,包括:获取待压缩神经网络模型;确定对应所述待压缩神经网络模型的第一比特宽度、第二比特宽度与目标稀疏率;根据所述第一比特宽度、所述第二比特宽度与所述目标稀疏率,得到目标数值;使用所述目标数值、所述第一比特宽度与所述第二比特宽度对所述待压缩神经网络模型进行压缩,得到所述待压缩神经网络模型的压缩结果。2.根据权利要求1所述的方法,其中,所述确定对应所述待压缩神经网络模型的第一比特宽度包括:确定运行所述待压缩神经网络模型的处理器;将所述处理器的向量宽度,作为对应所述待压缩神经网络模型的第一比特宽度。3.根据权利要求1-2中任一项所述的方法,其中,所述确定对应所述待压缩神经网络模型的第二比特宽度包括:确定运行所述待压缩神经网络模型的处理器;根据所述处理器中的指令集的向量宽度,确定对应所述待压缩神经网络模型的第二比特宽度。4.根据权利要求1-3中任一项所述的方法,其中,所述确定对应所述待压缩神经网络模型的目标稀疏率包括:获取所述待压缩神经网络模型的属性信息;将与所述属性信息对应的稀疏率,作为对应所述待压缩神经网络模型的目标稀疏率。5.根据权利要求1-4中任一项所述的方法,其中,所述根据所述第一比特宽度、所述第二比特宽度与所述目标稀疏率,得到目标数值包括:计算所述第二比特宽度与所述目标稀疏率之间的乘积;将所述第一比特宽度与所述乘积之间的相除结果,作为所述目标数值。6.根据权利要求1-5中任一项所述的方法,其中,所述使用所述目标数值、所述第一比特宽度与所述第二比特宽度对所述待压缩神经网络模型进行压缩,得到所述待压缩神经网络模型的压缩结果包括:根据所述目标数值、所述第一比特宽度与所述第二比特宽度,对所述待压缩神经网络模型中的参数进行稀疏化处理,得到第一神经网络模型;根据所述第一神经网络模型,得到所述待压缩神经网络模型的压缩结果。7.根据权利要求6所述的方法,其中,所述根据所述目标数值、所述第一比特宽度与所述第二比特宽度,对所述待压缩神经网络模型中的参数进行稀疏化处理,得到第一神经网络模型包括:将所述待压缩神经网络模型中连续的、对应所述目标数值个数的参数作为一个参数单元;按照绝对值从小到大的顺序,对所述参数单元包含的参数进行排序;根据所述第一比特宽度、所述第二比特宽度与所述目标数值,得到置零数量;将所述待压缩神经网络模型的参数单元中排在置零数量之前的参数设置为零,得到所述第一神经网络模型。8.根据权利要求6-7中任一项所述的方法,其中,所述根据所述第一神经网络模型,得

到所述待压缩神经网络模型的压缩结果包括:根据所述第二比特宽度,对所述第一神经网络模型中未设置为零的参数进行量化处理;将量化处理之后的神经网络模型,作为所述待压缩神经网络模型的压缩结果。9.根据权利要求1-5中任一项所述的方法,其中,所述使用所述目标数值、所述第一比特宽度与所述第二比特宽度对所述待压缩神经网络模型进行压缩,得到所述待压缩神经网络模型的压缩结果包括:获取训练数据;根据所述目标数值、所述第一比特宽度与所述第二比特宽度,对所述待压缩神经网络模型中的参数进行稀疏化处理,得到稀疏化神经网络模型;使用所述训练数据对所述稀疏化神经网络模型进行训练,得到所述稀疏化神经网络模型的损失函数值与模型精度;在确定所述模型精度未满足第一预设条件的情况下,使用所述损失函数值对所述待压缩神经网络模型的参数进行调整之后,转至执行得到稀疏化神经网络模型的步骤,直至所述模型精度满足第一预设条件,将所述稀疏化神经网络模型作为第二神经网络模型;根据所述第二神经网络模型,得到所述待压缩神经网络模型的压缩结果。10.根据权利要求9所述的方法,其中,所述根据所述第二神经网络模型,得到所述待压缩神经网络模型的压缩结果包括:根据所述第二比特宽度,对所述第二神经网络模型中未设置为零的参数进行量化处理,得到量化神经网络模型;使用所述训练数据对所述量化神经网络模型进行训练,得到所述量化神经网络模型的损失函数值与模型精度;在确定所述模型精度未满足第二预设条件的情况下,使用所述损失函数值对所述第二神经网络模型的参数进行调整之后,转至执行得到所述量化神经网络模型的步骤,直至所述模型精度满足第二预设条件,将所述量化神经网络模型作为所述待压缩神经网络模型的压缩结果。11.一种压缩神经网络模型的装置,包括:获取单元,用于获取待压缩神经网络模型;确定单元,用于确定对应所述待压缩神经网络模型的第一比特宽度、第二比特宽度与目标稀疏率;处理单元,用于根据所述第一比特宽度、所述第二比特宽度与所述目标稀疏率,得到目标数值;压缩单元,用于使用所述目标数值、所述第一比特宽度与所述第二比特宽度对所述待压缩神经网络模型进行压缩,得到所述待压缩神经网络模型的压缩结果。12.根据权利要求11所述的装置,其中,所述确定单元在确定对应所述待压缩神经网络模型的第一比特宽度时,具体执行:确定运行所述待压缩神经网络模型的处理器;将所述处理器的向量宽度,作为对应所述待压缩神经网络模型的第一比特宽度。13.根据权利要求11-12中任一项所述的装置,其中,所述确定单元在确定对应所述待

压缩神经网络模型的第二比特宽度时,具体执行:确定运行所述待压缩神经网络模型的处理器;根据所述处理器中的指令集的向量宽度,确定对应所述待压缩神经网络模型的第二比特宽度。14.根据权利要求11-13中任一项所述的装置,其中,所述确定单元在确定对应所述待压缩神经网络模型的目标稀疏率时,具体执行:获取所述待压缩神经网络模型的属性信息;将与所述属性信息对应的稀疏率,作为对应所述待压缩神经网络模型的目标稀疏率。15.根据权利要求11-14中任一项所述的装置,其中,所述处理单元在根据所述第一比特宽度、所述第二比特宽度与所述目标稀疏率,得到目标数值时,具体执行:计算所述第二比特宽度与所述目标稀疏率之间的乘积;将所述第一比特宽度与所述乘积之间的相除结果,作为所述目标数值。16.根据权利要求11-15中任一项所述的装置,其中,所述压缩单元在使用所述目标数值、所述第一比特宽度与所述第二比特宽度对所述待压缩神经网络模型进行压缩,得到所述待压缩神经网络模型的压缩结果时,具体执行:根据所述目标数值、所述第一比特宽度与所述第二比特宽度,对所述待压缩神经网络模型中的参数进行稀疏化处理,得到第一神经网络模型;根据所述第一神经网络模型,得到所述待压缩神经网络模型的压缩结果。17.根据权利要求16所述的装置,其中,所述压缩单元在根据所述目标数值、所述第一比特宽度与所述第二比特宽度,对所述待压缩神经网络模型中的参数进行稀疏化处理,得到第一神经网络模型时,具体执行:将所述待压缩神经网络模型中连续的、对应所述目标数值个数的参数作为一个参数单元;按照绝对值从小到大的顺序,对所述参数单元包含的参数进行排序;根据所述第一比特宽度、所述第二比特宽度与所述目标数值,得到置零数量;将所述待压缩神经网络模型的参数单元中排在置零数量之前的参数设置为零,得到所述第一神经网络模型。18.根据权利要求16-17中任一项所述的装置,其中,所述压缩单元在根据所述第一神经网络模型,得到所述待压缩神经网络模型的压缩结果时,具体执行:根据所述第二比特宽度,对所述第一神经网络模型中未设置为零的参数进行量化处理;将量化处理之后的神经网络模型,作为所述待压缩神经网络模型的压缩结果。19.根据权利要求11-15中任一项所述的装置,其中,所述压缩单元在使用所述目标数值、所述第一比特宽度与所述第二比特宽度对所述待压缩神经网络模型进行压缩,得到所述待压缩神经网络模型的压缩结果时,具体执行:获取训练数据;根据所述目标数值、所述第一比特宽度与所述第二比特宽度,对所述待压缩神经网络模型中的参数进行稀疏化处理,得到稀疏化神经网络模型;使用所述训练数据对所述稀疏化神经网络模型进行训练,得到所述稀疏化神经网络模

型的损失函数值与模型精度;在确定所述模型精度未满足第一预设条件的情况下,使用所述损失函数值对所述待压缩神经网络模型的参数进行调整之后,转至执行得到所述稀疏化神经网络模型的步骤,直至所述模型精度满足第一预设条件,将所述稀疏化神经网络模型作为第二神经网络模型;根据所述第二神经网络模型,得到所述待压缩神经网络模型的压缩结果。20.根据权利要求19所述的装置,其中,所述压缩单元在根据所述第二神经网络模型,得到所述待压缩神经网络模型的压缩结果时,具体执行:根据所述第二比特宽度,对所述第二神经网络模型中未设置为零的参数进行量化处理,得到量化神经网络模型;使用所述训练数据对所述量化神经网络模型进行训练,得到所述量化神经网络模型的损失函数值与模型精度;在确定所述模型精度未满足第二预设条件的情况下,使用所述损失函数值对所述第二神经网络模型的参数进行调整之后,转至执行得到所述量化神经网络模型的步骤,直至所述模型精度满足第二预设条件,将所述量化神经网络模型作为所述待压缩神经网络模型的压缩结果。21.一种电子设备,包括:至少一个处理器;以及与所述至少一个处理器通信连接的存储器;其中,所述存储器存储有可被所述至少一个处理器执行的指令,所述指令被所述至少一个处理器执行,以使所述至少一个处理器能够执行权利要求1-10中任一项所述的方法。22.一种存储有计算机指令的非瞬时计算机可读存储介质,其中,所述计算机指令用于使所述计算机执行权利要求1-10中任一项所述的方法。23.一种计算机程序产品,包括计算机程序,所述计算机程序在被处理器执行时实现根据权利要求1-10中任一项所述的方法。

技术总结

本公开提供了一种压缩神经网络模型的方法、装置、电子设备及可读存储介质,涉及深度学习、云服务等人工智能技术领域。其中,压缩神经网络模型方法包括:获取待压缩神经网络模型;确定对应所述待压缩神经网络模型的第一比特宽度、第二比特宽度与目标稀疏率;根据所述第一比特宽度、所述第二比特宽度与所述目标稀疏率,得到目标数值;使用所述目标数值、所述第一比特宽度与所述第二比特宽度对所述待压缩神经网络模型进行压缩,得到所述待压缩神经网络模型的压缩结果。本公开能够简化神经网络模型的压缩步骤、提升神经网络模型的压缩效率。提升神经网络模型的压缩效率。提升神经网络模型的压缩效率。

技术研发人员:王桂彬 丛士钧 董昊 贾磊

受保护的技术使用者:北京百度网讯科技有限公司

技术研发日:2021.12.02

技术公布日:2022/4/29

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。