一种基于特征表示对比学习策略的样本不平衡分类优化方法

- 国知局

- 2024-07-31 22:48:42

本发明涉及机器学习和人工智能。具体而言,涉及一种基于特征表示对比学习策略的样本不平衡分类优化方法。

背景技术:

1、当前在机器学习中,处理不平衡样本的策略主要聚焦于数据层面和算法层面。

2、在数据层面,常见的策略包括:(1)过采样少数类样本,如采用随机过采样、smote和adasyn等技术,通过复制或生成新数据来平衡样本数量。然而,这种方法可能导致模型对过采样数据过度拟合,削弱了对真实数据分布的泛化能力。(2)欠采样多数类样本,包括随机欠采样、tomek links和enn等方法,以减少多数类别样本数量。但这样做可能丢失原始数据中的关键信息,影响模型对多数类别特征的学习。

3、算法层面,主要方法包括:(1)代价敏感学习,通过调整损失函数,赋予不同类别样本不同的权重,以优化模型对少数类别的分类性能。然而,这种方法往往忽视了样本间的内在关系,这在某些情况下可能导致模型性能下降。(2)集成学习,通过结合多个分类器的预测结果来增强整体性能。但集成效果受限于基分类器的质量和选择。

4、然而,这些方法均存在不足。首先,不平衡数据集常常导致模型对多数类别的过度偏向,忽略了少数类别的识别,从而降低模型性能。其次,它们往往忽略了样本间的内在关系,这在处理具有复杂关系的数据集时尤为明显,导致模型性能下降。因此,需要探索更加全面、有效的方法来处理不平衡样本问题。

技术实现思路

1、针对上述问题,本发明旨在提供一种基于特征表示对比学习策略的样本不平衡分类优化方法,通过对比学习策略和特征表示优化的结合,在分类任务中取得了显著的进展。

2、本发明采用的技术方案如下:

3、一种基于特征表示对比学习策略的样本不平衡分类优化方法,包括以下步骤:

4、步骤1:数据集预处理;

5、步骤2:构建三元组网络训练所需的数据集;

6、步骤3:对比学习网络搭建和训练;

7、步骤4:原始数据集的特征表示转换;

8、步骤5:利用转换后的特征表示进行数据分类。

9、进一步的,步骤1中,数据集包含数值型和枚举型特征,数据集预处理包括以下步骤:

10、步骤1.1:枚举型特征从数据集中切分;

11、步骤1.2:对枚举型特征进行one-hot编码,并将编码后的部分与原本切分后的数值型特征进行合并;

12、步骤1.3:对数据部分进行归一化,分离标签;

13、步骤1.4:分割80%的数据作为训练集,20%作为测试集。

14、进一步的,步骤2中,三元组是这样构成的:从训练集中随机选一个样本,该样本称为anchor,记为a,然后再随机选取一个和anchor属于同一类的样本和不属于同一类的样本,这两个样本对应的称为positive和negative,positive记为p,negative记为n,由此构成一个三元组<a,p,n>;步骤2包括以下步骤:

15、步骤2.1:将样本按类别分别保存;

16、步骤2.2:将正常样本作为anchor样本,随机选择相同类别的样本作为positive样本,然后按顺序选择不同类别的样本中的一个作为negative样本,为每个正常的样本生成n-1个三元组,n为样本类别数;

17、步骤2.3:将除了正常样本之外的其他类别分别作为anchor样本,进行与步骤2.2相同的操作,控制每一类生成的三元组数量;

18、步骤2.4:合并两步生成的三元组并保存用于后续对比学习网络的训练。

19、进一步的,步骤3搭建用于特征表示对比学习的神经网络,包括以下步骤:

20、步骤3.1:确定特征表示对比学习的损失函数;

21、采用triplet loss作为特征表示对比学习的核心损失函数,triplet loss以三元组<a,p,n>为学习对象,旨在构建一个特征空间,使同类别样本间的距离拉近,而异类别样本间的距离推远;通过设置间隔距离margin,将正样本对与负样本对有效分离,确保在嵌入空间中,同类样本点间距离足够近,而异类样本点间距离足够远;通过优化triplet loss,确保基准样本与负样本的距离显著大于其与正样本的距离,实现精准的特征表示对比学习;对比学习的损失函数用欧氏距离形式化表示为:

22、l=max{d(a,p)-d(a,n)+mar gin,0}

23、步骤3.2:搭建特征表示对比学习的神经网络模型;

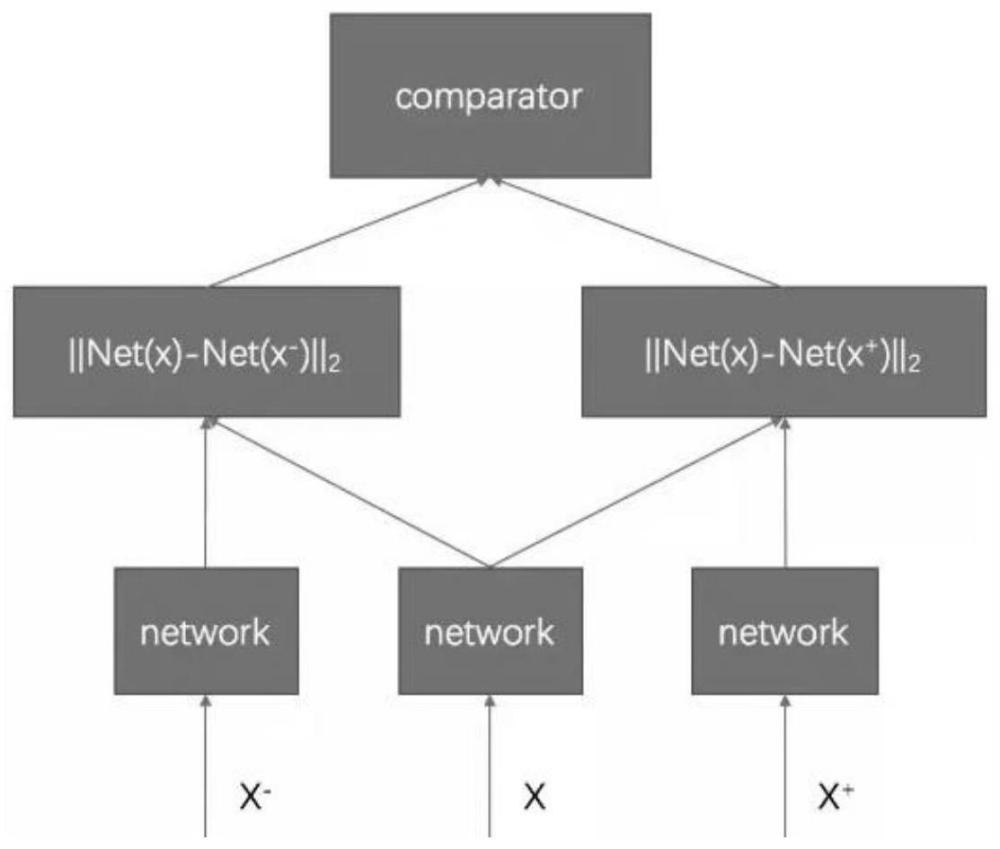

24、构建三联孪生神经网络实现对triplet loss的学习,三联孪生神经网络由三个结构相同且共享参数的前馈网络组成,这些前馈网络被统一标记为net(x);在训练过程中,三联孪生神经网络每次接收三个样本作为输入,这三个样本分别标记为a、p和n;每个样本经过前馈网络net(x)的处理后,会被转换为具有特定长度的特征向量,即net(a)、net(p)和net(n);利用这些转换后的特征向量net(a)、net(p)和net(n)来计算triplet loss,实现对神经网络的训练。

25、进一步的,步骤4包括以下步骤:

26、通过步骤3得到已训练完成的三联孪生神经网络,此时的三联孪生神经网络已经能够提取原始样本的关键特征;基于该神经网络模型对原始的训练集和测试集进行特征提取,并将转换后的特征表示保存代替原本的训练集与测试集。

27、进一步的,步骤5包括以下步骤:

28、将转换后的特征表示处理为适合分类器学习的形状,分类器对训练集转换的特征表示进行学习,然后评估方法性能。

29、本发明的有益效果是:

30、本发明首先利用triplet loss对比学习的思路对样本特征表示进行预训练,通过深入学习同类和异类样本对间的相似度任务,来增强模型对样本特征表示的学习能力,从而从原始数据集中抽取出关键特征,为后续的分类任务奠定坚实基础。接着,将这些基于预训练转换后的特征表示用于下游的分类任务,构建和训练分类模型,实现对不平衡样本集的有效分类。相较于传统方法,本发明的基于特征表示对比学习的方法更能全面考虑每个样本在特征空间中的位置关系,有效避免了对少数类别的忽略,从而实现了对不平衡样本的有效分类。本发明的优化方法能够有效解决样本不平衡问题,提高分类模型的性能,具有广泛的应用前景。

技术特征:1.一种基于特征表示对比学习策略的样本不平衡分类优化方法,其特征在于,包括以下步骤:

2.根据权利要求1所述的一种基于特征表示对比学习策略的样本不平衡分类优化方法,其特征在于,步骤1中,数据集包含数值型和枚举型特征,数据集预处理包括以下步骤:

3.根据权利要求2所述的一种基于特征表示对比学习策略的样本不平衡分类优化方法,其特征在于,步骤2中,三元组是这样构成的:从训练集中随机选一个样本,该样本称为anchor,记为a,然后再随机选取一个和anchor属于同一类的样本和不属于同一类的样本,这两个样本对应的称为positive和negative,positive记为p,negative记为n,由此构成一个三元组<a,p,n>;步骤2包括以下步骤:

4.根据权利要求3所述的一种基于特征表示对比学习策略的样本不平衡分类优化方法,其特征在于,步骤3搭建用于特征表示对比学习的神经网络,包括以下步骤:

5.根据权利要求4所述的一种基于特征表示对比学习策略的样本不平衡分类优化方法,其特征在于,步骤4包括以下步骤:

6.根据权利要求5所述的一种基于特征表示对比学习策略的样本不平衡分类优化方法,其特征在于,步骤5包括以下步骤:

技术总结本发明涉及一种基于特征表示对比学习策略的样本不平衡分类优化方法。首先利用Triplet loss对比学习的思路对样本特征表示进行预训练,通过深入学习同类和异类样本对间的相似度任务,来增强模型对样本特征表示的学习能力,从而从原始数据集中抽取出关键特征,为后续的分类任务奠定坚实基础。接着,将这些基于预训练转换后的特征表示用于下游的分类任务,构建和训练分类模型,实现对不平衡样本集的有效分类。本发明的基于特征表示对比学习的方法更能全面考虑每个样本在特征空间中的位置关系,有效避免了对少数类别的忽略,从而实现了对不平衡样本的有效分类。本发明能够有效解决样本不平衡问题,提高分类模型的性能,具有广泛的应用前景。技术研发人员:邵国林,吴恒锐,卢一,胡泽毅受保护的技术使用者:南昌大学技术研发日:技术公布日:2024/7/29本文地址:https://www.jishuxx.com/zhuanli/20240730/194746.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。