基于深度强化学习的自动驾驶汇入工况下交通参与者动态行为生成方法

- 国知局

- 2024-07-31 20:34:13

本发明涉及无人驾驶汽车上匝道行车安全评估领域,具体说就是一种基于深度强化学习的匝道行车场景下具有博弈性交通流车辆生成方法。

背景技术:

1、对于智能汽车来说,交通流车辆是行驶环境的重要组成部分,不同场景下不同驾驶风格的交通流车辆对智能车辆的安全性、可靠性具有深刻影响。无人驾驶已经逐步在各类矿区和工业园区等相对简单的场景得到了广泛的应用,但是对于实际公路等相对复杂的驾驶场景,要考虑到障碍物、交通标识、地面路况和其他行驶车辆等环境因素,这为无人驾驶的落地带来了许多不确定的危险,如何确定无人驾驶车辆的可靠性、找到其存在的缺陷成为迫切的需求。现有的场景生成方法是人工搭建的,其他交通参与者的运动都是在运行前确定下来,无法主动且深度发掘无人驾驶车辆存在的不足。

技术实现思路

1、本发明为了克服上述现有技术的不足之处,提供一种基于深度强化学习的自动驾驶汇入工况下交通参与者动态行为生成方法,以期能生成具有博弈行为的交通流车辆,在匝道场景下与智能汽车换道行为进行博弈,从而发掘智能汽车在匝道场景下的不足,使汽车在行驶过程中安全高效地通行,为智能汽车的安全导航提供保障。

2、本发明为达到上述发明目的,采用如下的技术方案是:

3、本发明一种基于深度强化学习的自动驾驶汇入工况下交通参与者动态行为生成方法的特点是应用于交通流车辆阻止测试车辆在匝道口处向目标车道换道的行车场景中,并包括如下步骤:

4、步骤1、建立交通流车辆的动力学模型,并根据动力学模型获得交通流车辆加速度aagent的上限和下限,并以交通流车辆的加速度aagent作为神经网络的动作参数a;

5、步骤2、根据采集到的环境信息,并结合动力学模型,构建状态参数集s=(xagent,yagent,xego,yego,vagent,vego,aagent,aego,θego),其中,(xagent,yagent)表示交通流车辆的坐标、(xego,yego)表示测试车辆的坐标、vagent表示交通流车辆的速度、vego表示测试车辆的速度、aego表示测试车辆的加速度、θego表示测试车辆的航向角;

6、步骤3、构建奖励函数的四个组成部分,用于交通流车辆与测试车辆之间的博弈;

7、步骤4、构建深度神经网络,并初始化强化学习参数;

8、基于历史状态参数集s={si|i=1,2,…,n}和历史动作参数a={ai|i=1,2,…,n}对所述深度神经网络进行训练,并得到最优阻止换道模型;其中,si表示第i步的状态参数,ai表示第i步的动作参数;

9、将当前场景在第i步的状态参数s′i输入所述最优阻止换道模型中,并输出当前场景在第i步的动作参数a′i并作为交通流车辆的第i步加速度,从而控制交通流车辆在当前场景第i步纵向运动,以阻止测试车辆换道。

10、本发明所述的一种基于深度强化学习的自动驾驶汇入工况下交通参与者动态行为生成方法的特点在于,所述步骤1包括:

11、步骤1.1:建立交通流车辆的纵向驱动模型,从而得到交通流车辆加速度aagent的上限:

12、对交通流纵向受力进行建模,交通流车辆纵向运动的动力来源于前轮纵向力与后轮纵向力,而阻力来源于风阻、坡道阻力、前轮滚动摩擦力与后轮滚动摩擦力;

13、根据发动机转矩、变速器传动比、主减速器传动比、液力变矩器的扭矩特性函数、交通流车辆中液力变矩器涡轮的转速、发动机的转速和传动系机械效率计算前后车轮的纵向力;

14、根据交通流车辆相对于风的速度、车辆迎风面积、空气密度和风阻系数计算当前风阻,根据车重、道路坡度和滚动摩擦系数计算交通流车辆受到的前后车轮滚动摩擦力与坡道阻力;

15、通过交通流车辆能提供的最大动力与当前阻力的差值,计算出交通流车辆加速度上限;

16、步骤1.2:利用构建交通流车辆的纵向制动模型,从而得到交通流车辆的加速度aagent的下限:

17、对于交通流车辆加速度的下限,根据车辆制动系提供给车轮的最大制动力矩、车轮半径、滚阻、风阻、坡道阻力计算得到。

18、所述步骤3包括:

19、步骤3.1:构建第一部分的奖励函数r1:

20、第一部分奖励函数r1由两车横纵向间距组成,并设定博弈距离的超参数,使得交通流车辆与被测车辆纵向间距保持在博弈距离内,当间距小于博弈距离时,第一部分的奖励函数r1达到最大值0;

21、步骤3.2:构建第二部分的奖励函数r2:

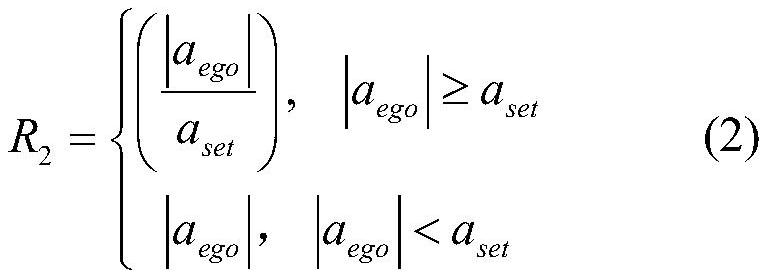

22、第二部分的奖励函数r2是由被测车辆的加速度组成,且第二部分的奖励函数与被测车辆加速度的绝对值成正比;设定博弈指标的超参数,当加速度的绝对值大约博弈指标的超参数时,第二部分的奖励函数与被测车辆的加速度绝对值的比值增大;

23、步骤3.3:构建第三部分的奖励函数r3:

24、若被测车辆车身从未进入目标车道,则视为未发生换道,给予定值的惩罚;

25、若被测车辆放弃换道时,则根据放弃换道时两车质心横向间距给予奖励,当间距为车道宽度的一半时,r3达到最大值;

26、步骤3.4:若发生追尾碰撞,则令第四部分的奖励函数r4为负数,否则,令r4为正数。

27、所述步骤4包括:

28、步骤4.1:初始化衰减系数,经验回放池的容量,训练的步数,同时将高速匝道场景时间进行离散化;

29、步骤4.2:构建策略网络和价值网络并初始化网络的权重参数和偏置参数:策略网络包含两个全连接网络,分别输出动作的均值和方差构成的高斯分布;价值网络输出当前状态的价值函数;

30、步骤4.3:将当前时刻i的状态参数si输入策略网络πθ′的输入层,得到交通流车辆第i时刻动作参数ai所对应的高斯分布的均值与方差,根据均值与方差随机得到交通流车辆第i时刻执行的动作ai,执行动作后记录i+1时刻的状态si+1和根据步骤三奖励函数计算出的奖励ri,将(si,ai,si+1,ri)作为一条样本存入经验池中;

31、步骤4.4:若经验池的样本数量达到容量上限,则执行步骤4.5;否则,i+1赋值给i后,返回步骤4.3;

32、步骤4.5:从经验池中随机抽取一批样本对策略网络和价值网络进行训练;

33、对于任意第i条样本(si,ai,si+1,ri),用价值网络计算第i条样本中si与si+1对应的状态价值;用第i条样本的si与si+1对应的状态价值计算第i条样本的优势函数及价值网络梯度;

34、用新策略和旧策略在同状态si下选择同动作ai的概率比值与第i条样本的优势函数的乘积,得到策略网络的梯度;所述旧策略是在训练过程中更新前的策略网络,所述新策略是在训练过程中更新后的策略网络;

35、步骤4.6:基于随机梯度下降法对步骤4.5所计算的所有样本对应的策略网络的梯度与价值网络的梯度进行优化求解,以更新策略网络的参数与价值网络的参数;

36、步骤4.7:若是训练步数和未达到指定步数,则用训练更新后的新策略网络与环境互动,返回步骤4.3继续采集样本进行训练;循环数次在达到指定步数后得到包含策略网络的最优参数与价值网络和最优参数的最优阻止换道模型,用于控制交通流车辆在匝道汇入工况下与智能车辆进行博弈。

37、本发明一种电子设备,包括存储器以及处理器的特点在于,所述存储器用于存储支持处理器执行所述自动驾驶汇入工况下交通参与者动态行为生成方法的程序,所述处理器被配置为用于执行所述存储器中存储的程序。

38、本发明一种计算机可读存储介质,计算机可读存储介质上存储有计算机程序的特点在于,所述计算机程序被处理器运行时执行所述自动驾驶汇入工况下交通参与者动态行为生成方法的步骤。

39、与现有技术相比,本发明的有益效果体现在:

40、1、本发明利用深度强化学习ppo算法训练其他交通车辆,结合博弈性理论设计奖励函数,可以生成具有博弈性的交通流车辆,同时交通流场景可以更贴合行车的实际。

41、2、相较于传统的场景生成方法,本发明引入了深度强化学习所具有的探索与开发的优点。在传统方法陷入局部最优的情况下,本方法可以学习如何跳出局部稳定点,因此交通流车辆可以根据被测车辆的表现,不停探索优化采取的博弈性动作,产生的场景比传统方法更加全面。

42、3、本发明通过博弈性理论设计奖励函数,利用深度强化学习追求最大奖励的趋势,鼓励交通流车辆与被测车辆产生博弈,由此可以在智能车辆匝道汇入工况下,针对被测车辆的行为,逐步生成边缘性、小概率的交通场景。从而解决了传统场景生成方法中,交通流车辆无法掌握合理的博弈强度,也无法根据以往场景的效果,调整自身的动作风格。

本文地址:https://www.jishuxx.com/zhuanli/20240731/186928.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表