一种图稀疏掩膜窗口注意力的学习图像压缩方法及装置

- 国知局

- 2024-08-02 14:04:44

本发明涉及数据压缩和计算机视觉的,尤其涉及一种图稀疏掩膜窗口注意力的学习图像压缩方法,以及一种图稀疏掩膜窗口注意力的学习图像压缩装置。

背景技术:

1、自从johannes ballé等人第一次提出端到端学习图像压缩框架以来,深度图像压缩已经在图像压缩任务上受到了极大的关注。这种深度架构利用非线性变换模块的表达能力来消除图像内容的空间冗余。此后,越来越多的研究工作集中在如何提高学习图像压缩的编码效率以及是否有任何先进的框架来重新定义学习图像压缩。得益于数据样本的丰富性和各种神经网络的成熟,学习图像压缩可以实现优于传统图像编解码器的先进性能。然而,更深的网络层导致深度模型的复杂性增加,并且堆叠的神经模块失去了对模块设计的解释。

2、从编码效率的角度来看,许多工作都关注于更好地建模熵估计。johannes ballé等人提出了超先验模块,以进一步消除潜在变量的特征冗余,并将自回归和分层先验引入熵模型以构建更精细的熵估计。考虑到计算复杂度,chen等人将空间域上的2d卷积转换为空间-通道域上的3d卷积,以减少参数量并探索相邻通道之间的相关性以进行熵估计。受通道条件的启发,he等人将通道条件信息与空间上下文模型相结合,以加快推理速度并节省比特率。据我们所知,熵估计的沉重负担来自变换编码。ma等人认为,自动编码器中具有降维特性的像素到特征转换不可避免地会造成信息损失,因此他们在端到端优化方式中构建了类小波非线性变换及其可逆变换,以实现无损和有损图像压缩。为了对深度图像压缩有一个全面的了解,hu等人研究了现有的学习图像压缩方法,并以粗到精的策略保留了超先验变换中的信号信息。然而,所有基于卷积的非线性变换模块都局限于局部感受野,无法利用像素域或特征域的非局部相关性。

3、近年来,基于transformer的深度网络在计算机视觉领域前景广阔,因为它对图像数据具有全局表达能力。对于图像压缩任务,现已存在一些基于transformer的最新算法设计。近期,zhu等人为图像压缩任务打开了一个新的大门,他们设计了基于transformer的非线性变换模块以获得更强大的变换表达能力,并证明了基于swin-transformer的变换在参数量和解码时间方面优于基于卷积的非线性变换。同年,zou等人探索了具有卷积神经网络(convnets)和transformer网络的即插即用嵌入框架,通过参考liu等人提出的窗口注意力模型,他们还提出了一种统一的基于swin-transformer的学习图像压缩架构。为了整合卷积cnn的局部相关性和transformer的非局部信息,liu等人将特征张量平均分配给卷积cnn分支和transformer分支,并分别对局部和全局表示进行建模,同时将swin-transformer模块引入到逐通道自回归熵模型中以提高并行效率。尽管如此,transformer模块相比于卷积cnn提高了学习图像压缩的编码性能,但其耗时性仍然是一个不容忽视的问题。

4、jaszczur等人将稀疏性思想引入transformer框架,并证明了qkv计算上的稀疏性可以在很大程度上加快解码时间。从计算复杂度的角度来看,ankit等人也关注稀疏注意力,并使用top-k稀疏注意力来近似线性注意力并节省内存使用。chen等人采用top-k稀疏注意力来提高图像去雨任务的性能。与上述不同的是,一些工作正在关注注意力层的感受野。dong等人将自注意力的计算设置在一个可并行实现的十字形窗口中,以减少全局注意力的昂贵计算,并为条带宽度对计算成本和建模能力之间权衡的影响提供了解释。为了捕获更多充分的上下文信息,wu等人设计了一个桨叶形transformer来扩大自注意力在计算机视觉任务中的感受野。尽管上述方法修改了transformer结构,但两阶段swin-transformer未被应用于学习图像压缩,并且具有稀疏注意力的swin-transformer尚未被探索用于学习图像压缩。

技术实现思路

1、为克服现有技术的缺陷,本发明要解决的技术问题是提供了一种图稀疏掩膜窗口注意力的学习图像压缩方法,其能够关注图像空域像素相关性与窗口注意力机制之间的联系,更好地适用于图像压缩任务,在编码性能相当的情况下,本发明所得到的重建图像在结构相似性客观指标上表现更加出色,主观质量上得到的重建图像纹理细节重建的更好。

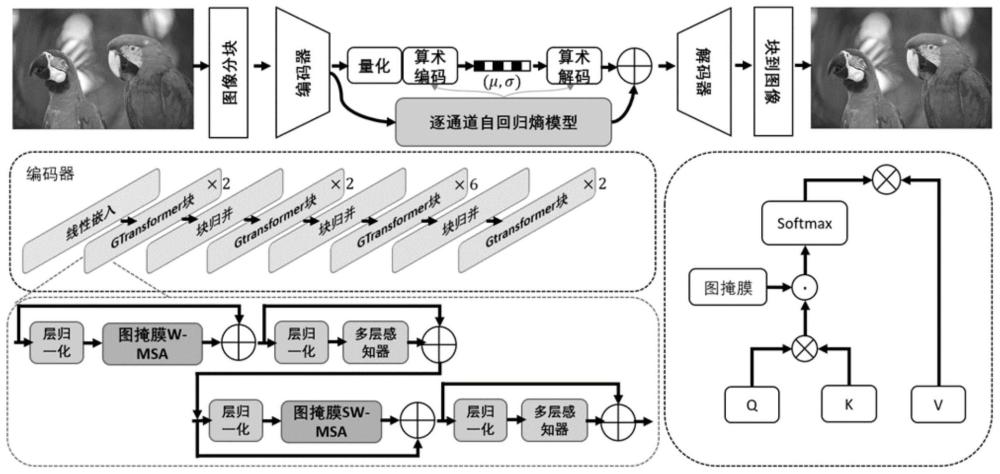

2、本发明的技术方案是:这种图稀疏掩膜窗口注意力的学习图像压缩方法,包括以下步骤:

3、(1)以自然图像为输入,经分块操作后送入编码器,获得能量紧凑的隐变量表示;

4、(2)通过量化和算术编码得到用于传输的比特流;

5、(3)在解码端,比特流依据逐通道自回归熵模型重建得到隐变量表示;

6、(4)该重建隐变量表示经解码器得到最终的重建图像。

7、本发明提出的图结构稀疏窗口注意力能更好地适用于图像压缩任务,在编码性能相当的情况下,本发明所得到的重建图像在结构相似性客观指标上表现更加出色,并且在主观质量上,本发明得到的重建图像纹理细节重建的更好,因此能够关注图像空域像素相关性与窗口注意力机制之间的联系,更好地适用于图像压缩任务,在编码性能相当的情况下,本发明所得到的重建图像在结构相似性客观指标上表现更加出色,主观质量上得到的重建图像纹理细节重建的更好。

8、还提供了一种图稀疏掩膜窗口注意力的学习图像压缩装置,该装置包括:

9、输入模块,其以自然图像为输入,经分块操作后送入编码器,获得能量紧凑的隐变量表示;

10、编码模块,其通过量化和算术编码得到用于传输的比特流;

11、解码模块,比特流依据逐通道自回归熵模型重建得到隐变量表示;

12、重建模块,重建隐变量表示经解码器得到最终的重建图像。

技术特征:1.一种图稀疏掩膜窗口注意力的学习图像压缩方法,其特征在于:该方法包括以下步骤:

2.根据权利要求1所述的图稀疏掩膜窗口注意力的学习图像压缩方法,其特征在于:所述步骤(1)中,定义图像中每一个像素与其它像素的局部连接和全局连接,并分别得到对应的局部邻接矩阵和全局邻接矩阵,矩阵元素为对应位置像素之间相似性,反映图像纹理特征,将每一个像素看作图的节点,像素之间的相似程度或邻接关系为图上的边权重,每一个像素位置构造4-连接图和8-连接图的局部连接图,对于全局连接图的构造,采用图像块的空间对称性,从水平轴对称、垂直轴对称、正对角对称和反对角对称四个角度去获取每一个像素位置的全局连接图。

3.根据权利要求2所述的图稀疏掩膜窗口注意力的学习图像压缩方法,其特征在于:所述步骤(1)中,将每一个像素都可以视为图上的节点,像素点之间的连接关系即表示像素强度之间的相似性,具体以[0,1]范围内的数值来刻画两两像素之间的连接强弱。

4.根据权利要求3所述的图稀疏掩膜窗口注意力的学习图像压缩方法,其特征在于:所述步骤(1)中,利用图拓扑结构描述像素点之间的局部和全局联系,设计邻接矩阵,考虑4连接图、8连接图为局部联系,水平-垂直-正对角-反对角为对称轴得到全局联系;4-连接图是构造当前像素位置与其上、下、左、右4个空间位置像素的连接关系,8-连接图则是构造当前像素位置与其上、下、左、右、左上、左下、右上、右下8个空间近邻像素间的连接关系;

5.根据权利要求4所述的图稀疏掩膜窗口注意力的学习图像压缩方法,其特征在于:所述步骤(1)包括以下分步骤:

6.根据权利要求5所述的图稀疏掩膜窗口注意力的学习图像压缩方法,其特征在于:将步骤(1.6)获得的邻接图矩阵作为稀疏注意力掩膜来验证其对于压缩性能的影响;将预先定义好的图邻接矩阵作为窗口注意力块的掩膜,分析引入图结构稀疏注意力的窗口相关性得到,当图像块像素个数为n时,原窗口注意力模块相关性计算复杂度为n2,稀疏图掩膜窗口注意力的相关性计算复杂度为并比较稀疏图注意力对于图像压缩模型性能的影响:

7.根据权利要求6所述的图稀疏掩膜窗口注意力的学习图像压缩方法,其特征在于:所述步骤(3)中,将基准学习图像压缩模型对称transformer作为基准模型,将局部和全局连接图构造作为图结构注意力掩膜,用在基准模型的窗口注意力计算块中。

8.根据权利要求7所述的图稀疏掩膜窗口注意力的学习图像压缩方法,其特征在于:所述步骤(3)包括以下分步骤:

9.根据权利要求8所述的图稀疏掩膜窗口注意力的学习图像压缩方法,其特征在于:所述步骤(3)中,采用小图像块来避免块内的空间冗余,使用线性归一化和gelu非线性激活来保证学习模型的网络训练,通过在窗口内进行自注意力计算,使模型更聚焦于空间近邻,并且窗口移位操作使得自注意力计算扩展到全局感受野,同时采用图结构稀疏窗口注意力进行像素相关性度量。

10.一种图稀疏掩膜窗口注意力的学习图像压缩装置,其特征在于:其包括:

技术总结一种图稀疏掩膜窗口注意力的学习图像压缩方法及装置,能够关注图像空域像素相关性与窗口注意力机制之间的联系,更好地适用于图像压缩任务,在编码性能相当的情况下,本发明所得到的重建图像在结构相似性客观指标上表现更加出色,主观质量上得到的重建图像纹理细节重建的更好。方法包括:(1)以自然图像为输入,经分块操作后送入编码器,获得能量紧凑的隐变量表示;(2)通过量化和算术编码得到用于传输的比特流;(3)在解码端,比特流依据逐通道自回归熵模型重建得到隐变量表示;(4)该重建隐变量表示经解码器得到最终的重建图像。技术研发人员:施云惠,王利龙,王瑾,尹宝才受保护的技术使用者:北京工业大学技术研发日:技术公布日:2024/7/23本文地址:https://www.jishuxx.com/zhuanli/20240801/241645.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表