视频通话中视频图像的处理方法及系统与流程

- 国知局

- 2024-08-02 14:28:05

本发明涉及视频处理,尤其涉及一种视频通话中视频图像的处理方法及系统。

背景技术:

1、在视频通话过程中,现有的视频通话是利用摄像头实时采集用户的视频画面,并将该视频画面提供给对方进行显示,但是,用户有时可能需要离开摄像头拍摄区域处理其他事情,但又不想让视频通话的对方发现,而现有的视频处理方式无法满足用户在对方不察觉的情况下离开摄像头拍摄区域的需求。

技术实现思路

1、为解决上述问题,本发明提供了一种视频通话中视频图像的处理方法及系统,其实现了在用户离开摄像头时自动切换到模拟人脸视频通话,并在用户回到摄像头范围内时恢复原始视频通话流程,提升了视频通话的用户体验和连续性。

2、本发明的目的可以通过以下技术方案实现:

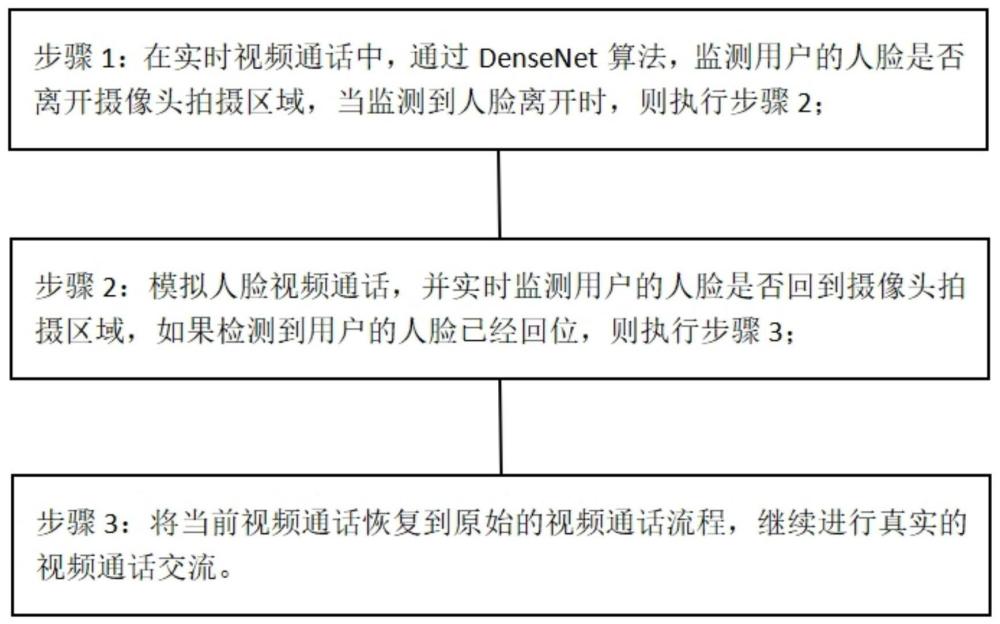

3、一种视频通话中视频图像的处理方法,包括以下步骤:

4、步骤1:人脸离开检测,包括:

5、在实时视频通话中,通过densenet算法,监测用户的人脸是否离开摄像头拍摄区域,当监测到人脸离开时,则执行步骤2;

6、步骤2:模拟人脸视频通话,包括:

7、获取用户视频:收集当前视频通话环境下的用户视频数据;

8、特征提取:从用户视频中提取语音信息特征和人脸信息特征,人脸信息特征包括面部表情特征和口型动作特征;

9、建立模型:以语音信息特征为输入,人脸信息特征为输出,建立语音匹配人脸视频算法;

10、视频生成:获取新的语音信息,提取新的语音信息特征,将新的语音信息特征输入所述语音匹配人脸视频算法,生成与新的语音相匹配的虚拟人脸视频;

11、视频融合更新:将生成的虚拟人脸视频与原始用户视频进行融合,并替换到当前视频通话中用户对应的视频画面中;

12、人脸复位检测:通过人脸关键点检测算法,实时监测用户的人脸是否回到摄像头拍摄区域,如果检测到用户的人脸已经回位,则执行步骤3;

13、步骤3:返回原始的视频通话流程,包括:

14、将当前视频通话恢复到原始的视频通话流程,继续进行真实的视频通话交流。

15、进一步,所述densenet算法的构建步骤包括:

16、数据采集:采集包含人脸离开摄像头拍摄区域的视频数据集和不同角度、光照条件下的人脸图像数据集作为训练数据;

17、数据预处理:对采集到的视频数据和人脸图像数据进行预处理,包括人脸检测、裁剪和尺寸调整操作;

18、数据划分:将经过预处理的数据划分为训练数据集和测试数据集;

19、搭建densenet模型:构建用于人脸监测的densenet模型;

20、训练模型:将训练数据集输入到densenet模型中进行训练,通过监督学习方式使模型学习人脸是否离开摄像头拍摄区域的特征;

21、模型评估:使用测试数据集评估训练好的模型性能,包括准确率、召回率和f1值指标,根据评估结果进行模型调优;

22、部署模型:将训练好的densenet模型部署到实时视频通话系统中;

23、持续优化:持续收集用户反馈数据,对模型进行更新和优化。

24、进一步,所述从用户视频中提取语音信息特征为通过预设的声纹识别与语音情感分析复合模型实现。

25、进一步,所述声纹识别与语音情感分析复合模型的构建方法包括:

26、音频收集:收集视频通话系统中用户已授权的用户视频;

27、提取音频:通过ffmpeg从用户视频文件中提取音频部分;

28、声音分割:利用vad算法对提取的音频进行声音分割,得到语音片段;

29、预处理:对每个语音片段进行预处理,包括去除噪音、降噪和音频增强;

30、特征提取:利用声纹识别算法和语音情感分析算法分别从每个语音片段中提取音频特征,包括声音的频谱特征、声纹特征、情感特征和语调特征;

31、特征表示:将提取的音频特征表示成特征矩阵;

32、模型训练:使用svm算法建立声纹识别与语音情感分析复合模型,通过训练数据集学习特征与对应标签之间的关系;

33、模型测试与评估:使用测试数据集评估已训练模型的性能表现,包括准确率、召回率、混淆矩阵和roc曲线指标;

34、应用部署:将训练好的声纹识别和语音情感分析模型部署到实时视频通话系统中。

35、进一步,从用户视频中提取人脸信息特征,包括以下步骤:

36、人脸检测与定位:通过haar级联检测器,在视频的每一帧中进行人脸检测,定位人脸所在的位置;

37、提取面部表情特征;

38、提取口型动作特征;

39、特征融合:将提取到的面部表情特征和口型动作特征进行融合,形成整体的人脸信息特征向量。

40、进一步,所述提取面部表情特征,包括:

41、特征点标定:使用dlib算法检测人脸区域;在检测到的人脸区域中,利用dlib算法标定关键点位置,关键点包括眼睛、嘴巴和眉毛;

42、表情识别模型的构建:基于循环神经网络设计表情识别模型;输入以关键点位置为特征的面部图像序列,通过循环神经网络学习人脸的不同表情特征;

43、特征提取:使用已经构建好的表情识别模型,对人脸图像进行预测,得到表情类别的概率分布;从表情类别的概率分布中提取出面部表情特征,并将面部表情特征转化为向量形式。

44、进一步,所述提取口型动作特征,包括:

45、嘴部区域提取:使用mtcnn算法定位出嘴部区域;

46、嘴部动作识别:基于gru模型构建嘴部动作识别模型,用于学习和理解口型动作,从而推断出嘴部的发音和张合程度信息;

47、特征提取:利用已训练好的嘴部动作识别模型,提取出口型动作特征,并将口型动作特征转化为向量形式。

48、进一步,所述语音匹配人脸视频算法的构建方法包括:

49、准备语音信息和对应的人脸信息数据集;

50、提取准备的数据集的语音信息特征和人脸信息特征;

51、选择cnn模型,将语音信息特征作为输入,人脸信息特征作为输出,搭建语音匹配人脸视频算法的模型架构;

52、使用准备好的数据集,对搭建的模型架构进行训练,通过反向传播算法不断调整模型参数,使得模型能够从语音信息中匹配出对应的人脸信息;

53、对训练好的模型进行评估,使用验证集或测试集来评估模型的性能表现,根据评估结果,对模型进行调参和优化;

54、将训练好的语音匹配人脸视频算法部署到实时视频通话系统。

55、进一步,所述通过人脸关键点检测算法,实时监测用户的人脸是否回到摄像头拍摄区域,包括:

56、通过摄像头实时捕获用户的人脸图像,并将捕获到的人脸图像输入至预先设置的hourglass网络中进行人脸位置检测;

57、根据hourglass网络输出的结果,基于人脸位置的坐标信息判断用户的人脸是否回到摄像头拍摄区域。

58、一种视频通话中视频图像的处理系统,所述视频通话中视频图像的处理系统用于执行如以上所述的视频通话中视频图像的处理方法。

59、本发明的有益效果为:

60、本发明实现了在用户离开摄像头时自动切换到模拟人脸视频通话,并在用户回到摄像头范围内时恢复原始视频通话流程,提升了视频通话的用户体验和连续性。具体的,通过自动切换到模拟人脸视频通话,当用户离开摄像头范围时,可以保持视频通话的连续性,避免出现空白画面或断流情况,从而提升用户体验。该方法能够在用户离开摄像头范围后自动切换到模拟人脸视频通话,在用户回到摄像头范围内时恢复原始视频通话流程,使得视频通话的切换更加自然流畅,保持通话流程的连续性,避免用户感到突兀或不适。通过densenet算法和hourglass网络分别进行人脸离开检测和人脸复位检测,实现对用户状态的实时监测,并根据监测结果进行相应的视频处理,保证视频通话处理的及时性和准确性。通过获取用户视频数据,提取语音和人脸信息特征,建立语音匹配人脸视频算法,生成虚拟人脸视频,实现在用户离开摄像头时的平滑切换和替换,增强视频通话的交互感和视觉效果。总体而言,本发明结合了人脸检测技术、特征提取技术和虚拟人脸生成技术,通过智能算法实现视频通话过程的自动化处理和优化,为用户带来更加流畅、自然的视频通话体验,提高了用户参与视频通话的舒适度和便利性。

61、本发明结合了声纹识别与语音情感分析两种算法,同时提取多种音频特征,并采用svm算法建立复合模型,通过大量的数据训练和测试,实现了对用户语音信息的准确识别和情感分析。

62、本发明结合了人脸检测、特征提取和融合等多项技术,使得从用户视频中提取人脸信息特征更加全面准确,有助于进一步深入分析和应用人脸相关的信息。

63、本发明结合了语音识别、人脸识别和深度学习等技术,整合了多种领域的知识和技术,能够有效地实现语音匹配人脸视频算法的构建和应用,为实时视频通话系统提供更加智能和便捷的服务。

本文地址:https://www.jishuxx.com/zhuanli/20240801/242932.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。