一种基于改进Transformer网络的大语言模型系统的训练方法

- 国知局

- 2024-08-08 16:51:41

本发明涉及文本处理,具体涉及文本和语音处理,大语言模型领域。

背景技术:

1、近年来,随着深度神经网络的发展,大语言模型的性能得到不断提升,如bert、gpt等模型通过在海量的数据上进行训练,已经可以胜任许多自然语言文本处理、问答、机器翻译等任务。然而大模型也面临着一些问题。

2、首先,面对弱相关的多任务学习效率过低:由于子前馈网络使用单一ffn网络,每次训练使用相同参数,致使不相关任务之间相互干扰。

3、其次,模型新增任务时训练时耗过长:每次新增任务都需要重头开始训练模型,耗费大量时间和成本,同时由于模型容量固定,随着支持任务的增加惠产生容量瓶颈问题。

4、最后,面对复杂的任务场景下,传统的数据增强方法鲁棒性能低,导致训练结果精准性低。

5、目前大语言模型方法主要有对数据增广进行改善、大语言模型进行去偏倚等方法。但对于大语言模型而言,如何更具有多场景应用可能性、长时间高容量运行、实时更新等方面,尽管目前已经有许多方法,但这些方法的性能较低或者不能兼顾多方问题。因此,如何提出一个鲁棒性强、学习效率高、允许动态规划的大语言模型方法,正是亟待解决的问题。

技术实现思路

1、本发明所要解决的技术问题是提供一种基于改进transformer网络的大语言模型系统的训练方法,采用flipda技术、二阶段apr技术、一对多ffn模块、以及adapter微调模块,在满足提高学习效率的同时提高数据鲁棒性。

2、为了解决上述技术问题,本发明采用以下技术方案:

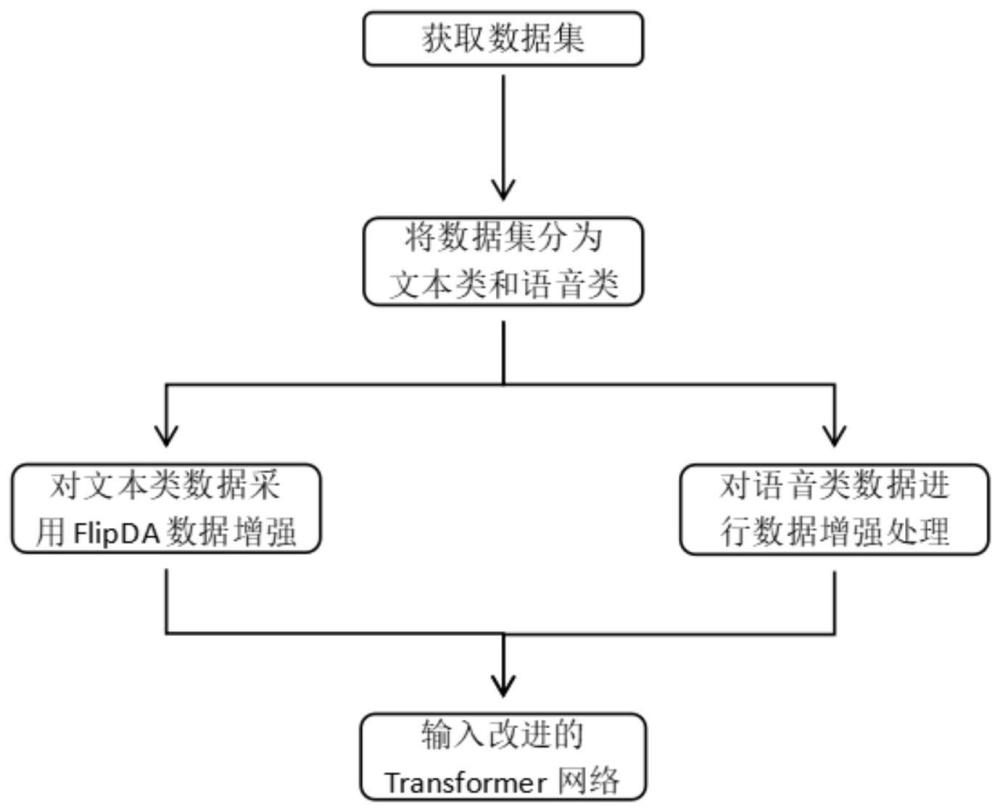

3、一种基于改进transformer网络的大语言模型系统的训练方法,该方法包括以下步骤:

4、s1获取训练大语言模型的数据集;

5、s2将数据集分为文本类和语音类,对文本类数据采用flipda数据增强;

6、s3对语音类数据进行数据增强处理;

7、s4构建改进型transformer网络,在网络中加入adaptertuning微调模块、以及应用动态扩展的一对多ffn代替原模型中一对一ffn模块;

8、s5将数据输入网络进行训练。

9、在s2步骤中,包括如下步骤:

10、s2.1将数据集根据文件扩展名进行分类,分别保存;

11、s2.2使用bert训练一个标签分类器;

12、s2.3将文本类数据输入t5模型生成既有保持原始标签的数据样本,也有标签翻转的数据样本;

13、s2.4将生成的样本输入到分类器中,分类器依据每个标签给出的最大概率来选择生成样本,确保选出的样本对于模型预测目标标签具有较高的置信度。

14、s2.5将原始训练样本与筛选出的增强样本结合起来,再次对分类器进行训练;

15、s2.6最后将得到的文本数据集保存。

16、在s2.2步骤中,包括如下步骤:

17、s2.2.1对文本进行预处理与分词,去除停用词、标点符号,进行词干提取或词形还原,将标签转换为数值编码;

18、s2.2.2选用bert-base模型,在bert模型顶部添加一个分类层,该层输出节点数量与标签类别数量相同。

19、在s3步骤中,包括如下步骤:

20、s3.1对语音识别的转录文本进行初步处理,通过seq2seq模型直接从语音识别的转录文本生成更易读的文本;

21、s3.2使用transformer模型抽取上下文特征,并利用两阶段训练方法合成数据增强方法扩大训练集规模;

22、在s3.2步骤中,包括如下步骤:

23、s3.2.1基于roberta模型,通过定制化的注意力掩码和应用自回归预测机制将其改造成seq2seq的生成模型。

24、s3.2.2利用tts系统将样本中含语法错误的源句转化为语音再输入asr系统获得语音识别转录文本,最后与目标句匹配作为增强后的数据集daug;

25、s3.2.3第一阶段在增强数据基础上使用seq2seq学习方法训练模型,第二阶段使用原始数据通过seq2seq学习方法对第一阶段预训练的模型进行精调

26、在s4步骤中,包括如下步骤:

27、s4.1将adapter串连地添加到transformer模型的多头注意力层之后、前馈层之后;

28、s4.2对于原网络中单个子前馈网络改为多个结构相同的子前馈网络ffn;

29、在s4.2步骤中,包括如下步骤:

30、为实现模型的动态扩展,将transformer注意力桥(由堆叠的多头注意力子层和前馈网络子层构成)中的前馈网络子层替换成逐位置的moe子层。moe子层由一组n个“专家网络”e1…en(即ffn1...ffnn)和一个输出为n维向量的“门控网络”g组成。每个ffn对应于一种技能,对于处理某个任务时仅激活对应的某个特定技能k的ffnk,对所有激活的特征表示进行平均池化操作如下:

31、

32、与现有技术相比,本发明具有如下的有益效果:

33、1、模型容量大:由于采用了动态增加的ffn模块网络,本方法在后续新任务训练时能够通过添加相关ffn网络的形式存储训练结果,大大提升了大模型的存储性能。

34、2、处理速度快:由于采用了一对多的ffn模块网络,本方法在训练多任务学习时具有高效率、更快的处理速度,这对于实时或近实时应用场景尤为重要。

35、3、鲁棒性强:大语言模常常受到多种因素影响,如语言种类的多样性、语言领域多样性等。本方法在面对这些干扰时,表现出较强的鲁棒性,对少量数据增广,得到良好的训练结果。

技术特征:1.一种基于改进transformer网络的大语言模型系统的训练方法,其特征在于,该方法包括以下步骤:

2.根据权利要求1所述的一种基于改进transformer网络的大语言模型系统的训练方法,其特征在于,上述s2中的包括如下步骤:

3.根据权利要求1所述的一种基于改进transformer网络的大语言模型系统的训练方法,其特征在于,上述s2.2中的包括如下步骤:

4.根据权利要求1所述的一种基于改进transformer网络的大语言模型系统的训练方法,其特征在于,上述s3中的包括如下步骤:

5.根据权利要求1所述的一种基于改进transformer网络的大语言模型系统的训练方法,其特征在于,上述s3.2中的包括如下步骤:

6.根据权利要求1所述的一种基于改进transformer网络的大语言模型系统的训练方法,其特征在于,上述s4中的包括如下步骤:

7.根据权利要求1所述的一种基于改进transformer网络的大语言模型系统的训练方法,其特征在于,上述s4.2中的包括如下步骤:

技术总结本发明涉及一种基于改进Transformer网络的大语言模型系统的训练方法,属于文本和语音处理,大语言模型领域,具体过程如下:获取数据集;将数据集分为文本类和语音类;对文本类数据采用FlipDA数据增强;对语音类数据进行两阶段数据增强处理;然后构建改进型Transformer网络,在网络中加入AdapterTuning微调模块、以及应用动态扩展的一对多FFN代替原模型中一对一FFN模块;最后将数据输入网络进行训练。本发明引入FlipDA数据增强算法,使得大语言模型准确率在绝大多场景下都能够稳定提升,同时引入动态扩展的一对多FFN模块,降低了新任务学习的时间以及解决了多任务学习中不相干任务相互干扰的问题。技术研发人员:李欣意,涂铮铮,周欣蕴受保护的技术使用者:安徽大学技术研发日:技术公布日:2024/8/5本文地址:https://www.jishuxx.com/zhuanli/20240808/270825.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表