一种基于簇中心负采样的多模态数据融合方法

- 国知局

- 2024-08-22 14:48:01

本发明可应用于计算机视觉领域、自然语言处理领域、多模态学习等领域,具体地提出了一种基于簇中心负采样的多模态数据融合方法,该方法可结合互信息最大化理论,将负样本簇中心作为额外的负样本,在不增加batchsize的情况下,显著提高模型性能。

背景技术:

1、在多模态模型中存在多个目标优化,对于多模态融合表征,大多采用对比学习中的infonce作为损失函数。对比学习目标是将正样本与正样本之间距离在语义空间中越来越近,正样本与负样本之间距离在语义空间中越来越远。在多模态模型中,对比学习的应用非常广泛。例如,在多模态文本分类中,对比学习可以用于将文本分类为不同的主题。在多模态语音识别中,对比学习可以用于识别不同的语音特征。在多模态图像识别中,对比学习可以用于识别不同的图像特征。

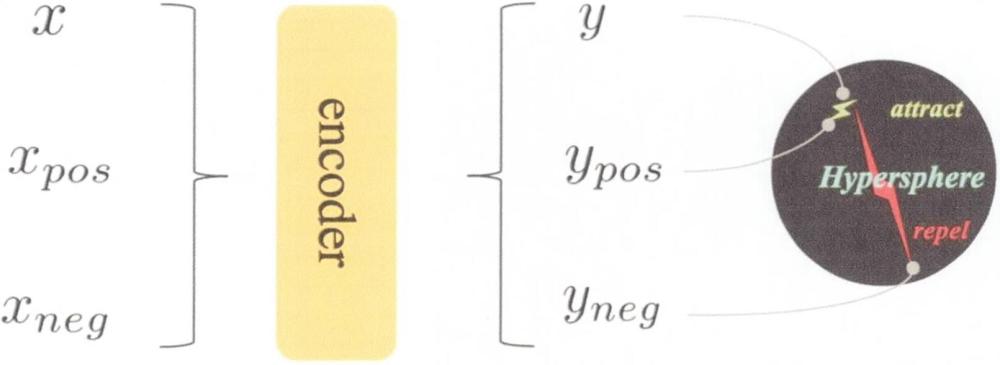

2、对比学习的优点包括:首先,对比学习不需要标记数据,可节省大量的标记数据的时间和成本。其次,对比学习可以在不同的模态之间进行比较和对比,可提高模型的泛化能力。最后,对比学习可并行化处理,可提高模型的效率。如图1所示,其神经网络架构较为基础,称为simclr,但其下游任务中的结果却较为出色,也是目前采用的比较流行的对比学习神经网络架构之一。

3、目前infonce成为多模态模型损失函数选择的主流,infonce是基于互信息和nce思想而提出。互信息定义如下,对于随机变量x,随机变量y,设二者随机变量的联合分布为p(x,y),边缘分布分别为p(x),p(y),互信息是联合分布与边缘分布的相对熵。

4、

5、对式子进行推导,根据贝叶斯公式展开联合分布:

6、

7、进行约分,进一步得到:

8、

9、对log函数进行展开:

10、

11、∑y∈yp(x,y)可表示为联合分布求边缘分布,可得p(x),则进一步推导得到:

12、

13、若用x神经网络softmax层输出结果,则h(x)则表示该结果对应的熵。h(x|y)则表示引入某种机制所带来的额外信息后模型结果的熵,如果互信息越大,则模型结果的熵越小,则系统越稳定。因此最大化互信息是infonce的核心想法。

14、针对互信息由于p(x,y)往往无法直接求救,p(x)是固定的,故最大化互信息则需最大化p(x|y)。infonce采用nce的思想通过构建正负样本来表示p(x|y)。p(x|y)可表示为:

15、

16、对于任何一个神经网络模型,采用交叉熵作为其损失函数。

17、l=-∑p(x)logp(x|y)

18、由于p(x)是固定值,则将上述式子优化得:

19、

20、若infonce越小,则p(x|y)越大,互信息越大,模型输出结果的熵越小,模型性能越优。但存在以下几个问题:第一需要使用大量的负样本数据。为了实现很好的表征效果,越多的负样本数据,越大的批次尺寸,对模型训练效果越好。第二需要大量的训练周期。故拟采用构建伪负样本的方式,在批次尺寸受限的情况下,提高训练效果,降低训练周期。

技术实现思路

1、本发明核心是提出了一种基于infonce的新型损失函数,下文将从互信息最大化理论角度,阐述本损失函数的优势所在。本发明命名cn-infonce。

2、从上述角度来看,增加批量大小的目的是为了提高模型收敛的难度。当批量大小受到限制时,由于计算资源的限制,这种方法无法有效运行。因此,有必要开发一种新的方法来减轻批量大小的敏感性。出于这一动机,我们探索了下文描述的基于聚类的负采样。

3、对比学习的核心是引入各种负样本来捕捉正样本和负样本之间的差异。负样本的聚类中心也包含重要的语义信息,值得将正样本与其进行比较。我们可以通过以下方式得到聚类中心xc:

4、

5、这意味着在一个批次中,所有与y形成负样本对的x的平均值。然后我们可以得到cn-infonce:

6、

7、接下来将从互信息最大化角度阐述cn-infonce的优势:

8、互信息最大化旨在捕获数据之间的共享属性,由于获取数据的联合分布p(x,y)难以计算,所以我们往往对其进行转换,求解

9、

10、假设函数和成正相关关系,则有:

11、

12、上述论证了cn-infonce较infonce可取得更高的互信息下界,从而让模型学习更好的表征,提高模型在下游的泛化能力。

13、与现有技术,本发明的优势所在如下:

14、1)本发明在不增加batch size的情况下,增加模型的负样本数量,提高模型的表征能力。

15、2)本发明基于互信息最大化理论进行推导,可获得更高的互信息下界,具备理论保证。

16、3)本发明应用领域包括但不限于计算机视觉、自然语言处理、语音识别、多模态学习领域,应用前景广泛。

技术特征:1.一种基于簇中心负样本的多模态数据融合方法,其核心特征包含如下:

2.根据权利1所示正负样本对获取方法,其特征如下:在数据处理阶段,根据数据的不同类型和应用领域不同,数据处理方式也不同。在计算机视觉领域,可对一个图片进行旋转、剪切、高斯模糊、加噪、调亮度等方式进行数据增广,同一个图片进行不同的数据增广获得两种图片称为正样本,在同一批次中其余图片称为负样本。在自然语言处理领域中,一个字与其相配对的上下文构成正样本,字典中其余与上下文无关的字构成负样本。在多模态领域中,一张图片与其对应描述的文本构成正样本,不配对的图片-文本对构成负样本。同时本发明引入负样本簇中心的概念,将负样本簇中心作为额外的负样本参与模型训练中。

3.根据权利1所示,在模型训练阶段,将cn-infonce作为模型的损失函数,其特征如下:首先在同一个批次中,获取每一个批次负样本的簇中心,接着,将其乘以一个可学习的参数w,最后将其作为损失函数新的一项参与模型训练。

技术总结将对比学习应用于表示学习中,成为无监督学习中一项有前景的基础任务之一。对比学习中的一个难以避免的问题是,需要大批次尺寸和长时间的训练周期来训练模型。然而,由于计算资源的限制,无法获取大批量尺寸提升模型性能。为了缓解这个问题,我们提出了一种名为基于簇聚类负采样的多模态数据融合方法,并给出了一种新的损失函数CN‑InfoNCE。负样本的聚类中心充满了语义信息,可以作为补充的负样本与正样本进行比较。在不增加批量大小的情况下,可以提高模型性能。且该发明可应用于计算机视觉领域、自然语言处理、多模态学习等领域。技术研发人员:刘春颜,杨星宇,赵蕴龙受保护的技术使用者:南京航空航天大学技术研发日:技术公布日:2024/8/20本文地址:https://www.jishuxx.com/zhuanli/20240822/279928.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表