一种大语言模型的压缩方法、系统、设备及存储介质与流程

- 国知局

- 2024-09-11 14:22:02

本发明属于大语言模型,具体涉及一种大语言模型的压缩方法、系统、设备及存储介质。

背景技术:

1、大语言模型(large language models)是基于变换器(transformer)构建的大型生成式神经网络模型,其通过预测下一个词元(token)来进行语言生成,是当前影响力广泛的chatgpt、claude等对话机器人的核心技术,可以应用于自然语言处理、计算机视觉等领域;现代大语言模型达到较快推理速度的一个核心技术点为键值缓存(kv cache),其通过将历史语境的键值向量进行缓存来减少冗余的计算,从而加快推理速度;但在长文本情境下,键值缓存将占据巨大的内存空间,从而成为模型访存的瓶颈。

2、为了压缩键值缓存的大小,已有一些研究工作采用低比特量化、词元裁剪等技巧对键值缓存进行压缩,现有方法中,低比特量化方法通过对键值缓存进行细粒度的量化分组设计,能够在模型无明显能力损失的前提下将键值缓存的数值精度压缩到2bits;词元裁剪方法通过设计某些指标来有选择地丢弃一些历史词元的键值缓存向量,在一定条件下能够将键值缓存的大小压缩50%左右。

3、现有技术中,低比特量化和词元裁剪的缺点主要如下:

4、(1):低比特量化能达到的压缩极限较低,在要求高压缩率(如10x及以上)的场景下很难满足要求,例如,2bits量化相比于16bit的全精度键值缓存也仅能达到8倍的压缩率,无法满足更高要求。

5、(2)词元剪裁方法普遍引入了较多先验知识,且需要较为复杂的人工设计,在复杂多变的实际应用场景中并不使用,同时,词元剪裁方法不可避免地永久丢失了部分历史词元的信息,给模型性能带来了潜在的风险。

6、因此,本申请预期一种大语言模型的压缩方法。

技术实现思路

1、针对现有技术中存在的问题,本发明提供一种大语言模型的压缩方法、系统、设备及存储介质,用以解决相关现有技术中自注意力模块在压缩、放大和存储的过程效率较低和精度较差的技术问题。

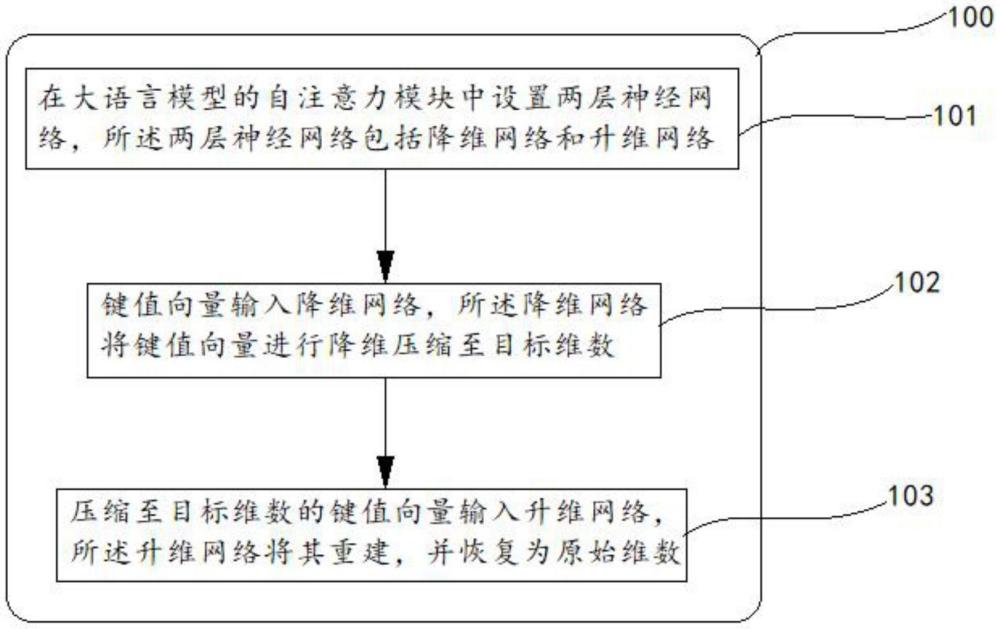

2、在第一方面,本发明实施例提供了一种大语言模型的压缩方法包括以下步骤:

3、在大语言模型的自注意力模块中设置两层神经网络,所述两层神经网络包括降维网络和升维网络;

4、键值向量输入降维网络,所述降维网络将键值向量进行降维压缩至目标维数;

5、压缩至目标维数的键值向量输入升维网络,所述升维网络将其重建,并恢复为原始维数。

6、进一步的,所述大语言模型的自注意力模块包括浅层自注意力模块和深层自注意力模块,所述深层自注意力模块设置有两层神经网络。

7、进一步的,所述自注意力模块将压缩至目标维数的键值向量存储于键值向量缓存中。

8、进一步的,所述键值向量包括键向量和值向量;

9、所述键向量用于与其他元素的键向量比较其相似度或关联性;

10、所述值向量包括与特定输入元素相关的信息。

11、进一步的,在训练阶段中的每次前向传播时,将每次生成的键值向量均通过降维网络和升维网络,用于模拟该网络对模型的精度误差;

12、基于所述精度误差在反向传播时更新降维网络和升维网络的参数。

13、进一步的,在推理阶段,每次推理时将新生成的键值向量通过降维网络进行通道压缩后保存到键值向量缓存中;

14、在其后的自注意力计算前将键值向量缓存中的键值向量通过升维网络进行重建。

15、进一步的,所述降维网络将键值向量进行降维压缩至目标维数的过程采用svd奇异值分解方法。

16、在本发明实施例中,在第二方面,本发明实施例提供了一种大语言模型存储的系统,包括:

17、初始化单元,被配置为:

18、用于在大语言模型的自注意力模块中设置两层神经网络,所述两层神经网络包括降维网络和升维网络;

19、第一处理单元,被配置为:

20、用于将键值向量输入降维网络,所述降维网络将键值向量进行降维压缩至目标维数;

21、第二处理单元,被配置为:

22、用于将压缩至目标维数的键值向量输入升维网络,所述升维网络将其重建,并恢复为原始维数。

23、第三方面,本公开实施例提供了一种电子设备,该电子设备包括:

24、至少一个处理器;以及,

25、与该至少一个处理器通信连接的存储器;其中,

26、该存储器存储有可被该至少一个处理器执行的指令,该指令被该至少一个处理器执行,以使该至少一个处理器能够执行上述的大语言模型的压缩方法。

27、第四方面,本公开实施例提供了一种非暂态计算机可读存储介质,该非暂态计算机可读存储介质存储计算机指令,该计算机指令用于使该计算机执行上述的大语言模型的压缩方法。

28、本发明实施例的其他可选特征和技术效果一部分在下文描述,一部分可通过阅读本文而明白。

29、与现有技术相比,本发明具有以下有益的技术效果:

30、本发明提供一种大语言模型的压缩方法、系统、设备及存储介质,包括以下步骤:在大语言模型的自注意力模块中设置两层神经网络,所述两层神经网络包括降维网络和升维网络;键值向量输入降维网络,所述降维网络将键值向量进行降维压缩至目标维数;压缩至目标维数的键值向量输入升维网络,所述升维网络将其重建,并恢复为原始维数;本申请基于在自注意力模块中设置的降维网络和升维网络,能够在压缩、放大和存储的过程中,不断的进行学习,进而能够提高压缩、放大和存储的过程的效率和精度。

技术特征:1.一种大语言模型的压缩方法,其特征在于,包括以下步骤:

2.根据权利要求1所述的大语言模型的压缩方法,其特征在于,所述大语言模型的自注意力模块包括浅层自注意力模块和深层自注意力模块,所述深层自注意力模块设置有两层神经网络。

3.根据权利要求1所述大语言模型的压缩方法,其特征在于,所述自注意力模块将压缩至目标维数的键值向量存储于键值向量缓存中。

4.根据权利要求1所述的大语言模型的压缩方法,其特征在于,所述键值向量包括键向量和值向量;

5.根据权利要求1所述的大语言模型的压缩方法,其特征在于,在训练阶段中的每次前向传播时,将每次生成的键值向量均通过降维网络和升维网络,用于模拟该网络对模型的精度误差;

6.根据权利要求1所述的大语言模型的压缩方法,其特征在于,在推理阶段,每次推理时将新生成的键值向量通过降维网络进行通道压缩后保存到键值向量缓存中;

7.根据权利要求1所述的大语言模型的压缩方法,其特征在于,所述降维网络将键值向量进行降维压缩至目标维数的过程采用svd奇异值分解方法。

8.一种用于大语言模型压缩的系统,其特征在于,包括:

9.一种电子设备,其特征在于,该电子设备包括:

10.一种非暂态计算机可读存储介质,其特征在于,该非暂态计算机可读存储介质存储计算机指令,该计算机指令用于使该计算机执行权利要求1至7任意一项所述的大语言模型的压缩方法。

技术总结本发明提供一种大语言模型的压缩方法、系统、设备及存储介质,包括以下步骤:在大语言模型的自注意力模块中设置两层神经网络,所述两层神经网络包括降维网络和升维网络;键值向量输入降维网络,所述降维网络将键值向量进行降维压缩至目标维数;压缩至目标维数的键值向量输入升维网络,所述升维网络将其重建,并恢复为原始维数;本申请基于在自注意力模块中设置的降维网络和升维网络,能够在压缩、放大和存储的过程中,不断的进行学习,进而能够提高压缩、放大和存储的过程的效率和精度。技术研发人员:请求不公布姓名,请求不公布姓名,请求不公布姓名,请求不公布姓名受保护的技术使用者:北京无问芯穹科技有限公司技术研发日:技术公布日:2024/9/9本文地址:https://www.jishuxx.com/zhuanli/20240911/290414.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表