图像合成的制作方法

- 国知局

- 2024-11-19 09:34:54

本发明涉及基于神经网络的图像合成,并且特别地但不排他地涉及基于神经网络的视频帧合成。

背景技术:

1、近年来,随着不断开发和引入新的利用和消费视频的服务和方式,图像和视频应用的种类和范围大大增加了。

2、例如,一种越来越流行的服务是以如下方式提供图像序列:观看者能够与系统主动且动态地交互以改变渲染的参数。在许多应用中,一个非常有吸引力的特征是能够改变观看者的有效的观看位置和观看方向,例如允许观看者在所呈现的场景中四处移动和环顾四周。

3、这样的特征能够特别允许向用户提供虚拟现实体验。这可以允许用户例如在虚拟环境中(相对)自由地移动并且动态地改变他的位置以及他正在观看的地方。通常,这样的扩展现实(xr)应用基于场景的三维模型,其中,该模型正被动态地评价以提供具体请求的视图。从例如用于计算机和控制台的游戏应用中(例如在第一人称射击者的类别中),这种方法是众所周知的。扩展现实(xr)应用包括虚拟现实(vr)、增强现实(ar)和混合现实(mr)应用。

4、已经提出的视频服务或应用的示例是沉浸式视频,其中,在例如vr头戴式设备上回放视频以提供三维体验。对于沉浸式视频,观看者具有在所呈现的场景中环顾四周和四处移动的自由,使得这可以被感知为从不同的视点观看。然而,在许多典型方法中,移动的量被限制到例如名义视点周围的相对较小的区,该名义视点通常可以对应于已经从其执行了场景的视频捕获的视点。在这样的应用中,常常提供三维场景信息,该三维场景信息允许针对相对靠近(一个或多个)参考视点的视点的高质量视图图像合成,但是如果视点与参考视点偏离太多,则该三维场景信息劣化。

5、沉浸式视频经常也可以被称为6自由度(6dof)或3dof+视频。mpeg沉浸式视频(miv)是一种新兴的标准,其中,在现有视频编解码器之上使用元数据来实现和标准化沉浸式视频。

6、沉浸式视频的问题是观看空间(观看空间是其中观看者具有足够质量的6dof体验的3d空间)是有限的。随着观看者移动到观看空间外部,因合成视图图像导致的劣化和错误变得越来越显著,并且可能导致不可接受的用户体验。由于所提供的3d视频数据没有为视图合成提供足够的信息(例如,去遮挡数据),因此在具体情况下在所生成的视图图像中可能发生错误、伪影和不准确。

7、例如,可以以可能伴随有场景的深度数据(mvd)表示的多视图的形式提供沉浸式视频数据。可以由多个在空间上有差别的相机捕获场景,并且可以一起提供所捕获的图像与深度图。然而,这样的表示没有包括足够的图像数据用于被去遮挡的区的可能性随着视点与从其捕获mvd数据的参考视点越来越不同而显著增加。因此,当观看者远离名义位置移动时,针对新视点的应当被去遮挡但在源视图中缺失的图像部分无法直接根据描述这样的图像部分的图像数据来合成。而且,不完美的深度图可能在执行视图合成时导致失真,并且在具体情况下为视图扭曲的部分,该视图扭曲是合成操作的组成部分。合成的视点距原始相机视点越远,合成视图中的失真就越严重。

8、用于从多视图图像进行视图合成的大多数现有方法需要每个源视图的深度图的可用性,并且通过组合来自多个参考视图的预测来合成新视图。然后使用深度操纵渲染来执行来自参考视图的预测。

9、最近的替代方法是将多视图图像转换为包含透明度的分层表示(例如,多平面图像(mpi)、多球图像(msi)、多对象表面图像(mosi)格式)并且对该分层表示进行编码/压缩。在解码之后,可以经由后到前层复合来合成新视图。

10、不管所使用的具体3d图像格式如何,针对不同观看姿势生成视图图像的过程是往往导致不完美图像的具有挑战性的过程。大多数图像合成算法往往引入一些伪像或误差,例如,由于不完美的去遮挡等。此外,大多数方法往往需要复杂且计算密集的处理来生成具有期望质量的针对不同观看姿势的图像。此外,为了允许视图合成算法生成可靠且高质量的图像而需要生成的3d图像数据的要求对于满足是具有挑战性的,并且往往增加数据速率并且使得这种数据的分布和通信困难且资源需求高。

11、因此,改进的方法将是有利的。特别地,允许改进的操作、提高的灵活性、改进的沉浸式用户体验、降低的复杂性、方便的实施、提高的合成图像质量、改进的渲染、增加的(可能是虚拟的)用户移动自由度、改进和/或促进的不同观看姿势的视图合成、减少的数据要求、和/或改进的性能和/或操作的方法将是有利的。

技术实现思路

1、因此,本发明试图优选地单独地或以任何组合减轻、缓解或消除上述缺点中的一个或多个缺点。

2、根据本发明的一个方面,提供了一种装置,包括:第一接收器,其被布置为接收从不同观看姿势捕获的三维场景的多幅图像;第二接收器,其被布置为接收针对所述场景的三维空间数据;视图合成神经网络,其被布置为根据所述多幅图像和所述三维空间数据来生成针对不同观看姿势的所述场景的视图移位图像;神经网络训练器,其被布置为基于针对不同观看姿势的所述场景的图像来训练所述视图合成神经网络;生成器,其被布置为生成视听数据流,所述视听数据流包括:所述多幅图像中的至少一些图像的图像数据;表示所述三维空间数据的场景数据;描述训练之后的所述视图合成神经网络的系数的系数数据。

3、本发明可以允许表征正在生成的场景的改进的数据,并且可以允许改进的图像合成。该方法可以允许针对不同观看姿势的改进的图像合成。在许多实施例中,可以生成允许基于神经网络的高效且高质量的视图移位和合成的数据。

4、在许多实施例和情形中,本发明可以提供改进的用户体验。该方法可以例如允许基于场景的有限捕获的改进的xr/ar/vr/mr应用。

5、在许多实施例中,使用神经网络进行视图合成可以提供改进的视图合成,并且可以例如允许增加的灵活性和对表示场景的数据的降低的要求。

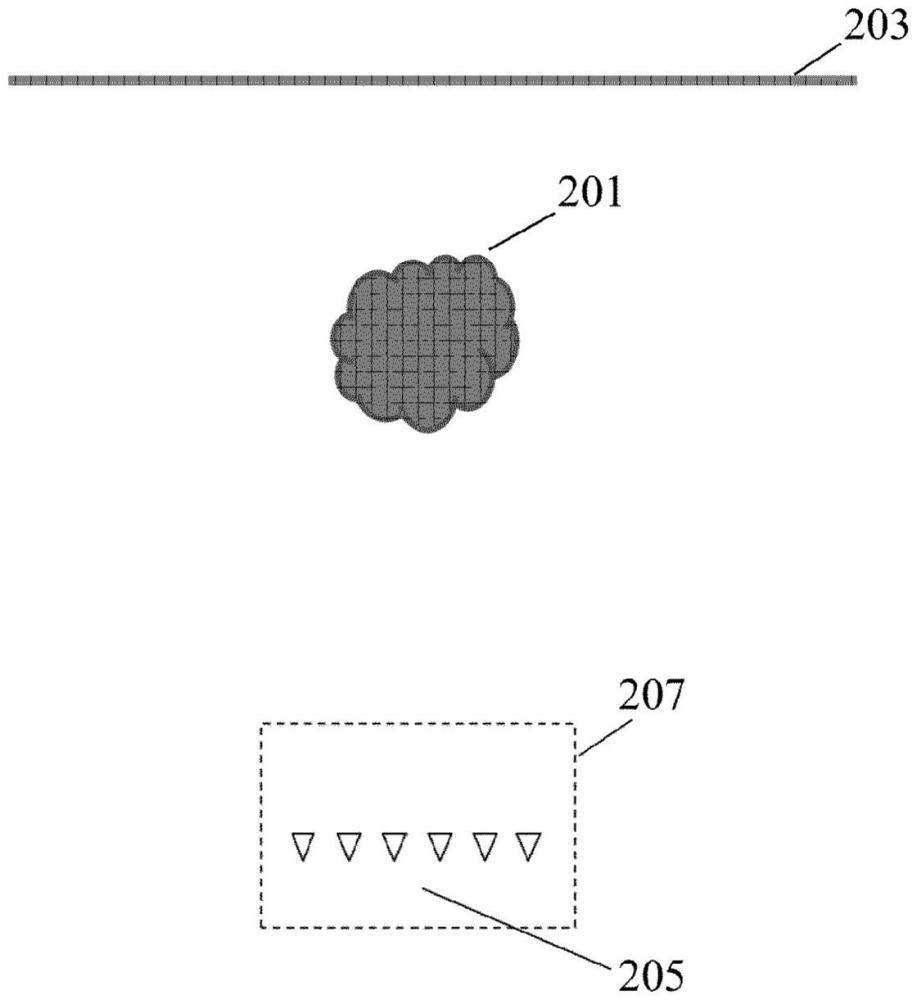

6、多幅图像可以包括一组多视图图像。多幅图像中的图像可以是二维图像。场景可以是真实生活场景,并且多幅图像可以是真实生活场景的捕获图像。图像可以是由图像或视频相机捕获的图像。三维空间数据可以表示场景的空间性质,并且可以例如包括3d点云、(静态)背景或(动态)前景对象的网格或深度图或由3d点云、(静态)背景或(动态)前景对象的网格或深度图组成。三维空间数据可以独立于多幅图像的任何观看姿势或多幅图像/与多幅图像的任何观看姿势或多幅图像无关。三维空间数据可以是观看姿势无关的。三维空间数据可以是描述场景的几何/空间性质的观看姿势无关数据。三维空间数据可以不被束缚于视图,或在多幅图像和/或多幅图像的观看姿势中表示,或与多幅图像和/或多幅图像的观看姿势相关联。三维空间数据可以包括几何图元或由几何图元组成,诸如3d点、平面、表面、线、网格等。

7、服务器神经网络可以具体地是卷积网络。服务器神经网络可以包括一个或多个卷积层。系数可以包括用于一个或多个卷积层的滤波器/内核的系数。服务器神经网络的一个、多个或所有卷积层可以是隐藏层或处理层。

8、在一些实施例中,服务器神经网络可以包括一个或多个全连接层。系数可以包括用于一个或多个全连接层的连接的权重。

9、姿势可以是/表示/指示位置、取向或位置和取向。

10、用于训练视图合成神经网络的针对不同观看姿势的场景的图像可以包括由第一接收器接收的多幅图像中的一幅或多幅。

11、视图移位图像可以是针对与多幅图像的观看姿势不同的观看姿势合成的图像。

12、根据本发明的可选特征,所述第一接收器被布置为接收一组输入视频序列,所述一组输入视频序列表示来自所述不同观看姿势的所述三维场景的视图,并且所述多幅图像是所述一组输入视频序列的帧;并且其中,所述神经网络训练器被布置为动态地训练所述视图合成神经网络,以使得所述视图合成神经网络的系数随时间而变化;并且所述生成器被布置为生成所述视听数据流,以包括来自所述一组输入视频序列的帧和描述训练之后的所述视图合成神经网络的时变系数的时变系数数据。

13、本发明可以允许动态地表征正在生成的场景的改进的数据,并且可以允许改进的视频合成。

14、根据本发明的可选特征,述神经网络训练器被布置为使用一组训练图像来训练所述视图合成神经网络,所述一组训练图像包括针对未由所述多幅图像中的所述至少一些图像中的图像所表示的观看姿势的第一组参考图像。

15、在许多情形中,这可以提供改进的训练并且因此改进的图像合成。它可以增强训练以反映更大区域上(诸如具体地整个期望观看区域上)的性质。

16、根据本发明的可选特征,提供了所述第一组参考图像包括从以下各项的组中选择的至少一幅图像:使用所述多幅图像通过非神经网络视图移位生成的参考图像;根据所述场景的视觉场景模型生成的参考图像。

17、这可以在更大的区域上提供改进的训练和图像合成,并且可以补偿/减轻可用的有限捕获数据。该方法可以降低捕获要求。

18、根据本发明的可选特征,所述一组训练图像包括第二组参考图像,所述第二组参考图像包括所述多幅图像中的图像,并且所述神经网络训练器被布置为将不同的权重应用于所述第一组参考图像和所述第二组参考图像。

19、在许多情形中,这可以提供改进的操作和训练。例如,可以通过将用于贡献的不同权重应用于用于训练服务器神经网络的成本函数来实施不同的权重。

20、根据本发明的可选特征,所述神经网络训练器被布置为在所述多幅图像中的至少一些图像被提供给所述视图合成神经网络之前对所述多幅图像中的至少一些图像进行编码和解码。

21、在许多实施例中,这可以改进性能,并且可以例如导致神经网络视图合成也补偿/减轻由视听数据流的通信/分布引起的影响和劣化。

22、根据本发明的可选特征,所述神经网络训练器被布置为在所述三维空间数据被提供给所述视图合成神经网络之前对所述三维空间数据进行编码和解码。

23、在许多实施例中,这可以改进性能,并且可以例如导致神经网络视图合成也补偿/减轻由视听数据流的通信/分布引起的影响和劣化。

24、根据本发明的可选特征,所述神经网络训练器被布置为利用一组默认系数来初始化所述视图合成神经网络,并且训练所述视图合成神经网络以确定用于所述视图合成神经网络的经修改的系数;并且其中,所述生成器被布置为将至少一些经修改的系数包括在所述视听数据流中。

25、在许多实施例和情形中,这可以允许改进的操作,并且在许多实施例中,可以特别地允许降低的数据速率和/或更快的初始化。

26、在一些实施例中,所述神经网络训练器可以被布置为响应于所述多幅图像而从多组默认系数中选择所述一组默认系数。

27、根据本发明的可选特征,所述生成器被布置为响应于所述经修改的系数与所述默认系数之间的差异而选择系数的子集以进行发送。

28、在许多实施例和情形中,这可以允许改进的操作。

29、在一些实施例中,所述生成器被布置为包括仅用于所述多幅图像的子集的图像数据,并且还包括针对与所述多幅图像的所述子集的观看姿势不同的观看姿势的图像的视图合成神经网络的至少一个特征图。

30、在一些实施例中,所述生成器被布置为包括针对与所述多幅图像的所述观看姿势不同的观看姿势的图像的视图合成神经网络的至少一个特征图。

31、在一些实施例中,所述生成器被布置为生成视听数据流,使得所述图像数据、所述场景数据和所述系数数据中的至少两者共享图片群组gop结构。

32、在一些实施例中,所述第一接收器被布置为接收输入视频序列,所述输入视频序列包括表示针对多个时刻中的每个时刻来自所述不同观看姿势的所述三维场景的视图的多个帧,并且所述多幅图像包括针对一个时刻的一组帧;并且其中,所述神经网络训练器被布置为动态地训练所述视图合成神经网络以导致所述视图合成神经网络的系数随时间变化;并且所述生成器被布置为生成输出视频序列,所述输出视频序列包括所述输入视频序列的至少一些帧的图像数据和所述输出视频序列的不同时刻的系数数据。

33、根据本发明的一个方面,提供了一种装置,包括:接收器,其被布置为接收视听数据流,所述视听数据流包括:表示从不同观看姿势捕获的三维场景的多幅图像的图像数据,所述场景的三维空间数据,以及描述视图合成神经网络的系数的系数数据;所述视图合成神经网络,其被布置为根据所述多幅图像和所述三维空间数据来生成针对不同观看姿势的所述场景的视图移位图像;以及神经网络控制器,其用于响应于所述系数数据而设置所述神经网络的系数。

34、本发明可以允许改进的图像合成。该方法可以允许针对不同观看姿势的改进的图像合成。

35、在许多实施例和情形中,本发明可以提供改进的用户体验。该方法可以例如允许基于场景的有限捕获的改进的xr/ar/vr/mr应用。

36、多幅图像可以包括一组多视图图像。多幅图像中的图像可以是二维图像。场景可以是真实生活场景,并且多幅图像可以是真实生活场景的捕获图像。图像可以是由图像或视频相机捕获的图像。三维空间数据可以表示场景的空间性质,并且可以例如包括或在于3d点云、(静态)背景或(动态)前景对象的网格或深度图。

37、客户端神经网络可以具体地是卷积网络。客户端神经网络可以包括一个或多个卷积层。系数可以包括用于一个或多个卷积层的滤波器/内核的系数。客户端神经网络的一个、多个或所有卷积层可以是隐藏层或处理层。

38、在一些实施例中,客户端神经网络可以包括一个或多个全连接层。系数可以包括用于一个或多个全连接层的连接的权重。

39、视图移位图像可以是针对与多幅图像的观看姿势不同的观看姿势合成的图像。

40、根据本发明的可选特征,所述视听数据流包括一组视频序列,所述一组视频序列包括表示来自所述不同观看姿势的所述三维场景的视图的多个帧,并且所述多幅图像是所述多个帧中的帧;并且,所述系数数据包括描述所述视图合成神经网络的时变系数的时变系数数据;并且,所述神经网络控制器被布置为响应于所述时变系数数据而改变所述视图合成神经网络的所述系数。

41、在许多实施例中,这可以允许改进的图像合成。

42、根据本发明的可选特征,所述神经网络控制器被布置为:确定针对至少一个时刻的内插系数值,针对所述至少一个时刻,系数数据不被包括在所述视听数据流中,所述内插系数值是根据所述时变系数数据的系数值确定的;并且将所述视图合成神经网络的所述系数设置为针对所述至少一个时刻的所述内插系数值。

43、在许多实施例中,这可以允许改进的图像合成。

44、根据本发明的可选特征,,所述视听数据流包括针对与所述多幅图像的观看姿势不同的观看姿势的图像的至少一个神经网络特征图,并且所述神经网络控制器被布置为利用所述至少一个特征图来配置所述视图合成神经网络。

45、在许多实施例中,这可以允许改进的图像合成。在许多情形中,它可以允许视听数据流的降低的数据速率。

46、在许多实施例中,这可以允许改进的图像合成。

47、根据本发明的可选特征,所述神经网络控制器被布置为利用一组默认系数来初始化所述视图合成神经网络,并且由来自所述视听数据流的系数来覆写所述默认系数。

48、在许多实施例中,这可以允许改进的图像合成。

49、根据本发明的可选特征,所述神经网络控制器被布置为响应于所述多幅图像而从多组默认系数中选择所述一组默认系数。

50、在许多实施例中,这可以允许改进的图像合成。

51、在一些实施例中,所述神经网络控制器被布置为利用默认系数初始化所述神经网络,并且通过从所述系数数据确定的系数来覆写默认系数。

52、根据本发明的可选特征,所述图像数据、所述场景数据以及所述系数数据中的至少两者共享所述视听数据流中的图片群组gop结构。

53、在许多情形中,这可以允许改进的操作。它可以便于视听数据流的编码和/或解码。

54、根据本发明的可选特征,所述视图合成神经网络包括多个可调谐层和多个不可调谐层,并且所述视听数据流包括仅用于可调谐层的系数数据。

55、在许多实施例中,这可以允许改进的图像合成。在许多情形中,它可以允许视听数据流的降低的数据速率。

56、在一些实施例中,所述视图合成神经网络包括具有固定系数的多个固定层和具有可变系数的多个可变层;并且所述神经网络训练器被布置为仅训练多个可调谐层;并且所述生成器被布置为生成所述视听数据流以仅包括用于所述可变系数的系数数据。

57、根据本发明的可选特征,所述三维空间数据包括所述场景的视频点云数据。

58、在许多实施例中,这可以允许改进的图像合成。

59、根据本发明的一个方面,提供了一种视听数据流,包括:表示从不同观看姿势捕获的三维场景的多幅图像的图像数据,所述场景的三维空间数据,以及描述视图合成神经网络的系数的系数数据,所述视图合成神经网络用于根据所述多幅图像和所述三维空间数据来生成针对不同观看姿势的所述场景的视图移位图像。

60、根据本发明的一个方面,提供了一种用于生成视听数据流的方法,所述方法包括:接收从不同观看姿势捕获的三维场景的多幅图像;接收所述场景的三维空间数据;视图合成神经网络根据所述多幅图像和所述三维空间数据来生成针对不同观看姿势的所述场景的视图移位图像;基于针对不同观看姿势的所述场景的图像来训练所述视图合成神经网络;并且生成视听数据流,所述视听数据流包括:所述多幅图像中的至少一些图像的图像数据,表示所述三维空间数据的场景数据,以及描述训练之后的所述视图合成神经网络的系数的系数数据。

61、根据本发明的一个方面,提供了一种方法,包括:接收视听数据流,所述视听数据流包括:表示从不同观看姿势捕获的三维场景的多幅图像的图像数据,所述场景的三维空间数据,以及描述视图合成神经网络的系数的系数数据;视图合成神经网络根据所述多幅图像和所述三维空间数据来生成针对不同观看姿势的所述场景的视图移位图像;并且响应于所述系数数据而设置所述视图合成神经网络的系数。

62、参考下文描述的(一个或多个)实施例,本发明的这些和其他方面、特征和优点将是明显的并且得到阐明。

本文地址:https://www.jishuxx.com/zhuanli/20241118/329378.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表