一种聊天会话生成方法、装置、设备及存储介质与流程

- 国知局

- 2024-11-21 12:10:28

本发明涉及深度学习,特别是涉及一种聊天会话生成方法、装置、设备及存储介质。

背景技术:

1、目前随着自然语言处理工具的发展,聊天模式的生成式模型应用越来越广,在国内呈井喷式爆发,这些预训练模型(pre-training model,ptm)可以利用搜集到的大量视觉和文本数据,以对比学习的模式进行训练得到目标模型。但现有技术中,针对不同的预训练模型,微调训练完成后,需要人工拷贝预训练模型,再进行云端部署,导致微调后的预训练模型可复用性很差,而且云端部署的数据安全性比较差。而且在预训练模型的训练过程中,需要准备大量的训练样本进行反复迭代训练,以提高模型的准确性,这就导致随着模型规模越来越大,数据越来越多,迁移的过程会消耗庞大的计算资源和时间成本,并且迁移的过程还会发送灾难性遗忘的现象。

2、为了在减少计算资源要求的同时保留预训练模型,目前可以在用于聊天生成的预训练模型的调试开始前,将模型文件数据拷贝到公共目录中,或在训练脚本中编写下载模型文件数据的代码,从而在运行脚本时实时下载模型文件数据,下载完成后再进行深度学习模型微调。这就导致,在模型训练之前需要先进行模型部署再复制,并且在需要对模型进行更新时,需要重新将目标模型部署到复制的路径中,此时针对需要多次迭代调优的预训练模型,就需要多次复制,不仅耗时较长,也需要占用较大的存储空间,同时若选择拉取模型至模型下载请求对应的存储空间,不仅需要占用较大的存储空间,耗时也比较长,严重影响模型训练的效率。这样一来,在上述模型训练过程中都存在深度学习模型训练的易用性问题,每次进行深度学习模型训练时,都需要进行模型文件数据的实时下载或拷贝,使得深度学习模型训练的便捷性不足,导致耗时较长,严重影响模型训练的效率;而且需要占用较大的磁盘空间,增加服务器的压力;另外,训练后的模型也无法保存,下次调试需要从头开始,不满足模型精细化的迭代调优的需求。

3、可见,如何提高目前对用于聊天生成的预训练模型微调时得到的目标模型的可复用性和模型的微调效率,是本领域技术人员需要解决的问题。

技术实现思路

1、本发明实施例的目的是提供一种聊天会话生成方法、装置、设备及存储介质,可以解决目前对用于聊天生成的预训练模型微调时得到的目标模型的可复用性差和模型的微调效率低的问题。

2、为解决上述技术问题,第一方面,本发明实施例提供一种聊天会话生成方法,包括:

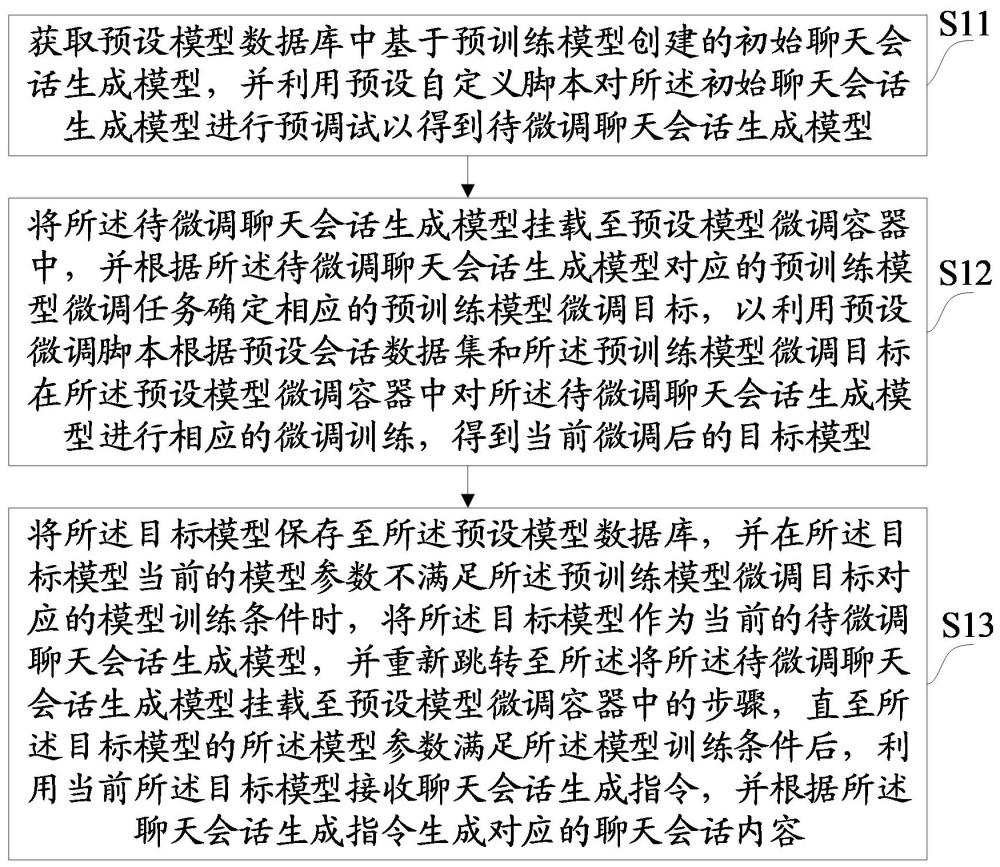

3、获取预设模型数据库中基于预训练模型创建的初始聊天会话生成模型,并利用预设自定义脚本对所述初始聊天会话生成模型进行预调试以得到待微调聊天会话生成模型;

4、将所述待微调聊天会话生成模型挂载至预设模型微调容器中,并根据所述待微调聊天会话生成模型对应的预训练模型微调任务确定相应的预训练模型微调目标,以利用预设微调脚本根据预设会话数据集和所述预训练模型微调目标在所述预设模型微调容器中对所述待微调聊天会话生成模型进行相应的微调训练,得到当前微调后的目标模型;

5、将所述目标模型保存至所述预设模型数据库,并在所述目标模型当前的模型参数不满足所述预训练模型微调目标对应的模型训练条件时,将所述目标模型作为当前的待微调聊天会话生成模型,并重新跳转至所述将所述待微调聊天会话生成模型挂载至预设模型微调容器中的步骤,直至所述目标模型的所述模型参数满足所述模型训练条件后,利用当前所述目标模型接收聊天会话生成指令,并根据所述聊天会话生成指令生成对应的聊天会话内容。

6、在一些实施例中,所述将所述待微调聊天会话生成模型挂载至预设模型微调容器中,包括:

7、在所述预设模型微调容器中挂载所述待微调聊天会话生成模型的模型目录;

8、若所述模型目录为空,则停止挂载所述模型目录并生成相应的第一告警信息;

9、若所述模型目录与所述预设模型微调容器中用于记录用户信息的用户目录或用于记录会话数据集的数据集目录重复,则停止挂载所述模型目录并生成相应的第二告警信息;

10、若所述模型目录存在表征目录已挂载的挂载标识,则确定所述模型目录对应的预调试结果,并基于所述预调试结果对所述待微调聊天会话生成模型进行增量调试,以便基于得到的增量调试结果在所述预设模型微调容器中对所述待微调聊天会话生成模型进行微调训练。

11、在一些实施例中,所述根据所述待微调聊天会话生成模型对应的预训练模型微调任务确定相应的预训练模型微调目标,包括:

12、根据所述预训练模型微调任务从预设预训练模型模板库中确定出所述待微调聊天会话生成模型对应的预训练模型模板,并根据所述预训练模型微调任务确定所述待微调聊天会话生成模型的微调任务参数和所述预设模型数据库中的所述预设会话数据集;

13、根据所述预训练模型模板和所述微调任务参数确定所述待微调聊天会话生成模型的所述预训练模型微调目标,以便根据所述预设会话数据集对所述待微调聊天会话生成模型进行微调训练。

14、在一些实施例中,所述根据所述预训练模型微调任务确定所述待微调聊天会话生成模型的微调任务参数,包括:

15、根据所述预训练模型微调任务确定所述待微调聊天会话生成模型的参数等级为预设基础等级的第一参数设置、参数等级为预设高等级的第二参数设置,并根据所述预训练模型微调任务确定所述待微调聊天会话生成模型的预训练模型微调方法,以根据所述预训练模型微调方法确定相应的超参数优化设置。

16、在一些实施例中,所述利用预设微调脚本根据预设会话数据集和所述预训练模型微调目标在所述预设模型微调容器中对所述待微调聊天会话生成模型进行相应的微调训练,得到当前微调后的目标模型之后,还包括:

17、生成所述待微调聊天会话生成模型的预训练模型训练日志和预训练模型训练结果,并将所述预训练模型训练日志和所述预训练模型训练结果保存至所述预设模型数据库中;

18、相应的,所述将所述目标模型保存至所述预设模型数据库,包括:

19、根据所述预训练模型微调任务确定所述目标模型的输出路径,并判断所述输出路径是否为空;

20、若所述输出路径是否为空,则生成相应的第三告警信息;

21、若所述输出路径不为空,则继续判断所述输出路径中是否存在用于表征路径已使用的路径标识,并在判定所述输出路径中不存在所述路径标识时,通过所述输出路径将所述目标模型保存至所述预设模型数据库中对应的存储位置;

22、若接收到所述预训练模型训练日志和所述预训练模型训练结果的文件清理指令和/或所述输出路径的删除指令,则将所述预设模型数据库中存储的所述目标模型的当前状态调整为已失效状态,并将所述输出路径的路径状态重置为未使用,以及将重置后的所述输出路径作为新的待微调聊天会话生成模型的导入路径,以便通过所述导入路径获取新的待微调聊天会话生成模型。

23、在一些实施例中,所述将所述预训练模型训练日志和所述预训练模型训练结果保存至所述预设模型数据库中之后,还包括:

24、判断所述预训练模型训练日志中是否存在异常日志;

25、若所述预训练模型训练日志中存在所述异常日志,则根据所述异常日志生成相应的第四告警信息,并基于所述异常日志调整所述预训练模型微调任务对应的微调任务参数、所述预设微调脚本和所述预设会话数据集,以及根据调整后的所述微调任务参数、所述预设微调脚本和所述预设会话数据集调整所述目标模型。

26、在一些实施例中,所述根据调整后的所述微调任务参数、所述预设微调脚本和所述预设会话数据集调整所述目标模型,包括:

27、根据调整后的所述微调任务参数、所述预设微调脚本创建调整后预训练模型微调任务,并基于所述调整后预训练模型微调任务根据调整后的所述预设会话数据集在所述预设模型微调容器中对所述目标模型进行微调训练。

28、第二方面,本发明提供了一种聊天会话生成装置,包括:

29、模型预调试模块,用于获取预设模型数据库中基于预训练模型创建的初始聊天会话生成模型,并利用预设自定义脚本对所述初始聊天会话生成模型进行预调试以得到待微调聊天会话生成模型;

30、模型微调模块,用于将所述待微调聊天会话生成模型挂载至预设模型微调容器中,并根据所述待微调聊天会话生成模型对应的预训练模型微调任务确定相应的预训练模型微调目标,以利用预设微调脚本根据预设会话数据集和所述预训练模型微调目标在所述预设模型微调容器中对所述待微调聊天会话生成模型进行相应的微调训练,得到当前微调后的目标模型;

31、模型保存模块,用于将所述目标模型保存至所述预设模型数据库,并在所述目标模型当前的模型参数不满足所述预训练模型微调目标对应的模型训练条件时,将所述目标模型作为当前的待微调聊天会话生成模型,并重新跳转至所述将所述待微调聊天会话生成模型挂载至预设模型微调容器中的步骤,直至所述目标模型的所述模型参数满足所述模型训练条件后,利用当前所述目标模型接收聊天会话生成指令,并根据所述聊天会话生成指令生成对应的聊天会话内容。

32、第三方面,本发明提供了一种电子设备,包括:

33、存储器,用于存储计算机程序;

34、处理器,用于执行所述计算机程序以实现前述聊天会话生成方法的步骤。

35、第四方面,本发明提供了一种计算机可读存储介质,所述计算机可读存储介质上存储有计算机程序,所述计算机程序被处理器执行时实现前述聊天会话生成方法的步骤。

36、本发明可以首先获取预设模型数据库中基于预训练模型创建的初始聊天会话生成模型,并利用预设自定义脚本对初始聊天会话生成模型进行预调试以得到待微调聊天会话生成模型,然后将待微调聊天会话生成模型挂载至预设模型微调容器中,并根据待微调聊天会话生成模型对应的预训练模型微调任务确定相应的预训练模型微调目标,以利用预设微调脚本根据预设会话数据集和预训练模型微调目标在预设模型微调容器中对待微调聊天会话生成模型进行相应的微调训练,得到当前微调后的目标模型,之后将目标模型保存至预设模型数据库,并在目标模型当前的模型参数不满足预训练模型微调目标对应的模型训练条件时,将目标模型作为当前的待微调聊天会话生成模型,并重新跳转至将待微调聊天会话生成模型挂载至预设模型微调容器中的步骤,直至目标模型的模型参数满足模型训练条件后,利用当前目标模型接收聊天会话生成指令,并根据聊天会话生成指令生成对应的聊天会话内容。

37、由上述技术方案可以看出,本发明的有益效果在于:在对预训练模型进行微调的过程中可以将预调试得到的待微调聊天会话生成模型挂载至预设模型微调容器中,并根据预训练模型微调任务在预设模型微调容器中进行相应的微调训练,这样一来,通过在容器中挂载所选择的预训练模型文件,调试脚本可以直接使用模型文件数据,有助于减少磁盘空间占用,节省时间成本,减少资源使用,提高效率,同时本发明可以将得到的目标模型保存至预设模型数据库,以根据当前的聊天会话生成指令生成对应的聊天会话内容,如此一来,通过将微调之后的模型保存到预设存储模块,可以在下次模型微调时快速对新数据进行学习来调优模型,节省计算资源和时间,提高模型训练的效率,并且可以有效增强聊天会话生成模型的抗遗忘能力。

本文地址:https://www.jishuxx.com/zhuanli/20241120/334693.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表