1.本发明涉及一种客观评估水下视频质量的无参考评价方法,属于视频分析技术领域。

背景技术:

2.视频图像的质量评价指标准可以分为主观评价方法和客观评价方法。主观评价由观察者对视频或图像给出主观评分,符合人眼视觉特性,但工作量大、实时性差、无法自动化实现,在水下视频图像的质量评分上并不适用。客观评价方法是利用计算机算法进行打分,可以进行实时在线测评,根据评价时是否需要参考图像又可以分为全参考、半参考(部分参考)和无参考三类评价方法。视频质量指标,尤其是实用性更强的客观评价指标,在视频技术研究中处于关键地位。有效且准确的视频质量评价指标能直接衡量视频质量,也引导着高质量视频的获取,还是验证水下视频增强与复原算法性能的重要手段。

3.水下视频在水域尤其是海洋的探索开发中,有不可替代的作用。不同于通常大气环境下的视频,水下视频由于特殊的光学环境导致的色偏、模糊、光照不均、对比度低以及成像设备在水中晃动导致的失焦等问题,存在明显的质量退化。通用的自然视频评价指标并不能准确的衡量水下视频质量。因此,需要建立针对水下视频的质量评价指标。因为水下视频通常缺少高质量参考视频,所以需要采用无参考的方法进行水下视频质量评价。

4.而目前,我们没有针对水下视频质量评价的无参考评价指标。

技术实现要素:

5.针对通用视频质量评价指标不能准确评估水下视频质量这一问题,本发明提出了一种客观评估水下视频质量的无参考评价方法。利用深度神经网络提取出视频帧的语义特征,结合水下彩色图像质量评价指标、图像模糊程度指标和自然图像质量评估指标。使用门循环单元网络融合视频帧之间的时序信息和多特征信息。

6.本发明为解决其技术问题采用如下技术方案:

7.一种客观评估水下视频质量的无参考评价方法,包括如下步骤:

8.第一步,将水下视频分解成帧,使用一组图像质量评价指标获得视频帧的退化特征,包括uciqe、边缘图像块对比度指数和niqe;

9.第二步,使用预训练的resnet50深度神经网络结合特征注意力机制提取视频帧的语义特征向量,降维后得到视频帧的语义质量分数;

10.第三步,将各指标分数进行归一化处理,与语义质量分数融合,得到每一帧最终的质量特征;

11.第四步,使用门循环单元网络捕获视频帧之间的时序信息并进行特征融合,得到最终的视频质量分数。

12.第一步中使用uciqe提取视频帧的色彩特征,该指标以色度、饱和度和对比度为测量分量,通过线性的方式将测量分量线性组合,量化了水下图像的色彩和对比度;

13.使用边缘图像块的对比度指数值和来表示水下彩色图像的模糊程度,提取出视频帧模糊程度特征;

14.使用niqe衡量水下图像的雾化程度,测试图像的niqe指标表示为从测试图像中提取的自然场景统计特征的多元高斯模型与从自然图像语料中提取的质量感知特征的多元高斯模型之间的距离。

15.第二步中所述特征注意力机制模块结合了通道注意力和空间注意力,对于输入的特征图f∈r

c*h*w

,注意力机制的处理过程表示为

[0016][0017][0018]

其中:f是输入的特征图,f

′

是经过通道注意力机制处理后的特征图;m

c

(f)∈r

c*1*1

代表的是1维通道注意力图,f

″

是经过空间注意力机制处理后的特征图;m

s

(f

′

)∈r

1*h*w

代表的是空间注意力图,代表逐元素相乘操作。

[0019]

第四步中使用多层门控递归单元网络捕获视频帧之间的时间序列信息,所述多层门控递归单元包括重置门和更新门,最终输出状态计算下式所示:

[0020][0021]

其中:h

t

是t时刻gru单元的输出,z

t

是控制更新门的门控,代表逐元素相乘,h

t

‑1是t

‑

1时刻gru单元的输出,是候选隐藏状态。

[0022]

本发明的有益效果如下:

[0023]

本发明提出了一种有效的水下视频质量评估方法。针对水下图像中的散射、模糊、雾化现象,融合了水下彩色图像质量评价指标、图像模糊程度指标、自然图像质量评估指标和高阶语义特征来进行测量评估,融合后的特征能更好的体现出水下图像退化过程并带有图像语义信息。此外,使用的门控递归单元网络能够有效的保留视频的时序信息。

附图说明

[0024]

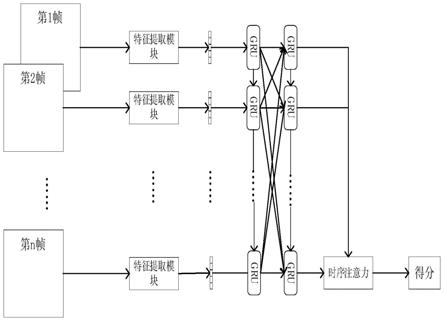

图1为模型整体框架图。

[0025]

图2为特征提取流程图。

[0026]

图3为特征提取中的特征注意力模块结构图。

[0027]

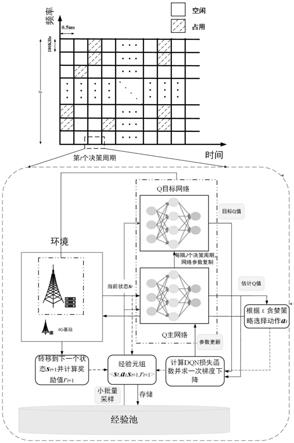

图4为gru单元结构图。

[0028]

图5为时序注意力机制模块结构图。

具体实施方式

[0029]

下面结合附图对本发明创造做进一步详细说明。

[0030]

我们将水下视频分解成帧,并按帧处理,每一帧即为一张水下图像。首先,针对水下视频特有的色偏、模糊、雾化等质量退化因素,我们使用一组图像质量评价指标获得视频帧的退化特征。使用水下彩色质量评价指标(uciqe)提取视频帧的色彩特征,该指标以色度、饱和度和对比度为测量分量,通过线性的方式将测量分量线性组合,有效地量化了水下

图像的色彩和对比度;使用边缘图像块的对比度指数值和来表示水下彩色图像的模糊程度,提取出视频帧模糊程度特征;使用自然图像质量指标(niqe)衡量水下图像的雾化程度,测试图像的niqe指标表示为从测试图像中提取的自然场景统计特征(nss)的多元高斯模型(mvg)与从自然图像语料中提取的质量感知特征的多元高斯模型之间的距离。其次,人类对视觉图像/视频质量的判断受到内容的影响,针对视频内容的感知问题,我们使用预训练的resnet50深度神经网络结合特征注意力机制提取视频帧的语义特征向量,降维后得到视频帧的语义质量分数。然后,将各指标分数进行归一化处理,与语义质量分数进行拼接,得到每一帧的特征向量。最后,使用门循环单元网络捕获视频帧之间的时序信息并进行特征融合,加上时序注意力机制,得到最终的视频质量分数。

[0031]

本发明主要采用如下模块:

[0032]

模块1:退化特征提取模块

[0033]

模块2:语义特征提取模块

[0034]

模块3:时序信息与特征融合模块

[0035]

模块1:退化特征提取模块。水下视频的主要退化现象包括色偏、模糊和雾化,因此我们提取出这三种退化对应的分数作为视频退化特征。

[0036]

使用视频帧色彩分数s

col

表示色偏。水下彩色质量评价指标(uciqe)是一种使用广泛的水下图像质量指标。以色度、饱和度和对比度为测量分量,通过线性的方式将测量分量线性组合,有效的量化了水下图像的色彩、模糊程度和对比度。计算视频帧的uciqe得到色彩特征分数s

col

。

[0037]

使用视频帧模糊分数s

blu

表示模糊程度。由于水介质的散射,特别是前向散射的影响,使水下图像严重失真,出现模糊。我们利用边缘图像块的对比度指数值和来表示水下彩色图像的模糊。通过计算视频帧像素的均方根对比度blu(v)。来表示模糊分数s

blu

。

[0038]

使用视频帧雾化分数s

fog

表示雾化程度。我们计算水下视频帧的自然图像质量指标(niqe)值来表示雾化程度。niqe指标通过计算待测图像与自然图像的统计规律的偏差来衡量图像质量,基于一系列从的图像质量特征“质量感知”特征,并将其用于拟合一个多元高斯模型(mvg)中。质量感知特征源于一系列正常的自然图像。将给定的测试图像的niqe指标表示为从测试图像中提取的图像统计模型特征的拟合的mvg模型与从自然图像语料中提取的质量感知特征的mvg模型之间的距离。通过niqe值得到视频帧的雾化特征分数s

fog

。

[0039]

模块2:语义特征提取模块。众多的实验已证明,人类对视觉图像质量的判断受到图像内容的影响。因此,提取到准确的图像内容信息对于质量评价指标的建立十分重要。我们使用预先训练的resnet50网络和注意力机制模块来提取视频帧内容感知的语义特征。resnet网络采用恒等映射将前一层的输出直接传递到后面层,这种残差跳跃的结构解决了深层次的网络退化问题,可以搭建更深的网络提高特征提取能力。使用resnet50网络模型提取语义特征,并在imagenet数据集上进行预训练。特征注意力机制模块结合了通道注意力和空间注意力。对于输入的特征图f∈r

c*h*w

,注意力机制的处理过程表示为

[0040][0041][0042]

其中:f是输入的特征图,f

′

是经过通道注意力机制处理后的特征图。m

c

(f)∈r

c*1*1

代表的是1维通道注意力图,f

″

是经过空间注意力机制处理后的特征图。m

s

(f

′

)∈r

1*h*w

代表的是空间注意力图,代表逐元素相乘操作。

[0043]

模块3:时序信息与特征融合模块。使用多层门控递归单元(gru)网络捕获视频帧之间的时间序列信息,并进行多特征的融合。gru能够保留长时间的特征信息,同时避免网络训练过程中出现的梯度消失的问题,是长短期记忆网络(lstm)的变体,具有更简单的结构,并且更易于计算。gru单元主要包括重置门和更新门,最终输出状态计算如式(2)所示:

[0044][0045]

h

t

是t时刻gru单元的输出,z

t

是控制更新门的门控,代表逐元素相乘,h

t

‑1是t

‑

1时刻gru单元的输出,是候选隐藏状态。

[0046]

在多层gru结构中,不同的gru层进行空间连接,数据由上层输出到下一层的神经元。同一gru层具有时间依赖性,gru层之前的输出将循环进入该层作为输入。每个gru层包含大量的神经元,以捕获传感器数据的长期依赖关系。特征经过多层的gru的融合,将最后一层gru各单元的输出作为时序注意力机制的输入,利用时序注意力机制调整gru的输出,之后使用全连接层进行降维处理,得到取值范围在[0,1]之间的视频质量分数数值。

[0047]

下面用具体实施例进一步解释本发明内容。

[0048]

步骤1:选取了一段5秒的水下视频,将其分解为120帧,每一帧大小为224*224。每一帧记为v

k

,k∈[1,120]。整个流程如图1所示。首先进行特征提取,特征提取的流程图如图2所示,流程为步骤2至步骤5。

[0049]

步骤2:计算v

k

帧的色彩分数s

col

。根据uciqe指标公式,计算出色彩得分,计算过程如式(4)所示:

[0050]

s

col

=0.4680

×

σ

c

0.2745

×

con

l

0.2576

×

μ

s

ꢀꢀꢀ

(4)

[0051]

其中,σ

c

是色度的标准方差,con

l

是亮度的对比度,μ

s

是饱和度的平均值。

[0052]

步骤3:计算v

k

帧的模糊分数s

blu

。利用边缘图像块的对比度指数值和来表示水下彩色图像的模糊。寻找边缘块的方法是判断边缘像素的数量是否大于一个块中像素总数的0.2%。我们将视频帧分成64*64的块。然后使用sobel算子判断某一块是否为边缘块。边缘块的寻找方法是判断块中的边缘像素的数量是否大于块中像素总数的0.2%。模糊指数为所有边缘块均方根对比度值之和,均方根对比度指数计算公式如(5)所示:

[0053][0054]

其中,h*w视频帧的尺寸,t边缘块的个数,v

(i,j)

是视频帧v中处于(i,j)位置处的像素值,是所有像素的平均强度,h为高度,m为宽度,blu()表示均方根。视频帧的模糊特征分数s

blu

=blu(v)。

[0055]

步骤4:计算v

k

帧的雾化分数s

fog

。将给定的测试图像的niqe指标表示为从测试图像中提取的图像统计模型特征的拟合的mvg模型与从自然图像语料中提取的质量感知特征的mvg模型之间的距离。niqe计算公式如(6)所示:

[0056]

[0057]

其中,v1,a1表示从自然图像中提取的mvg模型的均值向量和协方差矩阵。v2,a2表示待测帧的mvg模型的均值向量和协方差矩阵。再进行归一化处理,得到视频帧的雾化分数

[0058]

步骤5:计算v

k

帧的语义分数s

con

。使用预先训练的resnet50网络来提取视频帧内容感知的语义特征向量,并在resnet50网络中加入了注意力机制模块。使用sigmoid激活函数,将输出的值映射至0

‑

1之间。多个全连接将其维度降至1*1,得到最终的语义分数s

con

。

[0059]

步骤5.1:使用resnet50网络模型提取特征,并在imagenet上进行预训练。使用了resnet50网络的前四个模块。以第一个卷积模块为例,输入为3*224*224的彩色视频帧。首先经过一个7*7*64的卷积,卷积核大小为7*7,数量为64,输出为64*112*112的特征图。然后是一个最大池化层。之后通过第一个卷积块,由3个小的卷积块构成,每一个小的卷积块包含三个卷积层,分别为1*1*64,3*3*64,1*1*256,输出为256*56*56的特征图。第二个卷积块是4层的[1*1*128,3*3*128,1*1*512]卷积,输出的大小为512*28*28。第三个卷积块是6层的[1*1*256,3*3*256,1*1*1024]卷积,输出的大小为512*28*28。第四个卷积块是3层的[1*1*512,3*3*512,1*1*2048]卷积,输出的大小为512*28*28。

[0060]

步骤5.2:特征注意力机制模块。图3所示为注意力机制模块的结构,该模块结合了通道注意力和空间注意力。将resnet50网络第一个卷积块的输出当作特征注意力机制的输入的特征图。首先经过通道注意力机制处理,通道注意力关注什么样的特征是有意义的,使用平均池化和最大池化来聚合特征映射的空间信息,生成两个不同的空间上下文描述符f

cavg

和f

cmax

。将两个描述符送到一个由多层感知机(mlp)和一个隐藏层组成的共享网络,生成通道注意力图m

c

∈r

c*1*1

。

[0061]

整个过程的计算公式可以表示为

[0062]

m

c

(f)=σ(w1(w0(f

cavg

)) w1(w0(f

cmax

)))

ꢀꢀꢀꢀ

(7)

[0063]

式中σ()是sigmoid激活函数。w0是池化操作的权重,w1是多层感知机的权重,共享输入和relu激活函数。将通道注意力图m

c

和输入的特征f进行逐元素相乘即可得到新的特征f

′

。

[0064]

在通道注意力模块后,使用空间注意力机制来关注哪些特征是有意的。首先使用平均池化和最大池化操作聚合功能映射的通道信息,生产两个二维映射f

savg

∈r

1*h*w

和f

smax

∈r

1*h*w

。然后通过一个标准的卷积层进行混合,卷积核大小为7*7。产生空间注意力图的计算过程表示为:

[0065]

m

s

(f

′

)=σ(f

7*7

(f

savg

,f

smax

))

ꢀꢀꢀ

(8)

[0066]

其中:f

7*7

是大小为7*7的卷积操作。将m

s

与空间注意力机制的输入f

′

进行逐元素相乘,即得到整个注意力机制的最终输出f

″

。

[0067]

步骤6:特征融合。图4所示为gru单元的结构图,使用gru模块进行多特征与时序信息的融合。首先将第v

k

帧提取出的色彩分数s

col

、模糊分数s

blu

、雾化分数s

fog

、语义分数s

con

拼接成一个4*1的特征向量w

k

,w

k

=[s

col

,s

blu

,s

fog

,s

con

]

t

。在本实例中,视频被分为120帧,即经过退化特征和语义特征提取后,输出了一个120*4*1的张量。因此该视频对应的融合层具有120个gru单元。第一层gru用来捕获时序信息,gru单元的结构主要包括重置门和更新门。

[0068]

重置门决定上一单元记忆信息的保留。该门的计算公式如(9)所示:

[0069]

r

t

=σ(w

r

[h

t

‑1,w

k

])

ꢀꢀꢀ

(9)

[0070]

更新门的计算公式如式(10):

[0071]

z

t

=σ(w

z

[h

t

‑1,w

k

])

ꢀꢀꢀ

(10)

[0072]

其中,h

t

‑1为t

‑

1时刻gru单元的输出,w

k

为当前单元输入。w

r

,w

z

分别为重置门和更新门的权重,通过网络训练获得。σ()代表sigmoid激活函数,经过sigmoid激活函数,输出的值在0

‑

1之间。

[0073]

重置门中元素值接近0,那么意味着重置对应隐藏状态元素为0,即丢弃上一时间步的隐藏状态。如果元素值接近1,那么表示保留上一时间步的隐藏状态。然后,将按元素乘法的结果与当前时间步的输入连结,再通过含激活函数tanh的全连接层计算出候选隐藏状态其所有元素的值域为[

‑

1,1]。候选值的计算公式如(11)所示:

[0074][0075]

其中tanh()表示正切函数,r

t

控制重置门,w

c

为候选值权重,通过训练得到。w

k

为当前单元输入,代表逐元素相乘。

[0076]

gru模块的最终输出状态计算公式如前面的式(3)计算。我们将4*1的特征向量输入到gru单元中。序列长度为120、gru单元的隐藏层神经元数量设置为32。经过多层映射变换为长度为32的特征向量。式(3)所需的r

t

,z

t

,是由输入w

k

经过线性映射得到的。计算方法如式(8)

‑

(10)。z

t

是控制更新门的门控,代表逐元素相乘,是候选隐藏状态。

[0077]

步骤7:时序注意力机制。对多层gru输出的引入注意力机制,以强化关键帧对整个视频质量的影响。如图5所示,以最后一层gru的各隐藏层状态作为输入,得到最终时刻的隐藏层状态值。首先计算评分函数score,计算公式如式(12)所示:

[0078][0079]

h

z

是最后一个gru单元的输出,h

i

是历史时刻的gru单元输出。然后计算注意力权重α

z,i

,计算如式(13)所示:

[0080][0081]

式中:t

x

为gru单元个数,h

k

为第k时刻gru单元的输出,k∈(1,t

x

),α

z,i

是第i个输出的注意力权重。

[0082]

中间向量c

z

的计算如式(14)所示:

[0083][0084]

经过注意力机制得到的最终状态值如式(15)所示。

[0085][0086]

c

z

是中间向量,h

z

是最后一个gru单元的输出,也是时序注意力机制的输入。w

z

是中间向量的权重矩阵,需要进行训练。

[0087]

步骤8:质量分数。最后一层gru的最后一个单元输出的状态即视频质量特征向

量经过多层gru和时序注意力机制进行融合得到的。将其记为w

out

。因为gru单元的隐藏层神经元数量设置为32,所以w

out

长度为32。采用全连接层进行降维处理,计算公式如式(16)所示:

[0088]

w’out

=w

fc

*w

out

b

fc

ꢀꢀꢀ

(16)

[0089]

w

fc

是线性映射权重系数,b

fc

是偏置系数。全连接层的输出大小设定为1*1,即可将特征降维成一个范围在[0,1]之间的数值,代表整个视频的质量分数。模型的整体框架如图5所示。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。