1.本发明属于计算机软件领域,具体涉及一种基于垂直分割的差分隐私异构多属性数据发布方法。

背景技术:

2.网络信息技术的快速发展,推动了互联网应用的逐步普及,在提供便利的同时,大量数据信息通过个人用户、企业单位、研究机构等源源不断地产生,并被各种智能设备收集。通过对这些收集到的数据进行分析和处理,可以进一步挖掘其潜在的价值,创造巨大的社会效益。在现实生活中,大量的数据往往收集于不同的智能设备,即同一个体的不同属性集数据被收集于不同组织或机构,从而单个个体的数据被多方以垂直方式分割。多方协作发布整合数据集,可以使数据使用者更充分地挖掘不同数据潜在的关联,为制定决策提供更好的支持。例如,某地区的医院和银行拥有同一组市民的医疗数据r1和金融数据r2,其中r1记录市民的医疗信息,r2记录市民的金融信息。毫无疑问,整合市民的医疗数据和金融数据,对用户医疗水平和经济水平进行关联性分析,可以帮助政府部门制定更好的卫生政策。然而,由于每一方持有的数据中通常蕴含大量的个人敏感信息(例如,医疗数据中的患者医疗记录、金融数据中的市民工资记录等),简单地整合多方数据并直接对外发布会导致严重的个人隐私泄露。因此,基于垂直分割的整体数据发布需要保证各方的隐私数据不被泄露。

3.在k-匿名模型下,已经有许多关于垂直分割数据发布的研究。但已有的研究采用的k-匿名模型或其扩展容易受到属性连接、背景知识等多种隐私攻击,而且无法提供很好的隐私保护效果。与k-匿名等传统隐私保护模型不同,差分隐私可以为数据发布隐私保护提供理论分析,同时可以抵御背景知识、属性连接等攻击。在尝试正式定义数据发布的隐私需求后,差分隐私已经成为最广泛接受的数据发布隐私保护模型。

4.从已有的研究可以看出,差分隐私在单方数据发布方面做了诸多努力,但关于垂直分割的多方数据发布的研究还相对较少。distdiffgen方法是最早使用差分隐私技术来解决垂直分割数据发布隐私保护问题。然而,distdiffgen是为分类任务量身定制的,且仅适用于两方发布场景,不具备可扩展性。dplt方案的提出是为了发布满足差分隐私保护的垂直分割数据,在dplt中,多个数据拥有者和第三方在差分隐私保护下共同构建一棵隐树,利用隐树模型近似生成发布数据集。

5.上述方法对于分布式设置的处理均是固定隐私预算分配,即对所有数据拥有者提供相同级别的隐私保护,这显然是不合理的。当多个数据拥有者联合发布数据时,出于各自的隐私风险控制考虑,各方的隐私需求肯定是不完全相同的,相同强度的隐私保护会导致要么没有充分保护高敏感的数据拥有方,要么低敏感数据拥有方的数据信息的过度丢失。

技术实现要素:

6.发明目的:本发明提供一种基于垂直分割的差分隐私异构多属性数据发布方法,降低了属性联合分布中注入的噪声量,保证了每个本地数据集的数据隐私。

7.技术方案:本发明所述的一种基于垂直分割的差分隐私异构多属性数据发布方法,包括以下步骤:

8.(1)自适应隐私预算分配:数据拥有者pi根据局部数据集di的数据敏感性和隐私属性暴露概率计算隐私预算εi;

9.(2)提出隐树模型参数和结构学习相统一的满足差分隐私的隐树模型学习:数据拥有者pi利用隐树模型学习算法构建隐树结构,使构建的τi满足ε

i1-差分隐私,同时基于τi计算的θi满足ε

i2-差分隐私;pi将τi和θi发送给第三方,第三方通过隐树模型学习算法构建整合数据集的隐树结构τ,同时更新参数θ;

10.(3)合成数据发布:根据隐树结构τ和加噪θ,采样每个属性的条件分布,生成扰动数据集d',并对外发布。

11.进一步地,所述步骤(1)实现过程如下:

12.自适应隐私预算分配参数由数据敏感性sd和隐私属性暴露概率l

pb

两部分组成;

[0013][0014][0015]

其中,sen

attr

表示敏感属性,sen

val

表示敏感属性的值,η和σ分别为数据敏感度和隐私泄露概率的权重,η σ=1,权重的分配由数据拥有者根据具体数据隐私保护要求确定,对不同的隐私保护需求可以调节数据敏感度和隐私泄露概率的权重来进行自适应隐私预算分配,实现不同的隐私保护强度。

[0016]

进一步地,步骤(2)所述的隐树模型参数学习实现过程如下:

[0017]

基于双向推理算法计算隐属性y的联合条件分布,当yj的孩子节点不是显属性时,βj的计算需要从叶节点开始向上传递,计算每个隐属性节点yj∈y的βj,具体公式如下:

[0018][0019]

其中,{yc}是yj的孩子节点集合;

[0020]

从根节点开始自上而下推理,计算每个隐属性节点yj∈y的αj:

[0021][0022]

其中,{ys:y

p(s)

=y

p(j)

,ys≠yj}是yj的兄弟节点集合;

[0023]

对于任意隐属性节点yj∈y,计算边缘条件分布pr(yj,y

p(i)

|x

(n)

):

[0024][0025]

其中,{ys:y

p(s)

=y

p(j)

,ys≠yj}是yj的兄弟节点集合;

[0026]

当yj的孩子节点为显属性或者yj为根节点yr时,βj和αj计算为βj=pr(x

in

(j)|yj),αj=pr(yj|x

out

(j)),可以得到条件分布

[0027]

进一步地,步骤(2)所述的隐树模型结构学习实现过程如下:

[0028]

首先初始化隐树结构,隐属性集合,初始化模型参数,将未加入

τi的显属性xj∈x\τ和隐属性集合y加入候选集合ω,使用指数机制从候选集合ω中选取使模型参数θi的对数似然增量最大的属性对(a

j1

,a

j2

)加入隐树结构τi,若有生成隐属性,同时将隐属性加入集合y;基于更新的隐树结构τi,计算联合条件分布,更新隐树参数θi;重复执行上述隐树结构τi和隐树参数θi的更新操作,直到将初始的平凡树森林合并为一棵隐树。

[0029]

进一步地,所述步骤(3)实现过程如下:

[0030]

数据拥有者pi根据自适应隐私预算分配参数ai计算隐私预算大小εi=ai×

ε,并保证隐树参数学习的计算过程满足ε

i-差分隐私保护要求;在本地学习得到隐树结构之后,数据拥有者将隐树结构τi和参数θi发送给第三方;第三方根据接收到隐树森林,学习新的隐树结构τ,同时更新隐树参数θ;利用学习到的隐树的结构τ和参数θ,第三方可以估算原始整合数据的联合分布;根据该联合分布,第三方生成一组新的整合数据;

[0031]

为了保证θi的隐私性,为每个属性在给定其父节点的条件下的概率分布添加拉普拉斯噪声lap((2(d m))/(|di|ε2)),其中概率分布的全局敏感度

△

f=2/|di|。

[0032]

有益效果:与现有技术相比,本发明的有益效果:单方整体数据通过自适应隐私保护强度机制,实现隐私预算的自适应分配,在增加数据效用的情况下满足不同隐私需求的差分隐私保护;本发明提出的隐树模型参数和结构学习相统一的满足差分隐私的启发式学习算法,通过将模型结构和参数学习目标统一为最大化模型参数的对数条件似然增益,该算法能进一步提高隐树模型学习效率;本发明提出的自适应隐私保护强度机制、启发式隐私模型学习等技术提高了隐树学习效率,降低了属性联合分布中注入的噪声量,保证了每个本地数据集的数据隐私。

附图说明

[0033]

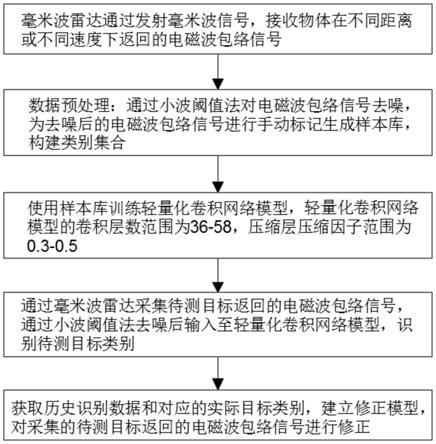

图1为本发明的流程图;

[0034]

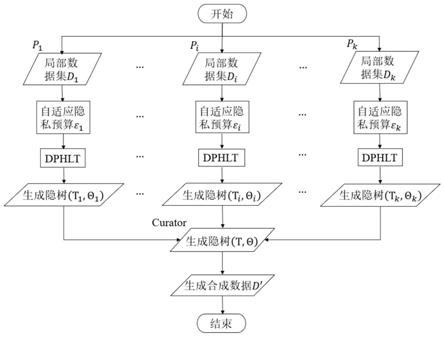

图2是双向推理算法示例图。

具体实施方式

[0035]

下面结合附图对本发明做进一步详细说明。

[0036]

本发明提出一种基于垂直分割的差分隐私异构多属性数据发布方法,如图1所示,具体包括以下步骤:

[0037]

步骤1:自适应隐私预算分配:数据拥有者pi根据局部数据集di的数据敏感性和隐私属性暴露概率计算隐私预算εi。

[0038]

数据敏感性代表数据的敏感程度,数据越敏感意味着原始数据隐私程度越高,潜在隐私泄露风险越大,即数据隐私风险随着数据敏感性的增高而增加。为了方便自适应分配参数的计算,规定sd的取值范围为0≤sd≤1。sd的大小与隐私保护强度成正比,即sd的值越大,需要的隐私保护程度越高,相应分配的隐私预算越小。

[0039]

隐私属性暴露概率(l

pb

)表示敏感属性中包含敏感属性值的概率,计算公式为:

[0040][0041]

其中,sen

attr

表示敏感属性,sen

val

表示敏感属性的值,l

pb

的大小与隐私暴露概率

成正比,即l

pb

的值越小,攻击者根据其背景知识推断出受害者敏感属性值的概率越小,需要的隐私保护程度也就越低,相应分配的隐私预算也就越大,反之亦然。

[0042]

利用数据敏感性和隐私属性暴露露概率计算自适应隐私预算参数:

[0043][0044]

步骤2:隐树模型学习:数据拥有者pi利用隐树模型学习算法构建隐树结构,使构建的τi满足ε

i1-差分隐私,同时基于τi计算的θi满足ε

i2-差分隐私。pi将τi和θi发送给第三方,第三方通过隐树模型学习算法构建整合数据集的隐树结构τ,同时更新参数θ。

[0045]

隐树模型学习是满足差分隐私的启发式学习算法,统一隐树模型参数学习和结构学习的目标,通过最大化模型参数的对数似然增益迭代更新隐树结构。隐树模型学习分为本地隐树构建和整体隐树构建两部分。具体来说,数据拥有者根据满足差分隐私的启发式隐树学习算法学习本地数据集的隐树模型,同时以动态隐私预算分配的方式对隐树参数添加拉普拉斯噪声扰动,并将隐树结构τi和参数θi发送到第三方。第三方根据收到的隐树森林,利用启发式隐树学习算法学习新的隐树结构τ,并同步计算噪声隐树参数θ。

[0046]

满足差分隐私的启发式隐树学习算法具体描述如下:给定数据集d={x

(1)

,

…

,x

(n)

},通过最大化似然估计γ学习隐树参数和隐树结构,其中利用指数机制从候选节点中选择使γ最大的加入隐树结构τ,同时更新隐树参数θ。隐树参数更新和结构更新交替进行,直到γ停止增加。

[0047]

(1)隐树参数学习:

[0048]

在隐树参数学习过程中,假设隐树结构是给定的。借助em算法,利用联合条件分布q

(n)

最大化期望对数似然以更新模型参数θ:

[0049]q(n)

=pr(y1,

…

,ym|x

(n)

).

ꢀꢀ

(1)

[0050][0051]

其中,y1,

…

,ym为隐属性,v={x,y}={v1,

…

,v

d m

}为隐树节点集合,x={x1,

…

,xd}为显属性集合,y={y1,

…

,ym}为隐属性集合,x

(n)

为多属性数据集d={x

(1)

,

…

,x

(n)

}中的数据。

[0052]q(n)

可以通过成对的边缘条件分布pr(yj,y

p(i)

|x

(n)

)计算,其中p(j)表示节点yj的父节点。对于根节点yr和叶子节点xi,相应的边缘条件分布表示为pr(yr|x

(n)

)和pr(y

p(i)

|x

(n)

)。条件分布的计算利用双向推理算法实现,即自上而下和自下而上推理。

[0053]

对于每个隐属性节点yj∈y,该推理算法定义内部显属性集x

in

(j)={xi:xi∈s is descendant of yj},外部显属性集x

out

(j)={xi:xi∈s is not descendant of yj},其中s为是显属性集x的任意子集。

[0054]

如图2所示,基于双向推理算法计算隐属性y的联合条件分布,当yj的孩子节点不是显属性时,βj的计算需要从叶节点开始向上传递,计算每个隐属性节点yj∈y的βj,具体公式如下:

[0055][0056]

其中,{yc}是yj的孩子节点集合。

[0057]

从根节点开始自上而下推理,计算每个隐属性节点yj∈y的αj:

[0058][0059]

其中,{ys:y

p(s)

=y

p(j)

,ys≠yj}是yj的兄弟节点集合。

[0060]

对于任意隐属性节点yj∈y,计算边缘条件分布pr(yj,y

p(i)

|x

(n)

):

[0061][0062]

其中,{ys:y

p(s)

=y

p(j)

,ys≠yj}是yj的兄弟节点集合。

[0063]

当yj的孩子节点为显属性或者yj为根节点yr时,βj和αj计算为βj=pr(x

in

(j)|yj),αj=pr(yj|x

out

(j)),可以得到条件分布

[0064]

(2)隐树结构学习:

[0065]

隐树结构学习自平凡树的初始森林开始,迭代更新隐树结构,其中所有的显属性xi∈x均独立。在初始的森林中,x的联合对数似然等于指定隐树的对数似然之和。结构学习中涉及两种图形编辑操作:1)在两个现有节点之间添加边;2)根据现有节点产生新的父节点。与操作1)相比,操作2)对模型复杂性的影响更大,会更大程度地增加模型复杂性。因此,在迭代更新树结构的过程中,优先评估操作1)。

[0066]

本地隐树模型学习自平凡树的初始森林开始,首先初始化隐树结构隐属性集合,初始化模型参数。将未加入τi的显属性xj∈x\τ和隐属性集合y加入候选集合ω,使用指数机制从候选集合ω中选取使模型参数θi的对数似然增量最大的属性对(a

j1

,a

j2

)加入隐树结构τi,若有生成隐属性,同时将隐属性加入集合y。基于更新的隐树结构τi,计算联合条件分布,更新隐树参数θi。重复执行上述隐树结构τi和隐树参数θi的更新操作,直到将初始的平凡树森林合并为一棵隐树。

[0067]

隐树结构迭代更新的过程就是将包含d棵平凡树的原始森林通过图形编辑操作生成一棵隐树τ。在对隐树结构进行图形编辑时,需要满足两个正则化约束条件:1)保持树形结构;2)对于新添加节点yj'的所有兄弟节点{ys'},条件概率pr(x

in

(s)|x

out

(s))的差值必须大于设定的阈值,避免树结构的不健康修改。

[0068]

指数机制通过计算(a

j1

,a

j2

)对模型参数θ的增益,决定其加入τ的概率。在给定父节点的条件下计算概率分布的全局敏感度

△

u=2/|di|,一共需要执行d-1次,因此被选择的概率为:

[0069][0070]

步骤3:合成数据发布:根据隐树结构τ和加噪θ,采样每个属性的条件分布,生成扰动数据集d',并对外发布。

[0071]

数据拥有者pi根据自适应隐私预算分配参数ai计算隐私预算大小εi=ai×

ε,并保证隐树参数学习的计算过程满足ε

i-差分隐私保护要求。在本地学习得到隐树结构之后,数据拥有者将隐树结构τi和参数θi发送给第三方。第三方根据接收到隐树森林,学习新的隐

树结构τ,同时更新隐树参数θ。利用学习到的隐树的结构τ和参数θ,第三方可以估算原始整合数据的联合分布。根据该联合分布,第三方生成一组新的整合数据。

[0072]

为了保证θi的隐私性,为每个属性在给定其父节点的条件下的概率分布添加拉普拉斯噪声lap((2(d m))/(|di|

·

ε2))。考虑到不同属性携带的信息量不同,从而对攻击者推理目标对象隐私信息的贡献不同,本文借助属性归一化风险熵oe,以动态隐私预算分配方式实现噪声扰动。

[0073][0074][0075]

借助公式(7),以属性风险熵为权重分配隐私预算,实现属性异构保护。其中概率分布的全局敏感度

△

f=2/|di|,由此可得显属性xj中注入的拉普拉斯噪声量为公式(6)所示。根据差分隐私性质1,数据拥有者pi执行privvplt算法满足ε

i-差分隐私,其中εi=ε

i1

ε

i2

。

[0076]

综上所述,本发明主要包括三个阶段,即自适应隐私预算分配、隐树模型学习和合成数据发布。首先,根据数据拥有方本地数据集的敏感性和隐私属性暴露概率计算自适应分配隐私预算参数,该参数是数据发布隐私保护强度的重要依据。单方整体数据通过自适应隐私保护强度机制,实现隐私预算的自适应分配,在增加数据效用的情况下满足不同隐私需求的差分隐私保护。其次,提出隐树模型参数和结构学习相统一的满足差分隐私的启发式学习算法,通过将模型结构和参数学习目标统一为最大化模型参数的对数条件似然增益,该算法能进一步提高隐树模型学习效率。最后,多个数据拥有者和第三方在满足差分隐私的条件下共同构建一棵隐私模型,该模型用于度量整合数据的所有属性之间的联合分布,利用联合分布可以生成新的合成数据集。本发明具有以下优点:一方面自适应隐私保护强度机制可以降低属性联合分布中注入的噪声量,保证每个本地数据集的个性化数据隐私;另一方面,启发式差分隐私隐树模型学习可以提高隐树学习效率,减少算法时间开销。

[0077]

以上所述仅是本发明的优选实施方式,应当指出:对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也应视为本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。