1.本发明涉及一种基于毫米波雷达和视觉传感器的车辆检测方法,属于雷达通信技术领域。

背景技术:

2.从上世纪60年代起,各国科学家开始了应用于汽车的毫米雷达的研究。但是由于当时的微波工艺水准处在一个较低的水平,无法制造出满足性能需求的微波器件,故各国对车载毫米波雷达的研究都受到了限制。然而,随微波科技的进步和dsp和fpga等硬件技术的快速发展,车载毫米波雷达的研究成为热点。

3.近年来,迅猛发展的汽车工业不仅给人们生活带来了诸多便捷,也进一步促进了社会的经济发展。但随之而来的道路交通安全问题也日渐凸显,传统机动车行驶过程中出现超速、酒驾等现象屡见不鲜,给人们出行安全带来了巨大隐患。

技术实现要素:

4.本发明的目的在于,克服现有技术中存在的问题,提供一种基于毫米波雷达和视觉传感器的车辆检测方法,能够达到实时检测要求,能够准确获取目标车辆位置及距离。

5.为了解决上述问题,本发明的基于毫米波雷达和视觉传感器的车辆检测方法包括如下步骤:

6.步骤1:通过毫米波雷达接收前方目标的雷达数据;

7.步骤2:对接收到的目标信息进行解析,得到前方目标与本车的距离、角度和相对速度;

8.步骤3:对进行过解析的目标进行筛选,得到有效目标;

9.步骤4:对目标进行可视化处理,将雷达监测到的有效目标位置信息投影于雷达监测鸟瞰图中,并将该目标对应的速度信息关联显示;

10.步骤5:通过视觉传感器获取目标的外形尺寸以及目标类别信息;

11.步骤6:将视觉传感器获取的信息和毫米波雷达数据进行融合,完成对前方目标的检测。

12.进一步的,所述步骤3具体包括如下步骤:

13.步骤3.1:判断目标是否为空目标,如果是则删除数据,如果不是则进入步骤3.2;

14.步骤3.2:判断目标是否为非车道目标,如果是则删除数据,如果不是则进入步骤3.3;

15.步骤3.3:判断目标是否在雷达的有效探测范围内,如果是则输出雷达有效目标,如果不是则删除数据。

16.进一步的,步骤5的具体步骤如下:

17.步骤5.1:通过视觉传感器对图像进行采集

18.步骤5.2:对图像中的目标进行提取;

19.步骤5.3:通过卷积神经网络对目标进行去噪处理,得到目标与本车的距离、角度和相对速度。

20.进一步的,步骤6具体包括如下步骤:

21.步骤6.1:将雷达坐标系转换为世界坐标系,公式如下:

[0022][0023]

式中,x、y、z为坐标系,r为前方目标与雷达的径向距离,α为偏航角,h为雷达坐标系xoz平面与世界坐标系xoz平面的距离,z0为雷达坐标系xoy平面到世界坐标系xoy平面的距离;

[0024]

步骤6.2:将视觉传感器坐标系转换为世界坐标系,公式如下:

[0025][0026]

式中,(xc,yc,zc)为视觉传感器坐标系下的坐标,(xw,yw,zw)为世界坐标系下的坐标,r为两个坐标系之间的旋转关系,t为两个坐标系之间的平移关系;

[0027]

步骤6.3:对视觉传感器和毫米波雷达进行联合标定,进行空间融合;

[0028]

步骤6.4:通过间隔采样的方法对毫米波雷达和视觉传感器进行时间融合;

[0029]

步骤6.5:对毫米波雷达和视觉传感器进行数据关联,并根据不同情况进行判断,包括:

[0030]

(d)存在未关联的视觉数据,仅输出视觉检测结果;

[0031]

(e)视觉传感器和毫米波雷达数据完成关联,输出雷达、视觉关联检测结果;

[0032]

(f)存在未关联的雷达数据,依据雷达信息输出检测结果。

[0033]

进一步的,步骤5中所述去噪处理的方法如下:

[0034]

(1)最大值法:gray(i,j)=max{r(i,j),g(i,j),b(i,j)};

[0035]

(2)分量法:将亮度值作为三个输出灰度值,进行分配处理,公式如下:

[0036]

gray1(i,j)=r(i,j)

[0037]

gray2(i,j)=g(i,j)

[0038]

gray3(i,j)=b(i,j);

[0039]

(3)加权平均法:gray(i,j)=0.289*r(i,j) 0.568*c(i,j) 0.104*b(i,j);

[0040]

其中,r、g、b为三原色,(i,j)为像素的坐标点。

[0041]

进一步的,所述卷积神经网络为cnn卷积神经网络,包括输入层、卷积层、池化层、relu层和全连接层。

[0042]

本发明的有益效果是:本发明通过检测到的激光雷达点云数据和彩色图像作为输入,预测定向三维矩形框检测前方车辆的距离和位置,完成基于激光雷达和摄像头有效地数据融合,可以运用到智能驾驶中进行实时监测以应对突发状况避免事故发生。

附图说明

[0043]

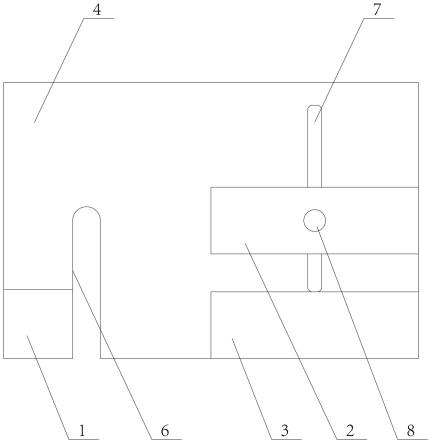

图1为本发明基于毫米波雷达和视觉传感器的车辆检测方法的流程图。

具体实施方式

[0044]

现在结合附图对本发明作进一步详细的说明。这些附图均为简化的示意图,仅以示意方式说明本发明的基本结构,因此其仅显示与本发明有关的构成。

[0045]

如图1所示,本发明的基于毫米波雷达和视觉传感器的车辆检测方法包括如下步骤:

[0046]

本发明的基于毫米波雷达和视觉传感器的车辆检测方法包括如下步骤:

[0047]

步骤1:通过毫米波雷达接收前方目标的雷达数据;通过can总线数组接收数据后,将16进制的数据转换为二进制的数据,判断数据是否为正,如果不是则将数据转化为其对应的补码,如果是就根据雷达协议进行解析。

[0048]

步骤2:对接收到的目标信息进行解析,得到前方目标与本车的距离、角度和相对速度;

[0049]

步骤3:对进行过解析的目标进行筛选,得到有效目标;

[0050]

步骤3具体包括如下步骤:

[0051]

步骤3.1:判断目标是否为空目标,如果是则删除数据,如果不是则进入步骤3.2;

[0052]

步骤3.2:判断目标是否为非车道目标,如果是则删除数据,如果不是则进入步骤3.3;

[0053]

步骤3.3:判断目标是否在雷达的有效探测范围内,如果是则输出雷达有效目标,如果不是则删除数据。

[0054]

步骤4:对目标进行可视化处理,将雷达监测到的有效目标位置信息投影于雷达监测鸟瞰图中,并将该目标对应的速度信息关联显示;

[0055]

步骤5:通过视觉传感器获取目标的外形尺寸以及目标类别信息;

[0056]

步骤5的具体步骤如下:

[0057]

步骤5.1:通过视觉传感器对图像进行采集

[0058]

步骤5.2:对图像中的目标进行提取;

[0059]

步骤5.3:通过卷积神经网络对目标进行去噪处理,得到目标与本车的距离、角度和相对速度。步骤5中去噪处理的方法如下:

[0060]

(1)最大值法:gray(i,j)=max{r(i,j),g(i,j),b(i,j)};

[0061]

(2)分量法:将亮度值作为三个输出灰度值,进行分配处理,公式如下:

[0062]

gray1(i,j)=r(i,j)

[0063]

gray2(i,j)=g(i,j)

[0064]

gray3(i,j)=b(i,j);

[0065]

(3)加权平均法:gray(i,j)=0.289*r(i,j) 0.568*g(i,j) 0.104*b(i,j);

[0066]

其中,r、g、b为三原色,(i,j)为像素的坐标点。

[0067]

卷积神经网络为cnn卷积神经网络,包括输入层、卷积层、池化层、relu层和全连接层。

[0068]

步骤6:将视觉传感器获取的信息和毫米波雷达数据进行融合,完成对前方目标的

检测。

[0069]

步骤6具体包括如下步骤:

[0070]

步骤6.1:将雷达坐标系转换为世界坐标系,公式如下:

[0071][0072]

式中,x、y、z为坐标系,r为前方目标与雷达的径向距离,α为偏航角,h为雷达坐标系xoz平面与世界坐标系xoz平面的距离,z0为雷达坐标系xoy平面到世界坐标系xoy平面的距离;

[0073]

步骤6.2:将视觉传感器坐标系转换为世界坐标系,公式如下:

[0074][0075]

式中,(xc,yc,zc)为视觉传感器坐标系下的坐标,(xw,yw,zw)为世界坐标系下的坐标,r为两个坐标系之间的旋转关系,t为两个坐标系之间的平移关系;

[0076]

步骤6.3:对视觉传感器和毫米波雷达进行联合标定,进行空间融合;

[0077]

步骤6.4:通过间隔采样的方法对毫米波雷达和视觉传感器进行时间融合;

[0078]

步骤6.5:对毫米波雷达和视觉传感器进行数据关联,并根据不同情况进行判断,包括:

[0079]

(g)存在未关联的视觉数据,仅输出视觉检测结果;

[0080]

(h)视觉传感器和毫米波雷达数据完成关联,输出雷达、视觉关联检测结果;

[0081]

(i)存在未关联的雷达数据,依据雷达信息输出检测结果。

[0082]

本发明可以给后续轨道线路规划提供数据支持,为城市交通规划、公交体系构建和轨道交通线网布局提供参考依据。

[0083]

以上述依据本发明的理想实施例为启示,通过上述的说明内容,相关工作人员完全可以在不偏离本项发明技术思想的范围内,进行多样的变更以及修改。本项发明的技术性范围并不局限于说明书上的内容,必须要根据权利要求范围来确定其技术性范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。