1.本发明涉及图像解耦表征技术领域,具体是涉及一种面向多时相图像序列的解耦表示学习方法及系统。

背景技术:

2.静态图像的解耦表征目的是学习一种结构化表征,其中单个单元的变化只对应观测变量的某个潜在变化因素,而与其他变化因素无关。与大多数静态图像的表征学习算法相比,解耦表示学习通常是可解释的,因为他们与数据的变化因素一致。

3.近年来,表征学习领域出现了许多面向静态图像的半监督和无监督学习的解耦研究工作betavae基于变分自编码器模型,通过引入一个大于1的系数β惩罚kl散度项,从而约束潜变量的信息瓶颈实现解耦,可以稳定训练,但输出的重建图像模糊。infogan基于生成对抗网络,通过最大化观测变量和潜码之间的互信息鼓励解耦表征学习,可以输出清晰的图像,但训练过程不稳定。lee等人将上述两种方法结合实现高保真图像生成,但当图像过于复杂时,无法控制其提取所需的特征。

4.随着深度学习的发展,解耦表示学习研究的对象拓展到多时相图像序列。多时相图像序列是指同一观测对象(也可称为观测变量)在不同时刻下拍摄获得的一系列图像,单个时间点所得观测图像影像即为一个时相下的静态图像数据。由于观测变量的身份不变性,多时空图像之间时域上存在的一定相关性;但由于观测变量的潜在因素变化性,其在空域上呈现一定的差异性(如颜色、亮度等的变化)。现有的面向静态图像的解耦表示学习方法很难处理复杂的时空变化性。面向多时相的解耦表示学习需要层数更深的深度学习网络和精心设计的目标函数。与本发明最相关的研究工作是dsvae,然而该算法仅使用小型卷积神经网络,构建从观测变量到潜变量的一阶简单映射,难以拟合高时空复杂度的观测空间(高维流形)和潜空间(低维流形)存在的复杂变换,单一的变分下界损失函数让观测变量的后验分布和潜变量的前验分布接近于高斯分布,故该算法容易产生模糊的均匀图像,在具有复杂高频纹理的图像重建中表现不佳。

5.由上述分析可以很容易发现,目前各种面向静态图像的解耦表示学习方法尽管取得了一定成果,但应用在时空复杂度更高的多时相图像序列中,单尺度模型拟合高维数据和潜变量之间的复杂变换性能欠佳、难以平衡解耦表示学习和图像重建性能。

技术实现要素:

6.本发明的目的是为了克服上述背景技术的不足,提供一种面向多时相图像序列的解耦表示学习方法。

7.第一方面,本发明提供了一种面向多时相图像序列的解耦表示学习方法,包括以下步骤:

8.步骤s1、获取原始多时相图像序列数据集,并划分得到训练集和测试集;

9.步骤s2、以训练集为输入,依次经高分辨率尺度推论模型和低分辨率尺度推论模

型推论,获取静态分量和动态分量的后验分布;

10.步骤s3、根据静态分量和动态分量的后验分布,获取潜码s、潜码e和拼接潜码r;

11.步骤s4、以拼接潜码r为输入,依次经低分辨率尺度生成模型和高分辨率尺度生成模型,获取重建的中间变量y

′

和观测变量x

′

;

12.步骤s5、获取潜码s经分类器处理后得到的识别分类结果;

13.步骤s6、获取训练集经高分辨率尺寸尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型、高分辨率尺度生成模型和分类器处理后的总损失函数,根据总损失函数,使用adam算法来迭代优化总损失函数,迭代完成后,模型训练完毕,即可获取多尺度变分自编码器的模型参数;

14.其中,adam算法中的参数β1设为0.9,参数β2设为0.999,参数e设为1e-8,学习率设为1e-3并以指数幂为0.3进行指数衰减,迭代周期为800;

15.步骤s7、加载获取的各模型参数以及测试集至多尺度变分自编码器上,获取多尺度变分自编码器的重建性能;

16.其中,所述多尺度变分自编码器包括高分辨率尺寸尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型、高分辨率尺度生成模型。

17.根据第一方面,在第一方面的第一种可能的实现方式中,所述步骤s1,具体包括以下步骤:

18.步骤s11、对多时相图像进行图像配准;

19.步骤s12、剪裁配准后的多时相图像成图像块;

20.步骤s13、随机打乱同一个地点不同时刻的图像块,每6个图像块横向拼接成一个多时相图像序列,获取多时相图像序列的数据集;

21.步骤s14、按照预设比例,将数据集划分成训练集和测试集。

22.根据第一方面,在第一方面的第二种可能的实现方式中,所述步骤s2,具体包括以下步骤:

23.步骤s21、打乱训练集中的数据样本顺序;

24.步骤s22、以随机加载打乱后的训练集的数据样本形成输入数据流x,经高分辨率尺度推论模型推论处理,获取二倍降采样后的中间变量y;

25.步骤s23、以中间变量y为输入,经低分辨率尺度推论模型推论处理,获取静态分量和动态分量的后验分布;

26.根据第一方面,在第一方面的第三种可能的实现方式中,所述步骤s3,具体包括以下步骤:

27.步骤s31、从静态分量和动态分量的分布中随机采样,获取潜码s和潜码e;

28.步骤s32、将潜码s中各时相分量顺序随机打散后重组,再与潜码e逐通道拼接成拼接潜码r。

29.根据第一方面,在第一方面的第四种可能的实现方式中,所述步骤s4,具体包括以下步骤:

30.步骤s41、以拼接潜码r为输入,经低分辨率尺度生成模型处理,获取中间变量y的条件分布;

31.步骤s42、从获取的中间变量y的条件分布随机采样,获取重建中间变量y

′

;

32.步骤s43、以拼接潜码r和重建中间变量y

′

为输入,经高分辨率尺度生成模型,获取观测变量x的分布;

33.步骤s44、从获取的观测变量x的分布中随机采样,获取中间观测变量x

′

。

34.根据第一方面,在第一方面的第五种可能的实现方式中,所述步骤s6之前还包括以下步骤:

35.步骤s60、建立静态分量和动态分量的前验分布。

36.针对本发明中的前验分布和后验分布,由贝叶斯定理引出该定义:

[0037][0038]

其中,x是观测得到的数据即结果,θ是决定数据分布的参数是本质原因。p(θ)是θ的前验分布,反映的是在观测变量得到具体数据之前我们对本质因素θ的了解和认识。p(θ∣x)是θ的后验分布,反映的是在给定观测数值的基础上,我们对于本质因素θ的新认知,即由结果推出产原因的分布。

[0039]

根据第一方面的第五种可能的实施方式,在第一方面的第六种可能的实现方式中,所述步骤s6,具体包括以下步骤:

[0040]

步骤s61、获取静态一致性损失项;

[0041]

步骤s62、获取交叉重建损失项;

[0042]

步骤s63、获取分类器的识别损失;

[0043]

步骤s64、获取变分自编码下界损失项;

[0044]

步骤s65、根据获取的静态一致性损失项、交叉重建损失项、分类器的识别损失以及变分自编码下界损失项,获取训练集经高分辨率尺寸尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型、高分辨率尺度生成模型和分类器处理后的总损失函数;

[0045]

步骤s66、根据总损失函数,执行反向传播和随机梯度下降算法不断循环迭代处理至模型收敛,获取各模型参数。

[0046]

根据第一方面,在第一方面的第七种可能的实现方式中,所述步骤s7中,具体包括以下步骤:

[0047]

步骤s71、打乱测试集中的样本数据顺序;

[0048]

步骤s72、随机加载打乱后的测试集的样本数据至多尺度变分自编码器中进行数据处理,获取重建观测变量;

[0049]

步骤s73、获取多尺度变分自编码器的序列图重建性能指标得分。

[0050]

第二方面,本发明提供了一种面向多时相图像序列的解耦表示学习系统,包括:

[0051]

原始多时相图像序列获取模块,用于获取原始多时相图像序列数据集,并划分得到训练集和测试集;

[0052]

分量后验分布获取模块,与所述原始多时相图像序列获取模块通信连接,用于以训练集为输入,依次经高分辨率尺度推论模型和低分辨率尺度推论模型推论,获取静态分量和动态分量的后验分布;

[0053]

潜码获取模块,与所述分量后验分布获取模块通信连接,用于根据根据静态分量和动态分量的后验分布,获取潜码s、潜码e和拼接潜码r;

[0054]

重建变量获取模块,与所述潜码获取模块通信连接,用于以拼接潜码r为输入,依次经低分辨率尺度生成模型和高分辨率尺度生成模型,获取重建的中间变量y

′

和观测变量x

′

;

[0055]

分类结果获取模块,与所述潜码获取模块通信连接,用于获取潜码s经分类器处理后得到的识别分类结果;

[0056]

模型收敛模块,与所述重建变量获取模块和所述分类结果获取模块通信连接,用于

[0057]

获取训练集经高分辨率尺寸尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型、高分辨率尺度生成模型和分类器处理后的总损失函数,根据总损失函数,使用adam算法来迭代优化总损失函数,迭代完成后,模型训练完毕,即可获取多尺度变分自编码器的模型参数;

[0058]

其中,adam算法中的参数β1设为0.9,参数β2设为0.999,参数e设为1e-8,学习率设为1e-3并以指数幂为0.3进行指数衰减,迭代周期为800;

[0059]

重建性能获取模块,与所述模型收敛模块通信连接,用于根据总损失函数,执行反向传播和随机梯度下降算法不断循环迭代处理至模型收敛,获取各模型参数;

[0060]

其中,所述多尺度变分自编码器包括高分辨率尺寸尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型、高分辨率尺度生成模型。

[0061]

根据第二方面,在第二方面的第一种可能的实现方式中,所述原始多时相图像序列获取模块进一步包括:

[0062]

配准子模块,用于对多时相图像进行图像配准;

[0063]

图像块获取子模块,与所述配准子模块通信连接,用于剪裁配准后的多时相图像成图像块;

[0064]

数据集获取子模块,与所述图像块获取子模块通信连接,用于随机打乱同一个地点不同时刻的图像块,每6个图像块横向拼接成一个多时相图像序列,获取多时相图像序列的数据集;

[0065]

划分子模块,与所述数据集获取子模块通信连接,用于按照预设比例,将数据集划分成训练集和测试集。

[0066]

本技术提供的面向多时相图像序列的解耦表示学习方法,通过构建高分辨率尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型和高分辨率尺度生成模型,拟合高时空复杂性的高维流形与低维流形复杂之间的映射变换,在实现静态特征和动态特征解耦分离的同时,也获得了多时相图像序列良好的重建性能,解决现有的同类算法难以良好拟合高维观测空间和低维潜空间复杂空间映射的问题。

附图说明

[0067]

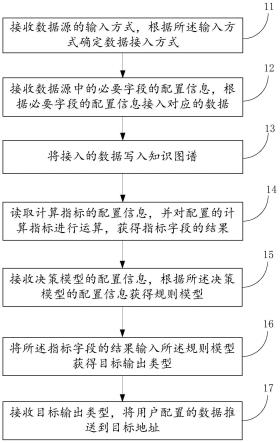

图1是本发明实施例提供的面向多时相图像序列的解耦表示学习方法的流程示意图;

[0068]

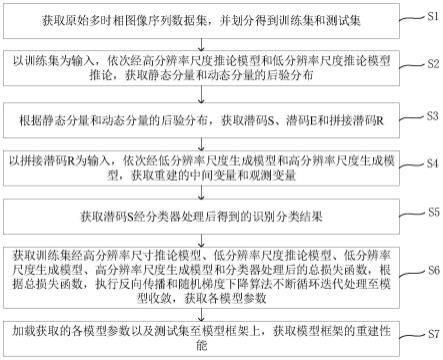

图2为本发明实施例提供的面向多时相图像序列的解耦表示学习方法的另一流程示意图;

[0069]

图3为本发明实施例提供的面向多时图像序列的解耦表示学习系统的功能模块框

图。

具体实施方式

[0070]

现在将详细参照本发明的具体实施例,在附图中例示了本发明的例子。尽管将结合具体实施例描述本发明,但将理解,不是想要将本发明限于所述的实施例。相反,想要覆盖由所附权利要求限定的在本发明的精神和范围内包括的变更、修改和等价物。应注意,这里描述的方法步骤都可以由任何功能块或功能布置来实现,且任何功能块或功能布置可被实现为物理实体或逻辑实体、或者两者的组合。

[0071]

为了使本领域技术人员更好地理解本发明,下面结合附图和具体实施方式对本发明作进一步详细说明。

[0072]

注意:接下来要介绍的示例仅是一个具体的例子,而不作为限制本发明的实施例必须为如下具体的步骤、数值、条件、数据、顺序等等。本领域技术人员可以通过阅读本说明书来运用本发明的构思来构造本说明书中未提到的更多实施例。

[0073]

单个时间点所得观测图像影像为一个时相下的静态图像数据,多时相图像序列为同一观测图像在不同时刻下拍摄获得的一系列图像。由于观测变量的身份不变性,因此多时相图像序列的一系列图像之间在时域上存在的一定相关性;但由于观测变量的潜在因素变化性,其在空域上呈现一定的差异性(如颜色、亮度等的变化)。现有的面向静态图像的解耦表示学习方法难以拟合高时空复杂度的观测变量空间(高维流形)和潜空间(低维流形)存在的复杂变换,其在具有高频纹理的图像重建中表现不佳。

[0074]

有鉴于此,参见图1所示,本发明实施例提供一种面向多时相图像序列的解耦表示学习方法,包括以下步骤:

[0075]

步骤s1、获取原始多时相图像序列数据集,并划分得到训练集和测试集;

[0076]

步骤s2、以训练集为输入,依次经高分辨率尺度推论模型和低分辨率尺度推论模型推论,获取静态分量和动态分量的后验分布;

[0077]

步骤s3、根据静态分量和动态分量的后验分布,获取潜码s、潜码e和拼接潜码r;

[0078]

步骤s4、以拼接潜码r为输入,依次经低分辨率尺度生成模型和高分辨率尺度生成模型,获取重建的中间变量y

′

和观测变量x

′

;

[0079]

步骤s5、获取潜码s经分类器处理后得到的识别分类结果;

[0080]

步骤s6、

[0081]

获取训练集经高分辨率尺寸尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型、高分辨率尺度生成模型和分类器处理后的总损失函数,根据总损失函数,使用adam算法来迭代优化总损失函数,迭代完成后,模型训练完毕,即可获取多尺度变分自编码器的模型参数;

[0082]

其中,adam算法中的参数β1设为0.9,参数β2设为0.999,参数e设为1e-8,学习率设为1e-3并以指数幂为0.3进行指数衰减,迭代周期为800;

[0083]

步骤s7、加载获取的各模型参数以及测试集至多尺度变分自编码器上,获取多尺度变分自编码器的重建性能;

[0084]

其中,所述多尺度变分自编码器包括高分辨率尺寸尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型和高分辨率尺度生成模型。

[0085]

本发明采用稠密连接网络densenet构建的深度残差网络,构建了从高维观测变量到低维潜变量二阶复合映射,从而能更好拟合两者之间的复杂变换。此外,本发明设计多任务损失函数引导模型学习良好的解耦表征,并约束潜变量的前验分布和观测变量的后验分布分别逼近双映射流模型realnvp和混合逻辑模型,而非简单的高斯分布族。由于观测变量是图像,即由离散的像素点值构成,混合逻辑回归模型可拟合离散型分布,更利于模型产生边缘清晰、纹理复杂的高清图像序列。

[0086]

在一实施例中,请参考图2,所述步骤s1,具体包括以下步骤:

[0087]

步骤s12、通过sift特征点匹配和仿射变换,对多时相图像进行图像配准,其中,多时相图像为卫星图像或街景图像;

[0088]

步骤s13、剪裁配准后的多时相图像为256

×

256像素大小的图像块;

[0089]

步骤s14、随机打乱同一个地点不同时刻的图像块,每6个图像块横向拼接成一个多时相图像序列,获取多时相图像序列的数据集;

[0090]

步骤s15、按照预设比例,将数据集划分成训练集和测试集。

[0091]

在一实施例中,所述预设比例为8:2,在数据集中随机抽取20%的多时相图像序列样本作为测试集,剩余作为训练集。

[0092]

在一实施例中,所述按照预设比例,将数据集划分成训练集和测试集之后,还包括以下步骤:

[0093]

预处理数据集,对不同地点的多时相图像序列上加附标签注释,并将标签注释按图像文件名称和标签值的格式同一保存在一个可读文档文件中。

[0094]

在一实施例中,所述步骤s2,具体包括以下步骤:

[0095]

s21、打乱训练集中的数据样本顺序;

[0096]

s22、以随机加载打乱后的训练集的数据样本形成输入数据流x,经高分辨率尺度推论模型推论处理,获取二倍降采样后的中间变量y;

[0097]

s23、以中间变量y为输入,经低分辨率尺度推论模型推论处理,获取静态分量和动态分量的后验分布。

[0098]

在一实施例中,所述步骤s22,具体包括以下步骤:

[0099]

s221、构建由一个降采样层组成的高分辨率尺度的尺度推论模型;

[0100]

s222、以随机加载打乱后的训练集的数据样本形成输入数据流x,经高分辨率尺度推论模型的最近邻域双线性插值d(

·

)和狄拉克德尔塔函数δ(

·

)推论出推论处理获取二倍降采样后的中间变量y;

[0101]

假定一个多时相图像序列x具有t帧,记作同时引入低分辨率图像作为中间变量,那么单个降采样图像y

t

的分布可视为依赖于原始单帧图像的条件分布,其后验分布具体定义如下:

[0102]

q(y

t

|x

t

)=δ(d(x

t

)),

[0103]

其中,x

t

是原始图像序列中的任意单帧图像,即单时相图像。y

t

是将图像序列降采样后,序列中的任意单帧图像。δ是狄拉克德尔塔函数(dirac's delta function),d(

·

)代表降采样过程。

[0104]

在一实施例中,所述步骤s23,具体包括以下步骤:

[0105]

s231、构建一个稠密连接的深度卷积网络φ,作为低分辨率尺度推论模型,包含了静态编码器和动态编码器;

[0106]

s232、以步骤s222的中间变量y为输入,输出静态分量和动态分量分布的后验分布。

[0107]

其中,encs是静态编码器,ennce是动态编码器。后验分布包括静态分量和动态分量分布的均值和方差:

[0108][0109]

在一实施例中,所述步骤s3,具体包括以下步骤:

[0110]

s31、通过参数重采样技巧,从静态分量和动态分量的分布中随机采样获得解耦表征:潜码s和潜码e;

[0111]

s32、将潜码s中各时相分量顺序随机打散后重组,形成重组的潜码s

′

再与潜码e逐通道拼接成拼接潜码r。

[0112]

在一实施例中,所述步骤s4,具体包括以下步骤:

[0113]

步骤s41、以拼接潜码r为输入,经低分辨率尺度生成模型gen

θ

(

·

)处理,获取依赖于潜码s和潜码e的中间变量y的条件分布,由深度神经网络θ表示为;

[0114]

μ

y’σy=gen

θ

(s

′

,e);

[0115][0116]

其中,因为本发明用混合逻辑回归模型拟合x和y的后验分布,所以k代表混合逻辑回归模型由k个逻辑回归模型组成,f是离散的logistic函数,πi为可学习的神经网络采纳数,y

t

代表重建的降采样单帧图像,s

t

代表序列中任意单帧图像的静态分量,e

t

代表序列中任意单帧图像的动态分量。

[0117]

步骤s42、从获取的中间变量y的条件分布随机采样,获取重建中间变量y

′

;

[0118]

以拼接潜码r和重建中间变量y

′

为输入,经高分辨率尺度生成模型gen

θ’(

·

),获取观测变量x的分布;

[0119]

μ

x

,σ

x

=gen

θ’(y,s

′

,e);

[0120]

观测变量的分布为依赖于潜码s和e、中间变量y的条件分布,由深度神经网络θ

′

表示为:

[0121][0122]

从获取的观测变量x的分布中随机采样,获取中间观测变量x

′

。其中各字母含义同s41相同。

[0123]

在一实施例中,所述步骤s6之前还包括以下步骤:

[0124]

步骤s60、建立静态分量和动态分量的前验分布。

[0125]

在一实施例中,所述步骤s60,具体包括以下步骤:

[0126]

利用双射流模型realnvp建立潜变量的前验分布,并假设静态分量和动态分量均服从该前验分布,以实现丰富复杂的潜空间分布。对于静态分量和动态分量中任意一个潜变量z,其前验分布被定义为:

[0127][0128]

其中,潜变量z的分布是基于一个服从标准正态分布的基础变量w和映射函数f:w

→

z。映射函数由h个可逆可微分的变换fi组合形成的变换序列,fi(w

i-1

)=wi,w0=w,wh=z。其中det代表矩阵行列式,代表第i个变换fi的雅各比矩阵。

[0129]

在一实施例中,所述步骤s6,具体包括以下步骤:

[0130]

步骤s61、获取静态一致性损失项;

[0131]

为了确保静态分量编码不随时间变化的本质信息,设计静态一致性损失项,要求各时相中的静态分量应彼此接近,即计算步骤4中所得的静态潜码的标准差,公式为:

[0132][0133]

其中,因为多时相序列包含t帧图像。是序列中t帧图像的静态分量的均值。

[0134]

步骤s62、获取交叉重建损失项;

[0135]

因为各时相中的静态分量具有一致共享性,设计了交叉重建损失项,要求尺度生成模型输入打乱时相顺序后的潜码s

′

和潜码e拼接重组,能重建出降采样和原先的观测变量。该项计算步骤6和步骤8所得的重建图y

′

、x

′

与原始y、x的误差,公式如下:

[0136][0137][0138][0139]

步骤s63、获取分类器的识别损失;

[0140]

在静态编码器的最上方添加一个简单的多层感知器作为分类器,设计识别分类这一辅助任务鼓励解耦。分类器以静态分量s为输入,根据其中包含的本质信息识别分类,输出该序列所属的身份标签。采用center loss和softmax loss计算识别损失,计算公式如下:

[0141][0142]

其中,αi表示分类器中最后一个卷积层输出的深度特征图,τi代表该观测变量所属

的身份标签,表示深度特征图聚类中第τi类特征图聚簇的中心,m是样本数,n是总的种类数,w代表权重系数,b代表偏差量,exp代表以自然常数e为底的指数函数。

[0143]

步骤s64、获取变分自编码下界损失项

[0144][0145]

其中re代表重建损失项,kl代表kullback-leibler散度项。

[0146]

步骤s65、将静态一致性损失项、交叉重建损失项、分类器的识别损失以及变分自编码下界损失项加和得到训练集经高分辨率尺寸尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型、高分辨率尺度生成模型和分类器处理后的总损失函数;

[0147]

步骤s66、根据总损失函数,采用反向传播和随机梯度下降算法,不断进行模型迭代,降低总损失值直至收敛,则训练结束,模型可同时实现解耦表征和多时相图像序列重建。

[0148]

在一实施例中,所述步骤s7中,具体包括以下步骤:

[0149]

步骤s71、打乱测试集中的样本数据顺序;

[0150]

步骤s72、随机加载打乱后的测试集的样本数据至多尺度变分自编码器中进行数据处理,获取重建观测变量;

[0151]

步骤s73、以输入数据流作为真实值x,计算模型输出的重建序列图y的峰值信噪比psnr和结构相似性ssim指标得分:

[0152][0153][0154][0155][0156][0157]

ssim(x,y)=l(x,y)

*

c(x,y)*s(x,y)。

[0158]

其中,x代表原始图像,y代表恢复后的图像,h代表图像的高度,w代表图像的宽度,mse(mean square error)为均方误差。l(x,y)是亮度比较,c(x,y)是对比度比较,s(x,y)是结构比较。c1,c2,c3分别为常数,避免分母为0带来的系统错误。

[0159]

应当理解的是,本说明书未详细阐述的部分均属于现有技术。

[0160]

基于同一发明构思,请参考图3,本发明提供了一种面向多时相图像序列的解耦表

示学习系统,包括:

[0161]

原始多时相图像序列获取模块100,用于获取原始多时相图像序列数据集,并划分得到训练集和测试集;

[0162]

分量后验分布获取模块200,与所述原始多时相图像序列获取模块通信连接,用于以训练集为输入,依次经高分辨率尺度推论模型和低分辨率尺度推论模型推论,获取静态分量和动态分量的后验分布;

[0163]

潜码获取模块300,与所述分量后验分布获取模块通信连接,用于根据根据静态分量和动态分量的后验分布,获取潜码s、潜码e和拼接潜码r;

[0164]

重建变量获取模块400,与所述潜码获取模块通信连接,用于以拼接潜码r为输入,依次经低分辨率尺度生成模型和高分辨率尺度生成模型,获取重建的中间变量y

′

和观测变量x

′

;

[0165]

分类结果获取模块500,与所述潜码获取模块通信连接,用于获取潜码s经分类器处理后得到的识别分类结果;

[0166]

模型收敛模块600,与重建变量获取模块和分类结果获取模块通信连接,

[0167]

获取训练集经高分辨率尺寸尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型、高分辨率尺度生成模型和分类器处理后的总损失函数,根据总损失函数,使用adam算法来迭代优化总损失函数,迭代完成后,模型训练完毕,即可获取多尺度变分自编码器的模型参数;

[0168]

其中,adam算法中的参数β1设为0.9,参数β2设为0.999,参数e设为1e-8,学习率设为1e-3并以指数幂为0.3进行指数衰减,迭代周期为800;

[0169]

重建性能获取模块700,与所述模型收敛模块通信连接,用于加载获取的各模型参数以及测试集至多尺度变分自编码器上,获取多尺度变分自编码器的重建性能;

[0170]

其中,所述多尺度变分自编码器包括高分辨率尺寸尺度推论模型、低分辨率尺度推论模型、低分辨率尺度生成模型、高分辨率尺度生成模型。

[0171]

原始变分自编码器包含一个单尺度推论模型和一个单尺度生成模型。本发明的方法通过引入降采样后的观测变量作为中间变量,构造多尺度变分自编码器,由低分辨率尺度推论模型、高分辨率尺度的尺度推论模型、低分辨率尺度生成模型和高分辨率尺度的尺度推论模型构成,更易于拟合时空复杂度高的观测空间与潜空间之间的复杂变换。其中,为了生成更清晰高质量的重建图像和多样性更丰富的数据,潜变量的分布和观测变量分布分别采用了更复杂的双映射realnvp流模型和离散的逻辑分布。特征解耦则是采用变分编码器的原理,使用恰当的损失函数并设计辅助任务,同时实现特征解耦和多时相图像序列重建。

[0172]

在一实施例中,所述原始多时相图像序列获取模块100进一步包括:

[0173]

配准子模块110,用于对多时相图像进行图像配准;

[0174]

图像块获取子模块120,与所述配准子模块110通信连接,用于剪裁配准后的多时相图像成图像块;

[0175]

数据集获取子模块130,与所述图像块获取子模块120通信连接,用于随机打乱同一个地点不同时刻的图像块,每6个图像块横向拼接成一个多时相图像序列,获取多时相图像序列的数据集;

[0176]

划分子模块140,与所述数据集获取子模块130通信连接,用于按照预设比例,将数据集划分成训练集和测试集。

[0177]

基于同一发明构思,本技术实施例还提供了一种计算机可读存储介质,其上存储有计算机程序,计算机程序被处理器执行时实现上述方法的所有方法步骤或部分方法步骤。

[0178]

本发明实现上述方法中的全部或部分流程,也可以通过计算机程序来指令相关的硬件来完成,计算机程序可存储于一计算机可读存储介质中,该计算机程序在被处理器执行时,可实现上述各个方法实施例的步骤。其中,计算机程序包括计算机程序代码,计算机程序代码可以为源代码形式、对象代码形式、可执行文件或某些中间形式等。计算机可读介质可以包括:能够携带计算机程序代码的任何实体或装置、记录介质、u盘、移动硬盘、磁碟、光盘、计算机存储器、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、电载波信号、电信信号以及软件分发介质等。需要说明的是,计算机可读介质包含的内容可以根据司法管辖区内立法和专利实践的要求进行适当的增减,例如在某些司法管辖区,根据立法和专利实践,计算机可读介质不包括电载波信号和电信信号。

[0179]

基于同一发明构思,本技术实施例还提供一种电子设备,包括存储器和处理器,存储器上储存有在处理器上运行的计算机程序,处理器执行计算机程序时实现上述方法中的所有方法步骤或部分方法步骤。

[0180]

所称处理器可以是中央处理单元(central processing unit,cpu),还可以是其他通用处理器、数字信号处理器(digital signal processor,dsp)、专用集成电路(application specific integrated circuit,asic)、现成可编程门阵列(field-programmable gate array,fpga)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等。通用处理器可以是微处理器或者该处理器也可以是任何常规的处理器等,处理器是计算机装置的控制中心,利用各种接口和线路连接整个计算机装置的各个部分。

[0181]

存储器可用于存储计算机程序和/或模块,处理器通过运行或执行存储在存储器内的计算机程序和/或模块,以及调用存储在存储器内的数据,实现计算机装置的各种功能。存储器可主要包括存储程序区和存储数据区,其中,存储程序区可存储操作系统、至少一个功能所需的应用程序(例如声音播放功能、图像播放功能等);存储数据区可存储根据手机的使用所创建的数据(例如音频数据、视频数据等)。此外,存储器可以包括高速随机存取存储器,还可以包括非易失性存储器,例如硬盘、内存、插接式硬盘,智能存储卡(smart media card,smc),安全数字(secure digital,sd)卡,闪存卡(flash card)、至少一个磁盘存储器件、闪存器件、或其他易失性固态存储器件。

[0182]

本领域内的技术人员应明白,本发明的实施例可提供为方法、系统、服务器或计算机程序产品。因此,本发明可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本发明可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器和光学存储器等)上实施的计算机程序产品的形式。

[0183]

本发明是参照根据本发明实施例的方法、设备(系统)、服务器和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的

每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

[0184]

这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

[0185]

这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

[0186]

显然,本领域的技术人员可以对本发明进行各种改动和变型而不脱离本发明的精神和范围。这样,倘若本发明的这些修改和变型属于本发明权利要求及其等同技术的范围之内,则本发明也意图包含这些改动和变型在内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。