1.本发明涉及自然语言处理事件抽取领域,具体涉及一种基于多任务学习对非结构化文本中含有的事件信息进行结构化处理的方法,属于一种事件抽取方法。

背景技术:

2.自然语言作为是一种由人蓄意为某些特定目的而创造的语言,是区分人类和其他动物的本质特征。自然语言是人类的智慧结晶,人类绝大部分的知识是以语言文字为载体保存流传,文字作为语言的记录工具,它能够保存记录丰富的语义信息和特征内容,帮助人们记录和表达所想要传达的信息。如何让机器识别理解自然语言所记录的丰富语义特征是如今信息化时代科学家们重点研究的内容,自然语言处理学科应运而生,自然语言处理(natural language processing,nlp)是计算机科学领域与人工智能领域中的一个重要方向。它研究能实现人与计算机之间用自然语言进行有效通信的各种理论和方法。

3.事件抽取(event extraction,ee)是nlp领域中一种经典的信息抽取任务,在商业、军事等领域的情报工作中应用非常广泛。因此,事件抽取问题一直是热门的研究课题之一。事件抽取是要求我们用自动智能的方法从半结构化、非结构化数据中,将与我们的目标相关的事件的重要元素识别出来。具体来说,事件抽取技术是从非结构化信息中抽取出用户感兴趣的事件以及重要元素,并以结构化呈现给用户,这些用户感兴趣的事件可以是一段时间的天气,体育比赛情况,不和谐的行为和言论等等事件。通过获取的结构化事件文本,用户可以按照一定的序列对其进行分析,获取其中用户感兴趣的信息以及规律,例如,我们可以将一段时间开店的事件聚合起来,分析盈亏状况,进而了解其商业能力。规范化结构化文本是分析一类事件并得到某种信息规律的前提。因此对事件抽取技术展开研究是十分必要的。

4.事件抽取是要求我们用自动智能的方法从半结构化、非结构化数据中,将与我们的目标相关的事件的重要元素识别出来。所以事件抽取任务的直接目标,就是识别特定类型的事件,并把事件中担任既定角色的要素找出来。一般来说,我们会按照任务的需求,制定一个事件类型体系,并根据研究对象的特点,规定各类事件里重要的角色。任务类型体系和各类型事件的角色清单,就是我们的预测目标。

5.事件抽取的操作对象是事件,组成事件的各元素包括:触发词、事件类型和事件论元。事件触发词表示事件发生的核心词,多为动词或名词;事件类型则是该事件的类别;事件论元是事件的参与者,主要包括事件主体、事件客体、时间和地点等。事件抽取任务按元素划分可以分为事件触发词抽取、事件类型判断和事件论元抽取。

6.现有的事件抽取方法往往先进行事件纲要schema的设计,之后通过关键词匹配找到事件的触发词,再根据触发词对schema中的类别进行事件类别判断,最后进行事件论元抽取。这种方法有较高的准确性,但对于schema设计者的专业水平要求较高,且容易丢失信息,可移植性差。随着深度学习领域的发展,对于抽取事件触发词、类型和论元等信息的能力越来越强。但事件抽取对底层的子任务结果有很大的依赖性,由于实体识别、深层句法分

析等底层技术还不成熟,因此造成了误差传递;并且分段的抽取方法在数据量较大时抽取时间较长。如何利用事件各类信息之间的强相关性,提升事件抽取的准确性并减少时间成为事件抽取领域的一个重要研究点。

7.现有的事件抽取技术多采用分段抽取的方法,而忽略了事件抽取各子任务间的相关性。多任务学习是指能够结合相关联的两个或者多个任务之间共通的信息来得到更有泛化性的参数和特征的方法,另外,由于使用多任务学习训练的模型的一部分参数是共享的,在一定程度上弱化了网络能力,有效防止了过拟合。当前基于多任务学习的事件抽取方法大多利用事件触发词抽取任务和事件论元抽取任务来联合训练模型,而忽略了事件的分类信息,将事件分类任务引入事件抽取的联合训练过程,能够有效地提高事件抽取的准确率、召回率、f1值。

8.如何利用事件抽取各子任务共通的信息,结合多任务学习,提供一种准确率、召回率、f1值更高并且更加高效的事件抽取方法是本领域技术人员正在探讨的热点问题。

技术实现要素:

9.本发明要解决的技术问题是提供一种基于多任务学习的事件抽取方法。此方法基于深度学习的算法,利用多个相关联的对事件抽取有帮助的任务对事件抽取模型进行联合训练,并且利用任务之间蕴含的丰富的关联关系来提高事件抽取的准确率、召回率和f1值,实现当文本数量庞大时也能快速高效进行事件抽取的要求。

10.为解决上述技术问题,本发明技术方案是:构建由客户端、负样本数据库、事件筛选模块、特征提取模块、事件分类模块、事件触发词和论元抽取模块和事件信息整合器构成的事件抽取系统。然后选择“2020科大讯飞事件抽取挑战赛”发布的数据集作为事件筛选模块、特征提取模块、事件分类模块和事件触发词与论元抽取模块的训练集,利用多任务学习对特征提取模块、事件分类模块和事件触发词与论元抽取模块进行训练,得到这些模块的网络权重参数。最后采用训练后的事件抽取系统对事件进行事件筛选,判断是否是预定义类别的事件,如果是则进行特征提取、事件分类、事件触发词与论元抽取以及事件信息整合,最终得到事件的结构化信息;如果不是则丢弃当前事件。

11.本发明主要包括以下具体步骤:

12.第一步:构建事件抽取系统。事件抽取系统由客户端、负样本数据库、事件筛选模块、特征提取模块、事件分类模块、事件触发词与论元抽取模块和事件信息整合器组成。

13.客户端与事件筛选模块和事件信息整合器相连,将用户输入的事件文本x送入事件筛选模块和事件信息整合器。

14.负样本数据库存储由互联网等渠道获取的文本集合,包含p条文本,p为正整数且p>3000,与事件筛选模块相连。负样本数据库供事件筛选模块读取。负样本数据库中的文本集合d={d1,d2,...,d

p

,...,d

p

},d

p

表示d中第p个文本;表示d中第p个文本;n为正整数,d

p

表示长度为n的文本(以字符为单位,d

p

长度为n说明d

p

包含n个字符)。

15.事件筛选模块是基于cnn(卷积神经网络)的二分类器,由字符嵌入模块、cnn编码器和二分类器组成。字符嵌入模块选择北京师范大学和中国人民大学合作开源的中文字符向量(网址为:https://pan.baidu.com/s/1svfowfbknnlsqrf1t99lnw,2018-5-25,如有更

sequence tagging.”,用于序列标记的双向lstm-crf模型,arxiv,2015)和解码器crf(即条件随机场,见文献“conditional random fields:probabilistic models for segmenting and labeling sequencedata.”,条件随机场:用于分割和标记序列数据的概率模型,icml(international conferenceon machine learning),2001)网络构成。事件触发词与论元抽取模块从特征提取模块接收f(x),对f(x)进行下游编码和解码操作,得到x的预测序列标签y(x),y(x)={y

cls

,y1,y2,...,yn,...,yn,y

sep

},yn表示x中第n个字符xn的预测标签,将y(x)送入事件信息整合器,y

cls

表示“[cls]”的预测标签,y

sep

表示“[sep]”的预测标签。

[0019]

事件信息整合器与客户端、事件分类模块和事件触发词与论元抽取模块相连,从客户端接收用户输入的事件文本x,从事件分类模块获得v,从事件触发词与论元抽取模块获得y(x),将y(x)中各元素与x中的字符对应起来,获得事件的触发词(trigger)、事件主体(subiect)、事件客体(obiect)、事件时间(time)以及事件地点(location)等信息,将这些事件要素使用事件要素五元组e来表示,e=(list1,...,listb,...,list5)来表示,其中1≤b≤5,分别对应5个事件要素类别(trigger,subject,object,time,location)。结合v和e得到事件文本x的结构化信息,即对x事件抽取的结果s。

[0020]

第二步:准备训练事件抽取系统的数据集。数据集包括三部分,一是用来训练事件筛选模块的数据集,二是用来训练事件分类模块的数据集,三是用来训练事件触发词与论元抽取模块的数据集,方法是:

[0021]

2.1选择来自同一领域的数据集(如来自“2020科大讯飞事件抽取挑战赛”的事件抽取数据集,包含4000条标注样本(此时l=4000))作为原始训练集。每条标注样本包含一条文本x和其对应的实际标签t,每个实际标签t包含真实事件类别标签vv,以及真实事件要素标签ee,要求原始训练集中标注样本条数l为正整数且l>3000;

[0022]

2.2初始化负样本数据库。在互联网上爬取与数据集不相关领域的事件文本共p(p≥l)条,构成负样本数据库的文本集合d,d={d1,d2,...,d

p

,...,d

p

}(其中}(其中1≤n≤n,n为正整数,d

p

表示d中第p个长度为n的文本,以字符为单位,d

p

长度为n说明d

p

包含n个字符)。

[0023]

2.3构建事件筛选模块训练集。将原始训练集里的l条标注样本的每条事件文本添加标签“1”,得到事件筛选模块的正样本集合;将负样本数据库中的p(p≥l)条事件文本添加标签“0”,得到事件筛选模块的负样本集合;混合正样本集合和负样本集合,作为事件筛选模块的训练集。训练集包括事件文本集合以及对应事件文本的标签集合1≤o≤o,o为正整数,表示训练集样本共o个,o=l p,1≤o≤o,o为正整数,表示训练集样本共o个,o=l p,若为0,则表示不需要进一步抽取,若为1,则表示需要进一步抽取。

[0024]

2.4构建事件分类模块训练集。将原始训练集的l条标注样本作为初始训练集。事件分类模块训练集包括来自事件标注数据的事件文本集合x1,x2,...,x

l

,...,x

l

以及对应的真实事件类别标签vv1,vv2,...,vv

l

,...,vv

l

,1≤l≤l,,表示事件分类模块训练集样本共l个,共l个,表示第l个样本在第r种事件分类方式下的类别标签。

[0025]

2.5构建事件触发词与论元抽取模块训练集,事件触发词与论元抽取模块训练集

包括事件文本x1,x2,...,x

l

,...,x

l

以及对应的真实事件要素标签ee1,ee2,...,ee

l

,...,ee

l

,ee

l

=(trigger

l

,subject

l

,object

l

,time

l

,location

l

),为了训练方便,将ee

l

转化为序列标签y(x

l

)(序列标签y(x

l

)采用bioes标注方式,b表示要素头部标签,i表示要素中部标签,o表示非要素标签,e表示要素尾部标签,s表示单要素标签,每个标签还包含要素类型信息,分别以tr,s,o,ti,l表示事件触发词(trigger)、事件主体(subject)、事件客体(object)、事件时间(time)以及事件地点(location),如标签“b-tr”表示标签对应的字符为要素头部,且字符所在的要素属于事件触发词(trigger)),转化ee1,ee2,...,ee

l

,...,ee

l

得到l个真实事件要素的序列标签集合y(x1),y(x2),...,y(x

l

),...,y(x

l

)。

[0026]

第三步:使用事件筛选模块训练集对事件筛选模块进行训练,得到事件筛选模块的网络权重参数。具体方法如下:

[0027]

3.1初始化事件筛选模块的网络权重参数。将cnn编码器的网络权重参数集合w

cnn

中所有元素值都初始化为[0,1]之间的随机数;将二分类器的网络权重参数集合wd中所有元素值都初始化为[0,1]之间的随机数。

[0028]

3.2设置网络训练超参数,包括:网络模型学习率(leamingrate)、批处理尺寸(batchsize)、文本最大长度(maxlen)、随机种子(seed,实验中设置为2022),实验证明,令leamingrate=0.0005,batchsize=32,maxlen=512时,筛选的准确率最高。

[0029]

3.3迭代计算二分类器的输出分布与真实筛选模块标签分布的差距,得到损失值,最小化损失值并更新网络参数,直到满足迭代阈值要求,得到权重参数。具体方法如下:

[0030]

3.3.1初始化训练迭代参数itretation1=1;初始化迭代阈值epoch1为[1,30]内的整数,优选epoch1为10(此时事件筛选的准确率最高)。

[0031]

3.3.2事件筛选模块的字符嵌入模块使用开源的中文字符向量(网址为:https://pan.baidu.com/s/1svfowfbknnlsqrf1t99lnw,2018-05-25,如有更新则使用更新后的中文字符向量)对事件筛选模块训练集中的事件文本集合进行字符嵌入,得到事件文本集合的字符嵌入集合其中事件文本集合的字符嵌入集合的字符嵌入集合表示中第n个字符的字符嵌入;cnn编码器对字符嵌入集合进行编码,得到事件编码集合其中表示事件文本集合的编码;二分类器对事件编码集合进行分类,得到当前参数下网络模型对于标签预测的输出分布,使用分类模型常用的交叉熵损失函数计算预测的输出分布与真实标签集合的差距,得到损失值lossf,并使用adam优化算法(见文献“kingma d p,ba j.adam:a method for stochastic optimization[j].arxiv preprint arxiv:1412.6980,2014”,kingma的论文:adam,一种随机优化方法)对lossf最小化以更新一次w

cnn

和wd。

[0032]

3.3.3令itretationl=itretationl 1,如果itretation1≤迭代阈值epoch1,转3.3.2;否则说明训练满足迭代次数要求,训练结束,将训练后的w

cnn

作为cnn编码器的权重参数集合,将训练后的wd作为二分类器的权重参数集合,得到训练好的事件筛选模块,转第

四步。

[0033]

第四步:使用事件分类模块训练集和事件触发词与论元抽取模块训练集基于多任务学习对特征提取模块、事件分类模块和事件触发词与论元抽取模块进行联合训练,得到特征提取模块、事件分类模块和事件触发词与论元抽取模块的网络权重参数。具体方法如下:

[0034]

4.1初始化权重参数,使用哈尔滨工业大学发布的预训练模型参数(网址为:https://pan.baidu.com/s/1rk_qwqd7-wbtwycr91bmug,2019-09-08,如有更新,则使用更新后的参数)初始化特征提取模块的roberta预训练语言模型权重参数集合wr中的所有元素值;将事件分类模块的net1,net2,...,netr,...,netr的网络权重参数集合w

net

中所有元素都初始化为[0,1]之间的随机数;将事件触发词与论元抽取模块中的下游编码器bilstm网络权重参数集合wb中所有元素值都初始化为[0,1]之间的随机数;将事件触发词与论元抽取模块中的解码器crf网络权重参数集合w

crf

中所有元素值都初始化为[0,1]之间的随机数;

[0035]

4.2设置网络训练超参数,包括:roberta预训练语言模型学习率(learningrate-roberta)、其他网络模型学习率(learningrate-other),批处理尺寸(batchsize)、文本最大长度(maxlen)、损失平衡参数(α)、随机种子(seed,实验中设置为2022),实验证明,learningrate-roberta=0.00001,leamingrate-other=0.0002,batchsize=32,maxlen=512,α=0.3时,事件分类的准确率最高,事件要素信息抽取的f1值最高。

[0036]

4.3事件分类模块迭代计算r个分类模型(即net1,net2,...,netr,...,netr)的输出分布与r个真实事件类别标签集合vv1,vv2,...,vv

l

,...,vv

l

(其中(其中)的差距,得到损失值loss1,loss2,...,lossr,...,lossr;事件触发词与论元抽取模块计算事件触发词与论元抽取模块的输出分布与真实事件要素的序列标签集合y(x1),y(x2),...,y(x

l

),...,y(x

l

)的差距,得到损失值losse。总损失计算方式为loss=α(loss1 loss2 ... lossr

…

lossr) (1-α)losse,α是用来平衡两部分损失值的超参数,0<α<1,实验证明α=0.3时效果最好。最小化总损失值loss并更新网络参数,直到满足迭代次数要求,得到权重参数。具体方法如下:

[0037]

4.3.1初始化训练迭代参数itretation2=1;初始化迭代阈值epoch2为[1,30]内的整数,epoch2优选为15(此时事件分类的准确率最高,事件要素信息抽取的f1值最高);

[0038]

4.3.2特征提取模块从事件分类模块训练集读取接收事件文本集合x1,x2,...,x

l

,...,x

l

,使用roberta预训练语言模型对事件文本集合进行特征提取,得到事件文本每个字符的特征表示集合f(x1),f(x2),...,f(x

l

),...,f(x

l

)以及事件文本整体的特征表示集合ff(x1),ff(x2),...,ff(x

l

),...,ff(x

l

),其中f(x

l

)表示第l个事件文本x

l

中每个字符的特征表示,征表示,表示第l个事件文本x

l

中的第n个字符的特征表示,表示第l个事件文本集合x

l

的第一个特征表示,第l个事件文本集合x

l

的第二个特征表示;表示第l个事件文本x

l

整体的特征表示,表示向量拼接操作。

[0039]

4.3.3事件分类模块接收特征提取模块的整体特征表示集合ff(x1),ff(x2),...,ff(x

l

),...,ff(x

l

),采用多分类的交叉熵损失函数计算net1,net2,...,netr,...,netr的输出分布与r个真实事件类别标签集合vv1,vv2,...,vv

l

,...,vv

l

的差距,得到损失值loss1,loss2,...,lossr,...,lossr,其中第r种分类方式下的损失值,其中第r种分类方式下的损失值表示第l个事件文本x

l

的整体特征表示ff(x

l

)经过netr后得到的输出分布与第l个事件文本x

l

在第r种分类方式下的标签的损失;事件触发词与论元抽取模块从特征提取模块接收每个字符的特征表示集合,下游编码器bilstm进行编码,得到每个字符的下游编码集合,解码器crf对下游编码集合进行解码,得到当前参数下网络模型对于标签的输出分布,crf计算事件触发词与论元抽取模块的输出分布与真实事件要素标签集合y(x1),y(x2),...,y(x

l

),...,y(x

l

)的差距,得到损失值losse。

[0040]

4.3.4对事件分类模块得到的损失值loss1,loss2,...,lossr,...,lossr和事件触发词与论元抽取模块得到的损失值losse进行加权平均,得到特征提取模块、事件分类模块和事件触发词与论元抽取模块整体的损失loss=α(loss1 loss2 ... lossr ... lossr) losse,使用adam优化算法对整体损失loss最小化以更新一次wr、w

net

、wb和w

crf

。

[0041]

4.3.5令itretation2=itretation2 1,如果itretation2≤迭代阈值epoch2,转4.3.2;否则说明训练满足迭代次数要求,训练结束,将训练后的wr作为特征提取模块的roberta预训练语言模型的权重参数集合,将训练后的w

net

作为事件分类模块的net1,net2,...,netr,...,netr的权重参数集合,将训练后的wb作为事件触发词与论元抽取模块的bilstm网络的权重参数集合,将训练后的w

crf

作为事件触发词与论元抽取模块的crf的权重参数集合,得到训练好的特征提取模块、事件分类模块和事件触发词与论元抽取模块,转第五步。

[0042]

第五步,使用训练后的事件抽取系统对用户从客户端输入的文本x进行事件抽取,x表示长度为n的文本(以字符为单位,x长度为n说明x包含n个字符),x={x1,x2,...,xn,...,xn},xn表示文本x的第n个字符。具体方法为:

[0043]

5.1事件筛选模块对事件文本x进行筛选:事件筛选模块的字符嵌入模块使用开源的中文字符向量对x进行字符嵌入,得到x的字符嵌入em(x),;cnn编码器对字符嵌入em(x)进行编码,得到x的编码表示en(x),;二分类器对编码表示en(x)进行分类,得到x的价值(用户是否关心此类事件)判断u;若u=1,则说明x是用户关心的事件,需要对x进一步抽取信息,将x发送给特征提取模块,转5.2;若u=0,则说明x不是用户关心的事件,丢弃x,转第六步。

[0044]

5.2特征提取模块对文本x进行特征提取:训练后的roberta网络对x进行编码,得到x中每个字符的表示f(x)={f(x

cls

),f(x1),f(x2),...,f(xn),...,f(xn),f(x

sep

)}和x的整体特征信息ff(x),(x),表示向量拼接操作。将ff(x)送入事件分类模块,将f(x)送入事件触发词与论元抽取模块。

[0045]

5.3事件分类模块从特征提取模块接收ff(x),使用训练后的net1,net2,...,netr,...,netr按r个事件分类方式同时对ff(x)进行分类,得到r个事件分类结果集合v=(v1,v2,...,vr,...,vr),vr表示x在第r种事件分类方式下的类别,将v送入事件信息整合器;同时事件触发词与论元抽取模块从特征提取模块接收f(x),使用训练后的bilstm网络对f(x)进行下游编码并使用训练后的crf网络对下游编码的结果进行解码,得到x的事件要素

预测序列标签y(x),预测序列标签y(x),表示x中第n个字符xn的预测标签,将y(x)送入事件信息整合器。

[0046]

5.4事件信息整合器对x的v和y(x)进行整合,得到事件抽取结果s。具体方法如下:

[0047]

5.4.1将y(x)中x的首字符“[cls]”和尾字符“[sep]”的预测标签结果去除,保留长度为n的预测序列标签。

[0048]

5.4.2将y(x)与x对应,得到每个要素类别的要素列表。具体方法如下:

[0049]

5.4.2.1初始化包含5个空列表的五元组e,用e=(list1,...,listb,...,list5)表示,1≤b≤5,分别对应5个事件要素类别{t

r,

s,o,ti,l},其中tr表示触发词(trigger)、s表示事件主体(subject)、o表示事件客体(object)、ti表示事件时间(time)以及l表示事件地点(location),初始化变量n=1,初始化预测要素字符序列entity为空字符,entity用来暂时存储预测的要素字符序列。

[0050]

5.4.2.2如果n≤n,令n=n 1,转5.4.2.3;如果n>n,说明已经对全部标签进行了判别,得到了5个事件要素类别对应的事件要素列表,即对x中事件要素的识别结果,每个事件要素列表对应一个要素类别,一个事件要素列表中的所有要素为同一类别的要素,转5.4.3。

[0051]

5.4.2.3根据y(x)的第n个预测标签执行不同的操作。如果则表示为非要素标签,转5.4.2.2;如果是“b-tag”或“i-tag”的形式,其中tag∈{tr,s,o,ti,l},则表示为tag类事件要素的要素头部标签或tag类事件要素的要素中部标签,将对应的x中字符xn插入到entity尾部,转5.4.2.2;如果是“e-tag”或“s-tag”的形式,则表示为tag类事件要素的要素尾部标签或tag类事件要素的单要素标签,将对应的x中字符xn插入到entity尾部,并将entity加入tag类事件要素对应的事件要素列表listb中,之后令entity为空字符,转5.4.2.2。

[0052]

5.4.3将事件文本x的事件要素五元组e=(list1,...,listb,...,list5)与事件分类结果集合v进行结构化整合,得到事件文本x的事件抽取结果,使用一个词典s来表示,即类结果集合v进行结构化整合,得到事件文本x的事件抽取结果,使用一个词典s来表示,即其中list1表示x中触发词(trigger)要素的结果列表,list2表示x中主体(subject)要素的结果列表,list3表示x中客体(object)要素的结果列表,list4表示x中时间(time)要素的结果列表,list5表示x中地点(location)要素的结果列表,dec(r)表示第r种事件分类方式的描述,vr表示按照第r种事件分类方式进行分类时事件文本x的类别。

[0053]

第六步,结束。

[0054]

采用本发明可以达到以下技术效果:

[0055]

1.本发明第一步构建了一个完整的事件抽取系统,融合了负样本数据库、事件筛选模块、特征提取模块、事件分类模块、事件触发词与论元抽取模块和事件信息整合器。事件筛选模块基于cnn卷积神经网络模型构建,对事件文本的价值(用户是否关心此类事件)进行判断,能够以较小的代价避免对无关事件进行抽取;特征提取模块使用roberta预训练语言模型对输入文本进行特征提取,能够获得输入文本中深层次的知识;事件分类模块使用多个分类模型对事件按多种分类方式进行分类,能够充分挖掘数据隐含的信息并快速获

得文本多领域的分类属性;事件触发词与论元抽取模块将事件要素抽取建模为序列标注任务,一次性抽取所有的事件要素,避免了误差传递。

[0056]

2.本发明第四步采用多任务学习对特征提取模块、事件分类模块和事件触发词与论元抽取模块进行联合训练,事件分类模块和事件触发词与论元抽取模块共享了特征提取模块,占用内存量减少,通过共享信息,相互补充,优化模型,通过多任务之间不相关的部分的相互作用,有助于逃离局部极小值点;而多任务之间相关的部分则有利于底部共享层对通用特征表示的学习。

[0057]

3.本发明第二步通过获取互联网上的事件信息构建了一个负样本数据库,这个数据库能够使事件筛选模块更好区分哪些事件文本是有价值的,从而提升系统效率和事件抽取的准确率。

附图说明:

[0058]

图1为本发明第一步构建的事件抽取系统逻辑结构图。

[0059]

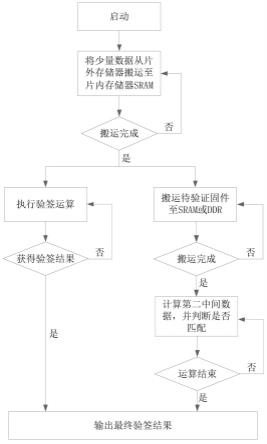

图2为本发明总体流程图。

[0060]

图3为本发明将事件分类任务引入事件抽取的联合训练过程对事件抽取整体精确率(precision)、召回率(recall)和f1值影响的示意图。

[0061]

图4为本发明训练事件筛选模块时负样本数量对事件筛选准确率的影响的示意图。

具体实施方式

[0062]

图2是本发明整体流程图;如图2所示,本发明包括以下步骤:

[0063]

第一步:构建事件抽取系统。事件抽取系统由客户端、负样本数据库、事件筛选模块、特征提取模块、事件分类模块、事件触发词与论元抽取模块和事件信息整合器组成。

[0064]

客户端与事件筛选模块和事件信息整合器相连,将用户输入的事件文本x送入事件筛选模块和事件信息整合器。

[0065]

负样本数据库存储由互联网等渠道获取的文本集合,包含p条文本,p为正整数且p>3000,与事件筛选模块相连。负样本数据库供事件筛选模块读取。负样本数据库中的文本集合d={d1,d2,...,d

p

,...,d

p

},d

p

表示d中第p个文本;表示d中第p个文本;n为正整数,d

p

表示长度为n的文本(以字符为单位,d

p

长度为n说明d

p

包含n个字符)。

[0066]

事件筛选模块是基于cnn(卷积神经网络)的二分类器,由字符嵌入模块、cnn编码器和二分类器组成。字符嵌入模块选择北京师范大学和中国人民大学合作开源的中文字符向量(网址为:https://pan.baidu.com/s/1svfowfbknnlsqrf1t99lnw,2018-5-25,如有更新则使用更新后的中文字符向量)对事件文本x进行字符嵌入,得到字符嵌入结果em(x)。cnn编码器共包含3个卷积层,1个池化层,共4层,卷积层为前3层,池化层为第4层,cnn编码器对字符嵌入结果em(x)进行编码,得到事件编码结果en(x)。二分类器为1个全连接层加1个归一化层,对编码结果en(x)进行全连接和归一化后得到一个2维向量,2维向量的和为1,将2维向量中较大值的索引作为事件文本的价值判断u(u∈{0,1})。事件筛选模块与客户端和特征提取模块相连,事件筛选模块从客户端接收用户输入的事件文本x,x={x1,x2,...,

xn,...,xn},其中1≤n≤n,n为正整数,x表示长度为n的文本(以字符为单位,x长度为n说明x包含n个字符),xn为x中的第n个字符,对x进行筛选,得到事件文本的价值(用户是否关心此类事件)判断u,若u=1,说明x是用户关心的事件,需要对x进一步抽取信息,将x输入发送给特征提取模块;若u=0,说明x不是用户关心的事件,丢弃x。

[0067]

特征提取模块与事件筛选模块、事件分类模块、事件触发词与论元抽取模块相连,当从事件筛选模块接收到事件文本x时,特征提取模块使用roberta预训练语言模型(见文献“roberta:a robustly optimized bert pretraining approach”,roberta:一种稳健优化的bert预训练方法,arxiv,2019)对事件文本x中的知识进行特征提取,得到x中n个字符的特征表示f(x)={f(x

cls

),f(x1),f(x2),...,f(xn),...,f(xn),f(x

sep

)},其中[cls]和[sep]为预训练语言模型特有的标识符,f(x

cls

)和f(x

sep

)分别表示[cls]和[sep]在x中的特征向量,因此,f(x)包含n 2个特征向量。使用f(x

cls

)和f(x

sep

)这两个标识符的特征向量表示x的整体特征信息ff(x),(x),表示向量拼接操作。将ff(x)送入事件分类模块,将f(x)送入事件触发词与论元抽取模块。

[0068]

事件分类模块与特征提取模块、事件触发词与论元抽取模块和事件信息整合器相连。令事件的分类方式集合为c,c={c1,c2,...,cr,...,cr},其中1≤r≤r,r为正整数,表示共有r种事件分类方式,cr表示第r种事件分类方式,其中1≤a≤a,a为正整数,表示第r种事件分类方式中共有a个类别(每个事件分类方式中包含的类别数量不一定一样,即a不是一个定值),表示第r种事件分类方式的第a个类别。事件分类模块包含r个分类模型,分别对应r个事件分类方式,r个分类模型表示为net1,net2,...,netr,...,netr,第r个分类模型netr包含一个全连接层和一个归一化层,对x的整体特征信息ff(x)进行全连接和归一化后得到一个a维向量,a维向量的和为1,得到a维向量中最大值的索引作为事件文本x在第r种事件分类方式下的类别vr(vr∈[0,a-1])。当从特征提取模块接收到ff(x)时,事件分类模块对r个事件分类方式同时进行分类,得到事件分类结果集合v=(v1,v2,...,vr,...,vr),其中vr表示事件文本x在第r种事件分类方式下的类别。将v送入事件信息整合器中。事件分类模块使用多个分类模型对事件按多种分类方式进行分类,能够充分挖掘数据隐含的信息并快速获得文本多领域的分类属性。

[0069]

事件触发词与论元抽取模块与特征提取模块和事件信息整合器相连。事件触发词与论元抽取模块需要抽取的要素有事件主体(subject)、事件客体(object)、事件触发词(trigger)、事件时间(time)和事件地点(location)等信息。将这些事件要素的抽取建模为序列标注任务,每种要素作为一个要素类别进行抽取,使用事件触发词与论元抽取模块一次性抽取所有的事件要素,避免误差传递。事件触发词与论元抽取模块由下游编码器bilstm网络(即双向长短时记忆循环网络,见文献“bidirectional lstm-crf models for sequence tagging.”,用于序列标记的双向lstm-crf模型,arxiv,2015)和解码器crf(即条件随机场,见文献“conditional random fields:probabilistic models for segmenting and labeling sequence data.”,条件随机场:用于分割和标记序列数据的概率模型,icml(international conference on machine learning),2001)网络构成。事件触发词与论元抽取模块从特征提取模块接收f(x),对f(x)进行下游编码和解码操作,得到x的预测序列标签y(x),y(x)={y

cls

,y1,y2,...,yn,...,yn,y

sep

},yn表示x中第n个字符xn的预测标签,将y

(x)送入事件信息整合器,y

cls

表示“[cls]”的预测标签,y

sep

表示“[sep]”的预测标签。

[0070]

事件信息整合器与客户端、事件分类模块和事件触发词与论元抽取模块相连,从客户端接收用户输入的事件文本x,从事件分类模块获得v,从事件触发词与论元抽取模块获得,将y(x)中各元素与x中的字符对应起来,获得事件的触发词(trigger)、事件主体(subject)、事件客体(object)、事件时间(time)以及事件地点(location)等信息,将这些事件要素使用事件要素五元组e来表示,e=(list1,...,listb,...,list5)来表示,其中1≤b≤5,分别对应5个事件要素类别(trigger,subject,object,time,location)。结合v和e得到事件文本x的结构化信息,即对x事件抽取的结果s。

[0071]

第二步:准备训练事件抽取系统的数据集。数据集包括三部分,一是用来训练事件筛选模块的数据集,二是用来训练事件分类模块的数据集,三是用来训练事件触发词与论元抽取模块的数据集,方法是:

[0072]

2.1选择来自同一领域的数据集(如来自“2020科大讯飞事件抽取挑战赛”的事件抽取数据集,包含4000条标注样本(此时l=4000))作为原始训练集。每条标注样本包含一条文本x和其对应的实际标签t,每个实际标签t包含真实事件类别标签vv,以及真实事件要素标签ee,要求原始训练集中标注样本条数l为正整数且l>3000;

[0073]

2.2初始化负样本数据库。在互联网上爬取与数据集不相关领域的事件文本共p(p≥l)条,构成负样本数据库的文本集合d,d={d1,d2,...,d

p

,...,d

p

}(其中}(其中n为正整数,dp表示d中第p个长度为n的文本,以字符为单位,dp长度为n说明dp包含n个字符)。

[0074]

2.3构建事件筛选模块训练集。将原始训练集里的l条标注样本的每条事件文本添加标签“1”,得到事件筛选模块的正样本集合;将负样本数据库中的p(p≥l)条事件文本添加标签“0”,得到事件筛选模块的负样本集合;混合正样本集合和负样本集合,作为事件筛选模块的训练集。训练集包括事件文本集合以及对应事件文本的标签集合1≤o≤o,o为正整数,表示训练集样本共o个,o=l p,1≤o≤o,o为正整数,表示训练集样本共o个,o=l p,为0,则表示不需要进一步抽取,若为1,则表示需要进一步抽取。

[0075]

2.4构建事件分类模块训练集。将原始训练集的l条标注样本作为初始训练集。事件分类模块训练集包括来自事件标注数据的事件文本集合x1,x2,...,x

l

,...,x

l

以及对应的真实事件类别标签vv1,vv2,...,vv

l

,...,vv

l

,1≤l≤l,,表示事件分类模块训练集样本共l个,共l个,表示第l个样本在第r种事件分类方式下的类别标签。

[0076]

2.5构建事件触发词与论元抽取模块训练集,事件触发词与论元抽取模块训练集包括事件文本x1,x2,...,x

l

,...,x

l

以及对应的真实事件要素标签ee1,ee2,...,ee

l

,...,ee

l

,ee

l

=(trigger

l

,subject

l

,object

l

,time

l

,location

l

),为了训练方便,将ee

l

转化为序列标签y(x

l

)(序列标签y(x

l

)采用bioes标注方式,b表示要素头部标签,i表示要素中部标签,o表示非要素标签,e表示要素尾部标签,s表示单要素标签,每个标签还包含要素类型信息,分别以tr,s,o,ti,l表示事件触发词(trigger)、事件主体(subject)、事件客体(object)、事件时间(time)以及事件地点(location),如标签“b-tr”表示标签对应的字符

为要素头部,且字符所在的要素属于事件触发词(trigger)),转化ee1,ee2,...,ee

l

,...,ee

l

得到l个真实事件要素的序列标签集合y(x1),y(x2),...,y(x

l

),...,y(x

l

)。

[0077]

第三步:使用事件筛选模块训练集对事件筛选模块进行训练,得到事件筛选模块的网络权重参数。具体方法如下:

[0078]

3.1初始化事件筛选模块的网络权重参数。将cnn编码器的网络权重参数集合w

cnn

中所有元素值都初始化为[0,1]之间的随机数;将二分类器的网络权重参数集合wd中所有元素值都初始化为[0,1]之间的随机数。

[0079]

3.2设置网络训练超参数,包括:网络模型学习率(learningrate)、批处理尺寸(batchsize)、文本最大长度(maxlen)、随机种子(seed,实验中设置为2022),实验证明,令learningrate=0.0005,batchsize=32,maxlen=512时,筛选的准确率最高。

[0080]

3.3迭代计算二分类器的输出分布与真实筛选模块标签分布的差距,得到损失值,最小化损失值并更新网络参数,直到满足迭代阈值要求,得到权重参数。具体方法如下:

[0081]

3.3.1初始化训练迭代参数itretation1=1;初始化迭代阈值epoch1为[1,30]内的整数,优选epoch1为10(此时事件筛选的准确率最高)。

[0082]

3.3.2事件筛选模块的字符嵌入模块使用开源的中文字符向量(网址为:https://pan.baidu.com/s/1svfowfbknnlsqrf1t99lnw,2018-05-25,如有更新则使用更新后的中文字符向量)对事件筛选模块训练集中的事件文本集合进行字符嵌入,得到事件文本集合的字符嵌入集合其中事件文本集合的字符嵌入集合的字符嵌入集合表示中第n个字符的字符嵌入;cnn编码器对字符嵌入集合进行编码,得到事件编码集合其中表示事件文本集合的编码;二分类器对事件编码集合进行分类,得到当前参数下网络模型对于标签预测的输出分布,使用分类模型常用的交叉熵损失函数计算预测的输出分布与真实标签集合的差距,得到损失值lossf,并使用adam优化算法(见文献“kingma d p,ba j.adam:a method for stochastic optimization[j].arxiv preprint arxiv:1412.6980,2014”,kingma的论文:adam,一种随机优化方法)对lossf最小化以更新一次w

cnn

和wd。

[0083]

3.3.3令itretation1=itretation1 1,如果itretation1≤迭代阈值epoch1,转3.3.2;否则说明训练满足迭代次数要求,训练结束,将训练后的w

cnn

作为cnn编码器的权重参数集合,将训练后的wd作为二分类器的权重参数集合,得到训练好的事件筛选模块,转第四步。

[0084]

第四步:使用事件分类模块训练集和事件触发词与论元抽取模块训练集基于多任务学习对特征提取模块、事件分类模块和事件触发词与论元抽取模块进行联合训练,得到特征提取模块、事件分类模块和事件触发词与论元抽取模块的网络权重参数。具体方法如下:

[0085]

4.1初始化权重参数,使用哈尔滨工业大学发布的预训练模型参数(网址为:

https://pan.baidu.com/s/1rk_qwqd7-wbtwycr91bmug,2019-09-08,如有更新,则使用更新后的参数)初始化特征提取模块的roberta预训练语言模型权重参数集合wr中的所有元素值;将事件分类模块的net1,net2,...,netr,...,netr的网络权重参数集合w

net

中所有元素都初始化为[0,1]之间的随机数;将事件触发词与论元抽取模块中的下游编码器bilstm网络权重参数集合wb中所有元素值都初始化为[0,1]之间的随机数;将事件触发词与论元抽取模块中的解码器crf网络权重参数集合w

crf

中所有元素值都初始化为[0,1]之间的随机数;

[0086]

4.2设置网络训练超参数,包括:roberta预训练语言模型学习率(learningrate-roberta)、其他网络模型学习率(learningrate-other),批处理尺寸(batchsize)、文本最大长度(maxlen)、损失平衡参数(α)、随机种子(seed,实验中设置为2022),实验证明,learningrate-roberta=0.00001,leamingrate-other=0.0002,batchsize=32,maxlen=512,α=0.3时,事件分类的准确率最高,事件要素信息抽取的f1值最高。

[0087]

4.3事件分类模块迭代计算r个分类模型(即net1,net2,...,netr,...,netr)的输出分布与r个真实事件类别标签集合vv1,vv2,...,vv

l

,...,vv

l

(其中(其中)的差距,得到损失值loss1,loss2,...,lossr,...,lossr;事件触发词与论元抽取模块计算事件触发词与论元抽取模块的输出分布与真实事件要素的序列标签集合y(x1),y(x2),...,y(x

l

),...,y(x

l

)的差距,得到损失值losse。总损失计算方式为loss=α(loss1 loss2 ... lossr ... lossr) (1-α)losse,α是用来平衡两部分损失值的超参数,0<α<1,实验证明α=0.3时效果最好。最小化总损失值loss并更新网络参数,直到满足迭代次数要求,得到权重参数。具体方法如下:

[0088]

4.3.1初始化训练迭代参数itretation2=1;初始化迭代阈值epoch2为[1,30]内的整数,epoch2优选为15(此时事件分类的准确率最高,事件要素信息抽取的f1值最高);

[0089]

4.3.2特征提取模块从事件分类模块训练集读取接收事件文本集合x1,x2,...,x

l

,...,x

l

,使用roberta预训练语言模型对事件文本集合进行特征提取,得到事件文本每个字符的特征表示集合f(x1),f(x2),...,f(x

l

),...,f(x

l

)以及事件文本整体的特征表示集合ff(x1),ff(x2),...,ff(x

l

),...,ff(x

l

),其中f(x

l

)表示第l个事件文本x

l

中每个字符的特征表示,征表示,表示第l个事件文本x

l

中的第n个字符的特征表示,表示第l个事件文本集合x

l

的第一个特征表示,第l个事件文本集合x

l

的第二个特征表示;表示第l个事件文本x

l

整体的特征表示,表示向量拼接操作。

[0090]

4.3.3事件分类模块接收特征提取模块的整体特征表示集合ff(x1),ff(x2),...,ff(x

l

),...,ff(x

l

),采用多分类的交叉熵损失函数计算net1,net2,...,netr,...,netr的输出分布与r个真实事件类别标签集合vv1,vv2,...,vv

l

,...,vv

l

的差距,得到损失值loss1,loss2,...,lossr,...,lossr,其中第r种分类方式下的损失值,其中第r种分类方式下的损失值表示第l个事件文本x

l

的整体特征表示ff(x

l

)经过netr后得到的输出分布与第l个事件文本x

l

在第r种分类方式下的标签的损失;事件触发词与论元抽取模块从特征提取模块接收每

个字符的特征表示集合,下游编码器bilstm进行编码,得到每个字符的下游编码集合,解码器crf对下游编码集合进行解码,得到当前参数下网络模型对于标签的输出分布,crf计算事件触发词与论元抽取模块的输出分布与真实事件要素标签集合y(x1),y(x2),...,y(x

l

),...,y(x

l

)的差距,得到损失值losse。

[0091]

4.3.4对事件分类模块得到的损失值loss1,loss2,...,lossr,...,lossr和事件触发词与论元抽取模块得到的损失值losse进行加权平均,得到特征提取模块、事件分类模块和事件触发词与论元抽取模块整体的损失loss=α(loss1 loss2 ... lossr ... lossr) losse,使用adam优化算法对整体损失loss最小化以更新一次wr、w

net

、wb和w

crf

。

[0092]

4.3.5令itretation2=itretation2 1,如果itretation2≤迭代阈值epoch2,转4.3.2;否则说明训练满足迭代次数要求,训练结束,将训练后的wr作为特征提取模块的roberta预训练语言模型的权重参数集合,将训练后的w

net

作为事件分类模块的net1,net2,...,netr,...,netr的权重参数集合,将训练后的wb作为事件触发词与论元抽取模块的bilstm网络的权重参数集合,将训练后的w

crf

作为事件触发词与论元抽取模块的crf的权重参数集合,得到训练好的特征提取模块、事件分类模块和事件触发词与论元抽取模块,转第五步。

[0093]

第五步,使用训练后的事件抽取系统对用户从客户端输入的文本x进行事件抽取,x表示长度为n的文本(以字符为单位,x长度为n说明x包含n个字符),x={x1,x2,...,xn,...,xn},xn表示文本x的第n个字符。具体方法为:

[0094]

5.1事件筛选模块对事件文本x进行筛选:事件筛选模块的字符嵌入模块使用开源的中文字符向量对x进行字符嵌入,得到x的字符嵌入em(x),;cnn编码器对字符嵌入em(x)进行编码,得到x的编码表示en(x),;二分类器对编码表示en(x)进行分类,得到x的价值(用户是否关心此类事件)判断u;若u=1,则说明x是用户关心的事件,需要对x进一步抽取信息,将x发送给特征提取模块,转5.2;若u=0,则说明x不是用户关心的事件,丢弃x,转第六步。

[0095]

5.2特征提取模块对文本x进行特征提取:训练后的roberta网络对x进行编码,得到x中每个字符的表示f(x)={f(x

cls

),f(x1),f(x2),...,f(xn),...,f(xn),f(x

sep

)}和x的整体特征信息ff(x),(x),表示向量拼接操作。将ff(x)送入事件分类模块,将f(x)送入事件触发词与论元抽取模块。

[0096]

5.3事件分类模块从特征提取模块接收ff(x),使用训练后的net1,net2,...,netr,...,netr按r个事件分类方式同时对ff(x)进行分类,得到r个事件分类结果集合v=(v1,v2,...,vr,...,vr),vr表示x在第r种事件分类方式下的类别,将v送入事件信息整合器;同时事件触发词与论元抽取模块从特征提取模块接收f(x),使用训练后的bilstm网络对f(x)进行下游编码并使用训练后的crf网络对下游编码的结果进行解码,得到x的事件要素预测序列标签y(x),预测序列标签y(x),表示x中第n个字符xn的预测标签,将y(x)送入事件信息整合器。

[0097]

5.4事件信息整合器对x的v和y(x)进行整合,得到事件抽取结果s。具体方法如下:

[0098]

5.4.1将y(x)中x的首字符“[cls]”和尾字符“[sep]”的预测标签结果去除,保留长度为n的预测序列标签。

[0099]

5.4.2将y(x)与x对应,得到每个要素类别的要素列表。具体方法如下:

[0100]

5.4.2.1初始化包含5个空列表的五元组e,用e=(list1,...,listb,...,list5)表示,1≤b≤5,分别对应5个事件要素类别{tr,s,o,ti,l},其中tr表示触发词(trigger)、s表示事件主体(subject)、o表示事件客体(object)、ti表示事件时间(time)以及l表示事件地点(location),初始化变量n=1,初始化预测要素字符序列entity为空字符,entity用来暂时存储预测的要素字符序列。

[0101]

5.4.2.2如果n≤n,令n=n 1,转5.4.2.3;如果n>n,说明已经对全部标签进行了判别,得到了5个事件要素类别对应的事件要素列表,即对x中事件要素的识别结果,每个事件要素列表对应一个要素类别,一个事件要素列表中的所有要素为同一类别的要素,转5.4.3。

[0102]

5.4.2.3根据y(x)的第n个预测标签执行不同的操作。如果则表示为非要素标签,转5.4.2.2;如果是“b-tag”或“i-tag”的形式,其中tag∈{tr,s,o,ti,l},则表示为tag类事件要素的要素头部标签或tag类事件要素的要素中部标签,将对应的x中字符xn插入到entity尾部,转5.4.2.2;如果是“e-tag”或“s-tag”的形式,则表示为tag类事件要素的要素尾部标签或tag类事件要素的单要素标签,将对应的x中字符xn插入到entity尾部,并将entity加入tag类事件要素对应的事件要素列表listb中,之后令entity为空字符,转5.4.2.2。

[0103]

5.4.3将事件文本x的事件要素五元组e=(list1,...,listb,...,list5)与事件分类结果集合v进行结构化整合,得到事件文本x的事件抽取结果,使用一个词典s来表示,即类结果集合v进行结构化整合,得到事件文本x的事件抽取结果,使用一个词典s来表示,即其中list1表示x中触发词(trigger)要素的结果列表,list2表示x中主体(subject)要素的结果列表,list3表示x中客体(object)要素的结果列表,list4表示x中时间(time)要素的结果列表,list5表示x中地点(location)要素的结果列表,dec(r)表示第r种事件分类方式的描述,vr表示按照第r种事件分类方式进行分类时事件文本x的类别。

[0104]

第六步,结束。

[0105]

图3为本发明将事件分类任务引入事件抽取的联合训练过程对事件抽取整体精确率(precision)、召回率(recall)和f1值影响的示意图。

[0106]

选择“2020科大讯飞事件抽取挑战赛”的验证集作为事件抽取测试集,实验的软件系统环境为乌班图18.04版本(即ubuntu18.04,linux系统的一个版本),搭载英特尔xeon gold系列6154中央处理器,处理频率为3.0hz,另外配有四块英伟达tesla v100显卡,每块显卡cuda核心数为5120个,显存容量为32gb。在本实验环境下,图3比较了本发明使用的事件分类模块和事件触发词与论元抽取模块联合抽取事件与分别抽取事件类别、事件触发词与论元(先抽取事件类别,再使用事件类别指导抽取事件触发词和论元:type argument;先抽取,再使用事件触发词和论元指导抽取事件类别:argument type)的精确率(precision)、召回率(recall)和f1值三种事件抽取任务常用的评价指标。其中精确率,即查准率,表示真正正确的占所有预测为正的比例;召回率,即查全率,表示真正正确的占所有实际为正的比例;f1值=精确率

×

召回率

×

2/(精确率 召回率),是对precision和

recall进行的整体评价。这三种评价指标越大,说明命名实体识别系统的性能越好。在本实验中,只有当事件分类和事件触发词与论元均正确时,才认为正确抽取出了事件。通过图3可以看出,分开进行事件分类和事件触发词与论元抽取时最好的f1值(type argument)为64.72,使用事件分类任务联合训练过程后f1值提升至65.84。由于本实验要求只有当事件的所有信息均正确时,才认为事件被正确抽取,因此f1值的提升相当可观,说明本发明采用的将事件分类任务引入事件抽取联合训练过程的方法是确实有效的。

[0107]

采用图3的实验环境,探究本发明训练事件筛选模块时负样本数量对事件筛选准确率的影响。具体来说,分别使用p=l/5=800、p=l/2=2000、p=l=4000、p=2l=8000和p=5l=20000个事件负样本结合l个事件正样本对事件筛选模块进行训练,并在使用测试集中进行测试。图4为本发明训练事件筛选模块时负样本数量对事件筛选准确率影响的示意图。

[0108]

图4中横坐标是训练事件筛选模块时负样本数量,纵坐标是事件筛选的准确率,准确率指判断正确的事件数量和所有事件数量的比值。从图4中可以看出,随着负样本数量的增多,模型看到的信息越多,学到的正样本和负样本之间的知识就越多,准确率也越来越好,当p≥l时可以达到90%以上,但当负样本数量超过一定数量时,准确率也会有下降。所以得出结论,本发明的事件筛选模块能够很好将有价值的事件筛选出来,从而在现实场景中快速高效地筛选事件。

[0109]

以上对本发明所提供的一种基于预训练语言模型的事件抽取方法进行了详细介绍。本文对本发明的原理及实施方式进行了阐述,以上说明用于帮助理解本发明的核心思想。应当指出,对于本技术领域的普通研究人员来说,在不脱离本发明原理的前提下,还可以对本发明进行若干改进和修饰,这些改进和修饰也落入本发明权利要求的保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。