1.本技术涉及计算机视觉以及车牌识别技术领域,特别是一种车牌图像角点检测模型训练方法、车牌脱敏方法及其设备。

背景技术:

2.随着科技的日益发展,在智能化技术的发展背景下,车辆的车牌检测识别技术也有了新的研究进展,是智能化技术交通管理的主要研究问题。但是目前的车牌识别技术主要是利用图像分割技术或目标检测技术,若是利用图像分割技术会存在图像分割模型内存占用大、分割耗时长、分割错误导致车牌识别错误等问题,若利用目标检测技术会存在由于矩形框与车牌不匹配、检测效果不佳等问题。

技术实现要素:

3.本技术提供一种车牌角点检测模型训练方法、车牌脱敏方法及其设备,通过训练一个基于车牌图像角点的检测模型训练方法,可以得到一个车牌图像角点检测模型,进而可以利用该车牌图像角点检测模型高准确度地检测出车牌图像的角点信息,并基于检测出的角点信息进行车牌脱敏。

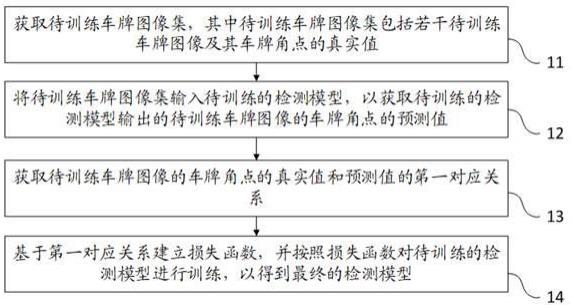

4.为了解决上述技术问题,本技术采用的一个技术方案是:提供一种基于车牌图像角点的检测模型训练方法,该方法包括:获取待训练车牌图像集,其中待训练车牌图像集包括若干待训练车牌图像及其车牌角点的真实值;将待训练车牌图像集输入待训练的检测模型,以获取待训练的检测模型输出的待训练车牌图像的车牌角点的预测值;获取待训练车牌图像的车牌角点的真实值和预测值的第一对应关系;基于第一对应关系建立损失函数,并按照损失函数对待训练的检测模型进行训练,以得到最终的检测模型。

5.其中,获取所训练车牌图像的车牌角点的真实值和预测值的第一对应关系,包括:获取真实值的第一维度信息和第二维度信息,以及预测值的第三维度信息和第四维度信息,其中第一维度信息和第三维度信息分别为与待训练车牌图像对应的目标框的中心点坐标、高度、宽度和置信度,第二维度信息和第四维度信息分别为与待训练车牌图像对应的目标框的左上角坐标、右上角坐标、左下角坐标和右下角坐标;基于真实值的第一维度信息和第二维度信息以及预测值的第三维度信息和第四维度信息,确定各待训练车牌图像的真实值和预测值的第一对应关系。

6.其中,损失函数为交并比损失函数、分类损失函数和关键点损失函数中的一种或多种的组合。

7.其中,按照损失函数对待训练的检测模型进行训练,以得到最终的检测模型,包括:固定待训练的检测模型中的一个或多个第一模型参数,按照损失函数对剩余的第二模型参数进行训练,得到第一检测模型;固定第一检测模型中的一个或多个第二模型参数,按照损失函数对第二模型参数进行训练,得到最终的检测模型。

8.其中,按照损失函数对第二模型参数进行训练,得到最终的检测模型,包括:按照

损失函数对第二模型参数进行训练,得到第二检测模型;将真实值和预测值的第一对应关系中的第一维度信息和第三维度信息剔除,得到真实值和预测值的第二对应关系;利用第二对应关系,按照损失函数对第二检测模型的模型参数进行训练,得到最终的检测模型。

9.其中,检测模型包括依次连接的骨干层、瓶颈层以及预测层。

10.其中,按照损失函数对待训练的检测模型进行训练,以得到最终的检测模型,包括:固定骨干层以及瓶颈层的模型参数;按照损失函数对待训练的检测模型中预测层的模型参数进行训练,以得到最终的检测模型。

11.为了解决上述技术问题,本技术采用的另一技术方案是:提供一种车牌脱敏方法,该车牌脱敏方法包括:将待脱敏的车牌图像输入预先训练的检测模型;获取检测模型输出的车牌角点,并基于车牌角点计算透视变换关系;基于透视变换关系对车牌图像进行脱敏处理。

12.其中,检测模型通过上述的检测模型训练方法训练所得。

13.其中,基于车牌角点计算透视变换关系,包括:获取线性变换矩阵、透视变换矩阵和图像平移矩阵;将线性变换矩阵、透视变换矩阵和图像平移矩阵,进行组合得到最终透视变换矩阵;利用最终透视变换矩阵对车牌角点进行计算,得到车牌角点透视变换后的透视变换关系,透视变换关系包括透视变换后的车牌角点。

14.其中,基于透视变换关系对车牌图像进行脱敏处理,包括:基于透视变换后的车牌角点,将掩码图像覆盖到车牌图像上的相应位置,达到脱敏效果。

15.为了解决上述技术问题,本技术采用的另一技术方案是:提供一种车牌脱敏设备,该车牌脱敏设备包括存储器和处理器,其中,存储器中存储有程序数据,处理器用于执行程序数据以实现如上述的基于车牌图像角点的检测模型训练方法或车牌脱敏方法。

16.为了解决上述技术问题,本技术采用的另一技术方案是:提供一种计算机可读存储介质,该计算机可读存储介质中存储有程序数据,该程序数据在被处理器执行时用于实现如上述基于车牌图像角点的检测模型训练方法或车牌脱敏方法。

17.本技术的有益效果是:区别于现有技术,本技术提供的基于车牌图像角点的检测模型的训练方法通过获取待训练车牌图像的真实角点和预测角点的对应关系,进一步基于该对应关系建立损失函数,并基于损失函数进行车牌图像角点检测模型训练,得到最终的基于车牌图像角点的检测模型训练模型。通过上述方式,可以得到车牌角点的检测模型,进而利用该车牌图像角点检测模型对车牌图像进行检测,得到车牌图像角点信息,并基于该车牌图像角点信息对车牌图像进行脱敏处理。

附图说明

18.为了更清楚地说明本技术实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。其中:图1是本技术提供的车牌图像角点检测模型训练方法第一实施例的流程示意图;图2是本技术提供的预测输出结构第一实施例的结构示意图;图3是图1所示车牌图像角点检测模型训练方法的步骤13一实施例的流程示意图;

图4是图1所示车牌图像角点检测模型训练方法的步骤14一实施例的流程示意图;图5是本技术提供的预测输出结构第二实施例的结构示意图;图6是本技术提供的车牌脱敏方法第一实施例的流程示意图;图7是图6所示车牌脱敏方法的步骤62一实施例的流程示意图;图8是本技术提供的车牌脱敏设备一实施例的结构示意图;图9是本技术提供的计算机可读存储介质一实施例的结构示意图。

具体实施方式

19.下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅是本技术的一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

20.参阅图1,图1是本技术提供的车牌图像角点检测模型训练方法第一实施例的流程示意图,该方法包括:步骤11:获取待训练车牌图像集,其中待训练车牌图像集包括若干待训练车牌图像及其车牌角点的真实值。

21.在一些实施例中,通过互联网图像库获取待训练车牌图像,如ccpd(chinese city parking dataset,中国城市车辆停车数据集),ccpd是一个大型的、多样化的、经过标注的中国城市车牌开源数据集,其包含了正常的车牌图像(二十几万张)、光线较暗或较亮的车牌图像(两万多张)、雨天或雪天或雾天的车牌图像(一万多张)、水平倾斜和/或垂直倾斜的车牌图像(两万多张)等,满足了模型训练的需求,利用该车牌数据集进行模型训练,可以得到一个能更好适应多场景的模型,提高模型的鲁棒性。

22.在其他实施例中,可以通过静态和动态两种方式采集待训练车牌图像,其中,静态指的是依靠地感线圈、红外或雷达等装置,当有车辆通过时这些装置时相机会接到一个触发信号,从而立刻抓拍一张图像;动态采集指的是在实时视频模式下进行,不需要其他感应装置给相机发送任何触发信号,完全依靠算法从实时的视频流图像中采集车辆信息。

23.步骤12:将待训练车牌图像集输入待训练的检测模型,以获取待训练的检测模型输出的待训练车牌图像的车牌角点的预测值。

24.在一些实施例中,检测模型输出的车牌角点的预测值是对应车牌图像的目标框,通过该目标框可以获取目标框左上角、右上角、左下角和右下角的坐标信息。

25.在一些实施例中,目标框的中心点坐标为(xc,yc),高度是h,宽度是w,置信度是a,目标框的左上角坐标是(x

lu

,y

lu

),右上角坐标是(x

ru

,y

ru

),左下角坐标是(x

lb

,y

lb

),右下角坐标是(x

rb

,y

rb

)。

26.在一些实施例中,参阅图2,图2是本技术提供的预测输出结构第一实施例的结构示意图,该预测输出结构20包括三个预测输出层,每一个预测层对应一个anchor(锚),即这三个预测分别是anchor1预测输出层201、anchor2预测输出层202和anchor3预测输出层203,检测模型输出的车牌角点的预测值可以通过预测输出结构20得到。

27.值得注意的是,anchor1预测输出层201、anchor2预测输出层202和anchor3预测输出层203都是单层预测输出层。

28.具体地,每一单层预测输出层中都包含4维向量、8维向量和1维向量。其中,4维向量指的是预测值中的目标框的中心点坐标、目标框的高度和目标框的宽度;8维向量指的是预测值中的目标框左上角、左下角、右上角和右下角的坐标信息;1维向量指的是置信度。

29.另外,每一单层预测输出层的高是y、宽是x(其中,x、y都是大于0的自然数,且x和y可以相同)。在一实施例中,高度和宽度所对应的数值表示分辨率,而预测输出层中的点对应原图像(如原始车牌图像)的像素位置,预测输出层的深度表示原图像对应的位置信息。

30.在一些实施例中,使用yolov5算法对待训练车牌图像进行目标检测,可以得到待训练车牌图像的目标框。

31.步骤13:获取待训练车牌图像的车牌角点的真实值和预测值的第一对应关系。

32.在一些实施例中,参阅图3,步骤13可以是以下流程:步骤31:获取真实值的第一维度信息和第二维度信息,以及预测值的第三维度信息和第四维度信息,其中第一维度信息和第三维度信息分别为与待训练车牌图像对应的目标框的中心点坐标、高度、宽度和置信度,第二维度信息和第四维度信息分别为与待训练车牌图像对应的目标框的左上角坐标、右上角坐标、左下角坐标和右下角坐标。

33.在一些实施例中,第一维度信息和第二维度信息属于真实值,第三维度信息和第四维度信息属于预测值。其中,真实值的目标框的中心点坐标是(x

c1

,y

c1

),高度是h1,宽度是w1,置信度是a1,左上角坐标是(x

lu1

,y

lu1

),右上角坐标是(x

ru1

,y

ru1

),左下角坐标是(x

lb1

,y

lb1

),右下角坐标是(x

rb1

,y

rb1

);预测值的目标框的中心坐标是(x

c2

,y

c2

),高度是h2,宽度是w2,置信度是a2,左上角坐标是(x

lu2

,y

lu2

),右上角坐标是(x

ru2

,y

ru2

),左下角坐标是(x

lb2

,y

lb2

),右下角坐标是(x

rb2

,y

rb2

)。

34.步骤32:基于真实值的第一维度信息和第二维度信息以及预测值的第三维度信息和第四维度信息,确定各待训练车牌图像的真实值和预测值的第一对应关系。

35.在一些实施例中,检测模型包括依次连接的骨干层(backbone)、瓶颈层(neck)以及预测层。其中,骨干层用于对待训练车牌图像进行特征提取,得到特征图,接着进入瓶颈层,瓶颈层中包含concat层,利用concat层对两个及以上的特征图按照在channel(通道)或num(数量)维度上进行拼接,并将不同分辨率的特征输入至预测层,预测层由不带bn(batch normalization)的单卷积层构成,待训练车牌图像经过预测层可以得到三个尺度(分辨率不同)的特征和特征深度c。

36.在一些实施例中,利用yolov5算法检测得到的待训练车牌图像的目标框,以及该目标框的高度h2和宽度w2基于anchor(锚)的数量为基础进行回归。

37.在一些实施例中,待训练车牌图像的特征深度的计算公式为:c=(5 8)*anchor_num。

38.其中,5指的是第三维度信息,8指的是第四维度信息,anchor的数量是anchor_num。

39.具体地,yolov5采用的匹配规则是:计算bbox(目标检测框)和当前层anchor的宽高比,若宽高比大于设定的阈值,则该anchor与bbox不匹配,丢弃该bbox,认为其为负样本;剩下的bbox,计算它落在哪个网格(利用特征提取网络对待训练车牌图像进行特征提取,得到若干个大小一致的特征图/网格图)内并寻找相邻的两个网格,认为这三个网格都可能是来预测该bbox的,基于此,一个bbox至少有3个anchor进行匹配。

40.在一些实施例中,anchor_num是3,即anchor1、anchor2和anchor3。

41.基于不同的anchor,通过以下方式获取各待训练车牌图像的真实值和预测值的第一对应关系(图未示):s1:获取某一anchor的高度anchor_h和宽度anchor_w,以得到(anchor_w,anchor_h)。

42.s2:获取真实值的中心点坐标(x

c1

,y

c1

)与预测值的中心点坐标(x

c2

,y

c2

)的偏移量x

c_o

和y

c_o

,以得到待训练车牌图像中心点坐标的真实值与预测值的第一对应关系为x

c1

= x

c2 σ(x

c_o

)和y

c1

= y

c2 σ(y

c_o

)。

43.s3:获取真实值与预测值之间的目标框的宽度、高度的第一对应关系,为w1=anchor_w*exp

w2

和h1=anchor_h*exp

h2

。

44.s4:获取真实值和预测值的目标框的左上角坐标、右上角坐标、左下角坐标和右下角坐标的第一对应关系,为x

lu1 =anchor_w*(σ(x

lu2

)-0.5)*4 x

c2

、y

lu1 =anchor_h*(σ(y

lu2

)-0.5)*4 y

c2

、x

ru1 =anchor_w*(σ(x

ru2

)-0.5)*4 x

c2

、y

ru1 =anchor_h*(σ(y

ru2

)-0.5)*4 y

c2

、x

lb1 =anchor_w*(σ(x

lb2

)-0.5)*4 x

c2

、y

lb1 =anchor_h*(σ(y

lb2

)-0.5)*4 y

c2

、x

rb1 =anchor_w*(σ(x

rb2

)-0.5)*4 x

c2

、y

rb1 =anchor_h*(σ(y

rb2

)-0.5)*4 y

c2

。

45.其中,σ是均方差。

46.步骤14:基于第一对应关系建立损失函数,并按照损失函数对待训练的检测模型进行训练,以得到最终的检测模型。

47.在一些实施例中,损失函数为交并比损失函数、分类损失函数和关键点损失函数中的一种或多种的组合。在一些实施例中,检测模型包括依次连接的骨干层、瓶颈层以及预测层。通过固定骨干层以及瓶颈层的模型参数,接着按照损失函数对待训练的检测模型中预测层的模型参数进行训练,可以得到最终的检测模型。

48.在一些实施例中,参阅图4,步骤14可以是以下流程:步骤41:固定待训练的检测模型中的一个或多个第一模型参数,按照损失函数对剩余的第二模型参数进行训练,得到第一检测模型。

49.在一些实施例中,交并比(intersection over union,iou)损失函数的计算公式是:是:是:是:在一些实施例中,分类损失函数的计算公式是:

其中,是一个one-hot向量,表示当前输出值为0或1,表示输出真实值的概率,表示目标类。

50.在一些实施例中,关键点损失函数的计算公式是:其中,x1表示真实值中的目标框左上角、左下角、右上角、右下角的横坐标信息,x2表示预测值中的目标框左上角、左下角、右上角、右下角的横坐标信息。

51.此时,总的损失函数为:其中,、和都是权重。

52.在一些实施例中,固定和,不断变化,在稳定时确定的取值;固定和,不断变化,在稳定时确定的取值;固定和,不断变化,在稳定时确定的取值。如,=0.25、=0.63、=0.12。

53.在一些实施例中,利用梯度下降算法减小总的损失函数,接着通过反向传播更新参数(权重)自动学习,以得到第一检测模型。

54.步骤42:固定第一检测模型中的一个或多个第二模型参数,按照损失函数对第二模型参数进行训练,得到最终的检测模型。

55.在一些实施例中,步骤42可以是以下流程(图未示):s1:按照损失函数对第二模型参数进行训练,得到第二检测模型。

56.s2:将真实值和预测值的第一对应关系中的第一维度信息和第三维度信息剔除,得到真实值和预测值的第二对应关系。

57.s3:利用第二对应关系,按照损失函数对第二检测模型的模型参数进行训练,得到最终的检测模型。

58.在一些实施例中,对模型进行剪枝处理,即将预测层的预测值中的目标框中心点坐标、宽度和高度剔除,以减少车牌图像角点检测模型的冗余,得到的交并比损失函数、分类损失函数和关键点损失函数的计算公式分别为:类损失函数和关键点损失函数的计算公式分别为:综上,总的损失函数为:

其中,和都是权重。

59.在一些实施例中,利用网络搜索策略,在小数集上确定和。

60.在一些实施例中,固定,不断变化,在稳定时确定的取值,固定,不断变化,在稳定时确定的取值。

61.在一些实施例中,利用梯度下降算法减小总的损失函数,接着通过反向传播更新参数(权重)自动学习,以得到第二检测模型。

62.在一些实施例中,参阅图5,图5是本技术提供的预测输出结构第二实施例的结构示意图,该预测输出结构50包括三个预测输出层,每一个预测层对应一个anchor(锚),即这三个预测分别是anchor1预测输出层501、anchor2预测输出层502和anchor3预测输出层503,检测模型输出的车牌角点的预测值可以通过预测输出结构50得到。

63.值得注意的是,anchor1预测输出层501、anchor2预测输出层502和anchor3预测输出层503都是单层预测输出层。

64.具体地,每一单层预测输出层中都包含8维向量和1维向量。其中, 8维向量指的是预测值中的目标框左上角、左下角、右上角和右下角的坐标信息;1维向量指的是置信度。

65.另外,每一单层预测输出层的高是y、宽是x(其中,x、y都是大于0的自然数,且x和y可以相同)。在一实施例中,高度和宽度所对应的数值都是分辨率,而预测输出层中的点对应原图像(如原始车牌图像)的像素位置,预测输出层的深度表示原图像对应的位置信息。

66.区别于现有技术,本技术提供的基于车牌图像角点的检测模型训练方法通过获取待训练车牌图像真实的角点信息和预测的角点信息的对应关系,进而基于该对应关系利用损失函数对待训练的检测模型进行训练,以得到最终的车牌图像角点检测模型。通过上述方式,利用损失函数进行训练可以减少车牌图像角点检测误差,进而可以得到一个高准确度的车牌图像角点检测模型。

67.参阅图6,图6是本技术提供的车牌脱敏方法第一实施例的流程示意图,该方法包括:步骤61:将待脱敏的车牌图像输入预先训练的检测模型。

68.具体地,预先训练的检测模型可以通过上述实施例获得。

69.步骤62:获取检测模型输出的车牌角点,并基于车牌角点计算透视变换关系。

70.在一些实施例中,透视变换关系的公式是:其中,为变换后的坐标,为原始坐标,为线性变换矩阵,为透视变换矩阵,为图像平移矩阵,s是一个与v2×1相关的缩放因子,一般情况下会通过归一化使得s=1。

71.在一些实施例中,参阅图7,步骤62可以包括以下流程:步骤71:获取线性变换矩阵、透视变换矩阵和图像平移矩阵。

72.步骤72:将线性变换矩阵、透视变换矩阵和图像平移矩阵,进行组合得到最终透视变换矩阵。

73.具体地,透视变换矩阵是。

74.步骤73:利用最终透视变换矩阵对车牌角点进行计算,得到车牌角点透视变换后的透视变换关系,透视变换关系包括透视变换后的车牌角点。

75.步骤63:基于透视变换关系对所述车牌图像进行脱敏处理。

76.在一些实施例中,基于透视变换后的车牌角点,将掩码图像覆盖到车牌图像上的相应位置,达到脱敏效果。

77.区别于现有技术,本技术提供的车牌脱敏方法利用预先训练好的车牌图像角点检测模型进行车牌脱敏,因车牌图像角点检测模型可以实现高准确度的车牌检测,进而进行车牌脱敏可以避免对图像覆盖面积过大的问题,以及解决了视觉效果差的问题。

78.参阅图8,图8是本技术提供的车牌脱敏设备一实施例的结构示意图,该车牌脱敏设备80包括存储器801和处理器802,存储器801用于存储程序数据,处理器802用于执行程序数据以实现如上述任一实施例的车牌图像角点检测模型训练方法或车牌脱敏方法,这里不再赘述。

79.参阅图9,图9是本技术提供的计算机可读存储介质一实施例的结构示意图,该计算机可读存储介质90存储有程序数据901,程序数据901在被处理器执行时用于实现如上述任一实施例的车牌图像角点检测模型训练方法或车牌脱敏方法,这里不再赘述。

80.综上所述,本技术可以通过训练得到基于车牌图像角点的检测模型,以及通过获取的基于车牌角点的检测模型获取车牌图像的角点信息,进而基于获取的角点信息进行车牌脱敏操作。

81.本技术涉及的处理器可以称为cpu(central processing unit,中央处理单元),可能是一种集成电路芯片,还可以是通用处理器、数字信号处理器(dsp)、专用集成电路(asic)、现场可编程门阵列(fpga)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件。

82.本技术使用的存储介质包括u盘、移动硬盘、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)或者光盘等各种可以存储程序代码的介质。

83.以上所述仅为本技术的实施方式,并非因此限制本技术的专利范围,凡是利用本技术说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的技术领域,均同理包括在本技术的专利保护范围内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。