一种融合位置和音频通用表征的双耳音频生成方法及系统

- 国知局

- 2024-06-21 11:40:15

本发明涉及音频还原领域,具体设计一种融合位置和音频通用表征的双耳音频生成方法及系统。

背景技术:

1、当人接收到双耳的声音输入后,大脑通过比较双耳音强差(interaural leveldifference,ild)和双耳时差(interaural time difference,itd)等信息,能够准确确定声音源的方向。这种听觉方向感知能力在现实世界中可以用于精确定位声音源的方向。在虚拟现实(vr)和增强现实(ar)的应用中,带有双耳立体声的视频可以使用户在视觉和听觉上深度融入虚拟环境,提升沉浸感。然而,由于录音设备的限制,大多数采集到的音视频数据通常包含的是单通道音频,因此如何把单通道音频有效转化为双耳立体声音频成为一个重要的研究方向。

2、伴随空间音频生成技术的进步,将同步的视频帧信息和单通道音频信息相结合,生成双通道立体声音频,为观众提供更加真实、沉浸且更具有交互性的立体声视听感官体验。

3、但在音频流方面,以往的方法主要是针对音频的复数谱特征进行提取和重建,复数谱是一种复杂的频域表示方法,它表示信号在频率域上的幅度和相位信息。其对整段音频进行静态展示,无法完全捕捉音频信号的时序模式和动态特性。深度学习模型能够自动学习音频数据中更抽象、更复杂的特征并生成通用表征,音频通用表征可以考虑音频信号在时间上的连续性和动态变化,有助于更准确地捕捉音频中的时序模式和演化趋势。

4、双耳音频可用于推断声源的位置,而不同位置的声源会导致我们在双耳体验中产生不同的听觉感知。在伴随视频帧的mono to binaural任务中,直接使用单耳音频进行双耳音频的预测是不可行的,因为神经网络难以学习到有效的掩膜(mask)信息。为解决这一问题,本发明采用单耳音频来预测双耳音频之间的差异,并通过单耳音频和双耳音频之间的差异进行双耳音频的还原。

技术实现思路

1、针对现有技术中的对于生成的掩模信息难以更有效地进行双耳音频的预测的技术问题,本技术提出了一种融合位置和音频通用表征的双耳音频生成方法及系统。

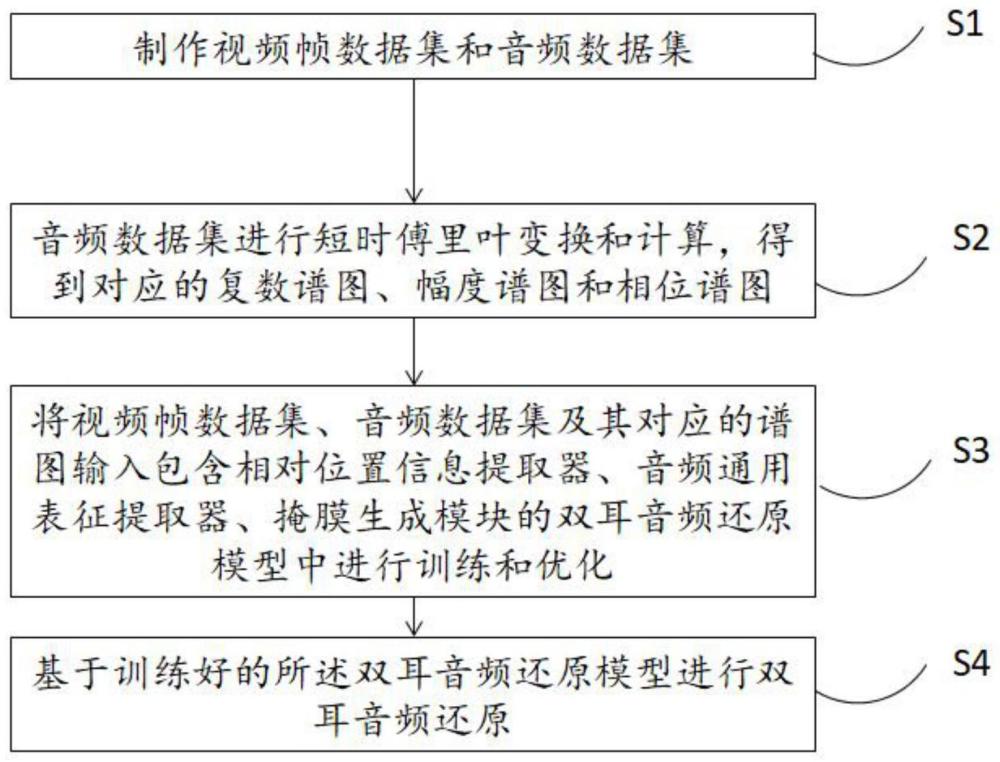

2、根据本发明的一方面,提出了一种融合位置和音频通用表征的双耳音频生成方法,包括:

3、s1,制作视频帧数据集和音频数据集;

4、s2,对音频数据集进行短时傅里叶变换和计算,得到对应的复数谱图、幅度谱图和相位谱图;

5、s3,将视频帧数据集、音频数据集及其对应的谱图输入包含相对位置信息提取器、音频通用表征提取器、掩膜生成模块的双耳音频还原模型中进行训练和优化;

6、s4,基于训练好的所述双耳音频还原模型进行双耳音频还原。

7、优选的,s1具体包括获取多个长度在一秒内的音频片段,并从对应视频片段中选取一个视频帧作为输入视频帧,制作视频帧数据集。

8、优选的,音频数据集包括混合音频数据集和差分音频数据集,获取音频片段对应的双耳音频左右通道音频数据xl和xr,对应相加得到混合音频数据xmono=xl+xr,制作混合音频数据集,对应相减得到差分音频数据xdiff=xl-xr,制作差分音频数据集。

9、进一步优选的,对所述混合音频数据和差分音频数据进行短时傅里叶变换和计算,得到对应的复数谱图smono和sdiff,计算差分音频xdiff的幅度谱图:

10、smag=||sdiff||2

11、计算差分音频xdiff的相位谱图:

12、

13、其中,real()算符表示取sdiff的实部,imag()算符表示取sdiff的虚部。

14、进一步优选的,s3所述的相对位置信息提取器为多层卷积神经网络构成的视觉图像预训练模型,其对视频帧中潜在的位置信息进行提取,得到视觉特征向量。

15、所述的音频通用表征提取器由语音预训练模型和多层降采样卷积神经网络组成,对混合音频数据的音频通用表征进行提取。

16、所述的掩膜生成模块分为编码器和解码器两个部分,将所述混合音频数据的复数谱图输入编码器中进行编码,获得混合音频数据的编码特征,将编码特征、音频通用表征和视觉特征向量按照通道维度拼接,输入解码器,得到掩膜。

17、优选的,s3中所述的步骤具体包括:

18、s31,视频帧数据输入相对位置信息提取器后,提取视觉特征向量fv;

19、s32,混合音频数据xmono输入音频通用表征提取器提取音频通用表征fa;

20、s33,混合音频数据的复数谱图smono输入掩膜生成模块的编码器后,经过n次降采样操作,每次降采样前的特征映射为i为升序。每次降采样的通道数加倍,并将最后一次降采样后的输出fen作为编码特征,与视觉特征向量fv、音频通用表征fa按照通道维度拼接为(fen,fa,fv);

21、s34,将拼接结果输入解码器中,进行n次上采样操作,每次上采样后的特征映射为i为降序,将每个与对应的按照通道维度拼接为接着将进行下一次上采样,每次上采样后的通道数减半,将最后一次的上采样输出作为生成的掩膜;

22、s35,将生成的掩膜与对应输入的smono相乘,得到预测的差分音频数据的复数谱图spre。

23、优选的,所述双耳音频还原模型采用的损失函数为l=α1lstft+α2lmag+a3lphs+α4lrec,其中,α1,α2,α3和α4根据经验设置,

24、

25、

26、

27、

28、其中,表示对欧几里得距离误差的平方求和,也称为l2损失。和是网络预测spre中得到的幅度谱图和相位谱图,srec和对应的公式如下所示:

29、srec=[smagcos(sphs),smagsin(sphs)]

30、

31、srec是由smag和sphs对复数谱图的虚部和实部进行重建,同样的是基于预测的和对复数谱图的虚部和实部进行重建。

32、进一步优选的,s4具体包括得到预测的差分音频数据的复数谱图spre后,通过短时傅里叶反变换得到预测的差分音频数据xpre,使用xpre和xmono还原左右双耳通道输入。

33、根据本发明的第二方面,提出了一种融合位置和音频通用表征的双耳音频生成系统,包括以下模块:

34、数据收集模块:用于制作视频帧数据集和音频数据集;

35、数据处理模块:用于对音频数据集进行短时傅里叶变换和计算,得到对应的复数谱图、幅度谱图和相位谱图;

36、模型训练模块:用于将视频帧数据集、音频数据集及其对应的谱图输入包含相对位置信息提取器、音频通用表征提取器、掩膜生成模块的双耳音频还原模型中进行训练和优化;

37、双耳通道音频预测模块:基于训练好的所述双耳音频还原模型进行双耳音频还原。

38、第三方面,本发明实施例提供了一种计算机可读介质,其上存储有计算机程序,所述计算机程序在被处理器执行时实施如第一方面中任一实施方式所述的方法。

39、第四方面,本发明实施例提供了一种计算系统,包括处理器和存储器,所述处理器被配置为执行如第一方面中任一实施方式所述的方法。

40、与现有技术相比,本发明的有益成果在于:

41、1.在视觉流中创建了一个相对位置信息提取器,用于提取视频帧中潜在的物体相对位置信息,且只有一个支路,在确保显著提升性能的同时减少视觉流网络的复杂性。

42、2.在音频流方面,本发明增加了一个音频通用表征提取器用于提取音频通用表征,结合音频原始复数谱特征,促进了系统性能的进一步提升。综上所述,本发明提出的网络模型能够有效提取视频帧中声音源的相对位置信息,获得更有效的音频通用表征,用于引导双耳音频的生成,从而提升系统性能。

本文地址:https://www.jishuxx.com/zhuanli/20240618/22802.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表