语音增强方法、装置、电子设备和计算机可读存储介质与流程

- 国知局

- 2024-06-21 11:55:47

本公开涉及计算机,特别涉及一种语音增强方法、装置、电子设备和计算机可读存储介质。

背景技术:

1、在各种语音应用环境中,常常因为使用人所处环境嘈杂,造成语音的背景噪音较大,导致体验感受差的情况。例如,在视频会议场景中,存在相互交流时听到对方回声的现象,导致交流不顺;在智能家居场景中,会因为家居噪声,而出现对某些智能家居控制不流畅的现象;在听障患者的助听场景中,当处于吵闹的环境中时,往往助听设备在增大语音音量的同时夹杂的噪音也被放大,导致在嘈杂环境中难以与他人进行正常交流沟通的情况。

2、因此,如何对夹杂噪音和回声的语音进行增强,以消除噪音和回声,便成为亟待解决的问题。

技术实现思路

1、有鉴于此,本公开提供一种语音增强方法、装置、电子设备和计算机可读存储介质,实现仅采用一个语音增强模型同时消除语音数据中的噪声和回声的目的。

2、本公开的技术方案是这样实现的:

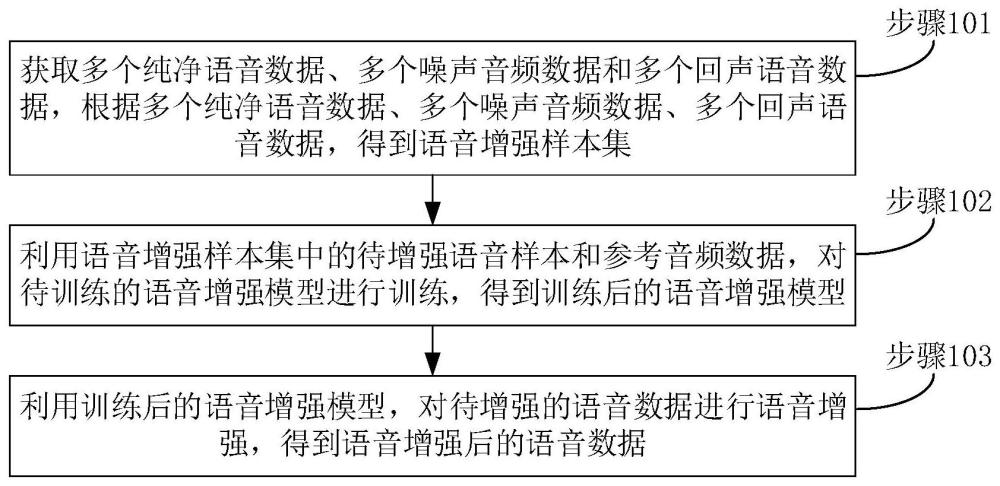

3、一种语音增强方法,包括:

4、获取多个纯净语音数据、多个噪声音频数据和多个回声语音数据,根据多个所述纯净语音数据、多个所述噪声音频数据、多个所述回声语音数据,得到语音增强样本集,其中,所述语音增强样本集包括待增强语音样本、与所述待增强语音样本相关联的参考音频数据、与所述待增强语音样本相关联的纯净语音数据,其中所述待增强语音样本包括含有噪声的待增强语音样本、含有回声的待增强语音样本、含有噪声和回声的待增强语音样本,其中,所述回声语音数据为通过采集扬声器播放的语音而得到的语音数据;

5、利用所述语音增强样本集中的所述待增强语音样本和所述参考音频数据,对待训练的语音增强模型进行训练,得到训练后的语音增强模型;

6、利用所述训练后的语音增强模型,对待增强的语音数据进行语音增强,得到语音增强后的语音数据。

7、进一步,所述根据多个所述纯净语音数据、多个所述噪声音频数据、多个所述回声语音数据,得到语音增强样本集,包括:

8、分别将多个所述纯净语音数据中的任意一个所述纯净语音数据与多个所述噪声音频数据中的任意一个所述噪声音频数据,采用不同的信噪比进行一对一叠加,得到多个所述含有噪声的待增强语音样本;

9、分别将多个所述纯净语音数据中的任意一个所述纯净语音数据,与进行增益处理和混响处理后的多个所述回声语音数据中的任意一个所述回声语音数据进行一对一叠加,得到多个所述含有回声的待增强语音样本;

10、分别将多个所述纯净语音数据中的任意一个所述纯净语音数据与多个所述噪声音频数据中的任意一个所述噪声音频数据,采用不同的信噪比进行一对一叠加,并与进行增益处理和混响处理后的多个所述回声语音数据中的任意一个所述回声语音数据进行一对一叠加,得到多个所述含有噪声和回声的待增强语音样本。

11、进一步,所述语音增强模型包括特征提取模块和增强模块,其中,所述增强模块包括n个语音增强结构,n≥1,每个所述语音增强结构包括宏观增强子结构、微观增强子结构和增益子结构;

12、所述利用所述语音增强样本集中的所述待增强语音样本和所述参考音频数据,对待训练的语音增强模型进行训练,得到训练后的语音增强模型,包括:

13、从所述语音增强样本集中获取任意一个待增强语音样本,将所述任意一个待增强语音样本从时域数据形式转换至频域数据形式,并从频域数据形式中得到所述任意一个待增强语音样本的实部数据和虚部数据;

14、从所述语音增强样本集中获取与所述任意一个待增强语音样本相关联的参考音频数据,将所述参考音频数据从时域数据形式转换至频域数据形式,并从频域数据形式中得到所述参考音频数据的实部数据和虚部数据;其中,若所述任意一个待增强语音样本为所述含有噪声的待增强语音样本,则所述参考音频数据为静音音频数据;若所述任意一个待增强语音样本为所述含有回声的待增强语音样本,或者若所述任意一个待增强语音样本为所述含有噪声和回声的待增强语音样本,则所述参考音频数据为用于送入所述扬声器进行所述播放的纯净语音数据;

15、将所述任意一个待增强语音样本的实部数据和虚部数据、以及所述参考音频数据的实部数据和虚部数据输入所述特征提取模块,通过所述特征提取模块得到音频特征数据,所述音频特征数据同时含有所述任意一个待增强语音样本的特征和所述参考音频数据的特征;

16、将所述音频特征数据输入每一个所述语音增强结构中的宏观增强子结构和微观增强子结构;

17、将所述任意一个待增强语音样本的实部数据和虚部数据输入所述n个语音增强结构中的第1个语音增强结构中的宏观增强子结构和微观增强子结构,通过所述第1个语音增强结构中的宏观增强子结构得到第1实部增强数据和第1虚部增强数据,通过所述第1个语音增强结构中的微观增强子结构得到第1实部微调数据和第1虚部微调数据;

18、将所述任意一个待增强语音样本的实部数据和虚部数据、所述第1实部增强数据和第1虚部增强数据、所述第1实部微调数据和第1虚部微调数据输入所述第1个语音增强结构中的增益子结构,通过所述第1个语音增强结构中的增益子结构得到第1实部增益数据和第1虚部增益数据;

19、将所述n个语音增强结构中的第q-1个语音增强结构中的增益子结构得到的第q-1实部增益数据和第q-1虚部增益数据输入所述n个语音增强结构中的第q个语音增强结构中的宏观增强子结构和微观增强子结构,通过所述第q个语音增强结构中的宏观增强子结构得到第q实部增强数据和第q虚部增强数据,通过所述第q个语音增强结构中的微观增强子结构得到第q实部微调数据和第q虚部微调数据,其中,1<q≤n;

20、将所述第q-1实部增益数据和第q-1虚部增益数据、所述第q实部增强数据和第q虚部增强数据、所述第q实部微调数据和第q虚部微调数据输入所述第q个语音增强结构中的增益子结构,通过所述第q个语音增强结构中的增益子结构得到第q实部增益数据和第q虚部增益数据;

21、将所述n个语音增强结构中的第n个语音增强结构中的增益子结构得到的第n实部增益数据和第n虚部增益数据,作为所述语音增强模型的输出数据;

22、从所述语音增强样本集中获取与所述任意一个待增强语音样本相关联的纯净目标语音数据,将所述纯净目标语音数据从时域数据形式转换至频域数据形式,并从频域数据形式中得到所述纯净目标语音数据的实部数据和虚部数据,其中,所述纯净目标语音数据为用于得到所述任意一个待增强语音样本所使用的纯净语音数据;

23、根据每一个所述语音增强结构得到的实部增益数据、虚部增益数据和输出幅度,以及所述纯净目标语音数据的实部数据、虚部数据和幅度,构建所述语音增强模型的损失函数;

24、根据所述语音增强模型的损失函数对所述语音增强模型中的参数进行调整,得到第一子训练后的语音增强模型;

25、将所述第一子训练后的语音增强模型确定为所述训练后的语音增强模型。

26、进一步,所述利用所述语音增强样本集中的所述待增强语音样本和所述参考音频数据,对待训练的语音增强模型进行训练,得到训练后的语音增强模型,包括:

27、利用所述语音增强样本集中的所述待增强语音样本和所述参考音频数据,对待训练的语音增强模型进行第一子训练,得到第一子训练后的语音增强模型;

28、将所述第一子训练后的语音增强模型和待训练的分类网络组成生成式对抗网络;

29、利用所述语音增强样本集中的所述待增强语音样本、所述参考音频数据、所述纯净语音数据,对所述生成式对抗网络中的所述待训练的分类网络进行第二子训练,得到第二子训练后的分类网络;

30、利用所述语音增强样本集中的所述待增强语音样本、所述参考音频数据,对所述生成式对抗网络中的所述第一子训练后的语音增强模型进行微调子训练,得到微调子训练后的语音增强模型,其中,在进行所述微调子训练的过程中,不更新所述第二子训练后的分类网络中的参数,仅更新所述第一子训练后的语音增强模型中的参数;

31、将所述微调子训练后的语音增强模型确定为所述训练后的语音增强模型。

32、进一步,所述利用所述语音增强样本集中的所述待增强语音样本、所述参考音频数据、所述纯净语音数据,对所述生成式对抗网络中的所述待训练的分类网络进行第二子训练,得到第二子训练后的分类网络,包括:

33、从所述语音增强样本集中获取任意一个待增强语音样本,将所述任意一个待增强语音样本从时域数据形式转换至频域数据形式,并从频域数据形式中得到所述任意一个待增强语音样本的实部数据和虚部数据;

34、从所述语音增强样本集中获取与所述任意一个待增强语音样本相关联的参考音频数据,将所述参考音频数据从时域数据形式转换至频域数据形式,并从频域数据形式中得到所述参考音频数据的实部数据和虚部数据;其中,若所述任意一个待增强语音样本为所述含有噪声的待增强语音样本,则所述参考音频数据为静音音频数据;若所述任意一个待增强语音样本为所述含有回声的待增强语音样本,或者若所述任意一个待增强语音样本为所述含有噪声和回声的待增强语音样本,则所述参考音频数据为用于送入所述扬声器进行所述播放的纯净语音数据;

35、将所述任意一个待增强语音样本的实部数据和虚部数据、以及所述参考音频数据的实部数据和虚部数据输入所述第一子训练后的语音增强模型,通过所述第一子训练后的语音增强模型,得到第一子训练后的语音增强模型的输出数据;

36、将所述第一子训练后的语音增强模型的输出数据,输入所述待训练的分类网络,通过所述待训练的分类网络,得到第一概率值;

37、从所述语音增强样本集中获取关联于所述任意一个待增强语音样本的纯净语音数据,将所述纯净语音数据从时域数据形式转换至频域数据形式,并从频域数据形式中得到所述纯净语音数据的实部数据和虚部数据;

38、将所述纯净语音数据的实部数据和虚部数据输入所述待训练的分类网络,通过所述待训练的分类网络,得到第二概率值;

39、根据所述第一概率值和所述第二概率值,构建所述分类网络的损失函数;

40、根据所述分类网络的损失函数对所述分类网络中的参数进行调整,得到所述第二子训练后的分类网络。

41、进一步,所述利用所述语音增强样本集中的所述待增强语音样本、所述参考音频数据,对所述生成式对抗网络中的所述第一子训练后的语音增强模型进行微调子训练,得到微调子训练后的语音增强模型,包括:

42、从所述语音增强样本集中获取任意一个待增强语音样本,将所述任意一个待增强语音样本从时域数据形式转换至频域数据形式,并从频域数据形式中得到所述任意一个待增强语音样本的实部数据和虚部数据;

43、从所述语音增强样本集中获取与所述任意一个待增强语音样本相关联的参考音频数据,将所述参考音频数据从时域数据形式转换至频域数据形式,并从频域数据形式中得到所述参考音频数据的实部数据和虚部数据;其中,若所述任意一个待增强语音样本为所述含有噪声的待增强语音样本,则所述参考音频数据为静音音频数据;若所述任意一个待增强语音样本为所述含有回声的待增强语音样本,或者若所述任意一个待增强语音样本为所述含有噪声和回声的待增强语音样本,则所述参考音频数据为用于送入所述扬声器进行所述播放的纯净语音数据;

44、将所述任意一个待增强语音样本的实部数据和虚部数据、以及所述参考音频数据的实部数据和虚部数据输入所述第一子训练后的语音增强模型,通过所述第一子训练后的语音增强模型,得到第一子训练后的语音增强模型的输出数据;

45、将所述第一子训练后的语音增强模型的输出数据,输入所述第二子训练后的分类网络,通过所述第二子训练后的分类网络,得到第三概率值;

46、根据所述第三概率值构建所述语音增强模型的微调损失函数;

47、根据所述语音增强模型的微调损失函数对所述第一子训练后的语音增强模型中的参数进行调整,得到所述微调子训练后的语音增强模型。

48、进一步,所述利用所述训练后的语音增强模型,对待增强的语音数据进行语音增强,得到语音增强后的语音数据,包括:

49、获取所述待增强的语音数据,将所述待增强的语音数据从时域数据形式转换至频域数据形式,并从频域数据形式中得到所述待增强的语音数据的实部数据和虚部数据;

50、将所述待增强的语音数据的实部数据和虚部数据输入所述训练后的语音增强模型,通过所述训练后的语音增强模型,得到关联于所述待增强的语音数据的输出数据;

51、将关联于所述待增强的语音数据的输出数据转换至时域数据形式,得到所述语音增强后的语音数据。

52、进一步,所述从时域数据形式转换至频域数据形式,采用短时傅里叶变换stft实现。

53、一种语音增强装置,包括:

54、样本获得模块,被配置为执行获取多个纯净语音数据、多个噪声音频数据和多个回声语音数据,根据多个所述纯净语音数据、多个所述噪声音频数据、多个所述回声语音数据,得到语音增强样本集,其中,所述语音增强样本集包括待增强语音样本、与所述待增强语音样本相关联的参考音频数据、与所述待增强语音样本相关联的纯净语音数据,其中所述待增强语音样本包括含有噪声的待增强语音样本、含有回声的待增强语音样本、含有噪声和回声的待增强语音样本,其中,所述回声语音数据为通过采集扬声器播放的语音而得到的语音数据;

55、训练模块,被配置为执行利用所述语音增强样本集中的所述待增强语音样本和所述参考音频数据,对待训练的语音增强模型进行训练,得到训练后的语音增强模型;

56、语音增强模块,被配置为执行利用所述训练后的语音增强模型,对待增强的语音数据进行语音增强,得到语音增强后的语音数据。

57、一种电子设备,包括:

58、处理器;

59、用于存储所述处理器的可执行指令的存储器;

60、其中,所述处理器被配置为执行所述可执行指令,以实现如上任一项所述的语音增强方法。

61、一种计算机可读存储介质,当所述计算机可读存储介质中的至少一条指令被电子设备的处理器执行时,使得所述电子设备能够实现如上任一项所述的语音增强方法。

62、从上述方案可以看出,本公开提供一种语音增强方法、装置、电子设备和计算机可读存储介质,利用分别包含噪音、回声以及同时包含噪音和回声的待增强语音样本对语音增强模型进行训练,使得语音增强模型同时具有分析噪音和回声的能力,从而利用训练后的语音增强模型实现了语音降噪和回声消除,达到了良好的消噪和消回声的效果,在进一步的方案中,结合生成式对抗网络对语音增强模型进行微调,使得语音增强模型同时对噪音和回声的分析能力进一步增强,从而利用微调后的语音增强模型实现了理想的语音降噪和回声消除,并且不会对语音造成失真,并且,由于仅采用一个语音增强模型便能够实现消噪和消回声的目的,因此也大大降低了系统复杂度。

本文地址:https://www.jishuxx.com/zhuanli/20240618/24530.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。