基于提示学习的测绘领域小样本命名实体识别方法及设备

- 国知局

- 2024-07-31 23:07:16

本发明涉及自然语言处理领域,更具体地指一种基于提示学习的测绘领域小样本命名实体识别方法及设备。

背景技术:

1、命名实体识别(named entity recognition,ner)是自然语言处理中的一个重要任务,它的目的是从文本中识别出具有特定意义的实体。随着人工智能技术的不断发展,ner已经在多个领域得到广泛应用,如智能客服、搜索引擎、信息抽取等。但是在训练数据少的低资源场景下,ner的表现通常会受到限制,因为这些场景下训练数据很少,模型难以学习到足够的语言规律和特征。此外,低资源场景下数据的质量也很难保证,这可能会影响模型的准确性和鲁棒性。因此,如何在低资源场景下设计一个高效准确的ner模型是非常有挑战性的。

2、现有的小样本命名实体识别方法主要分为基于原型的方法和基于元学习的方法。snell等提出使用原型网络做为目标类别学习原型表示。之后,该方法被引入到小样本ner任务中。yang等提出了structshot,它使用预训练的语言模型作为特征提取器,并在推理时执行维特比解码。das等提出了基于对比学习的container。该方法在度量学习框架下优化了表征的高斯分布嵌入的距离。

3、尽管有最近的研究进展,但小样本ner仍存在一些关键挑战。首先,如上所述,基于原型的方法通过计算查询集中每个标记与原型向量之间的相似度来进行分类,计算效率高但无法考虑句子间的语义关系。而基于元学习的方法可以考虑句子间的语义关系,但计算效率较低且需要更多的训练数据来训练元学习器。

4、近年来,基于预训练语言模型的提示学习(prompt-learning)方法也逐渐成为小样本命名实体识别任务的研究热点。这种方法的核心思想是通过利用提示信息来指导模型的训练和推断过程,从而提高模型在低资源场景下的性能。具体来说,通过将命名实体识别任务转化为预测一个特定的提示词,在不使用复杂的模板构建过程的同时,仍然保持了预训练模型的词预测范例,可以在少量的样本中完成命名实体识别任务。同时,这种方法也可以自动搜索适合预训练模型适应的标签词,进一步提高了模型的性能。与基于原型的方法和基于元学习的方法相比,基于prompt的方法既具有高效的计算速度,又具有良好的准确性和鲁棒性,因此在小样本命名实体识别任务中被广泛使用。

5、但是,这种手动设计模板来预测句子中每个文本片段的实体类型的方法可能会受到实体跨度检测引起的错误传播、须枚举所有可能的文本片段而导致高成本、因省略句子中标记之间的相互依赖造成模型识别结果不准确等问题的困扰。例如,ding等展示了在给定实体跨度的情况下使用结构为“[entity span]是[mask]”的提示进行实体类型预测的有效性。然而,当实体跨度未知时,需要在句子中的所有实体候选项上构建cloze-style提示,使用“[entity candidate]是[mask]”的结构进行预测。这种暴力枚举消耗的资源与代价通常非常昂贵。

技术实现思路

1、本发明的目的在于针对现有技术的不足,提供一种基于提示学习的测绘领域小样本命名实体识别方法及设备,能够解决在测绘领域的命名实体识别任务中,需要大量标注训练样本,模型训练效率低,以及模型最终分类识别实体准确性低的问题。

2、本发明设计的一种基于提示学习的测绘领域小样本命名实体识别方法,包含如下步骤:

3、步骤1:获取开源测绘领域文本数据,对所述开源测绘领域文本数据进行少量人工标记,构建测绘命名实体识别数据集;

4、步骤2:将测绘命名实体识别数据集输入解析成待测输入语句x=[x1,x2,...xn];

5、步骤3:将训练集中的所有标签集合设定为l=l1,l2,...,ll,l表示同一类别的集合,下标为序号;

6、步骤4:根据语言模型lm输出分布进行搜索找到一个中心词,可以代表每个类别中的大多数词作为l中每个类别的标签lf;

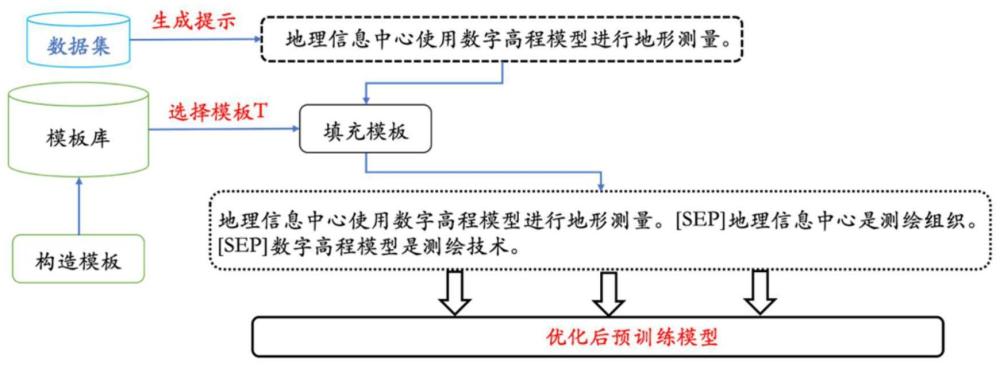

7、步骤5:选取实体-标签对的同时提取包含该实体标签对的句子,将其套入模板成“句子s。实体e是标签lf。”的形式。在不同的提示之间使用分隔符进行分割,构成成新输入,其中,“实体-标签对”指命名实体类别与对应的标签;

8、步骤6:构造基于bert的网络模型,该模型将bert网络中原有的12个transformer层生成的向量表示均赋予一个权重,再通过模型的训练进行权重值确定,最后将每一层生成的向量表示进行加权平均;

9、步骤7:将步骤5中构造的新输入输入到基于bert的网络模型中进行编码,得到标记表示向量;

10、步骤8:将标记表示向量输入到基于bert网络模型的条件随机场层中,该层在给定输入标记的情况下计算输出序列的条件概率

11、步骤9:通过使用交叉熵损失最小化条件概率来训练模型,得到候选实体类别预测值,得到识别出的命名实体。

12、进一步的,步骤4中,利用语言模型输出分布进行搜索每个标签中心提示词,选择最相似的候选提示。具体来说,将每个样本(x,y*)输入lm,并得到在每个位置j下预测的每个单词w∈v(所有单词集合)的概率分布假设指示w是否属于样本(x,y*)中xi的topk预测之一,具体如下:

13、

14、其中,m(c)表示选择类别c的过程,即使得指示函数的总和最大化的类别c,argmax表示对求和式中的表达式取最大值的类别c;φtopk(xi=ω,yi*=c)表示一个指示函数,它指示在样本(x,y*)中的位置i处的预测标记是否是类别c并且是否属于前k个预测之一;d表示整个数据集,包含多个样本(x,y*)。

15、进一步的,步骤8中,通过使用交叉熵损失最小化条件概率来训练模型,得到候选实体类别预测值,得到识别出的命名实体,具体如下:

16、

17、其中l表示损失函数,使用交叉熵损失来衡量模型的预测结果与真实标签之间的差异。n表示训练样本的数量。pθ(y|h):表示在给定输入h的情况下,模型预测标签y的条件概率。θ表示模型的参数,用于表示模型的预测能力。y表示真实标签,即样本的真实类别。h表示模型的输入特征,是通过模型从原始输入数据中提取的特征表示。

18、基于同一发明构思,本发明还设计了一种电子设备,包括:

19、一个或多个处理器;

20、存储装置,用于存储一个或多个程序;

21、当一个或多个程序被所述一个或多个处理器执行,使得所述一个或多个处理器实现基于提示学习的测绘领域小样本命名实体识别方法。

22、基于同一发明构思,本发明还设计了一种计算机可读介质,其上存储有计算机程序,所述程序被处理器执行时实现基于提示学习的测绘领域小样本命名实体识别方法。

23、本发明与现有技术相比,本发明的优势在于:

24、1)基于提示学习的方法:本发明采用基于提示学习的方法进行测绘领域小样本命名实体识别。这种方法通过利用提示信息指导模型的训练和推断过程,提高模型在低资源场景下的性能。通过将命名实体识别任务转化为预测特定的提示词,避免了复杂的模板构建过程,同时仍然保持了预训练模型的词预测范例。

25、2)自动生成提示模板:通过在训练集中搜索中心词,代表每个实体类别中的大多数词,作为每个标签的提示词。然后通过模板将实体-标签对套入句子中,构建“句子s。实体e是标签lf。”的形式。这种自动生成提示模板的方法减轻了手动设计模板的工作量。

26、3)上下文信息的引入:在构造新输入后,将其输入到基于transformer的编码器中进行编码,得到标记表示向量。这意味着模型能够利用上下文信息进行更好的特征提取,提高了对实体的识别能力。

27、4)更好地利用bert的多层表示:bert模型由多个transformer层组成,每个层都捕捉了不同抽象层次的语义信息。通过给每个层的向量表示赋予不同的权重,可以更好地利用bert模型的多层表示,从而获得更丰富、更准确的语义表示。

28、5)灵活性:通过训练来确定每个层的权重,使得模型可以根据具体任务的需求动态地调整各层表示的重要性。这种灵活性能够适应不同的任务和数据特点,从而提升模型的适应性和泛化能力。

29、6)减轻过拟合风险:通过对各层表示进行加权平均,可以减轻模型在训练过程中出现过拟合的风险。这是因为模型不会过于依赖于某一层的表示,而是综合考虑了所有层的信息,降低了过拟合的可能性。

30、7)提升性能:通过对bert模型中每个层表示进行加权平均,可以得到更丰富和更准确的语义表示,从而提升模型在各种自然语言处理任务上的性能,包括命名实体识别、文本分类、语义匹配等。

31、本发明创新性地将基于提示学习的方法应用于测绘领域小样本命名实体识别任务中,通过自动生成提示模板、引入上下文信息和使用动态融合等技术手段,提高了模型在低资源场景下的性能和准确性。

本文地址:https://www.jishuxx.com/zhuanli/20240730/196053.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表