基于边界细化的多尺度混合Transformer模型的高分辨率遥感影像建筑物提取方法

- 国知局

- 2024-09-05 14:49:41

本发明属于遥感图像识别,涉及一种基于边界细化的多尺度混合transformer模型的高分辨率遥感影像建筑物提取方法。

背景技术:

1、随着遥感技术的不断发展和高分辨率遥感影像的广泛应用,从高分辨率遥感图像中提取建筑物在遥感界引起了广泛的关注。准确提取建筑物对于人口估计、灾害评估和环保城市规划具有重要的意义。然而,由于建筑物外观和尺寸的多样性,建筑物周边环境的复杂性以及遮挡和阴影,使得准确从高分辨率遥感影像中提取建筑物仍然是一个重要的挑战。在面向多尺度对象分割问题时,有许多基于深度学习方法来进行建筑物提取。如pspnet利用空间金字塔池化模块来继承多尺度的上下文,但是大尺度上下文的提取以牺牲空间分辨率为代价。deeplab家族将空洞空间金字塔池模块集成到深度卷积神经网络中,在不丢失分辨率的前提下捕获多尺度上下文信息。

2、近年来,随着卷积神经网络(cnn)的迅速发展,建筑物提取任务迎来了有利的突破。全卷积网络(fcn)的提出首次将全卷积网络结构应用于该领域,这激发了许多研究人员的兴趣,他们专注于设计编码器-解码器架构,以实现更准确的建筑提取。他们提出了许多基于cnn的建筑提取框架。这些方法在一定程度上提高了建筑物的提取精度。然而,这些方法受到了建筑物卷积操作的局限性,难以有效地对全局上下文信息进行建模。由于建筑物的形状和大小差异巨大,周围环境也可能十分复杂,例如可能存在树木或阴影遮挡等问题,这使得局部上下文信息难以准确地推断建筑目标。

3、近年来,随着卷积神经网络(cnn)的迅速发展,建筑物提取任务迎来了有利的突破。全卷积网络(fcn)的提出首次将全卷积网络结构应用于该领域,与基于cnn的方法相比,transformer具有很强的全局建模的能力。尽管transformer在提取全局信息方面表现出了优势,但在建筑提取任务中,局部细节特征(如建筑边缘)也是至关重要的。这些细节可以提供有关建筑物形状、结构和边界的关键信息。在这一背景下,在transformer中引入cnn方法来增强局部信息提取能力成为解决局部和全局上下文信息之间平衡的关键。通过融合transformer的全局建模能力和cnn的局部特征的提取能力,混合transformer可以更好地理解图像中建筑物的整体结构,从而提高建筑物提取的准确性和鲁棒性。虽然将cnn模型与transformer模型进行串行、并行或交叉等能够提高对局部特征以及全局特征的提取,但这毫无疑问大大增加了计算成本。

4、在编码器中,低级特征承载着建筑物的边缘等局部细节信息,然而,它们也夹杂着大量的非建筑区域背景噪声。直接将这些低级特征与解码器中的高级特征融合可能导致语义歧义,同时边缘表示变得较弱,这使得模型在恢复空间细节信息时难以区分建筑物的边缘像素,进而导致建筑物边缘提取变得模糊。另外,在进行特征聚合时,高级特征图需要上采样至与低级特征图相同的大小。然而,由于不同层次的特征图之间存在错位问题,可能导致模型无法准确捕获建筑物的边界信息,从而影响了建筑物提取的精度。此外,小型建筑物可能被树木、其他建筑物或遮阳设施等遮挡,或者由于光照条件不佳而产生阴影,这会导致模型无法正确检测到它们,从而影响整个建筑物提取过程的准确性和鲁棒性。

技术实现思路

1、有鉴于此,本发明的目的在于提供一种基于边界细化的多尺度混合transformer模型的高分辨率遥感影像建筑物提取方法,以解决当前建筑提取方法中对小建筑物漏提、错提以及建筑边界不规则、模糊等问题。

2、为达到上述目的,本发明提供如下技术方案:

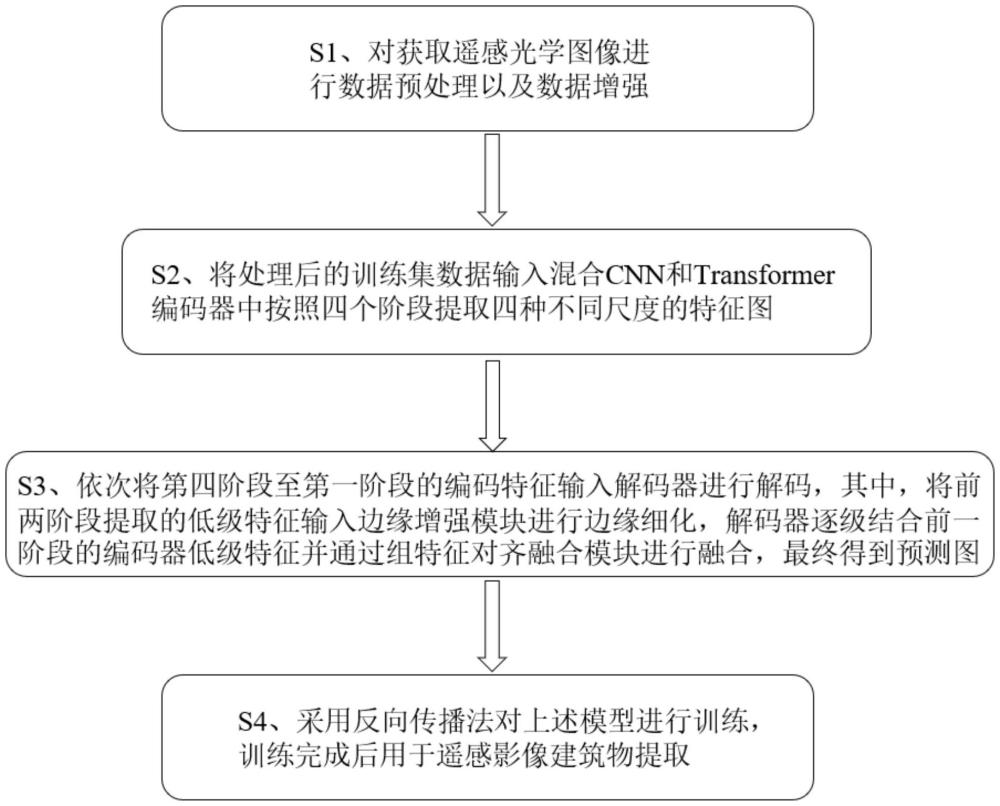

3、一种基于边界细化的多尺度混合transformer模型的高分辨率遥感影像建筑物提取方法,该方法包括:

4、s1、对获取遥感光学图像进行数据预处理以及数据增强;

5、s2、将处理后的训练集数据输入混合cnn和transformer编码器中按照四个阶段提取四种不同尺度的特征图;

6、s3、依次将第四阶段至第一阶段的编码特征输入解码器进行解码,其中,将前两阶段提取的低级特征输入边缘增强模块进行边缘细化,解码器逐级结合前一阶段的编码器低级特征并通过组特征对齐融合模块进行融合,最终得到预测图;

7、s4、采用反向传播法对上述模型进行训练,训练完成后用于遥感影像建筑物提取。

8、进一步,步骤s1中,在数据预处理方面,将获取的遥感建筑物数据集图像使用重叠的方式进行裁剪,并对标注图像的标签像素转为0或1,然后将裁剪后的数据集按照比例划分为训练集、验证集和测试集;

9、在数据增强方面,对训练集使用数据增强,包括对数据集进行随机大小缩放、随机水平翻转和垂直翻转、随机高斯噪声、限制对比度自适应直方图均衡、随机旋转及随机裁剪方法。

10、进一步,步骤s2中,将给定的rgb图像划分为若干大小相同的图像块,然后将这些图像块输入到多尺度混合transformer编码器中,依次通过每个阶段后,获得分辨率为原始图像{1/4,1/8,1/16,1/32}的四个特征图,其中每个阶段的特征图通道数记为c1~c4;

11、其中,多尺度混合transformer编码器具有四个阶段,四个阶段的多尺度混合transformer编码器编码中的特征图分别记为f1、f2、f3、f4,与之对应的,为四个阶段设置四个解码器,其中,第一阶段的解码器中的特征图为d4,第二阶段的解码器中的特征图为d3,第三阶段的解码器中的特征图为d2,第四阶段的解码器中的特征图为d1,其中,第一阶段和第二阶段得出的特征f1、f2为低级特征;在解码时,第四阶段中的特征f2优先解码,然后依次为f3、f2、f1;

12、每个阶段的多尺度混合transformer编码器包括一个重叠补丁合并层和多个hybirdformer block;

13、每个重叠补丁合并层有一个卷积层和一个layernorm正则化层组成,将通过重叠补丁合并层后的特征图向量传入hybirdformer block中;每个hybirdformer block包括:一个多尺度局部感知模块和一个全局感知模块;

14、其中多尺度局部感知模块mslp具体为,首先将特征图输入到能够适应不同输入的深度卷积idconv;将经过idconv后的特征图按通道维度划分为三组特征图,其中i=1,2,3,将分别输入到1×1、3×3和5×5的深度卷积;

15、将结果按通道维度进行级联融合得到具有多尺度信息的特征图;

16、使用两个全连接层和高斯误差线性单元gelu激活一起增强局部特征的非线性表示,最终生成特征图,整个mslp模块表示为:

17、x1,x2,x3=channelsplit(idconv(xin))

18、x′=concat(dwconv1×1(x1),dwconv3×3(x2),dwconv5×5(x3))

19、xlocal=xin+linear(gelu(linear(x′)))

20、其中,idconv表示依赖于输入的深度卷积,channelsplit表示将特征图按通道维度切分,gelu代表高斯误差线性单元;

21、全局感知模块具体为:包括一个高效自注意力层和一个混合前馈位置编码mix-ffn层,高效自注意力层将原始的q,k,v中的k和v进行下采样;mix-ffn层包括一个3×3的卷积层;在进入高效自注意力和mix-ffn模块之前有一个正则化层,并在每个模块后使用残差连接。

22、进一步,在步骤s3中,包括以下步骤:

23、s31、首先将第四阶段的特征f4输入至解码器中得到解码后的高级特征d1;将第四阶段解码后的高级特征d1与第三阶段的高级特征f3一起输入组特征对齐融合模块得到第三阶段对齐特征d2;

24、s32、将第二阶段的低级特征f2、第四阶段的解码后的高级特征d1、第三阶段对齐特征d2输入至边缘增强模块得到第二阶段增强的低级特征,将第二阶段增强的低级特征与第三阶段对齐特征d2输入组对齐模块得到第二阶段对齐特征d3;

25、s33、将第一阶段的低级特征f1与第四阶段的解码后的高级特征d1、第三阶段对齐特征d2以及第二阶段对齐特征d3输入边缘增强模块得到第一阶段增强的低级特征,将第一阶段增强的低级特征与第二阶段对齐特征d3输入组特征对齐融合模块进行对齐融合,得打最终预测图,并将此预测图作为最终的建筑分割结果。

26、进一步,在步骤s31中,通过组特征对齐融合模块进行特征对齐和融合的过程为:

27、给定解码器高级特征fhigh和前一阶段编码器低级特征flow,将fhigh执行1×1卷积和双线性插值上采样使得fhigh维度与flow一致得到特征然后将flow与同时使用1×1卷积压缩通道数得到特征图fl′ow与fh′igh:

28、

29、

30、fl′ow=conv1×1(flow)

31、将两个特征映射串联起来,将拼接后的特征映射输入到3×3卷积层,得到预测的语义流场δlow,语义流场表示为:

32、δlow=conv3×3(concat(fh′igh,fl′ow))

33、再将按通道维度分成g组,即其中其中每个子特征分别与语义流场空间网格上的每个点phigh通过简单的加法运算映射到flow中的新点plow,然后使用可微双线性采样机制对phigh的四个最近邻像素值进行线性插值,得到

34、然后再将对齐后的每组特征沿通道维度连接生成最终的结果具体表示为:

35、

36、

37、

38、其中n(phigh)表示fhigh中扭曲点phigh所涉及的相邻点,ωp表示由扭曲网格局部估计的双线性核权重;

39、最后通过连接操作和3×3卷积来融合和flow,具体过程如下:

40、

41、其中表示对齐后的高级特征,flow表示前一阶段编码器的低级特征。

42、进一步,在步骤s32中,将多尺度混合transformer编码器生成的四个阶段特征图中的第二阶段的特征图输入到边界增强模块,同时将解码器后两个阶段输出的融合后的特征图输入到边界增强模块,其中,第二阶段的边缘增强模块包括:

43、将第二阶段的编码器中的特征f2和第三、四阶段的解码器中的特征d1、d2作为输入;

44、使用3个1×1卷积将d1、d2的维度统一到与f2一致,统一进行上采样到与f2相同大小;

45、将统一后的d1、d2按通道维度进行级联,接着使用3×3卷积生成与f2相同维度的权重矩阵w;

46、使用快速傅里叶变换fft层将f2与权重参数w同时转换到频率域,在将f2与w进行逐元素相乘,使用逆快速傅里叶变换(ifft)将f2从频率域转回空间域生成特征图f,接着将f输入ln和mlp生成最终具有强边缘信息和建筑语义信息的特征fedge;

47、整个边缘增强模块的过程表示为:

48、

49、

50、

51、其中,代表具有cj个卷积核的1×1卷积,mlp表示多层感知机,fft表示快速傅里叶变换,ifft表示逆快速傅里叶变换,up表示上采样,ln代表layernorm正则化。

52、进一步,在步骤s33中,将多尺度混合transformer编码器生成的四个阶段特征图中的第一个阶段的特征图输入到边界增强模块,同时将解码器后三个阶段输出的融合后的特征图输入到边界增强模块;其中,通过第一阶段的边缘增强模块得到增强特征的过程包括:

53、将第一阶段的编码器中的特征f1和第二、三、四阶段的解码器中的特征d1、d2、d3作为输入;

54、使用3个1×1卷积将d1、d2、d3的维度统一到与f1一致,统一进行上采样到与f1相同大小;

55、将统一后的d1、d2、d3按通道维度进行级联,接着使用3×3卷积生成与f1相同维度的权重矩阵w;

56、使用快速傅里叶变换fft层将f1与权重参数w同时转换到频率域,在将f1与w进行逐元素相乘,使用逆快速傅里叶变换(ifft)将f1从频率域转回空间域生成特征图f,接着将f输入ln和mlp生成最终具有强边缘信息和建筑语义信息的特征fedge;

57、整个边缘增强模块的过程表示为:

58、

59、

60、

61、其中,代表具有cj个卷积核的1×1卷积,mlp表示多层感知机,fft表示快速傅里叶变换,ifft表示逆快速傅里叶变换,up表示上采样,ln代表layernorm正则化。

62、进一步,在步骤s4中,使用adamw优化器以及poly学习率调整策略,使用交叉熵损失函数计算预测图与真实图之间的损失,通过反向传播降低损失;

63、损失计算方式具体为:将s4中得到的最终预测图与真实图计算交叉熵损失,交叉熵损失计算公式如下:

64、

65、其中,n代表图像中像素的总数,yi∈{0,1}表示像素i的真实标签,表示对于像素i属于类别1的概率。

66、本发明的有益效果在于:

67、第一,本发明提出了一种基于边界细化的多尺度混合transformer模型的高分辨率遥感影像建筑物提取框架,可以将cnn的优点与transformer的优点充分结合,进行多尺度的局部信息以及全局信息提取。

68、第二,本发明提出了边缘增强模块,控制编码器输入到解码器中的信息流,利用解码器中具有丰富语义信息的高级特征增强编码器中低级特征的边缘表示,并抑制非建筑区域的不相关背景噪声,提高了建筑边界的分割结果。

69、第三,本发明提出了组对齐特征融合模块,将相邻级别的不同层次的特征图进行特征对齐,使得含有丰富上下文信息的高级特征与含有丰富空间细节信息的低级特征进行有效的融合。

70、本发明的其他优点、目标和特征在某种程度上将在随后的说明书中进行阐述,并且在某种程度上,基于对下文的考察研究对本领域技术人员而言将是显而易见的,或者可以从本发明的实践中得到教导。本发明的目标和其他优点可以通过下面的说明书来实现和获得。

本文地址:https://www.jishuxx.com/zhuanli/20240905/288338.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。