面向大模型联邦迁移场外微调的适配器隐私保护方法、系统、设备及介质

- 国知局

- 2024-10-21 15:09:15

本发明属于信息安全,尤其涉及一种面向大模型联邦迁移场外微调的适配器隐私保护方法、系统、设备及介质。

背景技术:

1、面向大模型的联邦迁移(ftl-llm)是在标准场外微调(offsite-tuning)框架基础上进行扩展,实现多数据方和大模型方同时进行场外微调,和多数据方联合微调大模型的结果。在标准场外微调框架下,模型所有者向数据所有者下发一个轻量级的适配器(adapter)和一个有损压缩的仿真器(emulator),使得数据所有者能够利用适配器和仿真器实现上级性能,利用私有数据集完成对适配器的微调。微调完成后,数据所有者将更新后的适配器上传模型所有者,模型所有者利用更新后的适配器对大模型进行调优,从而得到在特定数据集上效果增强的大模型。

2、在标准场外微调框架下,模型所有者能够通过压缩的方式保护仿真器所对应的原始参数数据,这很好地保护了大模型的安全。但数据所有者对适配器微调的过程是在明文的状态下进行的,有学者研究发现该过程中如果适配器原始参数泄漏将会威胁大模型的安全。

3、在(arxiv:2302.04870v1[cs.cl]9feb 2023),xiao,lin,和han提出的场外微调offsite-tuning:transfer learning withoutfull model技术中,它允许在不访问完整模型权重的情况下,对基础模型进行微调以适应下游任务。但在上游模型所有者对数据所有者发送的适配器中,其包含的是模型的原始参数,这可能造成下游数据所有者在利用私有数据集对大模型进行微调的同时窃取模型的原始参数,导致模型参数泄露,危害模型安全。

技术实现思路

1、为了克服上述现有技术的不足,本发明的目的在于提供一种面向大模型联邦迁移场外微调的适配器隐私保护方法、系统、设备及介质,利用差分隐私中的拉普拉斯机制对适配器中的参数添加扰动,使得原始参数不被窃取或恶意挪用,从而保护模型所有者的权益,提高场外微调框架下大模型联邦迁移学习过程的安全性。

2、为了实现上述目的,本发明采用如下技术方案:

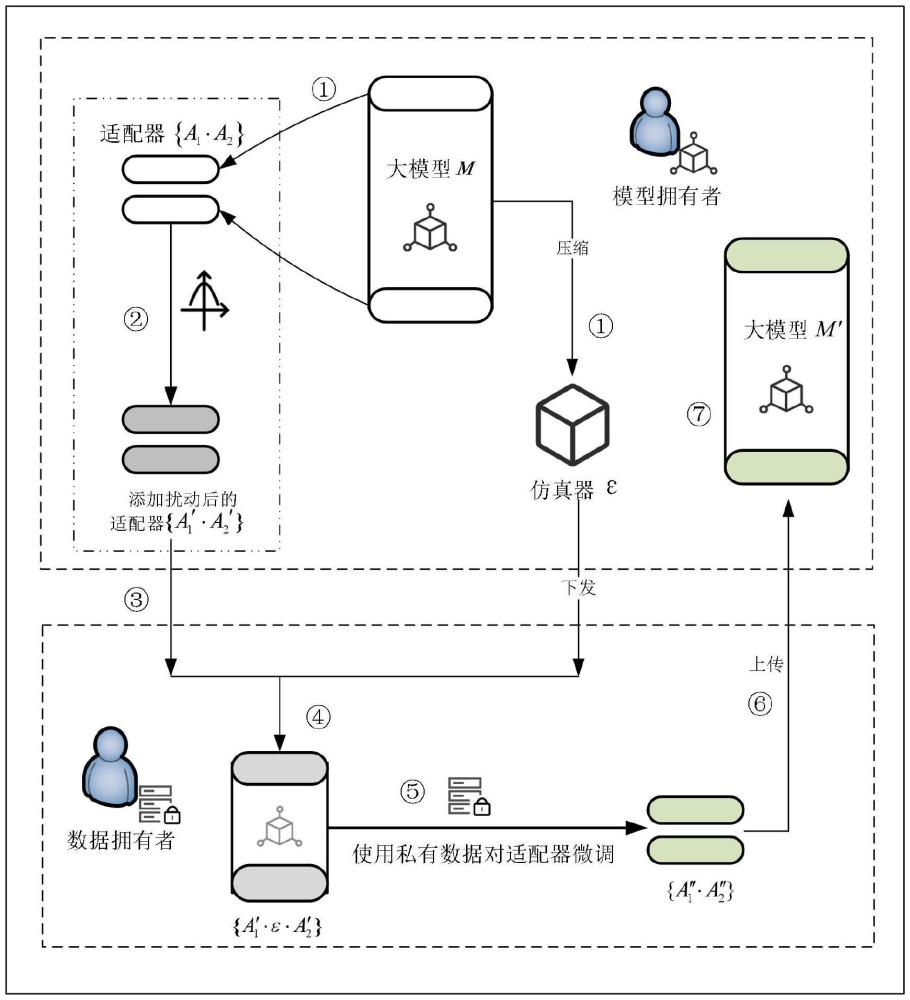

3、1、一种面向大模型联邦迁移场外微调的适配器隐私保护方法,其特征在于,首先,模型所有者选取大模型transformer结构下的顶层和底层作为适配器{a1·a2},并将其余层进行压缩作为仿真器;然后,模型所有者对适配器添加扰动,将该适配器和仿真器下发给下游的数据所有者;接着,数据所有者将模型所有者下发的适配器和仿真器进行拼接以实现上游大模型功能,并且利用私有数据集对适配器进行微调;最后,数据所有者将微调更新完成的适配器上传回模型所有者,模型所有者将更新后的适配器插入大模型,完成对大模型的更新。

4、1)所述下游的数据所有者微调所使用的是真实有效、非恶意的私有数据集;

5、2)所述数据所有者将微调更新后的适配器参数上传回模型所有者的过程中不会受到攻击。

6、一种面向大模型联邦迁移场外微调的适配器隐私保护方法,具体包括以下步骤:

7、步骤1、模型所有者选择大模型m中transformer结构下的顶层和底层作为适配器{a1·a2},并将其余层进行压缩作为仿真器;

8、步骤2、数据处理:模型所有者利用差分隐私中的拉普拉斯机制,对适配器参数的数据集d1添加扰动;所述数据集d1由适配器{a1·a2}所包含的参数,即k个n维向量ve=<x1,x2,...,xk>组成;

9、步骤3、模型所有者将添加扰动后的适配器和压缩过后的仿真器下发给下游数据所有者;

10、步骤4、数据所有者完成对仿真器和添加扰动后适配器的拼接,得到适配器和仿真器的拼接结构{a′1·ε·a′2},实现与大模型同样的性能;

11、步骤5、数据所有者利用私有数据对添加扰动后的数据集d′用lora微调方法进行微调即更新;

12、步骤6、数据所有者将更新后的适配器数据集d″上传回模型所有者;

13、步骤7、模型所有者使用更新后数据集d″将适配器{a″1·a″2}插入大模型,得到在下游数据集微调后的大模型。

14、所述步骤2的具体方法为:设,有数据集d1的相邻数据集d2和一个查询函数(·),计算f的敏感度δf:

15、

16、根据模型所有者确定的隐私预算ε和敏感度δf,计算拉普拉斯噪声的参数根据该参数生成符合拉普拉斯分布的随机数,将该随机数加到查询结果rd上,从而获得经过差分隐私添加扰动后的适配器{a′1·a′2}参数数据集d′:

17、

18、所述步骤5的具体方法为:使用lora微调方法,对于适配器参数数据集d′∈rn×k,用一个低秩分解来表示参数更新δd',即

19、d′+δd′=d′+ba

20、其中,b∈rn×r,a=rr×kand r<<min (n,k)

21、训练过程中冻结参数d′,仅训练a和b的参数,最后得到经过私有数据集微调后的适配器数据集d″。

22、基于步骤1至步骤7所述隐私保护方法的面向大模型联邦迁移场外微调的适配器隐私保护系统,包括:

23、模型分解模块,用于步骤1,通过选择大模型transformer结构下的首层和底层作为适配器,中间层压缩后作为仿真器,实现对大模型的分解。

24、模型扰动模块,用于步骤2、步骤3,通过差分隐私技术中的拉普拉斯机制,实现对适配器参数添加扰动;

25、模型拼接模块,用于步骤4,通过对仿真器和添加扰动的适配器的拼接,实现数据所有方的大模型拼接;

26、适配器微调模块,用于步骤5,通过轻量级的lora方法,实现数据所有者对适配器的高效微调;

27、模型聚合模块,用于步骤6、步骤7,通过数据所有者将微调后的适配器发送,模型所有者完成首层底层的大模型参数更新。

28、基于步骤1至步骤7所述隐私保护方法的面向大模型联邦迁移场外微调的适配器隐私保护设备,包括:

29、存储器,用于存储计算机程序;

30、处理器,用于执行所述计算机程序时实现步骤1至步骤7所述的面向大模型联邦迁移场外微调的适配器隐私保护。

31、一种计算机可读存储介质,所述计算机可读存储介质用来存储计算机程序,所述计算机程序被处理器执行时能够对基于步骤1至步骤7所述的隐私保护方法,使得原始参数不被窃取或恶意挪用,从而保护模型所有者的权益,提高场外微调框架下大模型联邦迁移学习过程的安全性。

32、与现有技术相比,本发明具有如下优点:

33、针对面向大模型场外微调下适配器存在隐私泄露问题,本发明提出针对大模型使用的场外微调中适配器的隐私保护方法,它保护了适配器部分所包含原始模型的参数,防止外部通过该部分参数推得大模型内部的数据或结构,有效避免了可能造成的模型隐私泄露,从而提高面对大模型使用的联邦迁移中场外微调框架下的模型安全性。

34、1、本发明采用场外微调框架,解决联邦大模型微调数据规模大的问题。在该框架下,原大模型被拆分为适配器和仿真器,仿真器经过模型蒸馏等压缩技术后参数量级减小,这使得数据所有者得到的是数据规模更小的大模型。结合适配器和仿真器,数据所有者可采用lora方法实现对大模型适配器的高效微调,在减少了计算开销的同时能够保证微调效果。

35、2、本发明创新性地将差分隐私技术用于场外微调框架中,能够有效解决由于适配器发送到下游数据所有者可能造成的数据泄露问题。具体而言,本发明采用拉普拉斯机制的差分隐私技术,结合模型所有方设置的隐私预算,将生成的噪声加在适配器的原始参数后,使得其满足差分隐私的定义,能够有效防抵御下游数据所有者的攻击,保护模型原始参数不被窃取。

36、综上,本发明提出的面向大模型联邦迁移场外微调的适配器隐私保护方法,利用差分隐私技术有效保护适配器的原始参数,使其能够抵御成员推理攻击、数据重构攻击等威胁,保护模型的原始参数不被下游数据所有者窃取,有效保护模型所有者的隐私。本发明将差分隐私技术应用于场外微调框架中,完成对适配器参数的扰动,有效保护数据所有者与模型所有者的信息安全,保障了大模型的高效微调。

本文地址:https://www.jishuxx.com/zhuanli/20241021/320688.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。