1.本公开总体上涉及由两个相机拍摄的场景中的元素的现实世界视差的估计,并且更具体地,涉及用于基于代价-体注意力(cost-volume attention)的鲁棒性视差估计的深度学习系统和方法。

背景技术:

2.深度学习现在正在各种计算机视觉任务中引领许多性能突破。深度学习的最先进的性能来自于过度参数化的深度神经网络,当在非常大的数据集上训练时,该深度神经网络能够为目标任务自动提取数据的有用的表征(特征)。

3.也存在对所拍摄的场景中的元素的现实世界深度的估计的兴趣,该估计具有许多应用(诸如,分离所拍摄的场景内的前景(近)对象与背景(远)对象的能力)。准确的视差估计允许将场景中的感兴趣的前景对象与背景分离。此外,准确的前景-背景分离允许处理所拍摄的图像以模拟诸如虚化(bokeh)效果的效果。虚化是背景的柔和的焦外模糊,当在具有快速镜头和宽光圈的昂贵相机中使用正确的设置并且将相机移动得更靠近主体以及主体进一步远离背景以模拟浅景深时,焦外模糊是有效的。因此,准确的视差估计允许处理来自非专业摄影师或具有较小镜头的相机(诸如,移动电话相机)的图像,以获得具有应用于拍摄主体的虚化效果的更有美感的图像。准确的视差估计的其他应用包括三维(3d)对象重建和虚拟现实应用,其中,期望改变背景或主体,并根据所期望的虚拟现实渲染它们。

4.然而,现实世界场景非常复杂,并且由具有各种不同模式的场景组成(诸如,室内与街景驾驶)。因此,由于现有的视差估计方法仅针对有限的场景进行优化,所以现有的视差估计方法没有很好地工作。此外,它们需要多个模型来处理不同现实世界环境中的视差估计。

技术实现要素:

5.提供本公开以至少解决上述问题和/或缺点并且至少提供下述优点。

6.本公开的一个方面是提供一种系统和方法,该系统和方法用于使用对于具有各种模式的场景工作良好的单个模型来估计由两个相机拍摄的场景中的元素的现实世界视差。

7.本公开的另一方面是提供一种用于基于代价-体注意力的鲁棒性视差估计的深度学习系统和方法。

8.本公开的另一方面是提供一种用于基于代价-量注意力的视差估计的系统和方法,该系统和方法可以使用单个模型处理现实世界视差估计问题。

9.根据一个实施例,提供了一种方法,所述方法包括:从由第一相机拍摄的左图像提取第一特征图;从由第二相机拍摄的右图像提取第二特征图;基于第一特征图和第二特征图的比较来计算匹配代价以生成代价体;从生成的代价体生成注意力-感知代价体;以及聚合注意力-感知代价体以生成输出视差。

10.根据一个实施例,提供了一种系统,所述系统包括存储器和处理器,所述处理器被

配置为从由第一相机拍摄的左图像提取第一特征图,从由第二相机拍摄的右图像提取第二特征图,基于第一特征图和第二特征图的比较来计算匹配代价以生成代价体,从生成的代价体生成注意力-感知代价体,以及聚合注意力-感知代价体以生成输出视差。

11.根据一个实施例,提供了一种系统,所述系统包括:特征图提取模块,被配置为从由第一相机拍摄的左图像提取第一特征图,并且从由第二相机拍摄的右图像提取第二特征图;代价体计算模块,被配置为基于第一特征图和第二特征图的比较来计算匹配代价以生成代价体;代价体注意力模块,被配置为从生成的代价体生成注意力-感知代价体;以及代价聚合模块,被配置为聚合注意力-感知代价体以生成输出视差。

附图说明

12.根据以下结合附图的详细描述,本公开的某些实施例的上述和其他方面、特征和优点将更加清楚,其中:

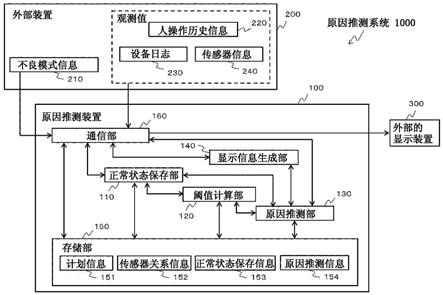

13.图1示出了根据实施例的用于基于代价-体注意力的鲁棒性视差估计的深度学习系统;

14.图2示出了根据实施例的由深度学习系统生成最终输出视差的处理;

15.图3示出了根据实施例的关于代价体的逐通道视差注意力(cva-cwda)的处理;

16.图4示出了根据实施例的cva-cwda中的注意力块的详细处理;

17.图5示出了根据实施例关于代价体的逐视差通道注意力(cva-dwca)的处理;

18.图6示出了根据实施例的cva-dwca中的注意力块的详细处理;

19.图7示出了根据实施例关于代价体的单分支视差注意力(cva-sbda)的处理;

20.图8示出了根据实施例的关于代价体的单分支通道注意力(cva-sbca)的处理;

21.图9示出了根据实施例的关于代价体的单分支组合的视差-通道注意力(cva-sbcdca)的处理;

22.图10示出了根据实施例的关于代价体的单分支空间注意力(cva-sbsa)的处理;

23.图11示出了根据实施例的利用顺序排列和并行排列的双重代价体注意力的处理;

24.图12示出了根据实施例的展示代价-体注意力模块的有效性的曲线图;以及

25.图13示出了根据实施例的网络环境中的电子装置。

具体实施方式

26.在下文中,参考附图详细描述本公开的实施例。应当注意,尽管相同的元件在不同的附图中被示出,但是相同的元件将由相同的附图标记表示。在以下描述中,仅提供诸如详细配置和组件的具体细节,以帮助全面理解本公开的实施例。因此,对于本领域技术人员应显而易见的是,在不脱离本公开的范围的情况下,可以对这里描述的实施例进行各种改变和修改。此外,为了清楚和简明,省略了对众所周知的功能和结构的描述。下面描述的术语是考虑到本公开中的功能而定义的术语,并且可以根据用户、用户的意图或习惯而不同。因此,术语的定义应基于贯穿本说明书的内容来确定。

27.本公开可以具有各种修改和各种实施例,其中,下面参考附图详细描述实施例。然而,应当理解,本公开不限于实施例,而是包括本公开的范围内的所有修改、等同物和替代物。

28.尽管可以使用包括诸如第一、第二等的序数的术语来描述各种元件,但是结构元件不受这些术语的限制。这些术语仅用于将一个元件与另一个元件区分开。例如,在不脱离本公开的范围的情况下,第一结构元件可以被称为第二结构元件。类似地,第二结构元件也可以被称为第一结构元件。如这里所使用的,术语“和/或”包括一个或更多个相关项目的任何和所有组合。

29.这里使用的术语仅用于描述本公开的各种实施例,而不旨在限制本公开。除非上下文另有明确说明,否则单数形式旨在包括复数形式。在本公开中,应当理解,术语“包括”或“具有”指示特征、数字、步骤、操作、结构元件、部件或其组合的存在,并且不排除一个或更多个其他特征、数字、步骤、操作、结构元件、部件或其组合的存在或添加的可能性。

30.除非不同地定义,否则这里使用的所有术语具有与本公开所属领域的技术人员所理解的含义相同的含义。术语(诸如,在通常使用的字典中定义的术语)应被解释为具有与相关领域中的上下文含义相同的含义,并且除非在本公开中明确定义,否则不应被解释为具有理想或过于形式化的含义。

31.根据一个实施例的电子装置可以是各种类型的电子装置中的一种。电子装置可以包括例如便携式通信装置(例如,智能电话)、计算机、便携式多媒体装置、便携式医疗装置、相机、可穿戴装置或家用电器。根据本公开的一个实施例,电子装置不限于上述电子装置。

32.本公开中使用的术语不旨在限制本公开,而是旨在包括相应的实施例的各种改变、等同物或替代物。关于附图的描述,类似的附图标记可以用于指代类似或相关的元件。除非相关上下文另有明确说明,否则对应于项目的名词的单数形式可以包括一个或更多个事物。如这里所使用的,诸如“a或b”、“a和b中的至少一个”、“a或b中的至少一个”、“a、b或c”、“a、b和c中的至少一个”和“a、b或c中的至少一个”的短语中的每一个可以包括在相应的一个短语中一起列举的项目的所有可能组合。如本文所使用的,可以使用诸如“第一(1

st

)”、“第二(2nd)”、“第一(first)”和“第二(second)”的术语将相应的组件与另一组件区分开,但不旨在在其他方面(例如,重要性或顺序)限制组件。意图在于:如果元件(例如,第一元件)被称为与另一元件(例如,第二元件)“结合”(具有或不具有术语“可操作地”或“通信地”),则它表示该元件可以直接地(例如,有线)、无线地或经由第三元件与另一元件结合。

33.如这里所使用的,术语“模块”可以包括以硬件、软件或固件实现的单元,并且可以与例如“逻辑”、“逻辑块”、“部件”和“电路”的其他术语互换使用。模块可以是适于执行一个或更多个功能的单个集成组件或其最小单元或部分。例如,根据一个实施例,模块可以以专用集成电路(asic)的形式实现。

34.传统的视差估计方法仅聚焦于估计来自诸如仅针对室内场景或者仅针对街景的特定域的视差。因此,当使用传统方法对不同场景进行测试时,准确度可能非常差。

35.图1示出了根据实施例的用于基于代价-体注意力的鲁棒性视差估计的深度学习系统。

36.参考图1,深度学习系统包括特征图提取模块101、代价体计算模块102、代价体注意力(cva)模块103、代价聚合模块104和视差融合模块105。特征图提取模块101从左图像和右图像提取特征图。代价体计算模块102基于左/右特征图计算匹配代价。cva模块103基于注意力来调整(强调/抑制)代价体的部分,为代价体中的不同视差提供不同的权重。代价聚合模块104聚合注意力-感知(attention-aware)代价体以输出视差。视差融合模块105融合

两个聚合视差(例如,在不同视差范围上训练)以提供最终输出视差。

37.尽管图1将每个模块示出为单独的元件,但是模块可以被包括在诸如处理器或asic的单个元件中。

38.图2示出了根据实施例的由深度学习系统生成最终输出视差的处理。具体地,图2示出了深度学习系统的处理,深度学习系统基于cva通过使用单个模型对于各种场景工作良好。在本文中,该系统可以被称为cvanet。例如,可由图1中所示的深度学习系统执行图2中所示的处理。

39.参考图2,基于在不同视差范围上训练的两个网络提供视差融合方案。在部分视差范围[0,a]上优化第一网络,并且在全视差范围[0,b]上优化第二网络,其中,b》a。对于不同视差范围的两个视差估计网络,特征图提取模块、代价体计算模块、cva模块和代价聚合模块可以是相同的。

[0040]

在两个网络中,特征图提取模块从左图像和右图像提取特征图。此后,代价体计算模块计算左/右特征图之间的匹配代价。输出是表示在每个视差水平处的左特征图和右特征图之间的匹配代价的代价体。在理想情况下,真实视差水平的匹配代价将为0。

[0041]

cva模块基于注意力技术来修改代价体,这为代价体中的不同视差提供不同的权重。对于不同的场景,注意力模块将聚焦于代价-体的不同部分。例如,如果是室外场景,则注意力模块可以给予小的视差更多的权重(因为室外对象在远处),但是对于室内场景可以给予大的视差更多的权重。cva模块可以以多分支(multi-branch)方式或单分支(single-branch)方式细化匹配代价体。

[0042]

代价聚合模块聚合注意力-感知代价体以从每个网络输出视差图。此后,视差融合模块(基于不同的视差范围)融合来自每个网络的聚合视差以提供最终估计视差。

[0043]

可以使用传统的特征提取主干(诸如,残差网络(resnet)或堆叠沙漏网络(stacked hourglass network))来实现特征提取。特征提取的输入是左图像和右图像,每个图像具有大小h

×

w,其中,h是高度,w是宽度,并且输出是分别针对左图像和右图像的对应的特征图c

×w×

h,而c是通道的数量。

[0044]

还可以使用现有的代价-体(诸如,基于特征图相关性的标准代价-体,或者集成多个代价体的扩展代价体)来实现代价体。代价体的输出可以是四维(4d)特征图c

×d×h×

w,其中c是通道的数量,d是视差水平,h是高度,并且w是宽度。

[0045]

关于cva,因为代价体是4d特征图,所以不能直接采用基于3d特征图的传统的注意力算法。因此,这里提供了用于执行关于代价体的注意力的各种实施例。

[0046]

基于多分支注意力的cva

[0047]

多分支cva的概念是将4d特征图cv∈r

(c

×d×h×

w)

划分为若干3d特征图,然后对每个3d特征图应用注意力机制。下面,针对4d到3d的划分描述了两种不同的方法,(a)沿着cv的通道维度进行划分,即,关于代价体的逐通道(channel-wise)视差注意力(cva-cwda),以及(b)沿着cv的视差维度进行划分,即,关于代价体的逐视差(disparity-wise)通道注意力(cva-dwca)。

[0048]

图3示出了根据实施例的cva-cwda的处理。例如,可以由图1的cva模块103执行图3的处理。

[0049]

在图3中,m标识代价体的通道1至c中的每一个的3d图。y是对应于m的输出的基于

注意力的代价体。注意力图是d

×

d,这能够针对不同数据集显示关于视差的不同注意力。

[0050]

参考图3,4d特征图被划分为c个3d特征图,每个3d特征图具有大小d

×h×

w(标记为m)。具体地,沿着cv的通道维度划分4d特征图cv∈r

(c

×d×h×

w)

,得到3d特征图cv={m1,

…

,mc},mi∈r

(d

×h×

w)

,1≤i≤c。

[0051]

此后,将通道注意力施加到注意力块a1至ac处的c个特征图中的每一个,以获得注意力-感知特征图yi∈r

(d

×h×

w)

。可以针对每个yi沿着视差维度计算注意力,这得到d

×

d注意力矩阵。

[0052]

然后将注意力-感知特征图级联回4d特征图cv’={y1,y2,

…

,yc}作为cva模块的输出。

[0053]

图4示出了根据实施例的cva-cwda中的注意力块的详细处理。

[0054]

参考图4,注意力块将d

×h×

w图m重构为被重构的(wh)

×

d图mr和被重构和被转置的d

×

(wh)图m

rt

。然后将mr和m

rt

相乘,并且采用柔性最大(softmax)来获得d

×

d注意力图(即,注意力矩阵x∈r

(d

×

d)

),然后d

×

d注意力图与mr相乘,重构为4d,然后与m相加,以便输出d

×h×

w注意力-感知特征图y。

[0055]

图5示出了根据实施例的cva-dwca的处理。例如,可以由图1的cva模块103执行图5的处理。

[0056]

在图5中,n标识代价体的视差水平1至d中的每一个的3d图。y是对应于n的输出的基于注意力的代价体。注意力图是c

×

c,这能够针对代价体的不同通道显示关于视差的不同的注意力。

[0057]

参考图5,4d特征图被划分成d个3d特征图,每个3d特征图具有大小c

×h×

w(标记为n)。具体地,沿着cv的视差维度划分4d特征图cv∈r

(c

×d×h×

w)

,得到3d特征图cv={n1,

…

,nd},ni∈r

(c

×h×

w)

,1≤i≤d。

[0058]

此后,将视差注意力施加到注意力块n1至nd处的d个特征图中的每一个,以获得注意力-感知特征图yi∈r

(c

×h×

w)

。可以针对每个yi沿着通道维度计算注意力,这得到c

×

c注意力矩阵。

[0059]

然后将注意力-感知特征图级联回4d特征图cv’={y1,y2,

…

,yd}作为cva模块的输出。

[0060]

图6示出了根据实施例的cva-dwca中的注意力块的详细处理。

[0061]

参考图6,注意力块将c

×h×

w图n重构为被重构的(wh)

×

c图nr和被重构和被转置的c

×

(wh)图n

rt

。然后将nr和n

rt

相乘,并采用柔性最大来获得c

×

c注意力图(即,注意力矩阵x∈r

(c

×

c)

),然后c

×

c注意力图乘以nr,重构为4d,然后与n相加,以便输出c

×h×

w注意力-感知特征图y。

[0062]

在上述实施例中,cva-cwda和cva-dwca模块拍摄不同的信息。更具体地,cva-cwda试图找到不同视差水平之间的相关性。例如,如果输入图像是近景室内场景,则cva-cwda可以以大的视差水平强调代价体。然而,如果输入图像是室外场景,则cva-cwda可以以小的视差水平强调代价体。

[0063]

cva-dwca聚焦于代价体的不同通道之间的相关性,这在代价体(诸如,amnet中的扩展代价体)由多种类型的信息组成时可能是有用的。当代价体由特征图相关性和差异性组成时,cva-dwca可以修改代价体中使用的哪种信息对于特定图像更好。

[0064]

基于单分支注意力的cva

[0065]

单分支cva的概念直接作用于4d代价体。在计算注意力矩阵之前,高维特征图被“平坦化”为低维特征图。这通过一次性(one-shot)注意力模块来实现,其中,输入代价体被平坦化为2d特征图。

[0066]

下面,提供了用于为了注意力计算而使高维特征图平坦化的四种不同的方法,(a)cva-sbda、(b)cva-sbca、(c)cva-sbcdca和(d)cva-sbsa。

[0067]

图7示出了根据实施例的cva-sbda的处理。

[0068]

参考图7,cva-sbda的输入是4d特征图cv∈r

(c

×d×h×

w)

。cv被重构为2d(whc)

×

(d)图cvr∈r

((whc)

×

d)

,并且被重构并被转置为2d(d)

×

(whc)图cv

rt

∈r

(d

×

(whc))

。将cvr与cv

rt

相乘并且采用柔性最大,以便获得注意力矩阵x∈r

(d

×

d)

。d

×

d注意力矩阵x与cvr相乘,重构为4d,然后与cv相加,以便输出注意力-感知代价体cv’∈r

(c

×d×h×

w)

。

[0069]

图8示出了根据实施例的关于代价体的单分支通道注意力(cva-sbca)的处理。

[0070]

参考图8,cva-sbca的输入是4d特征图cv∈r

(c

×d×h×

w)

。cv被重构为2d(dwh)

×

(c)图cvr∈r

((dwh)

×

c)

,并且被重构并被转置为2d(c)

×

(dwh)图cv

rt

∈r

(c

×

(dwh))

。将cvr与cv

rt

相乘并且采用柔性最大,以便获得注意力矩阵x∈r

(c

×

c)

。c

×

c注意力矩阵x与cvr相乘,重构为4d,然后与cv相加,以便输出注意力-感知代价体cv’∈r

(c

×d×h×

w)

。

[0071]

图9示出了根据实施例的关于代价体的单分支组合的视差-通道注意力(cva-sbcdca)的处理。

[0072]

参考图9,cva-sbcdca的输入是4d特征图cv∈r

(c

×d×h×

w)

。cv被重构为2d(wh)

×

(cd)图cvr∈r

((wh)

×

(cd))

并且被重构并被转置为2d(cd)

×

(wh)图cv

rt

∈r

((cd)

×

(wh))

。将cvr与cv

rt

相乘并且采用柔性最大,以便获得注意力矩阵x∈r

((cd)

×

(cd))

。cd

×

cd注意力矩阵x与cvr相乘,重构为4d,然后与cv相加,以便输出注意力-感知代价体cv’∈r

(c

×d×h×

w)

。

[0073]

图10示出了根据实施例的关于代价体的单分支空间注意力(cva-sbsa)的处理。

[0074]

参考图10,cva-sbsa的输入是4d特征图cv∈r

(c

×d×h×

w)

。cv被重构为2d(cd)

×

(wh)图cvr∈r

((cd)

×

(wh))

并且被重构并被转置为2d(wh)

×

(cd)图cv

rt

∈r

((wh)

×

(cd))

。将cvr与cv

rt

相乘并且采用柔性最大,以便获得注意力矩阵x∈r

((wh)

×

(wh))

。wh

×

wh注意力矩阵与cvr相乘,重构为4d,然后与cv相加,以便输出注意力-感知代价体cv’∈r

(c

×d×h×

w)

。

[0075]

在比较上述实施例时,cva-sbda和cva-sbca与cva-cwda和cva-dwca具有相同大小注意力矩阵,但是它们的注意力矩阵是从代价体的所有通道计算的,而不是从多分支cva计算的,其中,在多分支cva中,在每个通道计算注意力矩阵。由于注意力矩阵的大小没有改变,因此它们的计算消耗是相似的。

[0076]

cva-sbcdca具有大小为cd

×

cd的注意力矩阵,这是视差水平和通道之间的一种组合注意力,但导致高得多的计算消耗。

[0077]

cva-sbsa具有大小为wh

×

wh的注意力矩阵,这是一种空间注意力,其也具有较高的计算消耗。

[0078]

双重代价体注意力

[0079]

双重代价体注意力的概念可以利用上述cva模块中的任何两个。由于通过一起使用两个cva模块来构造双重注意力,因此可以利用顺序排列或并行排列。

[0080]

图11示出了根据实施例的利用顺序排列和并行排列的双重代价体注意力的处理。

[0081]

参考图11,在顺序排列流程(a)中,串行使用两个cva模块,并且在并行排列流程(b)中,并行使用两个cva模块,并且将其结果组合以提供最终代价体估计。由于不同的注意力矩阵捕获不同的信息,因此,如图11所示,可以通过以顺序排列或并行排列组织cva来利用双重代价体注意力。

[0082]

代价聚合

[0083]

代价聚合模块将通过输入注意力-感知代价体来输出视差图。它可以通过任何现有的代价聚合模块来实现(诸如,如图1的组件101、102和104所示的引导聚合网络(guided aggregation net,ganet)中的半全局(semi-global)类似的代价聚合,或者如图1的组件101、102、104所示的堆叠空洞多尺度(stacked atrous multi-scale,am))。

[0084]

视差融合

[0085]

为了进一步提高准确性和鲁棒性,可以在不同的视差范围上训练两个网络。这两个网络中的二者都可以使用相同的特征提取/代价体/代价注意力/代价聚合,但是使用不同的最大视差范围。

[0086]

例如,两个网络(cvanet)可以基于两个常用的主干(amnet和ganet)。

[0087]

amnet使用残差网络-50(resnet-50)的深度(depthwise)可分离版本作为特征提取器,残差网络-50(resnet-50)的深度(depthwise)可分离版本之后是以多个尺度捕获深度全局上下文信息的am模块。可以针对代价聚合采用同时计算不同代价匹配度量的扩展代价体(ecv)。ecv的输出可以由堆叠am模块处理以输出最终视差。

[0088]

ganet通过沙漏网络实现特征提取器,并使用特征图相关性作为代价体。ganet设计了半全局引导聚合(semi-global guided aggregation,sga)层,半全局引导聚合层实现了半全局匹配的可微分近似,并沿整个图像上的不同方向聚合匹配代价。这允许对遮挡和反射区域进行准确的估计。

[0089]

更具体地,第一cvanet在视差范围[0,a]上被训练,并且输出第一视差图其中,p

1,i

是当i<a时像素具有估计的视差等于i的概率,并且p

1,i

是当i=a时像素具有估计的视差大于或等于a的概率。

[0090]

在全视差范围[0,b]上训练第二cvanet,其中,a<b,并且第二cvanet输出第二视差图其中,p

2,i

是当i<b时像素具有估计的视差等于i的概率,并且p

2,i

是当i=b时像素具有估计的视差大于或等于b的概率。

[0091]

可以直接使用基于d1和d2的视差组合或者利用概率向量p

1,i

,p

2,i

的软组合(或概率组合)来融合d1和d2。

[0092]

当视差组合时,可以将最终输出视差d

fused

获得为如下的简单加权和:

[0093][0094][0095]

w1和w2是位于[0,1]之间的常数。由验证结果设置。

[0096]

当软组合时,在概率向量上如下发生融合,其中,w1、w2和w3是位于[0,1]之间的常数:

[0097][0098]

应进一步将p

fused,i

归一化为

[0099]

基于软组合的最终视差输出可以由下式表示:

[0100][0101]

使用单个模型,上述过程可以针对室内和室外场景二者生成合理的视差输出。

[0102]

下面在表1中提供了具有不同注意力模块的cvanet的准确度和效率(ae)比较,这示出了多分支注意力模块通常具有比单分支注意力模块更好的准确度/效率。

[0103]

表1

[0104][0105]

注意力图还示出了对于具有不同场景的图像,上述代价-体注意力模块工作良好。

[0106]

图12示出了根据实施例的展示代价-体注意力模块的有效性的曲线图。

[0107]

参考图12,为了展示上述技术的有效性,最上面一行中的曲线图(a)至(c)示出了注意力矩阵(d

×

d)的值的列向总和,列向总和提供与底部行中的曲线图(d)至(f)中的视差分布一致的图案。

[0108]

图13示出了根据一个实施例的网络环境中的电子装置的框图。

[0109]

参考图13,网络环境1300中的电子装置1301可经由第一网络1398(例如,短距离无线通信网络)与电子装置1302通信,或经由第二网络1399(例如,远距离无线通信网络)与电子装置1304或服务器1308通信。电子装置1301可经由服务器1308与电子装置1304通信。电子装置1301可以包括处理器1320、存储器1330、输入装置1350、声音输出装置1355、显示装置1360、音频模块1370、传感器模块1376、接口1377、触觉模块1379、相机模块1380、电源管理模块1388、电池1389、通信模块1390、用户识别模块(sim)1396或天线模块1397。在一个实施例中,可以从电子装置1301省略组件中的至少一个(例如,显示装置1360或相机模块1380),或者可以将一个或多个其他组件添加到电子装置1301。在一个实施例中,一些组件可以被实现为单个集成电路(ic)。例如,可以在显示装置1360(例如,显示器)中嵌入传感器模块1376(例如,指纹传感器、虹膜传感器或照度传感器)。

[0110]

处理器1320可以执行例如软件(例如,程序1340)以控制与处理器1320结合的电子装置1301的至少一个其他组件(例如,硬件或软件组件),并且可以执行各种数据处理或计算。作为数据处理或计算的至少一部分,处理器1320可以将从另一组件(例如,传感器模块1376或通信模块1390)接收的命令或数据加载在易失性存储器1332中,处理存储在易失性存储器1332中的命令或数据,并将结果数据存储在非易失性存储器1334中。处理器1320可以包括主处理器1321(例如,中央处理单元(cpu)或应用处理器(ap))以及可独立于主处理器1321操作或与主处理器1321一起操作的辅助处理器1323(例如,图形处理单元(gpu)、图像信号处理器(isp)、传感器集线器处理器或通信处理器(cp))。另外地或可替代地,辅助处理器1323可以被调整为比主处理器1321消耗更少的功率,或者执行特定功能。辅助处理器1323可以被实现为与主处理器1321分离或者是主处理器1321的一部分。

[0111]

辅助处理器1323可以在主处理器1321处于非活动(例如,睡眠)状态时替代主处理器1321控制与电子装置1301的组件中的至少一个组件(例如,显示装置1360、传感器模块1376或通信模块1390)相关的至少一些功能或状态,或者在主处理器1321处于活动状态(例如,执行应用)时与主处理器1321一起控制与电子装置1301的组件中的至少一个组件(例如,显示装置1360、传感器模块1376或通信模块1390)相关的至少一些功能或状态。根据一个实施例,辅助处理器1323(例如,图像信号处理器或通信处理器)可以被实现为在功能上与辅助处理器1323相关的另一组件(例如,相机模块1380或通信模块1390)的一部分。

[0112]

存储器1330可以存储由电子装置1301的至少一个组件(例如,处理器1320或传感器模块1376)使用的各种数据。各种数据可以包括例如软件(例如,程序1340)和用于与其相关的命令的输入数据或输出数据。存储器1330可以包括易失性存储器1332或非易失性存储器1334。

[0113]

程序1340可以作为软件存储在存储器1330中,并且可以包括例如操作系统(os)1342、中间件1344或应用1346。

[0114]

输入装置1350可从电子装置1301的外部(例如,用户)接收要由电子装置1301的另一组件(例如,处理器1320)使用的命令或数据。输入装置1350可以包括例如麦克风、鼠标或键盘。

[0115]

声音输出装置1355可将声音信号输出到电子装置1301的外部。声音输出装置1355可以包括例如扬声器或接收器。扬声器可以用于一般目的(诸如,播放多媒体或记录),并且接收器可以用于接收来电。根据一个实施例,接收器可以被实现为与扬声器分离或者扬声

器的一部分。

[0116]

显示装置1360可以在视觉上提供信息到电子装置1301的外部(例如,用户)。显示装置1360可以包括例如显示器、全息装置或投影仪以及控制显示器、全息装置和投影仪中的相应一个的控制电路。根据一个实施例,显示装置1360可以包括适于检测触摸的触摸电路,或者适于测量由触摸引起的力的强度的传感器电路(例如,压力传感器)。

[0117]

音频模块1370可以将声音转换为电信号,反之亦然。根据一个实施例,音频模块1370可经由输入装置1350获得声音,或经由声音输出装置1355或与电子装置1301直接(例如,有线)或无线结合的外部电子装置1302的耳机输出声音。

[0118]

传感器模块1376可以检测电子装置1301的操作状态(例如,功率或温度)或电子装置1301外部的环境状态(例如,用户的状态),然后生成与检测到的状态相对应的电信号或数据值。传感器模块1376可以包括例如姿态传感器、陀螺仪传感器、大气压传感器、磁传感器、加速度传感器、握持传感器、接近传感器、颜色传感器、红外(ir)传感器、生物传感器、温度传感器、湿度传感器或照度传感器。

[0119]

接口1377可以支持用于电子装置1301直接(例如,有线)或无线地与外部电子装置1302结合的一个或多个指定协议。根据一个实施例,接口1377可以包括例如高清晰度多媒体接口(hdmi)、通用串行总线(usb)接口、安全数字(sd)卡接口或音频接口。

[0120]

连接终端1378可以包括连接器,电子装置1301可以经由该连接器与外部电子装置1302物理连接。根据一个实施例,连接终端1378可以包括例如hdmi连接器、usb连接器、sd卡连接器或音频连接器(例如,耳机连接器)。

[0121]

触觉模块1379可以将电信号转换为可以由用户经由触感或动觉识别的机械刺激(例如,振动或运动)或电刺激。根据一个实施例,触觉模块1379可以包括例如马达、压电元件或电刺激器。

[0122]

相机模块1380可以拍摄静止图像或运动图像。根据一个实施例,相机模块1380可以包括一个或多个镜头、图像传感器、图像信号处理器或闪光灯。

[0123]

电源管理模块1388可管理供应给电子装置1301的电源。电源管理模块1388可以被实现为例如电源管理集成电路(pmic)的至少一部分。

[0124]

电池1389可以向电子装置1301的至少一个组件供电。根据一个实施例,电池1389可以包括例如不可再充电的原电池、可再充电的蓄电池或燃料电池。

[0125]

通信模块1390可支持在电子装置1301与外部电子装置(例如,电子装置1302、电子装置1304或服务器1308)之间建立直接(例如,有线)通信信道或无线通信信道,并经由所建立的通信信道执行通信。通信模块1390可以包括可独立于处理器1320(例如,ap)操作并且支持直接(例如,有线)通信或无线通信的一个或多个通信处理器。根据一个实施例,通信模块1390可以包括无线通信模块1392(例如,蜂窝通信模块、短距离无线通信模块或全球导航卫星系统(gnss)通信模块)或有线通信模块1394(例如,局域网(lan)通信模块或电力线通信(plc)模块)。这些通信模块中的对应通信模块可经由第一网络1398(例如,短距离通信网络(诸如,蓝牙

tm

、无线保真(wi-fi)直连或红外数据协会(irda)标准))或第二网络1399(例如,远距离通信网络(诸如,蜂窝网络、互联网或计算机网络(例如,lan或广域网(wan)))与外部电子装置通信。这些各种类型的通信模块可以被实现为单个组件(例如,单个ic),或者可以被实现为彼此分离的多个组件(例如,多个ic)。无线通信模块1392可以使用存储在用

户识别模块1396中的用户信息(例如,国际移动用户身份(imsi))来识别和认证通信网络(诸如,第一网络1398或第二网络1399)中的电子装置1301。

[0126]

天线模块1397可以向电子装置1301的外部(例如,外部电子装置)发送信号或功率或者从电子装置1301的外部(例如,外部电子装置)接收信号或功率。根据一个实施例,天线模块1397可以包括一个或多个天线,并且由此,适合于在诸如第一网络1398或第二网络1399的通信网络中使用的通信方案的至少一个天线可以例如由通信模块1390(例如,无线通信模块1392)选择。然后可以经由所选择的至少一个天线在通信模块1390和外部电子装置之间发送或接收信号或功率。

[0127]

上述组件中的至少一些可以相互结合并且经由外设通信方案(例如,总线、通用输入和输出(gpio)、串行外设接口(spi)或移动工业处理器接口(mipi))在它们之间通信信号(例如,命令或数据)。

[0128]

根据一个实施例,可以经由与第二网络1399结合的服务器1308在电子装置1301和外部电子装置1304之间发送或接收命令或数据。电子装置1302及1304中的每一个可以是与电子装置1301相同类型或不同类型的装置。可以在外部电子装置1302或1304中的一个或更多个处执行要在电子装置1301处执行的所有或一些操作。例如,如果电子装置1301应该自动执行功能或服务,或者响应于来自用户或另一装置的请求,则电子装置1301可以请求一个或多个外部电子装置执行功能或服务的至少一部分,而不是执行功能或服务,或者除了执行功能或服务之外,还可以请求一个或多个外部电子装置执行功能或服务的至少一部分。接收请求的一个或多个外部电子装置可以执行所请求的功能或服务的至少一部分,或者与请求相关的附加功能或附加服务,并将执行的结果传送到电子装置1301。电子装置1301可以在对结果进行进一步处理或不进行进一步处理的情况下提供结果,作为对该请求的答复的至少一部分。为此,例如,可以使用云计算、分布式计算或客户端-服务器计算技术。

[0129]

一个实施例可被实现为包括一个或多个指令的软件(例如,程序1340),该一个或多个指令被存储在可由机器(例如,电子设备1301)读取的存储介质(例如,内部存储器1336或外部存储器1338)中。例如,电子装置1301的处理器可以调用存储在存储介质中的一个或多个指令中的至少一个,并且在处理器控制下使用或不使用一个或多个其他组件的情况下执行它。因此,可以操作机器以根据所调用的至少一个指令来执行至少一个功能。一个或多个指令可以包括由编译器生成的代码或可由解释器执行的代码。可以以非暂时性存储介质的形式提供机器可读存储介质。术语“非暂时性”指示:存储介质是有形装置,并且不包括信号(例如,电磁波),但是该术语不区分数据半永久地存储在存储介质中还是数据临时地存储在存储介质中。

[0130]

根据一个实施例,可以在计算机程序产品中包括和提供本公开的方法。计算机程序产品可以作为产品在卖方和买方之间交易。计算机程序产品可以以机器可读存储介质(例如,光盘只读存储器(cd-rom))的形式分发,或者经由应用商店(例如,playstore

tm

)在线分发(例如,下载或上传),或者直接在两个用户装置(例如,智能电话)之间分发。如果在线分发,则可以在诸如制造商的服务器的存储器、应用商店的服务器或中继服务器的机器可读存储介质中,临时生成或至少临时存储计算机程序产品的至少一部分。

[0131]

根据一个实施例,上述组件的每个组件(例如,模块或程序)可以包括单个实体或

多个实体。可以省略上述组件中的一个或多个,或者可以添加一个或多个其他组件。可替代地或另外地,多个组件(例如,模块或程序)可以集成到单个组件中。在这种情况下,集成组件仍然可以以与在集成之前由多个组件中的相应一个组件执行的功能相同或相似的方式,执行多个组件中的每一个的一个或多个功能。由模块、程序或另一组件执行的操作可以顺序地、并行地、重复地或启发式地被执行,或者可以以不同的顺序执行或省略一个或多个操作,或者可以添加一个或多个其他操作。

[0132]

尽管已经在本公开的具体实施方式中描述了本公开的某些实施例,但是在不脱离本公开的范围的情况下,可以以各种形式修改本公开。因此,本公开的范围不应仅基于所描述的实施例来确定,而是基于所附权利要求及其等同物来确定。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。