1.本技术涉及文本检索技术领域,特别是涉及一种基于对比学习的长文本检索模型。

背景技术:

2.用户输入一段包含案件基本事实的长文本如起诉状、上诉状以及裁判案例等,检索系统从数据库中返回与该文本在基本事实、争议焦点、法律适用问题等方面具有相似性的裁判文书,并按照相关程度进行排序返回。无论是法律相关人士如从业律师、公司法务或司法人员,还是普通民众,都对法律检索有很大的需求,其价值不言而喻。

3.类案检索问题面临的首要难点就是文本过长,一般检索场景中查询语句较短,而类案检索中的查询文本往往多达上千字,传统检索模型往往基于关键字进行字面匹配,虽不限制文本的长度,但对于分词准确度有较高要求,且无法处理词语之间语义相关性,而一般的深度学习模型对于输入长度有限制,随着输入长度的增加,计算的时间和空间成本急剧增加;另一方面,长文本检索面临着检索效率的瓶颈,传统检索模型在查询文本过长、数据库中候选案例数量过多的情况下,需要耗费大量时间进行计算,基于交互的深度学习模型在这种场景下将产生大量的交互计算,耗费不可承受的时间和空间资源,同样不适用。

技术实现要素:

4.本技术提供了一种基于对比学习的长文本检索模型,所述长文本检索模型包括法律领域预训练模块、对比学习模块以及检索模块;其中,

5.所述法律领域预训练模块,用于构建基础的长文本编码器,以及使用法律文书语料对所述长文本编码器进行领域预训练;

6.所述对比学习模块,用于从案例标注数据集中构造训练数据,以及利用所述训练数据对所述长文本编码器进行文本向量训练,其中,所述训练数据包括查询语句及其正样本、负样本;

7.所述检索模块,用于采用训练好的长文本编码器检测长文本查询语句对应的案例。

8.其中,所述检索模块,还用于利用所述长文本编码器将查询语句转换为查询向量,与案例库中所有案例的案例向量计算相似度,从而基于相似度得分高低返回检索排序结果。

9.其中,所述检索模块,还用于将数据库中的所有案例经过所述长文本编码器编码后得到对应的案例向量,并对所有案例向量进行聚类后,离线存储形成所述案例库。

10.其中,所述检索模块,还用于计算所述查询向量与所述案例库中的所有聚类中心的距离,获取距离最小的聚类中心对应的聚类,将该聚类中的所有案例向量按照与所述案例向量的距离大小进行排序,并以排序结果返回检索排序结果。

11.其中,所述法律领域预训练模块,还用于以中文预训练模型为基础构建所述长文

本编码器;

12.其中,所述中文预训练模型事先使用大量法律无标签语料进行全词遮罩预训练。

13.其中,所述法律领域预训练模块,还用于将所述中文预训练模型的完全注意力机制替换为滑动窗口注意力机制和全局注意力机制。

14.其中,所述法律领域预训练模块,还用于将所述完全注意力机制中的查询参数、键参数以及值参数复制到所述长文本编码器的滑动窗口注意力机制和全局注意力机制中,以实现所述长文本编码器的参数初始化。

15.其中,所述全词遮罩预训练为:将法律语料中预设比例的词汇进行遮罩标记处理和替换词汇处理,并采用所述长文本编码器对处理后的法律语料进行编码,得到预测输出词,以所述预测输出词与法律语料的距离对所述长文本编码器进行训练。

16.其中,所述中文预训练模型为roberta-wwm-ext模型,所述长文本编码器为longformer模型。

17.其中,所述对比学习模块,还用于从所述案例标注数据集中选择查询语句,及其正样本、负样本构造三元组,其中,所述正样本为所述查询语句相关的案例,所述负样本为所述查询语句不相关的案例;

18.所述对比学习模块,还用于将所述三元组输入所述长文本编辑器进行编码,得到所述三元组的向量表示;基于所述查询语句的向量与所述正样本的向量构建正相似度矩阵,基于所述查询语句的向量与所述负样本的向量构建负相似度矩阵,利用所述正相似度矩阵和所述负相似度矩阵构建交叉熵损失函数对所述长文本编辑器进行训练。

19.本技术的有益效果是:长文本检索模型,包括法律领域预训练模块、对比学习模块以及检索模块;其中,法律领域预训练模块,用于构建基础的长文本编码器,以及使用法律文书语料对长文本编码器进行领域预训练;对比学习模块,用于从案例标注数据集中构造训练数据,以及利用训练数据对所述长文本编码器进行文本向量训练,其中,训练数据包括查询语句及其正样本、负样本;检索模块,用于采用训练好的长文本编码器检测长文本查询语句对应的案例。通过上述方式,本技术的长文本检索模型能够有效解决深度模型处理长文本的问题,结合类案检索的特点,使用领域预训练以及对比学习方法对文档编码器进行调整,提高了检索的准确度和效率。

附图说明

20.为了更清楚地说明本发明实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。其中:

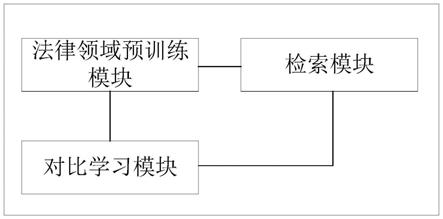

21.图1是本技术提供的一种基于对比学习的长文本检索模型一实施例的框架示意图;

22.图2是本技术提供的一种基于对比学习的长文本检索模型另一实施例的框架示意图。

具体实施方式

23.下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅是本技术的一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

24.类案检索是法律领域的一个特定检索需求,旨在根据用户提供的长文本如起诉状、裁判案例等,从数据库中检索相似案例并返回排序结果,一个好的类案检索系统可以给用户提供类似案件判决信息等有价值的法律参考,因此实现一个针对法律领域的长文本检索模型具有重要的研究价值。长文本匹配算法是法律类案检索功能的核心,传统信息检索场景中查询语句比较短,而作为查询的长文本具有更加丰富的语义信息和逻辑结构,如何学习长文本的语义表示是问题的关键所在。

25.针对长文本检索存在的难点,本技术提出了一种基于对比学习的长文本检索模型,采用基于表示型模型架构,将文本编码成一个固定维度向量,通过向量之间的距离衡量文本间的相关度,提高检索效率;使用面向长文本的基于稀疏自注意力机制的预训练语言模型(longformer)作为基础文档编码器,扩展输入序列长度上限至上千字,同时降低注意力机制计算复杂度,经过法律领域预训练和对比学习的方法训练模型捕获长文本语义特征。综合来说,本技术提出的长文本检索模型兼顾检索精度和速度,可被有效应用于查询文本较长的语义检索场景当中,解决模型对输入文本长度的限制问题,并通过对比学习方法获得高质量的文档语义表达,使得长文本检索兼具较高的准确度和效率,有着广阔的应用前景。

26.具体请参阅图1,图1是本技术提供的一种基于对比学习的长文本检索模型一实施例的框架示意图。

27.具体而言,本技术提供的长文本检索模型主要包括法律领域预训练模块、对比学习模块以及检索模块,有效解决了深度模型处理长文本的问题,结合类案检索的特点,使用领域预训练以及对比学习方法对文档编码器进行调整,提高了检索的准确度和效率。

28.具体地,法律领域预训练模块,通过使用面向长文本的基于稀疏自注意力机制的深度模型(longformer)作为基础编码器,以基于全词遮罩技术的中文预训练模型(roberta-wwm-ext)参数为基础,扩展位置编码构建长文本编码器(longformer)基础,使用法律文书语料进行领域预训练,提高编码器对于领域知识的适应性。

29.对比学习模块,由法律检索标注数据集构造正负样本三元组作为训练数据,采用基于表示的框架,每个案例文本被长文本编码器单独编码为一个向量,通过向量之间的相似度计算构建相似度矩阵,计算交叉熵损失函数进行反向传播参数更新。

30.检索模块,由领域预训练和对比学习训练后的长文本编码器(longformer)作为最终的模型,将数据库中所有案例文书经该长文本编码器编码成文档向量,同时将查询文本转换成查询向量,与案例库中所有向量计算相似度,通过近似最近邻搜索按照得分高低返回检索排序结果。

31.请继续参阅图2,图2是本技术提供的一种基于对比学习的长文本检索模型另一实施例的框架示意图。下面结合图2的图示,对本技术提出的基于对比学习的长文本检索模型中的各个模块的内容进行详细描述。

32.法律领域预训练模块:

33.首先,以基于全词遮罩技术的预训练模型(roberta-wwm-ext)为基础构造面向长文本的双向编码模型(longformer)。

34.为了实现输入序列长度的增加,一方面需拓展位置编码长度,分段复制原模型512个位置编码至长度4096;另一方面需替换原模型的完全注意力机制(full attention)为滑动窗口注意力机制(sliding window attention)和全局注意力机制(global attention)。其中,滑动窗口注意力机制,即每个词只与周围窗口内的词计算注意力得分,全局注意力机制,即仅在某些特殊位置与整段文本的词进行交互。通过将完全注意力机制替换为滑动窗口注意力机制和全局注意力机制可以增加注意力机制的灵活性,同时大大减少计算的复杂度,从而降低时间和空间开销。

35.具体地,完全注意力机制公式如下:

[0036][0037]

其中,q矩阵表示query(查询),k矩阵表示key(键),v矩阵代表value(值)。

[0038]

本技术的法律领域预训练模块将上述完全注意力机制响应的q矩阵参数、k矩阵参数、v矩阵参数复制至长文本编码器的滑动窗口注意力机制和全局注意力机制,从而实现整个长文本编码器的参数初始化。

[0039]

需要说明的是,中文预训练模型(roberta-wwm-ext)已在海量的中文语料上进行过全词遮罩训练。为了提升长文本编码器(longformer)对法律领域知识的感知能力以及在下游任务中的性能,本技术进一步在大量法律无标签语料上进行领域预训练。

[0040]

例如,可以选取约28万条法律文书,每条文书去除了首尾的无用信息,仅保留案情描述和法院认为部分,在掩码语言模型任务(mlm,masked language modeling)上进行训练,即对于输入句子,对15%的词进行随机掩码(mask)并预测,这15%词汇的输入有80%被替换为[mask]特殊标记,10%被替换为其他词,10%保持不变。

[0041]

具体做法为,一段文本的字符序列d[d1,d2,d3,...,dn],经长文本编码器(longformer)后被转换成向量序列v[v1,v2,v3,...,vn],通过平均池化层(average pooling)将向量序列聚合为单个向量代表整段文本,通过全连接网络(fully connected network)和归一化指数函数(softmax)预测输出词。

[0042]

其中,文本向量生成公式具体如下:

[0043]

[v1,v2,...,vn]=longformer([d1,d2,...,dn])

[0044]

vd=average_pooling([v1,v2,...,vn])

[0045]

本技术的法律领域预训练模块使用了长文本编码器(longformer)来编码法律文书,使得模型能够一次性输入上千字的长文本,采用稀疏注意力机制降低模型运算的复杂度和计算成本,通过平均池化层(average pooling)聚合编码器最后一层的信息,得到最终文档表达。进一步地,法律领域预训练模块采用了领域预训练来增强长文本编码器(longformer)对于法律领域专业知识的感知能力,不仅能够利用大规模中文语料上学习到的通用知识,而且可通过领域预训练进一步获取法律专业知识,从而提高模型在下游任务中的表现。

[0046]

对比学习模块:

[0047]

为了进一步提升长文本编码器(longformer)生成文档向量的质量,缓解其原生句子表示的各向异性,使其与下游相似度任务的数据分布更加适配,本技术提出了使用对比学习对长文本编码器进行微调。从案例标注数据集中构造训练数据,对于某查询文本,与其相关的案例为正样本而不相关的为负样本,从而每条查询与其正负样本构成一个三元组

[0048]

对于一批训练数据,xi的正样本仅为而负样本除外还包含其他文本的正负样本。每条文本通过长文本编码器(longformer)编码后经平均池化层得向量表示,经余弦相似度计算构建相似度矩阵,矩阵每一行代表xi与同批数据的所有和的相似度得分,训练目标为交叉熵:

[0049][0050]

其中,hi表示第i个查询文本,表示第i个正样本,表示第j个正样本,表示第j个负样本。

[0051]

本技术通过上述对比学习的训练,可以提高模型生成向量的对齐性(alignment)以及均匀性(uniformity),即相近实例之间有相近的特征且向量表示在空间中分布更加均匀,从而使得向量之间的相似度计算可以很好地代表文本间的相似度。

[0052]

本技术的对比学习模块通过对比学习的方法对长文本编码器(longformer)进行微调训练,使得模型更好地学习长文本信息,有效缓解向量坍缩现象,生成更高质量的向量表达,采用了对比学习框架来训练长文本编码器(longformer),提高了生成向量的对齐性和各向同性,使得其在向量空间中分布更加均匀,从而提升了模型的语义表达能力。

[0053]

检索模块:

[0054]

经领域预训练和对比学习训练后的长文本编码器(longformer)已经能较好地捕获长文本的语义并生成高质量的向量表达。为了提高检索的效率,将数据库中的所有案例经长文本编码器(longformer)和平均池化后得到对应的文档向量,离线存储和并进行聚类,即将所有的向量划分至n个单元。

[0055]

当查询来临时,对查询文本按照相同方式生成查询向量,比较查询向量与n个单元的单元中心的距离,从中选择最近的m个单元。然后,比较被选中单元中的所有向量,这种近似最近邻方法(anns,approximate nearest neighbors search)在检索时返回的结果并不一定是与查询向量最近的结果,即牺牲了一定的精度,但仍在可接受范围内,且将大大提高检索的效率。

[0056]

本技术的检索模块采用了后交互式的向量检索框架,对数据库中的案例生成离线向量并聚类,使用近似最近邻方法进行向量匹配,在保持准确度的基础上大大提升了检索的效率。

[0057]

以上所述仅为本技术的实施方式,并非因此限制本技术的专利范围,凡是利用本技术说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的

技术领域,均同理包括在本技术的专利保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。