语音生成方法、装置、电子设备及计算机可读存储介质与流程

- 国知局

- 2024-06-21 10:38:58

本申请涉及语音生成领域,尤其涉及一种语音生成方法、装置、电子设备及计算机可读存储介质。

背景技术:

1、目前,现有的混响仿真技术难以完全模拟真实声学环境,生成的仿真混响语音数据与真实数据之间存在显著差异,会导致语音模型在训练过程中的泛化能力不够,训练完成的语音模型基于真实场景生成的混响语音数据的准确性较低。

技术实现思路

1、本申请实施例提供一种语音生成方法、装置、电子设备及计算机可读存储介质,可以提高真实场景中混响语音生成的准确性和提升模型的泛化能力。

2、本申请实施例的技术方案是这样实现的:

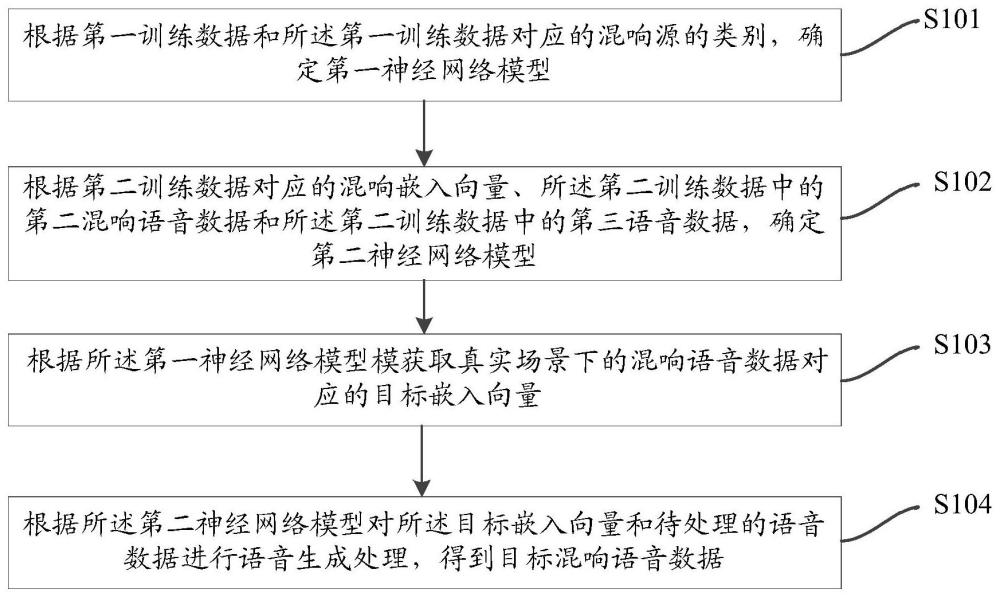

3、第一方面,本申请实施例提供一种语音生成方法,包括:

4、根据第一训练数据和所述第一训练数据对应的混响源的类别,确定第一神经网络模型;

5、根据第二训练数据对应的混响嵌入向量、所述第二训练数据中的第二混响语音数据和所述第二训练数据中的第三语音数据,确定第二神经网络模型;

6、根据所述第一神经网络模型模获取真实场景下的语音数据对应的目标嵌入向量;

7、根据所述第二神经网络模型对所述目标嵌入向量和待处理的语音数据进行语音生成处理,得到目标混响语音数据。

8、在上述方案中,所述根据第一训练数据和所述第一训练数据对应的混响源的类别,确定第一神经网络模型,包括:

9、根据混响场景的参数生成至少两个类别的混响源;

10、将第一语音数据合成与所述混响源对应的混响效果,得到所述第一训练数据。

11、在上述方案中,所述根据第一训练数据和所述第一训练数据对应的混响源的类别,确定第一神经网络模型,包括:

12、对所述第一训练数据进行分帧处理,获取每个数据帧对应的声学特征;

13、针对所述第一训练数据中的每个音频数据,获取所述音频数据对应的所有数据帧的声学特征;

14、基于所述声学特征和所述音频数据对应的混响源的类别构建训练数据对;

15、根据所述训练数据对训练所述第一神经网络模型。

16、在上述方案中,所述根据第二训练数据对应的混响嵌入向量、所述第二训练数据中的第二混响语音数据和所述第二训练数据中的第三语音数据,确定第二神经网络模型,包括:

17、根据第二语音数据、第三语音数据和所述混响源,确定第二训练数据,所述第二语音数据的数据量和所述第三语音数据的数据量相同;

18、根据所述第一神经网络获取所述第二训练数据对应的混响嵌入向量;

19、根据所述第二训练数据和所述混响嵌入向量,训练所述第二神经网络模型。

20、在上述方案中,所述根据第二语音数据、第三语音数据和所述混响源,确定第二训练数据,包括:

21、针对每个类别的混响源,将所述第二语音数据中的数据合成所述混响源的混响效果,生成第二混响语音数据;

22、将所述第三语音数据中的数据合成所述混响源对应的混响效果,生成第三混响语音数据;

23、将所述第二混响语音数据、第三混响语音数据和第三语音数据所组成的集合确定为第二训练数据中的样本数据。

24、在上述方案中,所述根据所述第一神经网络获取所述第二训练数据对应的混响嵌入向量,包括:

25、对所述第二训练数据进行分帧处理,获取每个数据帧对应的声学特征;

26、针对所述第二训练数据中的每个样本中的第二混响语音数据对应的音频数据,获取所述音频数据对应的所有数据帧的声学特征;

27、根据所述第一神经网络模型获取所述声学特征对应的混响嵌入向量。

28、在上述方案中,所述根据所述第二训练数据和所述混响嵌入向量,训练所述第二神经网络模型,包括:

29、根据第二训练数据中第三混响语音数据和第三语音数据,以及所述混响嵌入向量,确定新的训练样本数据;

30、根据新的训练样本数据训练所述第二神经网络模型。

31、第二方面,本申请实施例提供一种语音生成装置,所述语音生成装置包括:

32、第一训练模块,用于根据第一训练数据和所述第一训练数据对应的混响源的类别,确定第一神经网络模型;

33、第二训练模块,用于根据第二训练数据对应的混响嵌入向量、所述第二训练数据中的第二混响语音数据和所述第二训练数据中的第三语音数据,确定第二神经网络模型;

34、嵌入向量获取模块,用于根据所述第一神经网络模型模获取真实场景下的语音数据对应的目标嵌入向量;

35、语音生成模块,用于根据所述第二神经网络模型对所述目标嵌入向量和待处理的语音数据进行语音生成处理,得到目标混响语音数据。

36、第三方面,本申请实施例提供一种电子设备,所述电子设备包括:至少一个处理器;以及与所述至少一个处理器通信连接的存储器;其中,所述存储器存储有可被所述至少一个处理器执行的指令,所述指令被所述至少一个处理器执行,以使所述至少一个处理器能够执行本申请实施例提供的语音生成方法。

37、第四方面,本申请实施例提供一种计算机可读存储介质,所述存储介质包括一组计算机可执行指令,当所述指令被执行时用于执行本申请实施例提供的语音生成方法。

38、本申请实施例提供的语音生成方法,根据第一训练数据和所述第一训练数据对应的混响源的类别,确定第一神经网络模型;根据第二训练数据对应的混响嵌入向量、所述第二训练数据中的第二混响语音数据和所述第二训练数据中的第三语音数据,确定第二神经网络模型;根据所述第一神经网络模型模获取真实场景下的语音数据对应的目标嵌入向量;根据所述第二神经网络模型对所述目标嵌入向量和待处理的语音数据进行语音生成处理,得到目标混响语音数据。本申请中的语音生成方法通过基于第一训练数据和第一训练数据对应的混响源的类别确定第一神经网络模型,能够使得第一神经网络学习混响语音数据中的混响嵌入向量;通过基于第二训练数据中的第二混响语音数据和第二训练数据中的第三语音数据和第二训练数据对应的混响嵌入向量确定第二神经网络模型,能够使第二神经网络基于混响嵌入向量生成混响语音数据。通过第一神经网络模型获取真实场景下的语音数据对应的目标嵌入向量,通过第二神经网络模型基于目标嵌入向量将待处理的语音数据处理为对应的目标混响语音数据,不仅可以提高真实场景中混响语音生成的准确性,而且可以提升模型的泛化能力。

技术特征:1.一种语音生成方法,其特征在于,所述方法包括:

2.根据权利要求1所述的方法,其特征在于,所述根据第一训练数据和所述第一训练数据对应的混响源的类别,确定第一神经网络模型,包括:

3.根据权利要求1所述的方法,其特征在于,所述根据第一训练数据和所述第一训练数据对应的混响源的类别,确定第一神经网络模型,包括:

4.根据权利要求1所述的方法,其特征在于,根据第二训练数据对应的混响嵌入向量、所述第二训练数据中的第二混响语音数据和所述第二训练数据中的第三语音数据,确定第二神经网络模型,包括:

5.根据权利要求4所述的方法,其特征在于,所述根据第二语音数据、第三语音数据和所述混响源,确定第二训练数据,包括:

6.根据权利要求4所述的方法,其特征在于,所述根据所述第一神经网络获取所述第二训练数据对应的混响嵌入向量,包括:

7.根据权利要求4所述的方法,其特征在于,所述根据所述第二训练数据和所述混响嵌入向量,训练所述第二神经网络模型,包括:

8.一种语音生成装置,其特征在于,所述装置包括:

9.一种电子设备,其特征在于,所述电子设备包括:

10.一种计算机可读存储介质,其特征在于,所述存储介质包括一组计算机可执行指令,当所述指令被执行时用于执行权利要求1-7任一项所述的语音生成方法。

技术总结本申请提供了一种语音生成方法、装置、电子设备及计算机可读存储介质;所述方法包括:根据第一训练数据和所述第一训练数据对应的混响源的类别,确定第一神经网络模型;根据第二训练数据对应的混响嵌入向量、所述第二训练数据中的第二混响语音数据和所述第二训练数据中的第三语音数据,确定第二神经网络模型;根据所述第一神经网络模型模获取真实场景下的语音数据对应的目标嵌入向量;根据所述第二神经网络模型对所述目标嵌入向量和待处理的语音数据进行语音生成处理,得到目标混响语音数据。本申请提供的语音生成方法提高了真实场景中混响语音生成的性能。技术研发人员:叶帅帅,胡新辉,徐欣康受保护的技术使用者:浙江同花顺智能科技有限公司技术研发日:技术公布日:2024/1/15本文地址:https://www.jishuxx.com/zhuanli/20240618/20923.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表