具有序列的对比损失的有监督和无监督的训练的制作方法

- 国知局

- 2024-06-21 10:39:20

本公开涉及具有序列的对比损失的有监督和无监督的训练。

背景技术:

1、自动语音识别(automatic speech recognition,asr)是将音频输入转换为文本的过程,它已经成为在移动设备和其它设备中使用的重要技术。通常,自动语音识别试图通过取得音频输入(例如,语音话语)并将音频输入转录成文本来提供人所说的内容的准确转录。基于深度神经网络的持续发展,现代asr模型在精确度(例如,低字错误率(word errorrate,wer))和时延(例如,用户说话和转录之间的延迟)方面继续改进。然而,在开发基于深度学习的asr模型中的一个挑战是,asr模型的参数趋于过度拟合训练数据,从而导致当训练数据不够广泛时asr模型难以泛化到未见的数据。结果,在较大的训练数据集上训练asr模型提高了asr模型的精确度。在训练数据集上应用数据增强可以提高用于训练asr模型的训练数据集的声学多样性。

技术实现思路

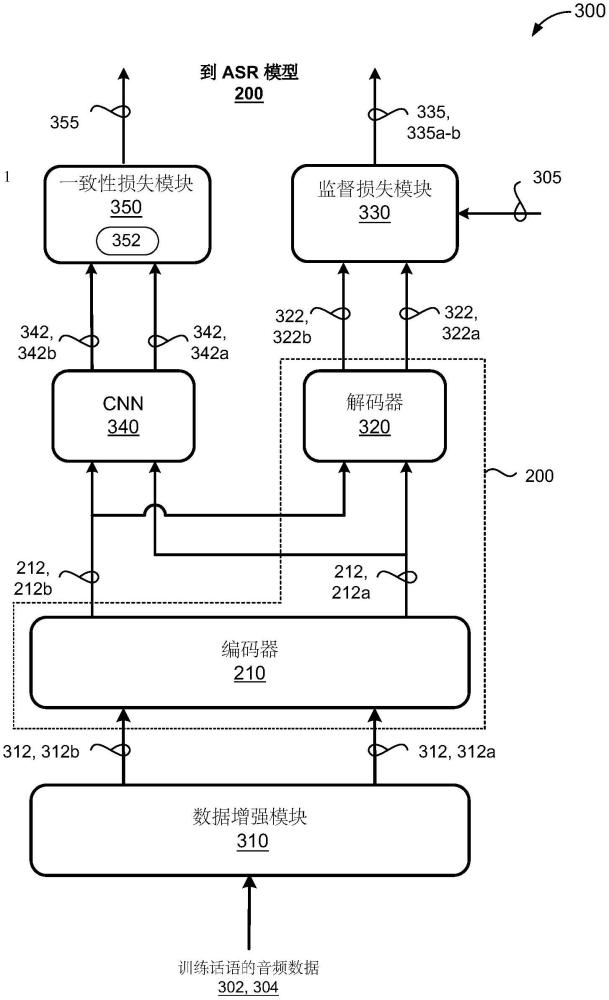

1、本公开的一个方面提供了一种计算机实施的方法,当在数据处理硬件上执行时,该方法使数据处理硬件执行具有序列的对比损失的有监督和无监督的训练的操作。该操作包括接收与话语对应的音频数据。该操作还包括使用数据增强模块生成一对正音频数据示例。这里,该一对正音频数据示例中的每个正音频数据示例包括与话语对应的接收到的音频数据的相应的增强副本。对于该一对正音频数据示例中的每个相应的正音频数据示例,该操作包括使用神经网络编码器生成相应的编码器输出的序列,并且使用卷积神经网络(cnn)将相应的正音频数据示例的相应的编码器输出的序列投影到对比损失空间中。确定该正音频数据示例的投影的该编码器输出的序列中的每个对应的编码器输出之间的l2距离;该操作还包括通过对针对所述投影的编码器输出的序列中的编码器输出所确定的l2距离求平均来确定每话语一致性损失;该操作还包括使用语音识别模型为该一对正音频数据示例中的每个相应的正音频数据示例生成相应的语音识别结果。该操作还包括基于与每个对应的语音识别结果相关联的相应的监督损失项和所述每话语一致性损失来更新所述语音识别模型的参数。

2、本公开的实施方式可以包括以下可选特征中的一个或多个。在一些实施方式中,cnn包括第一cnn层,随后是修正线性激活函数(rectified linear activation function)(relu)激活和层归一化(layernorm)层,以及具有线性激活的第二cnn层。所述数据增强模块可以添加噪声、混响中的至少一个,或操纵所述接收到的音频数据的时序。在一些示例中,所述语音识别模型(200)包括序列变换器(transducer)模型,所述序列变换器模型具有基于conformer的编码器和长短期(lstm)解码器。在这些示例中,所述基于conformer的编码器包括conformer层的堆叠,每个所述conformer层包括一系列多头自注意力、深度卷积和前馈层。

3、在一些实施方式中,该操作还包括接收一组训练话语,每一个训练话语包括相应的话语的非合成语音表示,并且对于该组训练话语中的每一个训练话语,使用文本到语音(text-to-speech,tts)模型来转换相应的基准真值(ground truth)转录,以生成相同相应的话语的一个或多个合成语音表示。这里,接收与话语对应的音频数据包括接收所述对应的话语的非合成语音表示中的一个或对应的话语的一个或多个合成语音表示中的一个。在一些示例中,为所述一对正音频数据示例中的每个相应的正音频数据示例生成对应的语音识别结果包括使用解码器来确定所述相应的编码器输出的序列的可能的语音识别假设(hypotheses)的概率分布。

4、该操作可以还包括通过将所述相应的正音频数据示例的所述对应的语音识别结果与所述相应的正音频数据示例的对应的基准真值转录进行比较来确定相应的监督损失项。在一些实施方式中,所述一对正音频数据示例中的每个正音频数据示例包括与所述一对正音频数据示例中的每个其他正音频数据示例不同的、与所述话语对应的所述接收到的音频数据的不同的相应的增强副本。在一些示例中,生成所述正音频数据示例对包括基于对所述话语的单次观察生成所述一对正音频数据示例中的每个正音频数据示例。

5、本发明的另一方面提供一种系统,其包括数据处理硬件和存储指令的存储器硬件,该指令在该数据处理硬件上执行时致使该数据处理硬件执行操作。该操作包括接收与话语对应的音频数据。该操作还包括使用数据增强模块生成一对正音频数据示例。这里,该一对正音频数据示例中的每个正音频数据示例包括与话语对应的接收到的音频数据的相应的增强副本。对于该一对正音频数据示例中的每个相应的正音频数据示例,该操作包括使用神经网络编码器生成相应的编码器输出的序列,并且使用卷积神经网络(cnn)将相应的正音频数据示例的相应的编码器输出的序列投影到对比损失空间中。确定该正音频数据示例的投影的该编码器输出的序列中的每个对应的编码器输出之间的l2距离;该操作还包括通过对针对所述投影的编码器输出的序列中的编码器输出所确定的l2距离求平均来确定每话语一致性损失;该操作还包括使用语音识别模型为该一对正音频数据示例中的每个相应的正音频数据示例生成相应的语音识别结果。该操作还包括基于与每个对应的语音识别结果相关联的相应的监督损失项和所述每话语一致性损失来更新所述语音识别模型的参数。

6、本公开的实施方式可以包括以下可选特征中的一个或多个。在一些实施方式中,cnn包括第一cnn层,随后是修正线性激活函数(rectified linear activation function)(relu)激活和层归一化(layernorm)层,以及具有线性激活的第二cnn层。所述数据增强模块可以添加噪声、混响中的至少一个,或操纵所述接收到的音频数据的时序。在一些示例中,所述语音识别模型(200)包括序列变换器模型,所述序列变换器模型具有基于conformer的编码器和长短期(lstm)解码器。在这些示例中,所述基于conformer的编码器包括conformer层的堆叠,每个所述conformer层包括一系列多头自注意力、深度卷积和前馈层。

7、在一些实施方式中,该操作还包括接收一组训练话语,每一个训练话语包括相应的话语的非合成语音表示,并且对于该组训练话语中的每一个训练话语,使用文本到语音(text-to-speech,tts)模型来转换相应的基准真值(ground truth)转录,以生成相同相应的话语的一个或多个合成语音表示。这里,接收与话语对应的音频数据包括接收所述对应的话语的非合成语音表示中的一个或对应的话语的一个或多个合成语音表示中的一个。在一些示例中,为所述一对正音频数据示例中的每个相应的正音频数据示例生成对应的语音识别结果包括使用解码器来确定所述相应的编码器输出的序列的可能的语音识别假设的概率分布。

8、该操作可以还包括通过将所述相应的正音频数据示例的所述对应的语音识别结果与所述相应的正音频数据示例的对应的基准真值转录进行比较来确定相应的监督损失项。在一些实施方式中,所述一对正音频数据示例中的每个正音频数据示例包括与所述一对正音频数据示例中的每个其他正音频数据示例不同的、与所述话语对应的所述接收到的音频数据的不同的相应的增强副本。在一些示例中,生成所述正音频数据示例对包括基于对所述话语的单次观察生成所述一对正音频数据示例中的每个正音频数据示例。

9、本公开的一个或多个实施方式的细节在附图和以下描述中阐述。通过说明书、和附图、以及权利要求书,其他方面、特征和优点将变得显而易见。

本文地址:https://www.jishuxx.com/zhuanli/20240618/20970.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表