一种数字人交互对话方法和系统与流程

- 国知局

- 2024-06-21 10:41:29

本发明涉及数据处理,具体涉及一种数字人交互对话方法和系统。

背景技术:

1、在数字人交互对话过程中,获取实时用户音频数据的准确性,是音频数据的语义转化与智能化交互对话的重要前提。但是由于实时采集的用户音频数据往往存在环境噪声数据,会形成混合音频数据,对于音频数据的准确处理造成一定的影响,因此往往需要对用户音频数据进行去噪处理。

2、在去噪处理过程中,根据音频数据的每个数据点受到噪声的程度来获取去噪后的音频数据。迭代自组织聚类方法是一种无监督的聚类方法,适用于音频数据的每个数据点的噪声程度量化。但是由于采集的混合音频数据中用户声音及噪声的存在不同的时序分布特征,其中用户声音的相同音素在音频数据中的音频波动特征存在相似性,并且其音频波形受到用户声音中音素的影响呈现出一定的阶段内聚集特征,而噪声部分则由于其随机特征增加了局部的波形混乱程度。在通过迭代自组织聚类算法对音频数据进行聚类分析的过程中,其噪声造成的异常数据点往往会使得聚簇的错分,影响后续聚类簇中心的修正,难以实现真实用户声音数据的提取。

技术实现思路

1、为了解决上述问题,本发明提出一种数字人交互对话方法和系统。

2、本发明的一种数字人交互对话方法和系统采用如下技术方案:

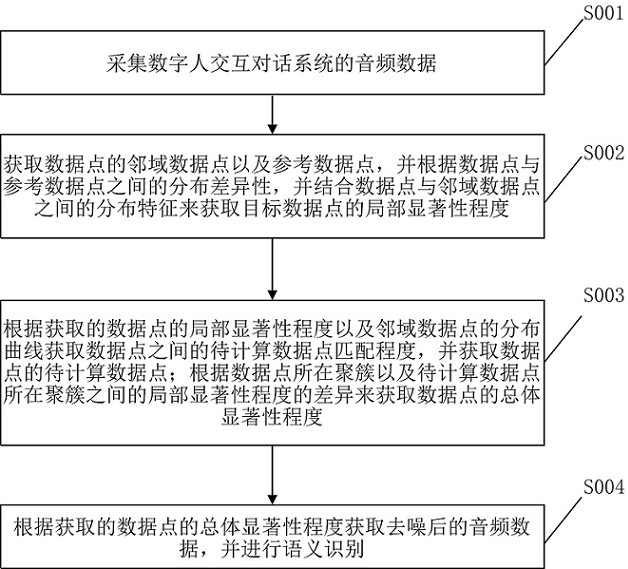

3、本发明一个实施例提供了一种数字人交互对话方法,该方法包括以下步骤:

4、获取音频数据;根据获取的音频数据构建二维样本空间,其中二维样本空间中横坐标为时刻,纵坐标为音频数据的振幅值;

5、对所有数据点进行迭代自组织聚类,得到所述聚类过程中第一次聚类结果,其中第一次聚类结果中包含若干聚簇;

6、将任意一个数据点记为目标数据点;预设数据点邻域范围,根据数据点邻域范围获取所述目标数据点的邻域数据点;在第一次聚类结果中,将所述目标数据点所在聚簇中的其他数据点记为目标数据点的参考数据点;

7、根据目标数据点和参考数据点之间的振幅值差异,以及目标数据点和邻域数据点振幅值分布,获取目标数据点的局部显著性程度;

8、对于目标数据点所在聚簇以外的其他聚簇中的任意一个数据点,记为第一数据点;获取目标数据点和第一数据点的邻域分布曲线;

9、根据目标数据点和第一数据点的局部显著性程度的差异,以及邻域分布曲线之间的差异,获取目标数据点与第一数据点的待计算数据点匹配程度;根据待计算数据点匹配程度,获取目标数据点的待计算数据点集合;

10、根据目标数据点与待计算数据点集合中待计算数据点的聚簇差异以及局部显著性程度的差异获取目标数据点的总体显著性程度;

11、根据目标数据点的总体显著性程度进行迭代自组织聚类的第一次聚类结果的聚簇中心的更新;根据更新后的聚簇中心进行下一次迭代自组织聚类;依次类推,得到最终的迭代自组织聚类结果;

12、根据最终的迭代自组织聚类结果获取数据点的异常程度,根据所述数据点的异常程度获取去噪后的音频数据,并进行音频数据的语义识别。

13、进一步的,所述根据目标数据点和参考数据点之间的振幅值差异,以及目标数据点和邻域数据点振幅值分布,获取目标数据点的局部显著性程度,包括的具体步骤如下:

14、记目标数据点为第个数据点,则第个数据点的局部显著性程度的计算方法为:

15、

16、其中,表示第个数据点的振幅值;表示第个数据点的所有参考数据点的振幅值的均值;表示第个数据点的邻域数据点的振幅值;表示获取所有数据点中的振幅值的最大值;表示获取方差值函数;表示获取最大值函数。

17、进一步的,所述获取目标数据点和第一数据点的邻域分布曲线,包括的具体步骤如下:

18、将目标数据点的所有邻域数据点按照从左到右的顺序将相邻的邻域数据点依次连接,得到目标数据点的邻域分布曲线;

19、将第一数据点的所有邻域数据点按照从左到右的顺序将相邻的邻域数据点依次连接,获取第一数据点的邻域分布曲线。

20、进一步的,所述根据目标数据点和第一数据点的局部显著性程度的差异,以及邻域分布曲线之间的差异,获取目标数据点与第一数据点的待计算数据点匹配程度,包括的具体步骤如下:

21、对目标数据点的邻域分布曲线和第一数据点的邻域分布曲线进行dtw匹配,获取目标数据点的邻域分布曲线和第一数据点的邻域分布曲线之间的dtw距离;

22、记目标数据点为第个聚簇的第个数据点,第一数据点为第个聚簇的第个数据点,则是的待计算数据点匹配程度的计算方法为:

23、

24、其中,表示第个聚簇的第个数据点的邻域分布曲线;表示第个聚簇的第个数据点的邻域分布曲线;表示邻域分布曲线和邻域分布曲线之间的dtw距离;表示第个聚簇的第个数据点的局部显著性程度;表示第个聚簇的第个数据点的局部显著性程度;表示以自然常数为底数的指数函数。

25、进一步的,所述根据待计算数据点匹配程度,获取目标数据点的待计算数据点集合,包括的具体步骤如下:

26、获取目标数据点与其他所有第一数据点之间的待计算数据点匹配程度,记为待计算数据点匹配程度集合,对所述待计算数据点匹配程度集合中的待计算数据点匹配程度进行归一化处理,得到归一化处理后的待计算数据点匹配程度;

27、预设待计算数据点匹配程度阈值,对于任意一个第一数据点,若目标数据点与所述第一数据点之间的待计算数据点匹配程度大于待计算数据点匹配程度阈值,则将所述第一数据点作为目标数据点的待计算数据点,将所有目标数据点的待计算数据点构成目标数据点的待计算数据点集合。

28、进一步的,所述根据目标数据点与待计算数据点集合中待计算数据点的聚簇差异以及局部显著性程度的差异来获取目标数据点的总体显著性程度,包括的具体步骤如下:

29、将待计算数据点集合中的待计算数据点所在聚簇,记为待计算聚簇;

30、对于目标数据点的待计算数据点集合中的任意一个待计算数据点,获取所述待计算数据点所在的聚簇与目标数据点所在的聚簇之间的归一化互信息值;

31、根据所述待计算数据点所在的聚簇与目标数据点所在的聚簇之间的归一化互信息值获取目标数据点的总体显著性程度。

32、进一步的,所述获取目标数据点的总体显著性程度,包括的具体步骤如下:

33、记目标数据点为第个聚簇的第个数据点,所述目标数据点的总体显著性程度的计算方法为:

34、

35、其中,表示待计算聚簇的数量;表示第个聚簇的第个数据点所在聚簇与第个待计算聚簇之间的归一化互信息值;表示第个待计算聚簇中待计算数据点的数量;表示第个待计算聚簇中第个待计算数据点的局部显著性程度;表示第个待计算聚簇中第个待计算数据点的所有参考数据点的局部显著性程度的均值;表示第个待计算聚簇中第个待计算数据点与所述待计算数据点的所有参考数据点的局部显著性程度的方差值;表示第个聚簇的第个数据点的局部显著性程度;表示第个聚簇的第个数据点的所有参考数据点的局部显著性程度的均值;表示第个聚簇的第个数据点与所述数据点的所有参考数据点的局部显著性程度的方差值;表示以自然常数为底数的指数函数。

36、进一步的,所述根据目标数据点的总体显著性程度进行迭代自组织聚类的第一次聚类结果的聚簇中心的更新,包括的具体步骤如下:

37、对于第一次聚类结果中的任意一个聚簇中的任意一个数据点,根据所述数据点的总体显著性程度,预设总体显著性程度阈值,若所述数据点的总体显著性程度小于所述总体显著性程度阈值,则所述数据点参与第一次聚类结果的所述聚簇的聚簇中心更新过程,获取新的聚簇的中心。

38、进一步的,所述根据最终的迭代自组织聚类结果获取数据点的异常程度,根据所述数据点的异常程度获取去噪后的音频数据,并进行音频数据的语义识别,包括的具体步骤如下:

39、将最终的迭代自组织聚类结果中的任意一个数据点记为对象数据点,获取所述对象数据点所在聚簇的聚簇中心,得到对象数据点与聚簇的聚簇中心之间的欧式距离;

40、获取最终的迭代自组织聚类结果中所有数据点与所在聚簇的聚簇中心之间的欧式距离,对所有数据点与所在聚簇的聚簇中心之间的欧式距离进行线性归一化处理,作为每个数据点的异常程度;

41、预设异常程度阈值,若所述对象数据点的异常程度大于所述异常程度阈值,则将所述对象数据点记为异常数据点;

42、对于任意一个异常数据点,将所述异常数据点去除,并根据异常数据点的所有邻域数据点的振幅值的均值作为所述异常数据点对应时刻的新的振幅值,进而得到新的音频数据,将所述新的音频数据作为去噪后的音频数据;

43、根据获取的去噪后的音频数据,作为输入数据输入到transformer模型中进行用户音频数据的语义识别。

44、本发明还提出一种数字人交互对话系统,包括存储器、处理器以及存储在所述存储器中并可在所述处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现任意一项所述一种数字人交互对话方法的步骤。

45、本发明的技术方案的有益效果是:本发明通过获取用户与数字人交互对话过程中的音频数据,利用迭代自组织聚类算法,获取去噪后的音频数据。其中获取数据点的邻域数据点以及参考数据点,并根据目标数据点与参考数据点之间的分布差异性,并结合数据点与邻域数据点之间的分布特征来获取局部显著性程度。根据获取的局部显著性程度以及邻域数据点的分布曲线获取数据点的待计算数据点,进而得到数据点的总体显著性程度,最终的去噪后的音频数据,并进行音频数据的语义识别。避免了传统的迭代自组织聚类结果来量化每个数据点的异常程度来去噪的过程中,由于更新聚类中心会很多的由于噪声引起的异常数据点作为更新依据,使得会使得数据点的异常程度的计算出现较大的误差的缺点,使得可以实现用户的音频数据的精准去噪,提高后续数字人交互对话系统的语义转化与智能化交互对话的准确性。

本文地址:https://www.jishuxx.com/zhuanli/20240618/21235.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。