基于特定人物少样本情况下情感可控语音合成方法及系统与流程

- 国知局

- 2024-06-21 11:38:33

本发明属于语音合成,尤其涉及一种基于特定人物少样本情况下情感可控语音合成方法及系统。

背景技术:

1、现有技术提供语音合成技术、情感合成技术。但现有的语音合成技术,依赖于在录音棚录制的大量高质量数据,不同的特定人需要录制对应人物的大量数据,耗时耗力,同时现有的情感合成技术针对于特定人的情感合成,仍需要特定人物进行配合录制预先设定的几种情感,同样也耗时,耗费大量精力,同时合成的情感种类受限于录制数据,在特定人无法配合录制的情况下则无法具备情感合成能力。

2、通过上述分析,现有技术存在的问题及缺陷为:现有的语音合成技术依赖于针对特定人物的大量高质量数据录制,需要耗费大量时间和精力,同时现有语音合成技术,采用两阶段,从文本中得到梅尔频谱,再重梅尔频谱重建为波形,这个过程合成速度慢。

3、现有的情感合成技术,同样依赖于对应人物的大量情感数据录制,在人物不可配合的情况下则无法进行该特定人物的情感语音合成。

技术实现思路

1、为克服相关技术中存在的问题,本发明公开实施例提供了一种基于特定人物少样本情况下情感可控语音合成方法及系统。具体应用于针对于特定人少样本数据情况下,实现情感可控的语音合成。

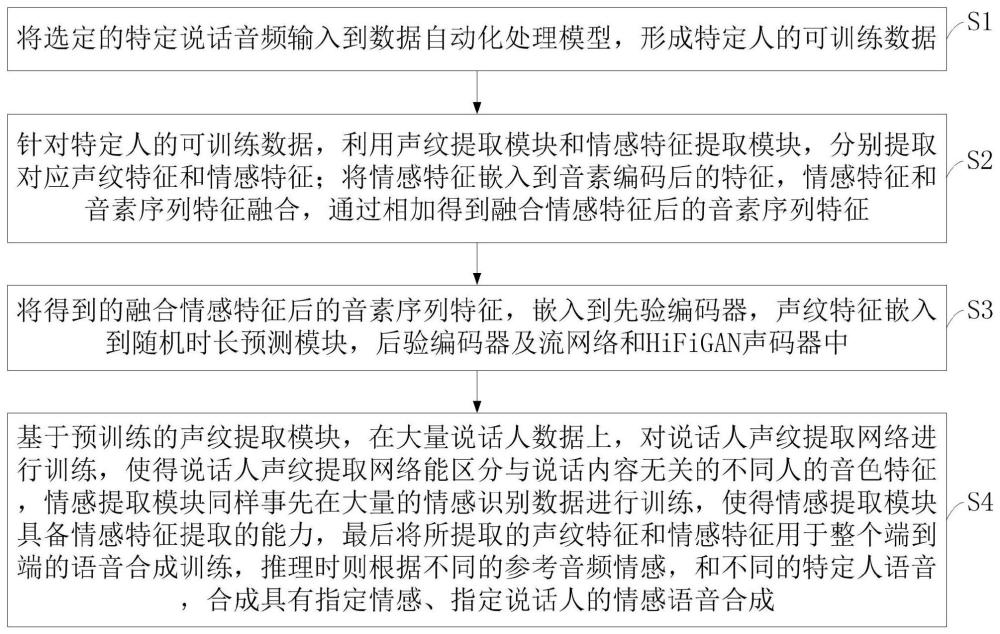

2、所述技术方案如下:一种基于特定人物少样本情况下情感可控语音合成方法,包括以下步骤:

3、s1,将选定的特定说话音频输入到数据自动化处理模型,形成特定人的可训练数据;

4、s2,针对特定人的可训练数据,利用声纹提取模块和情感特征提取模块,分别提取对应声纹特征和情感特征;将情感特征嵌入到音素编码后的特征,情感特征和音素序列特征融合,通过相加得到融合情感特征后的音素序列特征;

5、s3,将得到的融合情感特征后的音素序列特征,嵌入到先验编码器,声纹特征嵌入到随机时长预测模块,后验编码器及流网络和hifigan声码器中;

6、s4,基于预训练的声纹提取模块,在大量说话人数据上,对说话人声纹提取网络进行训练,使得说话人声纹提取网络能区分与说话内容无关的不同人的音色特征,情感提取模块同样事先在大量的情感识别数据进行训练,使得情感提取模块具备情感特征提取的能力,最后将所提取的声纹特征和情感特征用于整个端到端的语音合成训练,推理时则根据不同的参考音频情感,和不同的特定人语音,合成具有指定情感、指定说话人的情感语音合成。

7、在步骤s1中,数据自动化处理模型的处理流程包括:

8、特定人的语音首先经过去噪处理,消除语音中的背景声音、噪音,并以固定采样率进行重新采样,再根据vad沉默检测,进行语音片段裁剪,裁剪后的语音进行语种检测,选用不同语种模型进行语音识别,最终得到针对于该特定人物的可训练数据。

9、进一步,所述特定人的语音首先经过去噪处理,消除语音中的背景声音、噪音,并以固定采样率进行重新采样,包括:将所搜集的针对于特定人语音,重新采样为单通道,16000hz的音频;将重新采样后的音频,通过深度学习算法进行去噪处理,去掉杂音和背景音干扰声音,得到只有干净的人声音频。

10、进一步,所述根据vad沉默检测,进行语音片段裁剪,包括:

11、通过设置分贝阈值,检测经过重采样、降噪处理后特定人语音中沉默的区间;进行语音片段裁剪,根据vad沉默检测得到的沉默区间进行随机长度的裁剪,单条语音裁剪长度在10秒内,最终得到针对于特定人的少量语音片段;

12、所述裁剪后的语音进行语种检测包括:对上述经过重采样、去噪、裁剪后的语音,进行单条语音的语种检测,若识别语音片段为中文则打上中文语音标签,识别语音为英文则打上英文语音标签,若为中英混合则打上中英混合标签;

13、所述选用不同语种模型进行语音识别包括:对经过上述语种检测后的语音片段,根据语音片段对应标签,选择对应的语音识别模型,中文标签,选用中文语音识别模型,英文标签,选用英文语音识别模型,中英混合语音标签,选用中英混合语音识别模型;对语音片段进行语音识别,得到语音片段对应的文字;所得文字经过对应的语种文本前端处理后得到对应的音素序列。

14、在步骤s2中,情感特征和经过音素编码模块后的特征在维度上一致;两个相同维度矩阵,通过矩阵中相同位置逐点相加得到融合情感特征后的音素序列特征;其中,维度矩阵大小为(b,t,h),b表示一批次训练中样本数量,t表示传的序列长度,h表示隐藏层维度。

15、在步骤s4中,整个端到端的语音合成训练流程中,网络结构采用基于vae、流网络、hifigan、随机时长预测网络、说话人声纹提取网络;同时,增加双向流网络损失,用于约束在经过流网络变化前后特征。

16、进一步,基于kl散度用于约束经过先验编码器以及线性层得到的先验分布,和线性频谱经过后验编码器、流网络得到的后验分布;线性频谱经过后验编码器,得到后验特征,hifigan声码器将经过后验编码器得到的后验特征重建为语音波形;在做kl散度约束时,采用双向流网络损失;

17、lkl=logqφ(z|xlin)-logpφ(z|ctext,a)

18、式中,xlin表示语音经过线性刻度的频谱分析,z表示分布,ctext,a分别表示输入的音素序列和对应音素的时长,qφ表示后验网络,pφ表示先验网络,lkl表示经过先验网络和后验网络后的差值。

19、进一步,训练过程中,通过单调对齐搜索,估计文本音素所对应的时长,作为训练随机时长预测器的真实标签;训练过程中,情感特征提取器和说话人特征提取器,不参与网络参数的更新,分别计算说话人音频中的情感特征和说话人特征。

20、进一步,所述推理过程包括:根据输入文本,和指定的说话人参考音频情感,结合说话人特征,得到文本音素的时长预测,将经过线性层的先验分布,根据时长预测进行扩充,扩充后的特征再经过流网络的逆变换得逆变换后的特征,最后hifigan声码器根据逆变换后的特征进行波形重建,得到具有指定情感、指定说话人的情感语音合成。

21、本发明的另一目的在于提供一种基于特定人物少样本情况下情感可控语音合成系统,该系统实施所述的基于特定人物少样本情况下情感可控语音合成方法,该系统包括:

22、数据自动化处理模型模块,用于将选定的特定说话音频输入到数据自动化处理模型,形成特定人的可训练数据;

23、融合情感特征后的音素序列特征得到模块,用于针对特定人的可训练数据,利用声纹提取模块和情感特征提取模块分别提取对应声纹特征和情感特征;将情感特征嵌入到音素编码后的特征,情感特征和音素序列特征融合;情感特征和经过音素编码模块后的特征在维度上一致,通过相加得到融合情感特征后的音素序列特征;

24、嵌入不同网络模块,用于将得到的融合情感特征后的音素序列特征,嵌入到先验编码器,声纹特征嵌入到随机时长预测模块,后验编码器及流网络,和hifigan声码器中;

25、情感语音合成模块,用于基于预训练的声纹提取模块,在大量说话人数据上,对说话人声纹提取网络进行训练,使得其能区分与说话内容无关的不同人的音色特征,并进行整个端到端的语音合成训练和推理流程,将所提取的说话人特征嵌入到不同的网络中,得到具有指定情感、指定说话人的情感语音合成。

26、结合上述的所有技术方案,本发明所具备的优点及积极效果为:在只有特定人少量样本的情况下实现高质量的情感可控语音合成。本发明基于预训练的声纹提取模型、情感提取模型、和基于流网络的vae、hifigan网络等实现基于某特定人少样本数据情况下,实现高质量的情感可控语音合成技术。采用端到端的语音合成流程,基于数据自动化处理模块形成实现快速响应的自动化训练流程。

本文地址:https://www.jishuxx.com/zhuanli/20240618/22619.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。