一种基于深度学习的混叠鸟鸣声分离方法

- 国知局

- 2024-06-21 11:40:17

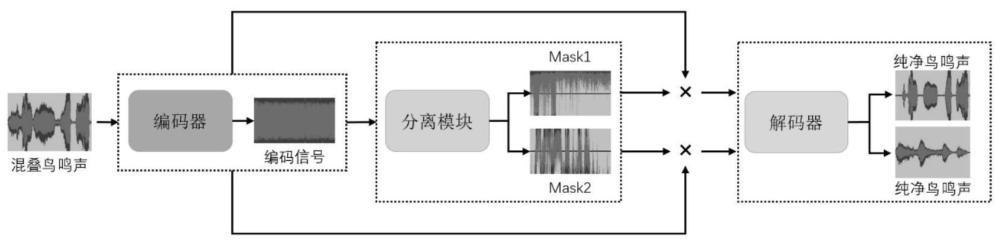

本发明涉及一种基于深度学习的混叠鸟鸣声分离方法,是一种基于ratt-gated-tasnet的深度学习混叠鸟鸣声分离方法。

背景技术:

1、近年来,全球工业化的快速发展导致了对环境的严重破坏。生物的多样性是地球生命的基础,也是人类社会赖以发展的基础,更是赖以生存的基础。生物多样性会影响一个国家或地区的发展,保护生物多样性就是保护生物其本身,更是在保护人类自己。在生物多样性的保护工作中,鸟类的保护也是一个极其重要的环节,某些鸟类的种群数量可以作为生态环境评估的重要指标以此来达到保护生物多样性的目的,因此,鸟类的识别在鸟类保护工作方面具有很大的意义。然而,直接使用在自然环境下采集的鸟鸣声来识别某种鸟类明显具有一定的难度,现场录入的鸟鸣声会包含许多难以避免的其他鸟类鸣叫声的噪声。所以,很有必要对开放环境下混叠鸟鸣声进行声源分离,将纯净的鸟鸣声从其他鸟类鸣叫声中分离出来并用于鸟类识别,纯净的鸟鸣声能大幅度提高鸟鸣声识别的效率。

2、综上,有必要设计一种混叠鸟鸣声分离方法。

技术实现思路

1、本发明所要解决的技术问题是提供一种基于深度学习的混叠鸟鸣声分离方法,该方法具有分离效果好的特点。

2、发明的技术解决方案如下:

3、一种基于深度学习的混叠鸟鸣声分离方法,包括以下步骤:

4、步骤一、在编码器中计算两种混叠鸟鸣声信号的特征向量;

5、所述的特征向量是指中间特征空间中对应的特征向量;得到的是d维矩阵,也可以说是鸟鸣声信号的特征向量,d一般取2;

6、步骤二、在分离网络中计算掩码向量;

7、将混叠鸟鸣声信号对应的特征向量通过分离网络模块,获得每个纯净鸟鸣声在时间步长内对应的掩码向量;

8、步骤三、使用掩码向量处理编码器特征;

9、使用从分离网络中得到的掩码向量处理编码器中输出的混叠鸟鸣声特征向量;

10、步骤四、使用解码器重构纯净鸟鸣声信号;

11、将分离网络输出的特征向量经过解码器的一维转置卷积处理后即可得到两种纯净的鸟鸣声信号,实现混叠鸟鸣声的分离。

12、步骤一中:将混叠鸟鸣声音频信号输送到编码器中,编码器名为残差多头注意力编码器((residual multihead attetionencoder,即resmhaencoder),它是一个经过改进的卷积神经网络,由一个一维卷积、多头注意力机制和两个relu激活函数组成;最终得到两种混叠鸟鸣声的特征向量w;有:

13、w=h(xut);

14、其中:

15、h()是relu函数,保证每个特征的非负性。这里的relu函数是一维卷积操作里的relu函数,后两个relu函数是残差多头注意力机制的组成部分;

16、x即x(t),

17、其中x(t)为混叠音频的离散波形,由c个干净音频的波形si(t),i=1,...,c组成,在本专利中c=2,混叠音频中存在两种鸟鸣声需要分离

18、u是编码器的基底函数,为一维卷积函数,一维卷积由一个逐点卷积与深度可分离卷积组成,包含n个向量,n为编码器的滤波器数量,n=512,每个向量长度为l=16。

19、在编码器中以叠加的方式加入两层多头注意力机制。将w再输入到中,第一个注意力机制的输出为第二个注意力机制的输入,经过注意力机制处理后,得到的是2维的值矩阵,这个就是步骤一的最终结果,2维的值矩阵即特征向量w。

20、多头注意力机制的表达式如下:

21、multihead(q,k,v)=concat(head1,...,headn)w°

22、其中,headi=attention(qwiq,kwik,vwiv),wiq,wik,wiv,wo为映射参数矩阵,用于线性变化参数,统一维度;wiq,wik,wiv的维度为512x64,wo的维度为512x512,根据梯度反向传播自动更新,取值范围为(0,1),concat函数将每个head的值进行维度连接,保证所有维度为512x512(一共有8个头,一个头的维度为512x64,8个就是512x512);multihead(q,k,v)最终是一个512x512的二维特征矩阵;残差多头注意力编码器:首先经过一个relu函数,再经过两个mha模块,最后再经过一个relu函数。

23、步骤二中,将编码器的输出输入至分离网络,在分离网络中,包括以下两个步骤:

24、步骤21,通过归一化运算保证数据的有效性和稳定性,再经过一个线性的1×1-conv块,其作为瓶颈层确定了后续卷积块的输入和残差路径中的信道数量;

25、归一化选择的是全局归一化(global layer normalization,gln),gln在通道和时间维度上对特征进行归一化,gln的表达式如下:

26、

27、

28、

29、其中,f是特征向量w,n和t分别为w的维度和片段数,γ,β是可训练参数;通常这两个取值为1,再通过反向传播来更新这两个参数并不断地调整取值,一般在(0,1),ε是常数,取值为0.00001,作用是防止除0;⊙是同或运算符号。n=512,t=100;

30、步骤22,经过门控时间卷积网络(gated-temporal convolutionalnetwork,gated-tcn)计算出分离鸟鸣声需要的掩码向量。门控时间卷积网络的具体设计为:由3层8个具有不同膨胀因子的门控卷积块堆叠组成,3层8个,是指每层8个,一共三层,每8个一组,每一个门控卷积块的结果通过跳过连接路径的结果进行异或运算,确保了足够大的时间上下文窗口,从而更好地利用语音信号的长期依赖性,每一个门控卷积块的残差路径用作下一个门控卷积块的输入,所有门控卷积块跳过连接路径的值进行异或运算,用作门控时间卷积网络的输出,即得到掩码向量;掩码向量为512x512的矩阵向量。

31、门控卷积块的设计(后面有设计图)为:每个1×1-conv块后面连接d-conv块,d-conv是学习数据的特征表示,从而提高网络的学习能力,在它们后面分别添加门控线性单元(glus)和全局归一化运算,以加快训练。图4中上方还有2个1×1-conv块,用于降低模型参数和计算成本,提高网络训练效率。

32、模型中用到的归一化都是这一种归一化,包括后面流程图的normalization和layernorm都是这一种归一化。

33、而且步骤21和22都有1×1-conv块,是独立的。

34、步骤三中,门控时间卷积网络的输出首先经过prelu函数,其作用是保证特征向量的非负性,然后被传递到核大小为1的逐点卷积块(1×1-conv)计算目标音源的掩码向量mi。再与编码器的输出w进行逐元素相乘,得到每个纯净音源的特征向量di。最后经过sigmoid函数保证特征向量的值在区间(0,1),特征向量di的定义如下式:

35、di=w⊙mi,其中⊙表示逐元素相乘。

36、步骤四中,采用解码器的转置卷积运算重构纯净音源的波形其定义如下:

37、其中v是解码器中的基底函数,一维转置卷积函数,即为一维卷积的转置矩阵。

38、本发明所要解决的技术问题主要有两点,第一点是提取混叠鸟鸣声信号特征向量的过程中,编码阶段存在大量冗余信道对网络特征提取进行干扰,第二点是分离阶段分离网络没有足够大的时间上下文窗口,无法比较好地兼顾上下文信息导致分离效果很差。针对第一个问题,本发明提出了resmha encoder,该方法能够将混叠鸟鸣声信号中的有效特征信息进行提取,过滤掉冗余信息。针对第二个问题,本发明提出了一种门控时间卷积网络(gated-tcn)。首先经过一个线性的1×1-conv块,其作为瓶颈层确定了后续卷积块的输入和残差路径中的信道数量。门控时间卷积网络(gated-tcn)由8个具有不同膨胀因子的门控卷积块堆叠组成,这些堆叠的卷积块重复3次,确保了足够大的时间上下文窗口,从而更好地利用语音信号的长期依赖性。每个块都进行零填充,确保输出长度和输入长度的一致。门控卷积块中应用了残差路径和跳过连接路径:残差路径用作下一个卷积块的输入,所有卷积块的跳过连接路径相加并用作门控时间卷积网络的输出。在每个卷积块中使用深度可分离卷积来代替标准卷积,这样做的目的是进一步减少参数的数量。深度可分离卷积将标准卷积运算解耦为两个连续运算,一个深度卷积,然后是逐点卷积。在第一个1×1-conv和d-conv块之后分别添加了门控线性单元(glus)和归一化运算,以加快训练,该方法具有分离效果好的特点。

39、有益效果:

40、本发明公开了一种基于深度学习的混叠鸟鸣声分离方法,对混叠鸟鸣声信号的特征进行提取,并在分离网络中计算其掩码向量,再通过解码器输出纯净鸟鸣声,将所有训练样本训练100次,逐渐提高分离效果,步骤一、在编码器中计算混叠鸟鸣声信号的特征向量;步骤二、在分离网络中,使用该特征向量计算出每一个鸟鸣声声源对应的掩码向量;步骤三、使用掩码向量处理编码器特征;步骤四、使用解码器重构纯净鸟鸣声信号。本发明方法具有分离效果好的特点,si-snri和sdri分别达16.8db和17.2db。

41、本发明的基于ratt-gated-tasnet的深度学习混叠鸟鸣声分离方法,首先考虑到时域混叠鸟鸣声分离需要保证足够大的时间上下文窗口以充分利用鸟鸣声信号的长期依赖性,提出门控时间卷积网(gated-tcn),增加了网络的感受野。其次,为了使网络更关注于目标音频特征,引入了多头注意力机制(multi-head attention mechanism)并提出了残差多头注意力(residual multihead attetion),令网络以更灵活、更有表现力地关注于目标信道的信息。

42、第一方面,本发明为了使数据更接近于真实情况,使本发明设计的模型适应性广,利用网站https://xeno-canto.org来自建混叠鸟鸣声数据集。该网站所有音频数据都由世界各地的志愿者上传,且都是在自然环境下录制,因此会存在背景噪音、鸟鸣声交替出现,重叠等现象,况且鸟类的鸣声本身复杂多变,如响度、时长等会发生变化,同时鸟鸣声存在鸣叫和鸣唱的区别,以上情况随机地排列组合,使得鸟鸣声的背景复杂化,其数据中包含了现实生活中的风声、车鸣等噪声。本次研究使用的剪辑软件是adobe audition 2022,在剪辑的时候可以人工听取音频的同时观察音频的波形图和频谱图。这样就可以将上述情况下的音频剔除出去,防止影响数据集的整体质量。将一些无用的原始音频文件剔除之后,以2秒的时长作为一个单位,在下载的音频上手动截取包含鸟鸣声的部分。这些截取音频里面夹杂着一些自然以及城市环境声音,或者是音频录取的时候存在的一些设备本身运行的噪音。这些因素的存在更贴近和符合真实环境下对鸟鸣声的识别,同时也可以提高模型的抗噪性。最终,我们下载了26类鸟不同时长的音频,并剪辑出36000条混叠鸟鸣声音频作为数据集。

43、第二方面,本发明为减小编码阶段冗余信道对目标音频特征向量的提取,本发明引入残差多头注意力(residual multihead attetion)作为编码器的附加层,以帮助分离网络关注与目标音源相关的编码特征,并反过来抑制编码特征中的噪声干扰。所提出的残差多头注意力机制能够更好地分离出纯净鸟鸣声的特征。

44、第三方面,本发明为增强网络获取上下文信息的能力,扩大了感受野,可以准确地识别出需要的音频特征,更好地抓取音频特征的细节,提高混叠鸟鸣声分离的效果。

45、本发明实例是为了更好的从混叠鸟鸣声中进行特征提取,充分利用混叠鸟鸣声音频信号的特点,提出了一种混叠鸟鸣声分离方法(ratt-gated-tasnet)。其结合了多头注意力机制对大幅屏蔽冗余信道的干扰从而更好地提取音频特征和门控时间卷积网络更好获取时间上下文信息的优势。

本文地址:https://www.jishuxx.com/zhuanli/20240618/22807.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。