一种语音合成方法、装置、设备及介质

- 国知局

- 2024-06-21 11:41:54

本技术涉及语音合成,特别是涉及一种语音合成方法、装置、设备及介质。

背景技术:

1、语音合成技术的目的是将文本信息转化为语音(texttospeech,tts)。语音合成在近年来得到了飞速的发展,受到了学术界与工业界的广泛关注。各行各业对于语音合成的需求越来越高,如边境巡逻人员可以使用智能喊话器进行多语种语音合成,然后使用无线电发送给边境外来人员。

2、在现有的技术中,现有的深度学习语音合成方法中特殊术语合成前端缺失情感分类任务,而且现有的特殊术语情感预测网络主要采用由word2vec和glove等训练的固定字向量,然后利用基于lstm网络来预测句子级的特殊术语情感标签,word2vec和glove等训练的固定字向量无法根据不同的特殊术语语境去获取字在当前句子中的含义,同时为了不同的任务去定制复杂的任务模型,会使得模型的泛化能力偏差。特殊术语合成后端现有的技术大多采用端到端的语音合成声学模型,比如transformer、tacotron以fast speech等模型。这些模型已训练特殊术语文本作为输入进行enr端编码,然后在der端采用teacherforcing的训练方式,解码输出声学特征,但这些模型都只能针对训练数据集,学习训练数据集中的平均韵律风格,存在缺失情感。现有技术中,声学模型采用端到端的语音合成声学模型,比如transformer、tacotron以fast speech等模型。但这些模型都只能针对训练数据集,学习训练数据集中的平均韵律风格,存在缺失情感,缺失不同情感之间变化的问题,无法根据对话内容以及情景来采用合适的情感做出语音的生成。情感语音合成,需要情感标签的控制。但通过单单采用情感标签对模型进行控制,情感标签控制只能学得每种情感的平均风格,存在情感区分度均不好,同种情感韵律变化小,缺失句子级情感韵律控制的问题。情感标签可以通过人工指定标签来指定对应情感语音的生成,虽然可以针对场景用户需求进行变化,但同时也存在人工参与度高等问题仍然无法对人类声道进行完全模拟,因此合成的质量欠佳,不符合特殊场景等问题,生成富含情感的语音是对语音合成有着重要的意义,能够准确表达喊话方的真实含义。

技术实现思路

1、基于此,有必要针对上述技术问题,提供一种能够提高语音合成质量的语音合成方法、装置、设备及介质。

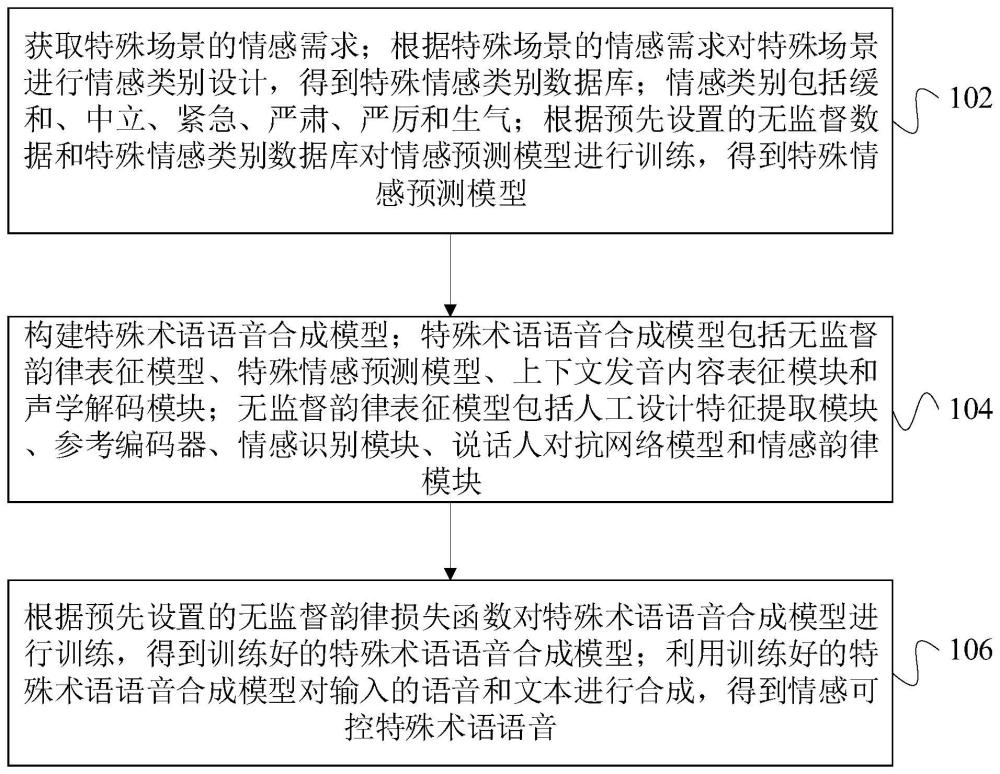

2、一种语音合成方法,所述方法包括:

3、获取特殊场景的情感需求;根据特殊场景的情感需求对特殊场景进行情感类别设计,得到特殊情感类别数据库;情感类别包括缓和、中立、紧急、严肃、严厉和生气;

4、根据预先设置的无监督数据和特殊情感类别数据库对情感预测模型进行训练,得到特殊情感预测模型;

5、构建特殊术语语音合成模型;特殊术语语音合成模型包括无监督韵律表征模型、特殊情感预测模型、上下文发音内容表征模块和声学解码模块;无监督韵律表征模型包括人工设计特征提取模块、参考编码器、情感识别模块、说话人对抗网络模型和情感韵律模块;

6、根据预先设置的无监督韵律损失函数对特殊术语语音合成模型进行训练,得到训练好的特殊术语语音合成模型;利用训练好的特殊术语语音合成模型对输入的语音和文本进行合成,得到情感可控特殊术语语音。

7、在其中一个实施例中,无监督韵律损失函数包括逼近损失、合成目标声学参数谱损失、合成语音声学结束损失、情感识别损失和说话人对抗任务损失。

8、在其中一个实施例中,逼近损失为

9、vae_loss=w*kl[q||p.detach]+(1-w)*kl[q||p.detach]

10、其中,w表示权重参数,q表示情感韵律分布,p.detach表示无监督韵律分布。

11、在其中一个实施例中,无监督韵律损失函数为

12、loss=vae_loss+mel_loss+stop_loss+emotion_loss+speaker_loss

13、其中,vae_loss表示逼近损失,mel_loss表示合成目标声学参数谱损失,stop_loss表示合成语音声学结束损失,emotion_loss表示情感识别损失,speaker_loss表示说话人对抗任务损失。

14、在一个实施例中,合成目标声学参数谱损失为

15、

16、其中,x为原始的语音信号,s为x的梅尔谱图,φ(x)为获取梅尔谱函数,φ(g(s))为生成器生成的语音信号;

17、合成语音声学结束损失为

18、

19、其中,ni表示特征的个数,di(x)输入x到d后,d中第i层的特征向量,g(s)表示根据梅尔谱s,生成器g自动生成的声学结束音;

20、情感识别损失为

21、

22、其中,x表示原始音频,s表示梅尔谱图,z表示高斯噪声,k表示情感判别器的尺度;

23、说话人对抗任务损失为

24、

25、其中,x表示原始音频,s表示梅尔谱图,z表示高斯噪声,h表示说话人对抗判别器的尺度。

26、在其中一个实施例中,利用训练好的特殊术语语音合成模型对输入的语音和文本进行合成,得到情感可控特殊术语语音,包括:

27、根据无监督韵律表征模型模块中的人工设计特征提取模块对输入语音进行特征提取,得到情感可控的人工设计特征;利用参考编码器对情感可控的人工设计特征进行编码,得到特征向量;

28、根据情感识别模块和说话人对抗网络模型来降低特征向量的文本耦合关联性和说话人关联性,得到关联性特征向量;

29、根据特殊情感预测模型对输入的文本得到情感类别识别和编码,得到情感类别标签向量;将关联性特征向量和情感类别标签向量进行融合,得到韵律编码向量;

30、根据上下文发音内容表征模块对输入的文本进行编码,得到表征向量;将情感类别标签向量、韵律编码向量和表征向量输入到声学解码模块中进行解码融合,得到情感可控特殊术语语音。

31、在其中一个实施例中,根据无监督韵律表征模型模块中的人工设计特征提取模块对输入语音进行特征提取,得到情感可控的人工设计特征,包括:

32、根据人工设计特征提取模块对输入语音进行特征提取,对提取的特征进行归一化处理,得到归一化后的数据;

33、将归一化的数据的基频、能量以及时长统计量调节到[μ-3δ,μ+3δ],得到情感可控的人工设计特征;其中,μ表示基频均值,δ表示基频方差。

34、一种语音合成装置,所述装置包括:

35、特殊情感预测模型构建模块,用于获取特殊场景的情感需求;根据特殊场景的情感需求对特殊场景进行情感类别设计,得到特殊情感类别数据库;情感类别包括缓和、中立、紧急、严肃、严厉和生气;根据预先设置的无监督数据和特殊情感类别数据库对情感预测模型进行训练,得到特殊情感预测模型;

36、构建特殊术语语音合成模型模块,用于构建特殊术语语音合成模型;特殊术语语音合成模型包括无监督韵律表征模型、特殊情感预测模型、上下文发音内容表征模块和声学解码模块;无监督韵律表征模型包括人工设计特征提取模块、参考编码器、情感识别模块、说话人对抗网络模型和情感韵律模块;

37、语音合成模块,用于根据预先设置的无监督韵律损失函数对特殊术语语音合成模型进行训练,得到训练好的特殊术语语音合成模型;利用训练好的特殊术语语音合成模型对输入的语音和文本进行合成,得到情感可控特殊术语语音。

38、一种计算机设备,包括存储器和处理器,所述存储器存储有计算机程序,所述处理器执行所述计算机程序时实现以下步骤:

39、获取特殊场景的情感需求;根据特殊场景的情感需求对特殊场景进行情感类别设计,得到特殊情感类别数据库;情感类别包括缓和、中立、紧急、严肃、严厉和生气;

40、根据预先设置的无监督数据和特殊情感类别数据库对情感预测模型进行训练,得到特殊情感预测模型;

41、构建特殊术语语音合成模型;特殊术语语音合成模型包括无监督韵律表征模型、特殊情感预测模型、上下文发音内容表征模块和声学解码模块;无监督韵律表征模型包括人工设计特征提取模块、参考编码器、情感识别模块、说话人对抗网络模型和情感韵律模块;

42、根据预先设置的无监督韵律损失函数对特殊术语语音合成模型进行训练,得到训练好的特殊术语语音合成模型;利用训练好的特殊术语语音合成模型对输入的语音和文本进行合成,得到情感可控特殊术语语音。

43、一种计算机可读存储介质,其上存储有计算机程序,所述计算机程序被处理器执行时实现以下步骤:

44、获取特殊场景的情感需求;根据特殊场景的情感需求对特殊场景进行情感类别设计,得到特殊情感类别数据库;情感类别包括缓和、中立、紧急、严肃、严厉和生气;

45、根据预先设置的无监督数据和特殊情感类别数据库对情感预测模型进行训练,得到特殊情感预测模型;

46、构建特殊术语语音合成模型;特殊术语语音合成模型包括无监督韵律表征模型、特殊情感预测模型、上下文发音内容表征模块和声学解码模块;无监督韵律表征模型包括人工设计特征提取模块、参考编码器、情感识别模块、说话人对抗网络模型和情感韵律模块;

47、根据预先设置的无监督韵律损失函数对特殊术语语音合成模型进行训练,得到训练好的特殊术语语音合成模型;利用训练好的特殊术语语音合成模型对输入的语音和文本进行合成,得到情感可控特殊术语语音。

48、上述一种语音合成方法、装置、设备及介质,首先根据特殊场景的情感需求对特殊场景进行情感类别设计,得到特殊情感类别数据库,根据预先设置的无监督数据和特殊情感类别数据库对情感预测模型进行训练,得到特殊情感预测模型,在构建的特殊术语语音合成模型时,通过人工设计特征提取或特殊情感预测情感控制实现情感控制,将人工设计特征与无监督韵律提取网络相结合提取情感韵律的编码,为提升情感韵律的合成语音效果,进一步对无监督网络约束进行设计,利用设计的无监督韵律损失函数对特殊术语语音合成模型进行训练,为提升情感韵律对合成语音的控制力,缓解情感韵律与文本以及说话人的强耦合关系,加入情感识别模块来增强情感韵律和情感的相关性,降低与文本耦合关系;加入说话人对抗网络模块来降低韵律和说话人的关联性,最后在声学模型解码端对将发音内容结合情感韵律与情感标签进行解码,实现情感特殊术语预测标签的语音合成和指定标签的情感特殊术语语音合成,提高语音合成质量。

本文地址:https://www.jishuxx.com/zhuanli/20240618/22989.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表