一种音色和风格深度解耦的语音风格迁移系统及方法与流程

- 国知局

- 2024-06-21 11:45:06

本发明涉及语音合成,更具体的说是涉及一种音色和风格深度解耦的语音风格迁移系统及方法。

背景技术:

1、目前语音合成技术能合成高自然度高音质的音频,可以满足生活应用中较多的需求,比如视频配音和播报等。但相比真人发音还是有不小的距离,真人具备多种情感和多种风格说话方式的能力。风格是语音表现力不可或缺的元素,带风格的语音合成也成为当下研究的热点。尽管目前可以通过声优录制多种风格的语音进行训练语音合成模型达到单音色多风格的目的,但这种模式存在很多难以解决的缺陷:(1)风格受声优模仿能力的影响,每个声优的能力都是有限的,很难对每种风格都进行完美的模仿;(2)可拓展性差且成本高昂,要想增加一种风格就需要重新让该声优录制新风格的音频,定制周期比较长且录制成本高。

2、实际情况是目前有很多种风格的数据,但每个人都只有一两种风格的数据,因此要实现单个说话人多种风格的能力最理想的方式就是进行风格迁移。现有技术中,虽然已提出不少的方法进行语音风格迁移,目前的效果仍难达到预期,这是由于语音中音色和风格信息深度耦合在一起导致的,比较突出的问题是要么风格不能成功迁移,要么风格迁移后音色发生泄露,导致合成音频的音色不像目标说话人,效果不理想,或者迁移后合成音频的音质比较差。

技术实现思路

1、有鉴于此,本发明提供至少解决上述部分技术问题的一种音色和风格深度解耦的语音风格迁移系统及方法,便于实现语音中风格和身份信息的充分解耦,有利于解决语音风格迁移中存在的音色泄露和迁移不稳定的问题,从而达到语音库中理想的风格迁移,可使库中的每个说话人具备库中多种风格的发音能力。

2、为实现上述目的,本发明采取的技术方案为:

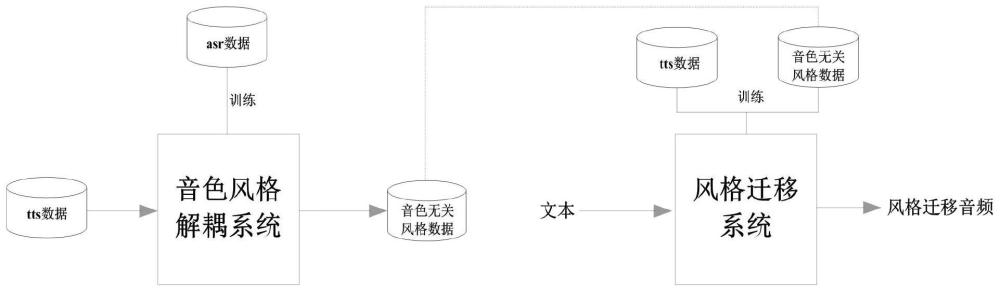

3、第一方面,本发明提供一种音色和风格深度解耦的语音风格迁移系统,音色风格解耦子系统和风格迁移子系统,其中:

4、所述音色风格解耦子系统,用于从语音合成数据中提取出音色无关的风格数据,供风格迁移子系统进行风格建模及音频合成;

5、所述风格迁移子系统,用于结合说话人信息生成具有目标风格和音色的音频。

6、优选的,所述音色风格解耦子系统中利用wenetasr模型从输入的语音合成数据中提取只包含风格不包含音色的bn特征。

7、优选的,wenetasr模型的编码器通过若干个conformerblock构建。

8、优选的,通过语音转换模型验证所述bn特征只包含风格不包含音色信息;所述语音转换模型包括:bn编码器,音色编码器和解码器;其中:

9、所述bn编码器包括多个conformerblock,用于将输入音频的bn特征并处理为内容和风格的隐特征;

10、所述音色编码器包括多层卷积和池化层,用于将目标说话人的参考音频处理为固定维度的说话人向量;

11、所述解码器包括多个conformerblock,用于结合所述隐特征和所述说话人向量进行解码生成最终的转换音频。

12、优选的,使用中文语音识别数据集训练所述wenetasr模型,从所述wenet asr模型提取出的所述bn特征作为风格特征供风格迁移子系统训练。

13、优选的,所述风格迁移子系统包括:文本编码器、梅尔编码器、风格预测器、时长预测器、bn解码器和梅尔解码器;其中

14、所述文本编码器,用于将输入文本生成文本隐特征;

15、所述梅尔编码器,用于处理辅助风格建模的与文本时间对齐的梅尔频谱,生成辅助风格信息隐特征;

16、所述风格预测器,用于以文本和风格id预测所述梅尔编码器输出的隐特征;

17、所述时长预测器,用于预测文本序列的时长,依据时长复制规整文本序列中每个文本隐特征,使最后文本隐特征长度和bn特征一致;

18、所述bn解码器,用于从融合的文本和辅助风格信息隐特征中生成bn风格特征;

19、所述梅尔解码器,用于将所述bn风格特征结合说话人信息生成具有目标风格和目标音色的梅尔频谱声学特征。

20、优选的,所述文本编码器、梅尔编码器和风格预测器均通过多层卷积网络构建。优选的,与文本时间对齐的梅尔频谱包含风格以及韵律的细节信息。

21、优选的,所述时长预测器采用双向rnn和全连接层构建。

22、优选的,所述bn解码器和所述梅尔解码器均采用多层conformer结构。

23、优选的,通过计算风格预测器与梅尔编码器的输出特征均方误差,优化所述风格预测器。

24、第二方面,本发明还提供一种音色和风格深度解耦的语音风格迁移方法,应用于上述的一种音色和风格深度解耦的语音风格迁移系统,进行语音风格迁移,该方法包括:

25、音色风格解耦阶段:

26、通过音色风格解耦子系统从语音合成数据中提取出音色无关的风格数据,供风格迁移子系统进行风格建模及音频合成;

27、风格迁移阶段:

28、通过风格迁移子系统结合说话人信息生成具有目标风格和音色的音频。

29、优选的,所述音色风格解耦子系统中利用wenetasr模型从输入的语音合成数据中提取只包含风格不包含音色的bn特征。

30、优选的,通过语音转换模型验证所述bn特征只包含风格不包含音色信息。

31、优选的,使用中文语音识别数据集训练所述wenetasr模型,从所述wenet asr模型提取出的所述bn特征作为风格特征供风格迁移子系统训练。

32、与现有技术相比,本发明至少具有如下有益技术效果:

33、本发明公开了一种音色和风格深度解耦的语音风格迁移系统及方法,利用本发明便于实现语音中风格和身份信息的充分解耦,有利于解决语音风格迁移中存在的音色泄露和迁移不稳定的问题,从而达到语音库中理想的风格迁移,可使库中的每个说话人具备库中多种风格的发音能力。

34、本发明的其它特征和优点将在随后的说明书中阐述,并且,部分地从说明书中变得显而易见,或者通过实施本发明而了解。本发明的目的和其他优点可通过在所写的说明书以及附图中所特别指出的结构来实现和获得。

35、下面通过附图和实施例,对本发明的技术方案做进一步的详细描述。

技术特征:1.一种音色和风格深度解耦的语音风格迁移系统,其特征在于,该系统包括:音色风格解耦子系统和风格迁移子系统,其中:

2.根据权利要求1所述的一种音色和风格深度解耦的语音风格迁移系统,其特征在于,所述音色风格解耦子系统中利用wenetasr模型从输入的语音合成数据中提取只包含风格不包含音色的bn特征。

3.根据权利要求2所述的一种音色和风格深度解耦的语音风格迁移系统,其特征在于,wenetasr模型的编码器通过若干个conformerblock构建。

4.根据权利要求3所述的一种音色和风格深度解耦的语音风格迁移系统,其特征在于,通过语音转换模型验证所述bn特征只包含风格不包含音色信息;所述语音转换模型包括:bn编码器,音色编码器和解码器;其中:

5.根据权利要求2所述的一种音色和风格深度解耦的语音风格迁移系统,其特征在于,使用中文语音识别数据集训练所述wenetasr模型,从所述wenet asr模型提取出的所述bn特征作为风格特征供风格迁移子系统训练。

6.根据权利要求2所述的一种音色和风格深度解耦的语音风格迁移系统,其特征在于,所述风格迁移子系统包括:文本编码器、梅尔编码器、风格预测器、时长预测器、bn解码器和梅尔解码器;其中

7.根据权利要求6所述的一种音色和风格深度解耦的语音风格迁移系统,其特征在于,所述文本编码器、梅尔编码器和风格预测器均通过多层卷积网络构建。

8.根据权利要求6所述的一种音色和风格深度解耦的语音风格迁移系统,其特征在于,与文本时间对齐的梅尔频谱包含风格以及韵律的细节信息。

9.根据权利要求6所述的一种音色和风格深度解耦的语音风格迁移系统,其特征在于,所述时长预测器采用双向rnn和全连接层构建。

10.根据权利要求6所述的一种音色和风格深度解耦的语音风格迁移系统,其特征在于,所述bn解码器和所述梅尔解码器均采用多层conformer结构。

11.根据权利要求6所述的一种音色和风格深度解耦的语音风格迁移系统,其特征在于,通过计算风格预测器与梅尔编码器的输出特征均方误差,优化所述风格预测器。

12.一种音色和风格深度解耦的语音风格迁移方法,其特征在于,应用于如权利要求1-11中任一项所述的一种音色和风格深度解耦的语音风格迁移系统,进行语音风格迁移,该方法包括:

13.根据权利要求12所述的一种音色和风格深度解耦的语音风格迁移方法,其特征在于,所述音色风格解耦子系统中利用wenetasr模型从输入的语音合成数据中提取只包含风格不包含音色的bn特征。

14.根据权利要求13所述的一种音色和风格深度解耦的语音风格迁移方法,其特征在于,通过语音转换模型验证所述bn特征只包含风格不包含音色信息。

15.根据权利要求13所述的一种音色和风格深度解耦的语音风格迁移方法,其特征在于,使用中文语音识别数据集训练所述wenetasr模型,从所述wenetasr模型提取出的所述bn特征作为风格特征供风格迁移子系统训练。

技术总结本发明公开了一种音色和风格深度解耦的语音风格迁移系统及方法,涉及语音合成技术领域,该系统包括:音色风格解耦子系统和风格迁移子系统,其中:音色风格解耦子系统,用于从语音合成数据中提取出音色无关的风格数据,供风格迁移子系统进行风格建模及音频合成;风格迁移子系统,用于结合说话人信息生成具有目标风格和音色的音频。利用本发明可对语音中风格和身份信息的充分解耦,从根本上解决目前语音风格迁移中存在的音色泄露和迁移不稳定的问题,便于实现语音库中理想的风格可控迁移,使库中的每个说话人具备库中所有的风格的发音能力,有助于提升目前语音合成的应用场景。技术研发人员:刘刚,苏江受保护的技术使用者:暗物质(北京)智能科技有限公司技术研发日:技术公布日:2024/4/22本文地址:https://www.jishuxx.com/zhuanli/20240618/23359.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表