一种融合声码器和相位估计的语音增强方法和系统

- 国知局

- 2024-06-21 11:46:46

本发明涉及语音增强,尤其涉及一种融合声码器和相位估计的语音增强方法和系统。

背景技术:

1、在日常生活中,语音是人们接触最多同时也是使用频率最高的信息之一。因为环境嘈杂或受网络传输过程中的各种因素所影响,语音信号不可避免地会带有噪声,如身处道路时汽车的喇叭声或传输过程中因为网络信号问题所造成的电流声。随着智能网络与信息传递的快速发展,ai技术在人们生活便利化过程中的不断渗透,语音信息传递的准确性对人类日常生活的重要性越来越大,语音增强模型的优化与提升也越来越重要。

2、语音增强技术旨在通过各种算法来改善语音质量;通过降噪来提高被噪声破坏的语音,即噪声降低,是语音增强中最重要的领域。根据语音信号的通道数量,可分为单通道与多通道两个研究方向,其中单通道语音增强作为其他研究的基础,是尤其重要的一环。

3、传统语音增强架构主要基于傅里叶变换的应用,时域下的语音波形经过傅里叶变换后生成为时频域下的幅度谱与相位谱,处理后再通过逆傅里叶变换重新恢复成增强后的语音波形。随着数字信号处理理论的不断完善,其已成为传统语音增强模型的有效助力,并衍生出了许多经典算法,如子空间语音增强法、wiener滤波法、谱减法等经典算法。这些算法大多采用傅里叶变化,对变换后噪声与非噪声的频谱进行处理的方法。例如传统谱减法可以将噪声频谱分量分离出来;或如wiener滤波法在时域上应用滤波器,以达到滤过噪声的目的。

4、21世纪初随着计算机算力的极大提升,深度学习成为了各信息处理领域的研究场景中最重要的应用趋势之一,语音增强逐渐被广泛纳入成为一种机器学习领域的有监督学习问题,结合神经网络进行语音增强成为了当前该研究领域的主流方法。基于深度学习神经网络的语音增强方法大致可分为两种:第一种方法是将时频信号通过短时傅里叶变换转换为时频频谱,并应用神经网络结构将其映射到干净语音的频谱;另一种方法则是直接输入时频信号,利用神经网络的学习能力将其映射到干净语音。在早期深度学习研究尚浅的阶段,语音增强仍然局限于只增强幅度谱,不改变噪声相位谱,但这样的方法存在一定的局限性,并带来了一些挑战和风险。由于相位组件中存在随机结构,并且相位是影响语音质量的一大影响因素,而一些传统仅依赖于幅值分量进行建模的模型忽略了相位分量,这将面临仅增强幅度谱可能带来语音失真问题的危机。

5、由上述可知,现有技术方案局限于只增强幅度谱,不改变噪声相位谱,典型方法如理想比值掩蔽ibm(ideal ratio mask)、相位敏感掩蔽psm(phase-sensitive mask)等。现有技术方案方法至少存在如下缺陷:

6、一方面,传统处理方法需要对音频信号先做出分布假设,一旦假设与实际情况出入较大,增强后的语音将会与纯净语音差别甚大,可能导致失真的现象发生,难以适应当今的通信要求,故催生了一系列充分发挥各类深度学习网络之优点的语音增强模型。然而,由于语音的各个属性间的复杂关系,神经网络模型的设计过程中难以兼顾质量和速度,即语音生成的质量和模型训练、语音处理的速度。

7、另一方面,语音作为一种时域下的信号,频谱(frequency spectrum)是指一个时域的信号在频域下的表示方式,可以针对信号进行傅里叶变换而得,所得的结果会是分别以幅度及相位为纵轴,频率为横轴的两张图,即幅度谱和相位谱。其中,相位谱具有连续性和相关性,相位信息受到频谱成分的影响,不同频率上的相位差异可能会对语音信号产生不同程度的影响。传统的单通道语音增强模型通常采用的方法是增强带噪语音的幅度谱,而对相位谱缺乏处理,影响了生成语音的质量。近年来大多数研究尝试在增强幅度谱后细化复数谱以实现对相位谱的增强,但相位和幅度间的补偿效应又大大降低了相位预测的准确性。特别是在低信噪比环境下,噪声可能掩盖了语音信号的细微变化,导致相位信息难以准确提取。因此,如何准确提取相位信息,显著增强相位谱,提高语音增强技术在低信噪比场景下的表现成为了当下该领域技术发展的一个严峻挑战。

8、故,针对现有技术的缺陷,实有必要提出一种技术方案以解决现有技术存在的技术问题。

技术实现思路

1、有鉴于此,确有必要提供一种融合声码器和相位估计的语音增强方法和系统,采用梅尔频谱(mel-spectrogram)作为声学特征,高保真度生成对抗网络hifi-gan作为声码器,以达到速度与质量的均衡,从而解决模型结构不同导致的处理速度与生成质量之间的平衡关系问题;同时,利用一个基于时频域的单通道语音增强模型,通过相位解码器结合抗卷绕损失函数能够直接处理相位信息,并将此相位信息融合声码器输出,得到降噪后的语音信号,解决了相位问题。

2、为了解决现有技术存在的技术问题,本发明的技术方案如下:

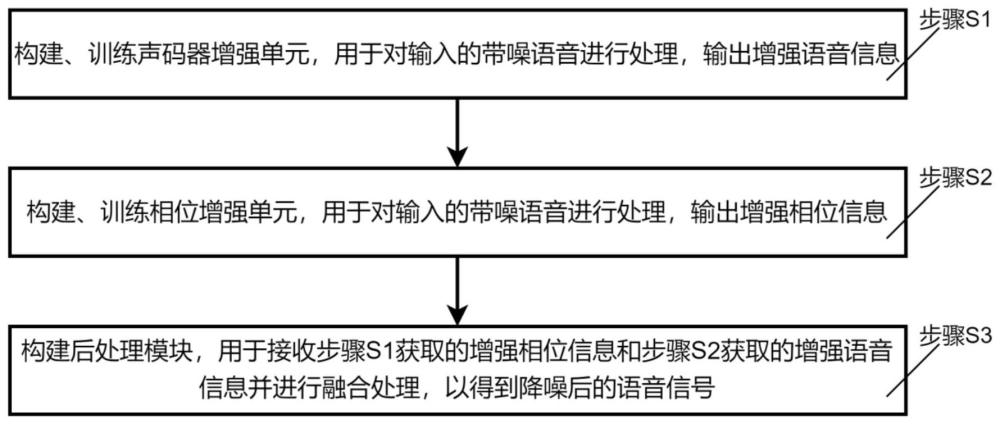

3、一种融合声码器和相位估计的语音增强方法,至少包括如下步骤:

4、步骤s1:构建、训练声码器增强单元,用于对输入的带噪语音进行处理,输出增强语音信息;

5、步骤s2:构建、训练相位增强单元,用于对输入的带噪语音进行处理,输出增强相位信息;

6、步骤s3:构建后处理模块,用于接收步骤s2获取的增强相位信息和步骤s1获取的增强语音信息并进行融合处理,以得到降噪后的语音信号。

7、作为进一步的改进方案,步骤s2中,相位增强单元至少设置相位降噪模块,相位降噪模块采用神经网络实现。

8、作为进一步的改进方案,步骤s2还包括如下步骤:

9、步骤s21:训练相位降噪模块;

10、步骤s22:使用训练好的相位降噪模块处理带噪语音,得到增强后的的相位信息;

11、其中,相位降噪模块至少包括相位编码器、两级卷积增强变压器和相位解码器。

12、作为进一步的改进方案,步骤s21包括:

13、步骤s211:获得大量成对的带噪语音与干净语音的训练集,并对其进行数据预处理;

14、步骤s212:从预处理后的数据集中提取语音信号的特征,作为步骤s23中模型的输入;

15、步骤s213:通过监督学习的方法训练相位降噪模块,训练过程中使用抗卷绕损失函数,多次迭代得到所对应最佳模型。

16、作为进一步的改进方案,步骤s213中,训练过程所采用的损失函数如下式:

17、

18、其中,表示抗卷绕损失函数的值,和分别表示瞬时相位损失、群延迟损失以及瞬时角频率损失,它们分别定义为:

19、

20、

21、

22、其中,xp表示干净语音的相位谱,表示训练过程中模型所预测的干净语音相位谱,是一个抗卷绕函数,δdf和δdt分别代表了沿频率轴和时间轴的微分算子,表示期望,||·||1表示l1范数。

23、作为进一步的改进方案,步骤s22进一步包括:

24、步骤s221:带噪语音经过短时傅里叶变换后得到对应的带噪相位谱与带噪幅度谱,丢弃带噪幅度谱,仅保留带噪相位谱;

25、步骤s222:步骤s221中获得的带噪相位谱作为相位编码器的输入,输出以其压缩后的时频域表示;

26、步骤s223:用一个两级卷积增强变压器对步骤s222得到的时频域表示进行处理;

27、步骤s224:时频域表示经过步骤s223的处理后作为相位解码器的输入,输出以干净的增强后相位谱

28、作为进一步的改进方案,声码器增强单元至少包括梅尔频谱提取模块、梅尔频谱域降噪模块和神经网络声码器模块,其中,梅尔频谱域降噪模块和神经网络声码器模块采用神经网络实现。

29、作为进一步的改进方案,步骤s1包括如下步骤:

30、步骤s11:从训练集获取特征,使用与步骤s211同样的方式获得带噪语音和对应干净语音组成的训练集,通过梅尔频谱提取模块,从带噪语音提取出带噪梅尔频谱,从对应干净语音提取对应干净梅尔频谱;

31、步骤s12:使用步骤s11中提取的梅尔频谱,训练梅尔频谱域降噪模块;

32、步骤s13:使用步骤s11中获得的干净语音、提取的梅尔频谱,训练神经网络声码器模块,完成声码器增强单元的训练;

33、步骤s14:使用训练好的声码器增强单元处理带噪语音,得到增强后的合成语音波形。

34、本发明还公开了一种融合声码器和相位估计的语音增强系统,至少包括声码器增强单元、相位增强单元和后处理模块,其中,

35、声码器增强单元,用于对输入的带噪语音进行处理,输出增强语音信息;

36、相位增强单元,用于对输入的带噪语音进行处理,输出增强相位信息;

37、后处理模块,用于接收步骤s2获取的增强相位信息和步骤s1获取的增强语音信息并进行融合处理,以得到降噪后的语音信号。

38、作为进一步的改进方案,相位增强单元至少设置相位降噪模块,相位降噪模块至少包括相位编码器、两级卷积增强变压器和相位解码器;

39、声码器增强单元至少包括梅尔频谱提取模块、梅尔频谱域降噪模块和神经网络声码器模块,其中,梅尔频谱域降噪模块和神经网络声码器模块采用神经网络实现;神经网络声码器模块采用高保真度生成对抗网络hifi-gan。

40、与现有技术相比较,本发明技术方案采用融合声码器和相位估计的语音增强联合架构,其中,声码器为生成质量高、速度快的声码器hifi-gan,一定程度上兼顾了质量与速度,同时采用了多种损失函数进行优化,进一步提升了语音增强模型生成模型的质量;另外,采用的相位解码器和抗卷绕相位损失函数解决了相位处理的关键难题,有效提高了语音增强技术在低信噪比场景下的表现。

本文地址:https://www.jishuxx.com/zhuanli/20240618/23517.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表