拟人化的副语言语音合成方法及系统与流程

- 国知局

- 2024-06-21 11:46:48

本发明属于语音处理,涉及一种拟人化的副语言语音合成方法及系统。

背景技术:

1、目前语音合成技术能合成高自然度高音质的音频,可以满足生活应用中较多的需求,比如视频配音和播报等。但相比真人发音还是有不小的距离,尤其是对话场景中,真人对话可以用“嗯,emmm,呃”不同的停顿和犹豫来思考下一句所说内容,或者发出一些笑声或呼气等非语言声音来表达当前说话人的状态,这种不带有实际语义的发音在语音学被称为副语言现象,而现有的tts模型(text to speech,文本到语音)往往会用相同的语速流畅地说话,在整个对话过程就显得比较机械和僵硬,缺少副语言让tts在对话过程中难以达到拟人的效果。

2、目前带副语言的tts研究并不多,市面上也很少有相关的产品。一般情况下要达到副语言发音,须进行额外的副语言标注,即首先定义好副语言标签,设计场景及其对应下的文本,声优根据文本以及文本中的标签进行声音的演绎,最后tts模型根据定制的数据进行训练从而具备发音副语言的能力。这种模式理论上可行,也存在些许问题。首先,定制成本相比一般的tts数据要更昂贵,数据录制周期也更长;其次,副语言是否能迁移也仍待验证,即能录制副语言的是说话人张三,而目标是想说话人李四具备副语言发音能力。

3、因此,如何提供一种高拟人化、可泛化的副语言语音合成方法及系统是本领域技术人员亟需解决的问题。

技术实现思路

1、有鉴于此,本发明提出了一种拟人化的副语言语音合成方法及系统,能以低成本实现语音库中的说话人具备副语言发音能力,提升tts说话人在对话过程的自然度及真实度,使ai在人机交互中零距离交流。

2、为了实现上述目的,本发明采用如下技术方案:

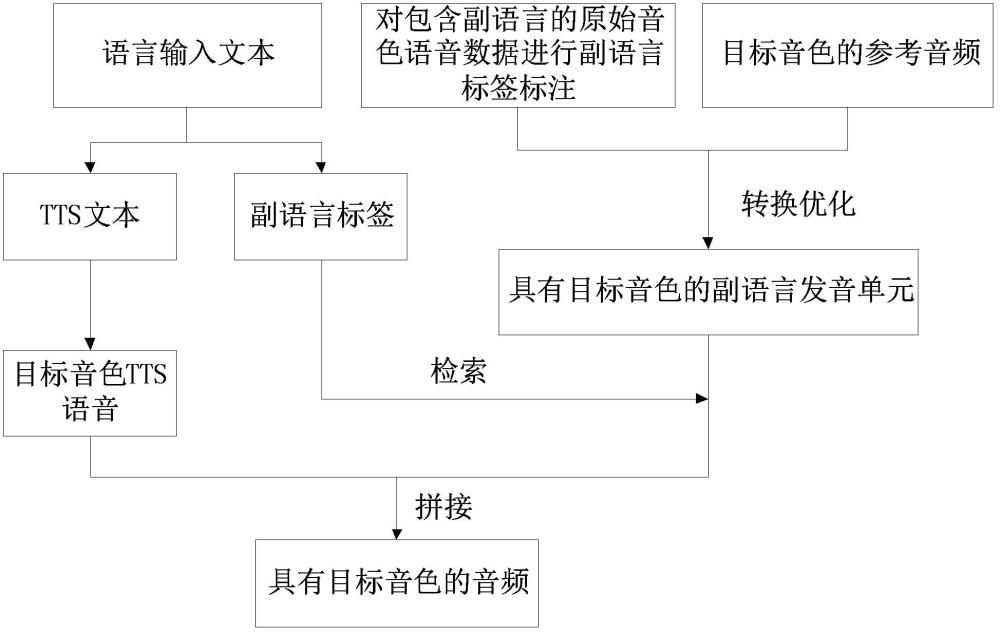

3、本发明公开了一种拟人化的副语言语音合成方法,包括如下步骤:

4、s1:对包含副语言的原始音色语音数据进行副语言标签标注,根据标注后的原始音色语音数据,结合目标音色的参考音频获取具有目标音色的副语言发音单元;

5、s2:接收语言输入文本,所述语言输入文本包括tts文本和在tts文本中相应位置标注的副语言标签;将所述tts文本合成目标音色tts语音,根据所述副语言标签选择相应的具有目标音色的副语言发音单元,并与所述目标音色tts语音进行拼接,生成具有目标音色的音频。

6、需要说明的是,本实施例中的原始音色语音数据中包含一种或多种音色,且至少一种音色中包含副语言。

7、优选的,所述s1包括:

8、s11:语音识别步骤:对包含副语言的原始音色语音数据进行副语言标签标注,将标注后的原始音色语音数据进行语音识别提取ppg特征和基频特征;

9、s12:语音转换步骤:对所述ppg特征进行内容编码,对所述基频特征进行语调编码,对所述目标音色的参考音频进行音色编码,将编码结果进行统一解码,获得具有目标音色的副语言发音单元。

10、优选的,还包括语音识别模型的训练步骤,其中,所述语音识别模型用于执行所述语音识别步骤:

11、采集包含副语言的语音对话数据集,并对所述语音对话数据集中的副语言进行副语言标签标注,获得标注后的语音对话数据集;

12、构建wenet模型,所述wenet模型包括conformer encoder,用于接收输入音频,并输出输入音频的ppg特征;

13、使用中文语音识别数据集对所述wenet模型进行预训练;

14、使用所述标注后的语音对话数据集对预训练后的所述wenet模型的权重进行微调,获得训练完成的语音识别模型。

15、优选的,还包括语音转换模型的训练步骤,其中,所述语音转换模型用于执行所述语音转换步骤:

16、使用中文语音识别数据集的音频,以及对应音频的ppg特征和基频特征对所述语音转换模型进行预训练;

17、使用目标音色的音频和标注后的语音对话数据集的音频,以及对应音频的ppg特征和基频特征对预训练后的所述语音转换模型的权重进行微调,获得训练完成的语音转换模型。

18、优选的,所述s12还包括,将编码结果进行统一解码后,获得与原始音色语音数据内容相对应的目标音色音频数据,并结合副语言标签所在位置,截取出目标音色副语言字段音频数据,即具有目标音色的副语言发音单元。

19、优选的,对所述s1获取的不同于副语言标签对应的具有目标音色的副语言发音单元进行存储,得到副语言数据库;所述s2中根据所述副语言标签从所述副语言数据库中检索其对应的具有目标音色的副语言发音单元。

20、优选的,所述s2中具有目标音色的副语言发音单元与所述目标音色tts语音进行拼接的步骤包括:

21、构建语音顺滑模型,使用目标音色的音频作为训练集训练自回归模型,所述自回归模型包括解码器,利用上一语音帧预测下一语音帧;

22、将具有目标音色的副语言发音单元与所述目标音色tts语音输入训练后的所述语音顺滑模型进行语音顺滑,输出具有目标音色的音频。

23、本发明还公开了一种根据所述的拟人化的副语言语音合成方法的拟人化的副语言语音合成系统,包括:

24、副语言单元提取子系统,用于对包含副语言的原始音色语音数据进行副语言标签标注,根据标注后的原始音色语音数据,结合目标音色的参考音频获取具有目标音色的副语言发音单元;

25、副语言合成子系统,用于接收语言输入文本,所述语言输入文本包括tts文本和在tts文本中相应位置标注的副语言标签;将所述tts文本合成目标音色tts语音,根据所述副语言标签选择相应的具有目标音色的副语言发音单元,并与所述目标音色tts语音进行拼接,生成具有目标音色的音频。

26、优选的,所述副语言单元提取子系统包括:

27、语音识别模块,用于对包含副语言的原始音色语音数据进行副语言标签标注,将标注后的原始音色语音数据进行语音识别提取ppg特征和基频特征;

28、语音转换模块,用于对所述ppg特征进行内容编码,对所述基频特征进行语调编码,对所述目标音色的参考音频进行音色编码,将编码结果进行统一解码,获得具有目标音色的副语言发音单元。

29、优选的,所述语音识别模块包括语音识别模型,所述语音识别模型按照如下步骤进行训练:

30、采集包含副语言的语音对话数据集,并对所述语音对话数据集中的副语言进行副语言标签标注,获得标注后的语音对话数据集;

31、构建wenet模型,所述wenet模型包括conformer encoder,用于接收输入音频,并输出输入音频的ppg特征;

32、使用中文语音识别数据集对所述wenet模型进行预训练;

33、使用所述标注后的语音对话数据集对预训练后的所述wenet模型的权重进行微调,获得训练完成的语音识别模型。

34、优选的,所述语音转换模块包括语音转换模型,所述语音转换模型按照如下步骤进行训练:

35、使用中文语音识别数据集的音频,以及对应音频的ppg特征和基频特征对所述语音转换模型进行预训练;

36、使用目标音色的音频和标注后的语音对话数据集的音频、以及对应音频的ppg特征和基频特征对预训练后的所述语音转换模型的权重进行微调,获得训练完成的语音转换模型。

37、优选的,还包括副语言发音单元截取模块,用于对编码结果进行统一解码获得的与原始音色语音数据内容相对应的目标音色音频数据执行截取操作,包括:结合副语言标签所在位置,截取出目标音色副语言字段音频数据,即具有目标音色的副语言发音单元。

38、优选的,还包括副语言数据库,用于存储不同于副语言标签对应的具有目标音色的副语言发音单元;副语言合成子系统根据所述副语言标签从所述副语言数据库中检索其对应的具有目标音色的副语言发音单元。

39、优选的,还包括语音顺滑模块,所述语音顺滑模块内构建语音顺滑模型,所述语音顺滑模型包括使用目标音色的音频作为训练集训练的自回归模型,所述自回归模型包括解码器,利用上一语音帧预测下一语音帧;

40、所述语音顺滑模型用于接收输入的具有目标音色的副语言发音单元与所述目标音色tts语音进行语音顺滑,输出具有目标音色的音频。

41、经由上述的技术方案可知,与现有技术相比,本发明具有以下增益效果:

42、本发明提出的副语言语音合成方法及系统能够以极低成本的实现目标说话人具备副语言发音的能力,一方面,该方法具有高可拓展性,适用于任何新入库的说话人,另一方面,由于我们的转换模型和顺滑模型,能完美实现副语言发音单元和tts合成音频的音色和自然度的承接,达成tts系统高拟人度的发音,实现人机交互场景中更沉浸式的对话。

本文地址:https://www.jishuxx.com/zhuanli/20240618/23525.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

上一篇

一种双孔排箫的制作方法

下一篇

返回列表