一种基于隐私保护的声纹年龄段估计方法及系统

- 国知局

- 2024-06-21 11:49:34

本发明涉及声纹识别,具体涉及一种基于隐私保护的声纹年龄段估计方法及系统。

背景技术:

1、声纹识别技术的飞速发展给人们的生活带来了诸多便利,但也引发了人们对声音数据隐私保护和安全性的关切。作为是一种极具个人特征的生物数据,因此声纹隐私保护显得愈发至关重要。然而,传统的声纹识别方法通常需要使用个体的原始声音数据,这可能会带来隐私泄漏的风险。因此,在估计声纹中的年龄属性时,保护声纹中的个人隐私成为当下待解决的问题。

2、声纹年龄段估计常规流程主要基于声音数据的时域和频域特征提取,包括声音的频谱、声音强度、语速等特征的分析。随后,这些特征会被输入到机器学习或深度学习模型中,以建立与年龄之间的关系。这些模型经过充分训练后,可以对新的声音样本进行年龄属性估计,从而实现声纹年龄段估计任务。然而,在面对隐私保护条件下的声纹时,传统流程存在一定的局限性。例如,传统流程中的声纹属性估计主要集中在原始声音数据上,这可能导致潜在的隐私泄漏风险。

技术实现思路

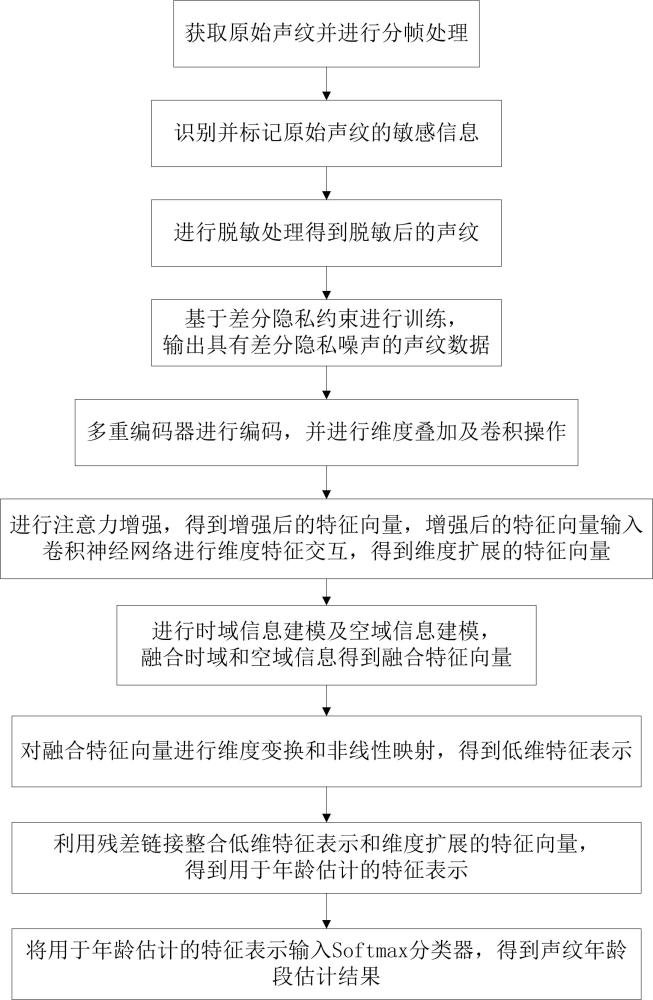

1、为了克服现有技术存在的缺陷与不足,本发明提供一种基于隐私保护的声纹年龄段估计方法,针对在隐私条件下声纹估计年龄困难问题,本发明首先通过融合多级编码器来强化声纹特征的表达能力;其次,引入长短记忆力网络和注意力机制,对时域和空域进行年龄解耦,以更精准地捕捉声音数据中与年龄相关的特征,从而提升隐私条件下声纹年龄段估计的鲁棒性和准确性。

2、为了达到上述目的,本发明采用以下技术方案:

3、本发明提供一种基于隐私保护的声纹年龄段估计方法,包括下述步骤:

4、获取原始声纹并进行分帧处理;

5、构建敏感信息数据库,基于敏感信息数据库训练循环神经网络模型,基于训练后的循环神经网络模型识别原始声纹的敏感信息,标记原始声纹的敏感信息;

6、基于第一对抗生成网络对已标记敏感信息的原始声纹进行脱敏处理,得到脱敏后的声纹;

7、脱敏后的声纹输入第二对抗生成网络,基于差分隐私约束进行训练,输出具有差分隐私噪声的声纹数据 y;

8、声纹数据 y分别经过mfcc编码器、fdlp编码器、wav2vec编码器得到特征向量、特征向量和特征向量;

9、将特征向量、特征向量和特征向量进行维度叠加及卷积操作,得到特征向量;

10、将特征向量进行注意力增强,得到增强后的特征向量;

11、将增强后的特征向量输入卷积神经网络进行维度特征交互,得到维度扩展的特征向量;

12、对维度扩展的特征向量进行时域信息建模,基于时域信息建模结果进行空域信息建模,基于残差网络融合时域和空域信息,得到融合特征向量;

13、对融合特征向量进行维度变换和非线性映射,得到低维特征表示;

14、利用残差链接整合低维特征表示及特征向量,得到用于年龄估计的特征表示;

15、将特征表示输入softmax分类器,得到声纹年龄段估计结果。

16、作为优选的技术方案,基于第一对抗生成网络对原始声纹进行脱敏处理,得到脱敏后的声纹,具体表示为:

17、;

18、;

19、;

20、;

21、其中,表示脱敏后的声纹帧,表示第 n帧的敏感声纹帧,表示第一对抗生成网络的第一生成器,表示第一生成器的参数,表示更新后的声纹数据集,表示通过循环神经网络模型提取的特征,是激活函数,表示第 n帧声纹信号包含敏感信息的概率,表示第 n帧是否包含敏感信息的判断,1表示包含敏感信息,0表示不包含,表示阈值。

22、作为优选的技术方案,脱敏后的声纹输入第二对抗生成网络,基于差分隐私约束进行训练,输出具有差分隐私噪声的声纹数据 y,具体表示为:

23、;

24、其中, y表示具有差分隐私噪声的声纹数据,表示第二对抗生成网络的第二生成器,表示第二生成器的参数,为第一对抗生成网络的第一生成器的输出结果,表示服从差分隐私分布的噪声。

25、作为优选的技术方案,特征向量经过注意力增强得到增强后的特征向量,具体表示为:

26、;

27、其中,表示注意力机制中的权重矩阵,表示注意力权重的偏置项,表示激活函数,用于将注意力权重规范化,表示逐元素相乘。

28、作为优选的技术方案,对特征向量进行时域信息建模,基于时域信息建模结果进行空域信息建模,基于残差网络融合时域和空域信息,得到融合特征向量,具体包括:

29、基于 lstm网络对特征向量进行时域信息建模,表示为:

30、;

31、其中,表示 lstm网络输出的声纹特征向量;

32、基于 transformer模型对声纹特征向量进行空域信息建模,表示为:

33、;

34、其中,表示 transformer模型通过对特征进行加权而输出的分数;

35、基于残差网络融合时域和空域信息,得到融合特征向量,表示为:

36、;

37、其中,表示基于残差网络融合时域和空域信息的结果,表示加权矩阵,用于强调与年龄相关的特征维度,表示逐元素相乘,表示最终的融合特征向量。

38、本发明还提供一种基于隐私保护的声纹年龄段估计系统,包括:原始声纹获取模块、预处理模块、声纹隐私保护模块、差分隐私约束模块、隐私声纹特征提取模块、年龄特征解耦模块和年龄段估计模块;

39、所述原始声纹获取模块用于获取原始声纹;

40、所述预处理模块用于对原始声纹进行分帧处理;

41、所述声纹隐私保护模块包括声纹敏感信息标记单元和声纹信息脱敏单元;

42、所述声纹敏感信息标记单元用于构建敏感信息数据库,基于敏感信息数据库训练循环神经网络模型,基于训练后的循环神经网络模型识别原始声纹的敏感信息,标记原始声纹的敏感信息;

43、所述声纹信息脱敏单元用于基于第一对抗生成网络对已标记敏感信息的原始声纹进行脱敏处理,得到脱敏后的声纹;

44、所述差分隐私约束模块用于将脱敏后的声纹输入第二对抗生成网络,基于差分隐私约束进行训练,输出具有差分隐私噪声的声纹数据 y;

45、所述隐私声纹特征提取模块包括多重编码器、多编码器特征融合单元、注意力增强单元和特征维度扩展单元;

46、所述多重编码器包括mfcc编码器、fdlp编码器和wav2vec编码器;

47、所述mfcc编码器、fdlp编码器、wav2vec编码器将声纹数据 y编码得到特征向量、特征向量和特征向量;

48、所述多编码器特征融合单元用于将特征向量、特征向量和特征向量进行维度叠加及卷积操作,得到特征向量;

49、所述注意力增强单元用于将特征向量进行注意力增强,得到增强后的特征向量;

50、所述特征维度扩展单元用于将增强后的特征向量输入卷积神经网络进行维度特征交互,得到维度扩展的特征向量;

51、所述年龄特征解耦模块包括时域信息建模单元、空域信息建模单元、特征融合单元、低维转换单元和残差单元;

52、所述时域信息建模单元用于对维度扩展的特征向量进行时域信息建模;

53、所述空域信息建模单元用于基于时域信息建模结果进行空域信息建模;

54、所述特征融合单元用于基于残差网络融合时域和空域信息,得到融合特征向量;

55、所述低维转换单元用于对融合特征向量进行维度变换和非线性映射,得到低维特征表示;

56、所述残差单元用于利用残差链接整合低维特征表示及特征向量,得到用于年龄估计的特征表示;

57、所述年龄段估计模块用于将特征表示输入softmax分类器,得到声纹年龄段估计结果。

58、作为优选的技术方案,所述声纹信息脱敏单元用于基于第一对抗生成网络对已标记敏感信息的原始声纹进行脱敏处理,得到脱敏后的声纹,具体表示为:

59、;

60、;

61、;

62、;

63、其中,表示脱敏后的声纹帧,表示第 n帧的敏感声纹帧,表示第一对抗生成网络的第一生成器,表示第一生成器的参数,表示更新后的声纹数据集,表示通过循环神经网络模型提取的特征,是激活函数,表示第 n帧声纹信号包含敏感信息的概率,表示第 n帧是否包含敏感信息的判断,1表示包含敏感信息,0表示不包含,表示阈值。

64、作为优选的技术方案,所述差分隐私约束模块用于将脱敏后的声纹输入第二对抗生成网络,基于差分隐私约束进行训练,输出具有差分隐私噪声的声纹数据 y,具体表示为:

65、;

66、其中, y表示具有差分隐私噪声的声纹数据,表示第二对抗生成网络的第二生成器,表示第二生成器的参数,为第一对抗生成网络的第一生成器的输出结果,表示服从差分隐私分布的噪声。

67、作为优选的技术方案,所述注意力增强单元用于将特征向量经过注意力增强得到增强后的特征向量,具体表示为:

68、;

69、其中,表示注意力机制中的权重矩阵,表示注意力权重的偏置项,表示激活函数,用于将注意力权重规范化,表示逐元素相乘。

70、作为优选的技术方案,所述特征融合单元用于基于残差网络融合时域和空域信息,得到融合特征向量,具体包括:

71、基于 lstm网络对特征向量进行时域信息建模,表示为:

72、;

73、其中,表示 lstm网络输出的声纹特征向量;

74、基于 transformer模型对声纹特征向量进行空域信息建模,表示为:

75、;

76、其中,表示 transformer模型通过对特征进行加权而输出的分数;

77、基于残差网络融合时域和空域信息,得到融合特征向量,表示为:

78、;

79、其中,表示基于残差网络融合时域和空域信息的结果,表示加权矩阵,用于强调与年龄相关的特征维度,表示逐元素相乘,表示最终的融合特征向量。

80、本发明与现有技术相比,具有如下优点和有益效果:

81、(1)本发明利用对抗学习对声纹中的敏感信息进行脱敏处理,目的在于平衡隐私保护和声纹年龄段估计特征完整性,虽对声纹数据进行了隐私保护,但对年龄段估计的准确性影响较小,成功实现了隐私安全与声纹分析效能的平衡。

82、(2)本发明通过使用多级编码器、长短期记忆网络(lstm)和注意力机制有效地在时间和空间域内解耦了年龄特征,更精准地捕捉声音数据中的年龄相关特征,提高了在隐私条件下年龄段估计的鲁棒性和准确性。

本文地址:https://www.jishuxx.com/zhuanli/20240618/23791.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。