一种基于跨模态损失的目标语音分离方法及系统

- 国知局

- 2024-06-21 11:51:24

本发明属于语音处理,具体涉及一种基于跨模态损失的目标语音分离方法及系统。

背景技术:

1、本部分的陈述仅仅是提供了与本发明相关的背景技术信息,不必然构成在先技术。

2、目标语音分离问题是指从混合音频中提取出特定的目标说话人的声音,是语音分离问题的一个分支。在复杂多说话人场景中,语音分离可以有效提升语音识别、说话人识别等应用的性能,可应用于远程会议记录、智能家居等系统。不同于多说话人分离提取说话场景中所有说话人语音,目标语音分离只有一个输出,即目标说话人的预估语音。目标语音分离可以避免多说话人分离中的排列模糊问题,且不需要预先知道说话人数量,但必须提供先验知识或辅助信息来指定目标信号。根据辅助信息的形态不同,目标语音分离可以分为依赖目标说话人视觉和依赖目标说话人注册语音片段辅助提取等方法。

3、目标语音分离网络通常由主网络和辅助网络组成,其中主网络用于学习目标说话人掩膜,辅助网络用于学习具有区分性的说话人嵌入。在目标语音分离网络中,辅助网络的输出对主网络具有重要指导意义,当辅助网络生成的说话人嵌入无法区分目标说话人和干扰说话人时,就会出现目标混淆问题,即错误地将干扰说话人提取出来,或得到的目标说话人语音质量不高。同时,辅助网络中用到的说话人标签、说话人预注册片段等信息可能难获取,不适用于现实应用场景。因此,如果能更好地利用辅助信息,提取出具有区分性的嵌入,将进一步提升目标语音分离的性能。

4、但据发明人了解,目前的目标语音分离存在以下问题:

5、(1)容易产生目标混淆:当目标语音与背景噪声或干扰语音在频谱上有重叠时,混合信号中的不同声源在频域上会相互干扰,导致提取出干扰说话人的语音或提取出的目标说话人语音质量低。

6、(2)难以获取部分辅助信息:在依赖目标说话人视觉辅助提取的方法中,在训练时通常需要获取说话人身份标签,计算说话人分类损失来约束说话人提取,但在现实生活中身份标签难以获得;在依赖目标说话人注册语音片段辅助提取的方法中,需要提前获取一段预录制的目标说话人纯净语音,并不适合实际应用场景。

技术实现思路

1、本发明为了解决上述问题,提出了一种基于跨模态损失的目标语音分离方法及系统,本发明通过在模型中引入目标说话人的视觉信息以提取视觉嵌入,采用自提取音频嵌入的方式代替预注册语音,以跨模态损失代替说话人交叉熵损失,能够避免目标混淆问题,提高目标语音分离实际应用场景的适应度。

2、根据一些实施例,本发明采用如下技术方案:

3、一种基于跨模态损失的目标语音分离方法,包括以下步骤:

4、获取目标说话人视频,提取目标说话人唇部序列;

5、获取混合音频信号;

6、利用预训练后的目标语音分离模型,基于目标说话人唇部序列和混合音频信号,得到分离后的目标语音信号,且目标语音分离模型的训练过程考虑跨模态损失;

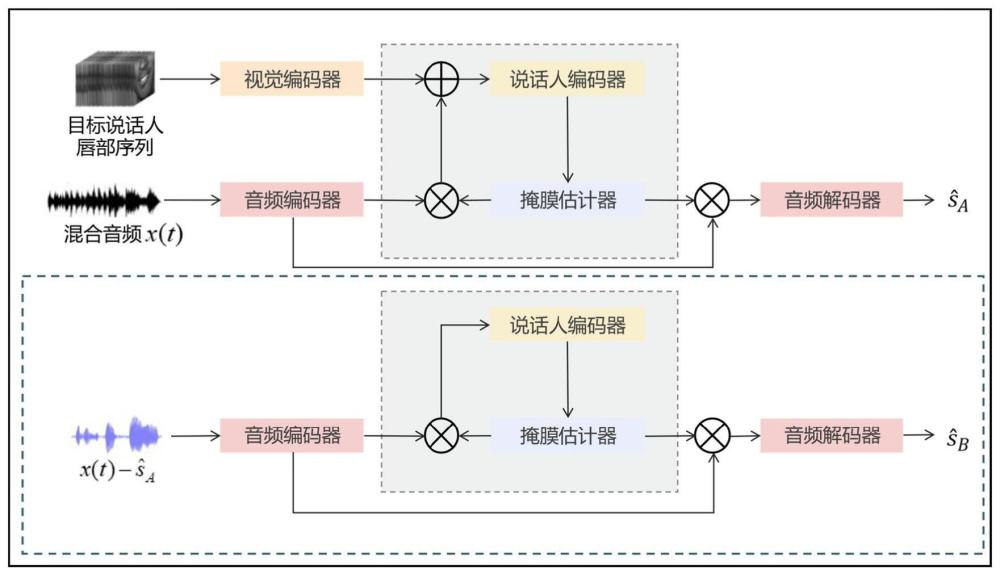

7、所述目标语音分离模型在训练过程为两分支架构,其中:

8、第一分支用于实现视听多模态目标语音提取,基于目标说话人唇部序列和混合音频信号,得到分离后的目标语音信号;

9、第二分支用于实现单模态干扰语音提取,基于第一分支的预估目标语音信号和混合音频信号,得到分离后的干扰语音信号,以获取的干扰语音信号作为辅助信息,通过跨模态损失影响第一分支目标语音的提取;

10、跨模态损失同时影响两分支的训练过程,在目标说话人视觉特征、目标语音特征和干扰语音特征之间进行度量学习,拉近正样本距离,拉远负样本距离,约束视觉和听觉特征的提取。

11、作为可选择的实施方式,所述第一分支包括音频编码器、视觉编码器、说话人提取器和音频解码器,其中:

12、音频编码器从混合音频信号中提取音频嵌入,视觉编码器将目标说话人唇部序列编码为视觉嵌入;

13、说话人提取器接收提取的音频嵌入和视觉嵌入输入,所述说话人提取器包括多层迭代的提取器块,每一个提取器块包括说话人编码器和掩膜估计器,所述说话人编码器在时间维度上拼接两个模态的嵌入,得到含有区分性身份信息的目标说话人嵌入,所述掩膜估计器根据视觉嵌入、目标说话人嵌入和上一层掩膜估计器的输出,得到目标说话人掩膜;

14、所述音频解码器,基于目标说话人掩膜,得到目标语音信号。

15、作为可选择的实施方式,所述第二分支包含依次连接的音频编码器、说话人提取器和音频解码器;

16、所述第二分支仅存在于训练过程中。

17、作为可选择的实施方式,第二分支的音频编码器接收混合音频信号与第一分支中预估的目标语音信号的差值,说话人编码器仅接收音频嵌入,输出干扰说话人嵌入。

18、作为可选择的实施方式,所述音频编码器包括一维卷积,用于将时域音频信号转换为音频特征序列。

19、作为可选择的实施方式,所述音频解码器执行重叠相加操作,用于将音频特征序列重建为音频信号。

20、作为可选择的实施方式,所述视觉编码器包括依次连接的3d卷积层、残差网络层和视频时间卷积层,视频时间卷积层包括依次连接的修正线性单元、批量归一化层和深度可分离卷积层,视觉编码器接收音频同步的裁剪后的目标说话人唇部序列,并通过网络层提取视觉嵌入,对视频时间卷积层的输出进行上采样,最终获得视觉嵌入。

21、作为可选择的实施方式,所述说话人编码器包括依次连接的三个残差块和自适应平均池化层,所述掩膜估计器包括多个堆叠的时间卷积块,每个时间卷积块包括依次连接的多个一维卷积层和残差模块。

22、作为可选择的实施方式,在目标语音分离算法中引入跨模态损失,在目标说话人视觉特征、目标语音特征和干扰语音特征之间进行度量学习,利用视听一致性约束视觉和听觉特征的提取,将干扰说话人信息转化为辅助信息,优化第一分支的语音提取。

23、作为可选择的实施方式,在目标语音分离模型的训练过程中,构建包含三个目标函数的多任务学习框架,第一分支的尺度不变信噪比损失用于衡量提取的目标语音和干净语音之间的质量,第二分支的尺度不变信噪比损失用于衡量提取的干扰语音和干净目标语音之间的质量,跨模态损失用于拉进目标视觉特征和预估目标语音信号音频特征,拉远目标视觉特征和预估干扰语音信号音频特征。

24、作为可选择的实施方式,在目标语音分离模型的训练过程中,使用已有音频数据和对应视频数据,利用adam优化器进行优化训练,直至满足测试要求。

25、一种基于跨模态损失的目标语音分离系统,包括:

26、数据获取模块,被配置为获取目标说话人视频,提取目标说话人唇部序列;获取混合音频信号;

27、目标语音分离模块,被配置为利用预训练后的目标语音分离模型,基于目标说话人唇部序列和混合音频信号,得到分离后的目标语音信号,且目标语音分离模型的训练过程考虑跨模态损失;

28、所述目标语音分离模型在训练过程为两分支架构,其中:

29、第一分支用于实现视听多模态目标语音提取,基于目标说话人唇部序列和混合音频信号,得到分离后的目标语音信号;

30、第二分支用于实现单模态干扰语音提取,基于第一分支的预估目标语音信号和混合音频信号,得到分离后的干扰语音信号,以获取的干扰语音信号作为辅助信息,通过跨模态损失影响第一分支目标语音的提取;

31、跨模态损失同时影响两分支的训练过程,在目标说话人视觉特征、目标语音特征和干扰语音特征之间进行度量学习,拉近正样本距离,拉远负样本距离,约束视觉和听觉特征的提取。

32、一种电子设备,包括存储器和处理器以及存储在存储器上并在处理器上运行的计算机指令,所述计算机指令被处理器运行时,完成上述方法中的步骤。

33、与现有技术相比,本发明的有益效果为:

34、本发明在模型中引入目标说话人的视觉信息以提取视觉嵌入,采用自提取音频嵌入的方式代替预注册语音,拼接自提取的音频嵌入和视觉嵌入并送入说话人编码器获得说话人嵌入,作为分离网络的吸引子,避免了目标混淆问题。

35、本发明以跨模态损失代替说话人交叉熵损失,在训练过程中,拉进目标说话人音频嵌入和视觉嵌入的距离,拉远干扰说话人音频嵌入和视觉嵌入的距离,以督促视觉编码器提取更好的视觉嵌入,进而获得更准确的说话人嵌入,以自提取语音代替预注册语音,重复四次说话人提取器网络,以获取先验知识解决辅助信息难获取的问题。

36、为使本发明的上述目的、特征和优点能更明显易懂,下文特举较佳实施例,并配合所附附图,作详细说明如下。

本文地址:https://www.jishuxx.com/zhuanli/20240618/24016.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。