基于强化学习的城市交通场景下自动驾驶车辆决策规划方法

- 国知局

- 2024-07-31 23:25:06

本发明涉及自动驾驶,特别涉及一种基于强化学习的城市交通场景下自动驾驶车辆决策规划方法。

背景技术:

1、自动驾驶作为信息时代的新产物,可以有效减少交通事故的发生、缓解交通阻塞、弥补交通系统中的薄弱环节。自动驾驶的研究涵盖不同领域,主要包括感知、规划和控制等。感知的目标是理解汽车周围的环境信息,实现诸如语义理解、可通行区域提取、动静障碍物检测、动态障碍物跟踪等功能,以提供下游模块可以直接使用的信息。控制的目标是通过给出车辆前轮转向角、油门开合度以及刹车量等,使车辆实现对参考轨迹的精确跟踪。而规划作为感知和控制之间的桥梁,是自动驾驶的关键技术之一,其目标为综合感知算法给出的结果,给出最优的可供车辆跟踪的轨迹。即满足车辆驶向目的地过程中,避开周围障碍物并尽可能减少花费的时间以及能量消耗等。它是自动驾驶决策系统的核心组成部分,是其能够安全高效地开展自动驾驶的重要保证。

2、在自动驾驶领域中,传统的决策规划算法包括:人工势能法、可视图法、自由空间法、a*算法和d*算法等。近些年,随着人工智能的不断发展,强化学习以其近似于人类学习知识的过程和对复杂环境较强的适应能力,被视为实现场景避障与自动驾驶的重要途径。然而,现有的自动驾驶路径规划算法,既依靠复杂的评估标准来权衡避障与抵达终点间的重要性,又倾向于沿初始设定轨迹航行而忽略了实时的环境交互,使得行驶时中路径长度与运动效率均难以达到最优。目前基于强化学习的自动驾驶路径规划技术尚处于研究阶段,各国学者呈现出百家争鸣的局面。因此,亟需一种强化学习方法能够快速自适应自动驾驶场景,并保障在强安全性、舒适度、时效性和泛化性的条件下完成决策规划任务。故而,研究基于强化学习的城市交通场景下自动驾驶车辆决策规划方法具有重要意义。

技术实现思路

1、针对目前自动驾驶领域决策规划的相关问题,本发明提供了一种基于强化学习的城市交通场景下自动驾驶车辆决策规划方法,该方法采用基于注意力机制的dqn算法作为决策规划方法,并设计合适的奖励函数指导车辆进行学习,同时采用基于改进优先回放经验的方法来提高智能体的学习效率,从而提高方法的安全性能、学习效率、决策速度和泛化能力。

2、为达到以上目的,本发明的技术方案如下:

3、一种基于强化学习的城市交通场景下自动驾驶车辆决策规划方法,所述方法包括以下步骤:

4、步骤1:在自动驾驶车辆上安装多个传感器,车辆通过与所在城市交通环境进行交互,获取环境中自身车辆和相邻车辆的观测信息、状态信息和动作信息等。

5、步骤2:将视觉传感器和激光雷达获取到的环境信息输入至强化学习算法中,在所述算法中增加基于改进优先回放经验的方法,在所述算法中设置基于城市交通场景下的奖励函数,以及在所述网络中增加注意力机制。

6、步骤3:强化学习算法输出相应的自动驾驶决策规划策略,根据城市交通场景下的奖励函数输出该策略的奖励值,并将相应的状态信息、动作信息和奖励值存入经验池中。

7、步骤4:采用基于改进优先回放经验的方法对经验池中的数据进行处理和提取,计算损失值,并更新主网络和目标网络的参数。

8、其中,所述步骤2中包含强化学习算法为基于注意力机制的dqn具体步骤为:

9、s1:所述自动驾驶车辆上安装多个传感器,本发明以视觉传感器和激光雷达为实施例进行说明,初始状态时,由视觉传感器和激光雷达获取城市交通场景中的环境信息,包括观测信息、动作信息以及相邻车辆的信息。

10、s2:将所有环境信息输入注意力机制中,利用注意力机制能够给予重要信息更多关注度的特点,对传感器数据中车辆相关的状态信息赋予更高的权重,从而达到提高有效信息读取能力的目的。相关处理过程为:

11、①压缩:通过全局平均池化来压缩每个通道的特征图,假设输入的视觉传感器和激光雷达数据特征图为x∈rc×h×w,其中c为通道数,h是高度,w是宽度,此阶段的输出为一通道向量z,其计算如下:

12、

13、其中,zc表示通道c的向量,xcij表示在通道c中高度为i宽度为j的数据特征图。

14、②激励:根据压缩阶段输出的每个通道向量z,使用全连接层学习通道的权重,以获得每个通道的注意力权重,通常使用一个单层全连接层来学习通道的权重,给定该全连接层的权重与偏置,则输出的通道注意力权重s计算如下:

15、sc=σ(wexc·zc+bexc)

16、其中,sc表示通道c的注意力权重,wexc表示全连接层的权重,bexc表示全连接层的偏置。通过全连接层将压缩后的特征图映射到一个新的维度,再使用σ激活函数将这个新的维度的数值限制在一个合适的范围内。

17、③缩放:将学习到的注意力权重应用到输入的特征图上,以实现通道的自适应加权。对于激励阶段得到的通道注意力权重向量,其中c是通道数,缩放阶段的输出特征图计算如下:

18、x′cij=sc·xcij

19、s3:根据注意力机制处理后的环境信息,遵循ε-greedy规则,选择合适的规划策略at=argmaxaq(φ(st),a;θ)。

20、s4:执行策略at,依据基于城市交通场景的奖励函数输出奖励r,并到达下一环境状态st+1。

21、s5:将上述过程中的(st,at,rt,st+1)存入经验池d中,并采用基于改进优先回放经验的方法对经验池中的数据进行处理。

22、s6:重复上述步骤,直至经验池存满。

23、s7:当经验池存满后,更新主网络参数。即开始从经验池中使用minibatch策略采样,抽取(st,at,rt,st+1)作为训练数据。将采样得到的rt和st+1送入目标网络中,计算yt=rt+γmaxaq(st+1,a;θ)。接着计算损失值loss=[yt-q(s,a;θ)]2,对主网络参数θ进行梯度下降,使得q(st,at)尽可能接近yt。

24、s8:主网络参数更新z步数后,将主网络更新后的参数全部直接复制给目标网络。

25、其中,所述步骤3中的基于城市交通场景下的奖励函数包含:自动驾驶决策规划的目标是避免发生碰撞并快速且舒适的到达目标点。设置合理的奖励函数可提高车辆的学习性能。考虑到城市交通场景的复杂互动,本发明基于多方面考虑设计了奖励函数。

26、1)安全性

27、在车辆驾驶的过程中,最重要的是需要保证车辆的安全性,即自动驾驶车辆不与环境中的其他任意车辆和障碍物发生碰撞。为了使车辆尽快学习到安全驾驶规则,需要对车辆的碰撞行为进行惩罚。安全性的奖励函数定义如下:

28、

29、其中,ro表示激光传感器测量到的自动驾驶车辆到周围其他车辆的最小距离;rc为碰撞距离。如果自动驾驶车辆与其他车辆发生碰撞,环境将返回-300的较大惩罚。此外,该安全性奖励函数还会对导致靠近其他车辆的行为进行轻微的惩罚。

30、2)目标完成度

31、自动驾驶决策规划的目标是使自动驾驶车辆安全的到达目标点。为确保车辆能够完成任务,目标点奖励函数的定义如下:

32、

33、其中,rt表示当前自动驾驶车辆到目标的距离;rt-1表示上一时刻自动驾驶车辆到目标的距离。当自动驾驶车辆靠近目标点时,环境将会返回正奖励值。

34、3)舒适度

35、考虑到自动驾驶车辆上乘客的舒适性,需要在满足安全性和目标完成度的同时保证车辆的驾驶舒适度,包括加减速以及行驶速度等。舒适度的奖励函数定义如下:

36、

37、其中,表示自动驾驶车辆加速度的导数。

38、4)时效性

39、在自动驾驶的过程中,需要满足安全性、舒适度的同时,保证车辆以更快的速度驾驶,从而更短的时间到达目的地。因此,为避免自动驾驶车辆圆度旋转或慢速运动,本发明不鼓励自动驾驶车辆以较小的线速度运动。时效性的奖励函数如下:

40、

41、其中,vt表示自动驾驶车辆的线速度。

42、考虑上述几个自动驾驶影响因素,最终本发明的奖励函数定义如下所示:

43、r=rs+rg+ru+rt

44、其中,所述步骤4中基于改进优先回放经验的方法包含:

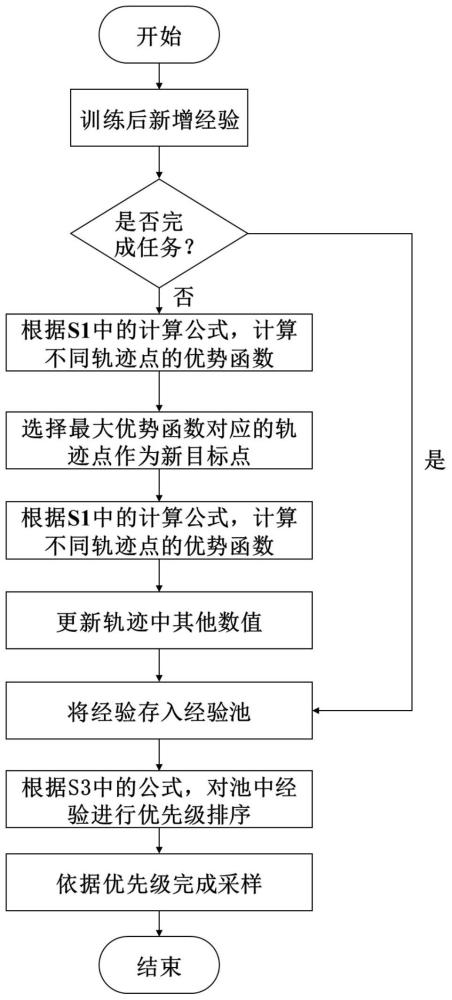

45、传统的dqn算法使用经验回放机制提高智能体对样本的利用率,并通过均匀采样的方式从经验池中获取数据。然而,这种方式并不能高效的利用经验数据。本发明打破均匀采样的方式,赋予学习价值高的经验更大的优先级,同时对失败样本中的目标点进行重新标记,增加经验池中成功样本的比重,从而达到提高样本利用率,加快算法收敛速度和提升算法泛化能力的目标。基于改进优先回放经验的方法,关键之处在于经验优先级的设置规则和失败样本中新目标点的确定方式。本发明先对失败样本进行处理,再对经验池中的数据进行优先级排序,具体步骤如下:

46、s1:在经验池中随机选取未完成目标任务的经验,根据下式计算不同轨迹点的优势函数并比较大小,将最大优势函数值对应的目标点作为此失败经验新的目标点,计算公式为:a(τ,vj)=r(τ|vj)-vπ(s0,vj)和其中,a(τ,vj)代表在轨迹τ中点vj作为目标点时轨迹的优势函数,r(τ|vj)代表点vj作为目标点时轨迹总的奖励值,vπ(s0,vj)代表策略π下的初始状态s0的价值函数,r(vi|vj)代表点vj作为目标点时点vi的奖励值。

47、s2:确定完新目标点后,对轨迹中新目标点之前的每一个轨迹点的状态、奖励值、和下一个状态进行修改,并将修改后的经验存入经验池中。

48、s3:使用两个衡量标准对经验池中的数据进行优先级排序,分别是pt=|rt+γ·max q(st,a′)-q(st-1,at-1)|和pr=r(s,a,s′)+∈,其中rt表示t时刻的奖励值,γ表示折扣因子,q(st,a′)表示状态st和动作a′对应的q值,q(st-1,at-1)表示上一时刻的q值,∈为e-5。两个衡量标准的权重将随着网络的更新进行调整,具体过程为:首先,分别计算出经验池中所有经验在不同衡量标准下的平均优先级,计算公式为其中δij表示在第j种衡量标准下第i种经验的优先级,n表示经验池中的经验数量;接着,根据sj=p(δij≥μj)计算出每个衡量标准的重要性,其中sj表示各衡量标准相对于平均优先级的优势概率的估计;其次,根据计算每个衡量标准的影响因子,其中fj表示衡量标准j的影响因子,根据计算出每个衡量标准的权重,其中wj表示衡量标准j的权重;最后,根据公式pi=∑j pij·wj计算出每条经验的优先级pi。

49、s4:从经验池中选取回放数据。选取概率与s3中设置的优先级相对应。优先值越高,经验被采样和重放的概率就越大,从而保证智能体能更有效地从信息量最大的经验中学习。采样概率为:其中,α是控制优先级的参数;pi表示经验i的优先级。

50、基于上述技术方案,本发明有以下有益技术效果:

51、1)利用基于通道注意力机制的dqn算法进行决策规划,能够更加关注城市交通环境中与车辆相关的状态、动作等信息,从而有效减少和避免自动驾驶过程中的碰撞。

52、2)通过设置针对城市交通场景的奖励函数,实现了自动驾驶下的安全性、舒适性、时效性和目标完成度,提高了车辆决策的智能化和自主性。

53、3)利用基于改进优先回放经验的方法,计算失败样本中每个轨迹点的优势函数,选择最大优势函数值对应的目标点作为此失败经验新的目标点,从而提高对失败样本的利用率,实现对全体训练样本利用率提高的目标,加快算法的学习和收敛速度。

54、4)利用两个衡量标准对经验池中的经验进行优先级排序,有效避免算法限于局部最优的情况,动态改变两个衡量标准的权重,实现了对不同训练阶段经验价值的准确评估。

本文地址:https://www.jishuxx.com/zhuanli/20240730/197437.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表