一种基于人类反馈的强化学习交通信号控制优化方法与流程

- 国知局

- 2024-07-31 21:08:00

本发明涉及一种交通信号控制方法,尤其是涉及一种基于人类反馈的强化学习交通信号控制优化方法。

背景技术:

1、随着经济的不断发展和城镇化步伐的加快,交通拥堵已经逐渐成为许多人口密集的城市面临的主要挑战之一。造成交通拥堵的原因有很多,包括道路通行能力不足、需求不受限制以及交通信号相位调度不当等。为了能缓解交通拥堵,人们已经做出了各种各样的努力,相较于扩建、改建道路、制定复杂的需求限制等方案而言,改进交通信号控制是一种更有机会找到有效策略和更节省成本的方式。

2、显然交通信号控制的改进是一个重要且具有挑战性的现实问题,其目的是在保证安全的前提下通过协调车辆在道路交叉口的运动来最大限度地减少车辆的行驶时间。控制信号交叉口的方法可分为两大类,即传统方法和自适应方法。许多城市都采用传统的信号控制系统,这种系统按照业务专家预期的交通假设计算出的固定时间的方式运行,虽然在一定程度上满足需要,然而知识以及规则都是事先制定的,不能基于内容和知识自动更新信号控制策略。但在自适应方法中,决策是根据交叉口的当前状态做出的,这种方法的使用给交通信号控制策略的制定带来了相当大的改进。

3、近年来人工智能技术的火爆使得许多研究团队尝试将新的技术应用在交通信号控制领域,因为它能够以最少的人为干预来控制系统,在减少城市拥堵方面的潜在好处是巨大的,其中强化学习由于其卓越的性能更是蓬勃发展,但大多数利用强化学习制定信控策略的方法往往使用已有数据在模拟器中做数据验证,并没有很好地利用业务专家的实际经验,损失了很大一部分颇有裨益的先验知识。同时,现有的很多方法都是对单一路口或者主干道进行信号控制策略优化,较少考虑整个区域中信号灯的协同控制。

技术实现思路

1、为了解决上述问题,本发明提出一种基于人类反馈的强化学习交通信号控制优化方法,其技术方案如下所述:

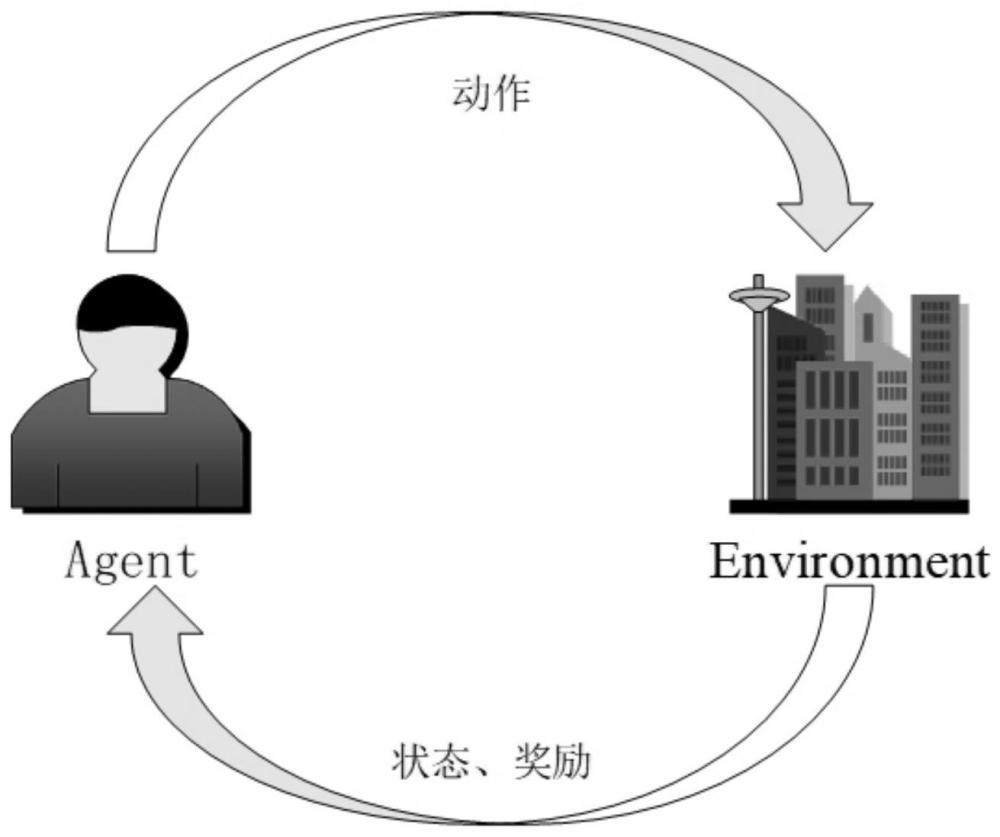

2、一种基于人类反馈的强化学习交通信号控制优化方法,采用的强化学习流程中,将路网模拟器作为环境,信号控制网络作为智能体,信号控制网络在与路网模拟器的多轮交互中不断优化自己的信号控制策略,包括以下步骤:

3、s1:通过交通感知设备收集路网信息和车流数据,利用所收集的数据对多交叉口路网模拟器进行建模,作为强化学习中的环境,根据当前信号控制策略、当前路网状态和下一时刻的信号控制策略输出下一时刻的路网状态;

4、s2:使用t0时刻的信号控制策略和每个路口的排队信息以及路网的拓扑结构初始化环境;

5、s3:将ti时刻组合了拓扑信息、排队信息和相互有车流影响的交叉口信息的整体路网信息以及ti时刻的动作策略作为状态、ti-1时刻采取的动作所获取的奖励输入信号控制网络,信号控制网络根据环境信息计算出ti+1时刻每个路口每个信号灯的动作概率分布,并依据业务需求修正该动作概率分布,然后使用ε-greedy原则选择信号控制策略;

6、s4:将ti时刻的动作策略、ti时刻的路网信息和ti+1时刻的信号控制策略输入到路网模拟器中,路网模拟器输出ti+1时刻的路网信息;

7、s5:重复步骤s3和步骤s4直到结束一个事件;

8、s6:重复步骤s2到步骤s5直到达到预定的事件。

9、进一步的,所述信号控制策略有三种:信号控制策略网络输出的信号策略;基于信号特殊配置策略修正的信号策略;业务专家输出的人类经验的信号策略。

10、本发明的应用场景为多个十字形的交叉口,不限制交叉口的数量,每个交叉口有东西南北四条道路,左侧车道允许车辆直行或左转,右侧车道允许车辆直行或右转。每个交叉口有一个信号灯控制车辆的通行,红色信号到绿色信号相位之间的切换由全红的2秒连接。

11、进一步的,步骤s3中,构建信号控制网络时,定义有强化学习的状态,所述状态定义为当前时刻的路况,包含当前时刻的信号策略和路网信息,表示为

12、

13、其中,表示tj时刻整个路网的状态,表示tj时刻整个路网的信号控制策略,表示为

14、

15、表示tj时刻路口i的信号控制策略,是m维向量,每个元素表示是否是绿灯,绿灯为1;

16、表示tj时刻整个路网的路况,计算方式为

17、

18、表示tj时刻路口i的编码,表示为

19、

20、其中,num_cross是对路口i的路况有影响的路口个数,

21、表示tj时刻路口i的原始编码,融合了位置信息和排队情况,根据如下公式进行计算:

22、

23、其中,是m维向量,中每个元素表示tj时刻路口i信号灯的每个方向上的排队长度;pi与维度相同,表示路口i的位置向量,由以下公式计算获得:

24、

25、

26、其中,pos表示路口的编号,k用于区分位置向量中的奇偶维度,dmodel=m。

27、步骤s3中,构建信号控制网络时,定义有强化学习的动作,所述动作空间定义为

28、action={(1,5),(2,6),(3,7),(4,8)}

29、在动作示意图中,设置有三横三竖交叉的九个点,上面三个点依次为7、8和9,中间三个点依次为6、1和2,下面三个点依次为5、4和3,动作空间中的“1”表示西东方向直行,“2”表示由西向北左转,“5”表示东西方向直行,“6”表示由东向南左转,“3”表示北南方向直行,“7”表示南北方向直行,“4”表示由北向东左转,“8”表示由南向西左转。

30、经过信号控制网络输出的信号策略需要根据实际业务场景进行修正,获取到修正的动作概率分布之后,采用ε-greedy策略选择动作:

31、

32、式中,π(a,s)为动作a在状态s下被选取的概率;该策略以概率1-ε来选择动作空间中概率最大的动作为输出指令,以概率ε随机选择动作空间中的其他某动作作为控制器的输出指令。

33、步骤s3中,构建信号控制网络时,定义有强化学习的奖励,奖励考虑三个部分:

34、1)排队车辆数变化量:排队车辆数的变化情况可以直观地看到路口信号控制的效果;

35、2)绿灯空放时间:假设相邻n次检测排队长度均为0,则n次检测之间的时间间隔即为绿灯空放时间;

36、3)排队车辆变化量标准差。

37、采用基于人类反馈的强化学习方法微调信号控制策略网络,具体地,通过定义hf-td error在模型训练中体现人类反馈,因此,hf-td error定义为q(s,a)←q(s,a)+α[rh+r+γmaxa′q(s′,a′)-q(s,a)]

38、其中,q(s,a)表示从状态s出发,执行动作a后再使用策略带来的累计奖赏,α表示学习率,rh表示人类反馈,r表示在状态s下采用动作a获得的奖励,γ表示折扣因子,maxa′q(s′,a′)表示从状态s采取某种行动后再使用策略能带来的最大累计奖赏。

39、本发明利用城市道路交通流量信息,为缓解交通拥堵、减少环境污染提供智能引导,在基础设施和预算有限的城市中,能够在有交通信号的十字路口进行充分的交通控制。本发明所采用的基于人类反馈的强化学习控制优化方法会根据区域中所有交叉路口的流量情况进行协调配时,能够解决信号灯控制的自适应问题;同时基于人类反馈的强化学习能够将业务专家的经验很好地结合到算法模型中,可以使信控策略更符合人类的偏好,更贴合实际应用的场景。本发明提供的基于人类反馈的强化学习交通信号控制优化方法,能够缩短整个路网中的车辆等待时间,提高路网整体的通行效率。

40、本发明具有以下特点:

41、(1)本发明能够根据实际路网情况自适应地调整信号灯配时方案,降低现有固定配时进行修改时所带来的反复验证调整的时间成本和人力成本。

42、(2)本发明在对路网状态进行编码时,考虑到了多交叉口之间的协同控制,提供了不同交叉口之间交流和影响的途径,因此在进行局部决策时能够综合考虑到路网的整体影响,从而不仅仅对单个路口的信号控制策略进行优化,而是能提高整个交通网络的运行效率,缓解交通拥堵。

43、(3)本发明提出了可用道路资源的定义,同时在制定奖励时能综合考虑道路长度和时间的因素,将更多的信息提供给模型,提高了强化学习算法的效果。

44、(4)与传统交通信号控制方法相比,强化学习在避免对交通做出硬性假设的同时,不需要交叉路口网络中交通流行为的精确模型,而是通过尝试不同的策略直接从反馈中学习。本方案正是利用了这种反馈的机制,将原本被忽视的业务专家的经验知识添加到信控策略的决策反馈中,充分地利用了业务资源来优化现有的信控方案。

本文地址:https://www.jishuxx.com/zhuanli/20240731/188512.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表