一种感知辅助的智能无人机隐蔽通信与路径规划方法

- 国知局

- 2024-08-02 12:40:08

本发明属于无线通信信息安全技术和路径规划领域,涉及到一种基于深度强化学习算法的无人机隐蔽数据收集的方法。

背景技术:

1、无人机辅助通信网络已经被越来越广泛地应用于军事与民事领域,例如,战场侦测,抢险救灾等。与传统的地面通信不同,无人机具有高机动性、可灵活部署、以及可与地面通信用户建立高概率视距信道的特点,因此常常被应用于空地协作的无线通信中,例如无人机辅助数据收集或热点地区流量卸载等。通过合理设计无人机的飞行轨迹,可以在各种支持无人机的无线网络中有效利用地空之间的视距通信链路来提高无线通信传输效率。然而,当空中额外存在一个非法的窃听者无人机时,地空之间的视距通信链路同样为窃听者提供良好的窃听信道,合法无人机的数据收集将面临严峻的通信安全问题,地面节点的上行数据被暴露的风险大大增加。此外,由于合法无人机体积受限,携带能量受限问题也限制了其作业范围及时间,无人机能耗问题也同样不容忽视。

2、传统的无线通信安全技术是通过信息加密或物理层安全来实现的,但这些技术并不能保障通信信号不被窃听者所监听到,因此仍然存在信息泄露的风险。此外,在一些特殊场景下,非法窃听者通过监测其感兴趣的信号是否存在或信号的传输规律,从而进一步分析出合法发射端的坐标信息或相关行为规律。因此,上述安全通信技术无法满足当前高安全信息传输的需求。隐蔽通信为安全通信提供了新的思路,与传统技术不同,隐蔽通信技术可以保障通信行为的安全性,即保障合法用户间的通信信号难以被非法窃听者检测。对于隐蔽通信技术,众多国内外学者已经进行了相关基础理论研究,并运用公式推导验证了不同条件下的隐蔽通信容量上限。在隐蔽通信场景中,恶意窃听者通常采用信号能量检测的方法来分析合法双方是否存在通信行为,而合法发射机可以利用信道衰落、人工噪声、合理优化无人机的飞行轨迹等方式在窃听者处引入不确定性来对其进行信息隐藏,提升合法用户双方的隐蔽通信效率。此外,由于窃听者与合法通信收发双方是非合作的,它们的工作周期一般也是非同步的,因此窃听者的检测周期应被视为若干个合法系统的决策周期,然而目前的研究普遍假设窃听者与合法系统是同步工作的。

3、近年来,随着人工智能相关技术的迅猛发展,强化学习方法已经广泛应用于各种路经规划与决策优化的问题。强化学习是一种以马尔可夫决策过程为基础,通过智能体在环境中不断交互试错,并通过积累的经验训练,最终得到动态环境下长期回报最大的智能算法。深度强化学习是在强化学习的基础上引入了深度神经网络,进行相关经验信息存储与值函数拟合,解决了当强化学习中的状态空间过大,算法难以收敛的问题,进而可以应对更复杂的决策问题。然而智能体在训练时不断与环境交互试错,在这个过程中信息传输仍有极大可能被暴露给窃听者,因此强化学习算法的运用与隐蔽通信的要求产生了一定的矛盾。目前现有的与深度强化学习结合的隐蔽通信的研究中未涉及在网络模型训练中的通信隐蔽性的问题。

技术实现思路

1、本发明的目的是提供一种感知辅助的智能无人机隐蔽通信与路径规划方法,构建无人机推进能耗模型和无线信道模型,结合隐蔽通信理论构建多检测时隙下的累计隐蔽性约束;基于地面节点和合法无人机的感知辅助信息和无人机网络对地面节点的调度约束,构建智能无人机隐蔽通信与路径规划的优化问题,并建模为一个马尔科夫决策过程;根据所建立马尔科夫决策过程构建深度强化学习框架,合法无人机在累计隐蔽性约束的辅助下在环境中交互训练,在保证传输数据安全的前提下,实现无人机单次飞行所收集的数据量最大化;基于深度强化学习框架利用q估计网络辅助无人机进行自适应决策,无人机每一决策周期的速度和方向都能够被唯一确定,进而实现无人机隐蔽通信与最优轨迹规划。

2、本发明的目的是通过下述技术方案实现的。

3、本发明公开的一种感知辅助的智能无人机隐蔽通信与路径规划方法,包括如下步骤:

4、步骤一、针对无人机携带能量有限的特点,构建无人机推进能耗模型表征无人机飞行轨迹对无人机单次飞行时间的影响;针对地对空无线信道特点,构建无人机合法通信链路模型,给出每个收集周期内合法无人机数据收集量和数据上行传输速率,并构建窃听者无人机的窃听信道模型;利用kl散度表征窃听者无人机多检测时隙下的检测错误概率,结合条件风险价值和拉盖尔级数推导累计隐蔽性约束。

5、步骤1.1:构建无人机推进能耗模型。提取旋翼无人机机身尺寸参数和无人机叶片转子参数,构建无人机悬停状态下的叶型功率p0如下:

6、

7、式中φ为机身剖面阻力系数,ρ表示空气密度,b表示旋翼稠密度,a为旋翼盘面积,ω为叶片角速度,χ为转子半径。构建无人机悬停状态下的诱导功率p1如下:

8、

9、其中κ为诱导功率校正因子,g为飞机整机重量。结合无人机飞行速度v,构建无人机飞行消耗功率如下:

10、

11、其中,utip为旋翼桨尖速度,v0表示悬停状态下旋翼平均诱导速度,d0表示机身阻力比。

12、步骤1.2:构建地面节点与无人机的无线信道模型,并确定无人机的收集数据量。无人机与地面节点之间的信道状态受无人机和地面节点连线与地面夹角影响。当仰角较大时,发射机与接收机之间不存在遮挡,地空信道是视距信道;当仰角较小时,发射机与接收机之间存在地形或障碍物的遮挡,地空信道是非视距信道。地面节点与无人机的无线信道为视距信道与非视距信道概率由如下式所示

13、

14、其中,和ψ为环境参数,θdu为地面节点到目标无人机的仰角。地空无线信道由大尺度衰落adu和小尺度衰落hdu共同组成。大尺度衰落部分用于描述当地面节点和无人机之间的距离相距几百米时,信号衰落受到传播距离的影响。大尺度衰落adu表示如下:

15、

16、其中λ0是与天线有关的常数,ddu是地面节点与无人机之间的距离,ξlos和ξnlos分别是视距信道与非视距信道下的路径损耗因子。小尺度衰落用于描述由于多径效应以及无人机的移动所产生的信号衰落。小尺度衰落hdu遵循nakagami衰落,其概率密度函数表示为:

17、

18、其中mdu为衰落参数,通过调整mdu的值,nakagami衰落可以拟合不同的信道衰落。

19、由于无人机需要不停移动地收集来自地面节点的信息,无人机自身存在抖动以及环境变化,地对空信道状态变化剧烈。为应对信道的频率选择性衰落,在一个决策周期t内划分n个时隙。在一个决策周期内无人机所收集的数据量wc[t]为:

20、

21、其中,δc为单个时隙的长度,zi,t为无人机是否在决策周期t内选择地面节点i收集数据,ri,n[t]为地面节点i在时隙n内数据上行传输速率,表示为:

22、

23、其中,b为数据传输的带宽,adu,n和hdu,n分别为时隙n内的大尺度衰落和小尺度衰落系数,pi[t]为决策周期内地面节点i的发射功率,为无人机处的噪声功率。

24、步骤1.3:利用地面节点和窃听者无人机的位置信息,构建窃听者无人机的窃听信道模型。窃听者无人机与地面节点之间的窃听信道状态受窃听者无人机和地面节点连线与地面夹角θde影响,地面节点与窃听者无人机的无线信道为视距信道与非视距信道概率由如下式所示

25、

26、地面节点与窃听者无人机之间的地空无线窃听信道被建模为由大尺度衰落ade和小尺度衰落hde共同组成。地面节点与窃听者无人机之间的大尺度衰落ade表示如下:

27、

28、其中dde是地面节点与窃听者无人机之间的距离。小尺度衰落hde遵循nakagami衰落,其概率密度函数可以表示为:

29、

30、其中mde为地面节点与窃听者无人机之间的小尺度衰落参数。

31、步骤1.4:利用感知获取窃听者无人机的位置信息,结合步骤1中的所建立的无人机推进能耗模型和地空无线信道模型,在合法无人机系统处表征窃听者无人机的检测错误概率下界,利用窃听者无人机处的二元假设检验和kl散度推导累计隐蔽性约束。

32、构建窃听者无人机的二元假设检验。在第n个时隙,窃听者无人机收集到第l(1≤l≤l)个信号样本ye,l,n[t]表示如下

33、

34、其中为零假设代表地面节点未向无人机传输信号,为替代假设代表地面节点向合法无人机传输信号。ne,l为窃听者无人机处功率为的加性高斯白噪声。

35、窃听者无人机基于功率检测器的辐射计测量的接收信号功率并设定最佳检测门限来判断地面节点是否向合法无人机发送信号。窃听者无人机的检测错误概率pe表示为:

36、pe=α+β≥1-ε (13)

37、其中α和β分别是虚警概率和漏检概率,ε>0为衡量所需隐蔽性的参数。窃听者无人机在第n个时隙内的检测错误概率的下限表示为:

38、

39、其中是当地面节点发送送信号时窃听者无人机处的观测值的概率分布,是当地面节点未发送信号时窃听者无人机处观测值的概率分布。为上述两个分布的kl散度。根据式(12)(13)(14),窃听者无人机第n个时隙内的隐蔽性约束表示为下式:

40、

41、由于窃听者无人机与合法通信收发双方是非合作的,窃听者无人机的检测周期被设定为与合法无人机辅助通信系统非同步的,因此窃听者无人机的检测周期建模为连续的两个决策周期。由于单个时隙内能传输的符号个数l≈δcb,结合kl散度的定义,第和个决策周期内的累计隐蔽性约束表示为下式:

42、

43、步骤二、建立无人机对地面节点的调度规则。根据步骤一建立的无人机推进能耗模型、地空无线信道模型以及累计隐蔽性约束,构建无人机路径规划,地面节点功率控制和调度策略的联合优化问题。

44、为保证节点之间的上行数据互不干扰,建立无人机与地面节点的调度规则,规定无人机在一个决策周期内只能调度一个地面节点来传输上行数据。建立地面节点调度约束如下:

45、

46、其中i为地面节点的总数。由于无人机携带能量有限,无人机每个决策周期开始时的剩余能量表示为:

47、

48、当无人机的剩余能量降低到预设的能量阈值eth时,返回充电站补充能量。通过优化无人机的速度和方向来制定无人机的运动轨迹,无人机当前决策周期的位置与上一决策周期之间的位置的距离应保证是无人机以最大速度在单个决策时隙可达的。因此在单个决策时隙内,无人机的轨迹约束表示为:

49、||du,t+1-du,t||≤vmaxnδc (19)

50、其中du,t为无人机在决策周期t的坐标位置,vmax为无人机具有的最大速度。无人机路径规划,地面节点功率控制和调度策略的联合优化问题表达如下:

51、

52、步骤三、将步骤二中建立的联合优化问题建模为具有状态集合、动作集合、奖励和环境的强化学习框架。基于累计隐蔽约束,利用条件风险价值和拉盖尔级数展开式,表征每个决策周期内的隐蔽性容量状态。在强化学习中,智能体通过与环境交互,根据当前t时刻环境的状态st,输出动作at,并通过环境得到反馈奖励rt和下一时刻状态st+1。强化学习中引入状态-动作价值,即q值,来评估当前状态下动作的好坏。由于每个动作都会对后续动作选择产生影响,因此q值基于累计折扣奖励构建的。在具体实施决策时,智能体是根据q函数选择当前状态,即选择q值最大的动作,实现累计奖励最大化。

53、步骤3.1:构建状态集合状态包括:决策周期t时刻开始时合法无人机位置坐标du,t,窃听者无人机位置坐标de,t,合法无人机剩余能量et,第t-1时隙内累计的隐蔽容量以及第t-2时隙内累计的隐蔽容量记为:

54、

55、结合条件风险价值以及拉盖尔级数展开近似等数学方法,重新刻画了单个决策周期内的累计隐蔽容量。由于窃听者无人机与合法无人机辅助通信系统并不合作,所以窃听信道的具体参数并不能通过传统信道估计方式得到,而相应的统计信息可以通过长期观测总结。根据不等式ln(1+x)≥x-x2/2,同时引入条件风险价值来重新刻画两个决策周期内的累计隐蔽性约束为:

56、

57、定义如下:

58、

59、根据条件风险价值定义,表示为:

60、

61、其中μ为置信度,ξ由风险价值定义如下:

62、

63、由于窃听信道的小尺度衰落hde服从参数为mde的nakagami分布,|hde|2服从伽马分布。根据拉盖尔级数展开式,的概率密度函数近似表示为:

64、

65、其中:

66、

67、

68、

69、根据上式,累计隐蔽性约束重构为:

70、

71、因此,定义决策周期t内累计的隐蔽性容量如下:

72、

73、其中γ(·,·)为上不完全伽马函数。

74、步骤3.2:构建动作集合动作集合包括:选择进行数据收集的地面节点zt,地面节点的功率pt,无人机运动方向与飞行速度vt,因此动作at可记为:

75、

76、在每个决策周期t内,无人机需要从地面节点集合中选择地面节点进行数据收集,其中且满足被选择的地面节点需要选择相应的发射功率进行数据传输,其中有从0到pmax共十档可选择的发射功率。同时,无人机需要选择自身下一步的飞行速度与飞行方向,其中速度被划分为从小到大三个不同等级,飞行方向有前、后、左、右、左前、左后、右前、右后八个飞行方向。基于每个决策周期的所选择的无人机飞行速度与方向,构建无人机的飞行轨迹。

77、由于构建的累计隐蔽不依赖于窃听者信道参数的具体值,因此在每个决策周期开始时,智能体根据当前环境状态中前一决策周期的累计隐蔽容量构建出当前决策周期所能达到的最大累计隐蔽容量,从而在选择当前决策周期执行的动作时,事先屏蔽部分不满足累计隐蔽性约束的动作,进而保证在连续两个决策周期内无人机进行数据收集时不被窃听者无人机监听到,因此每个状态的可选动作空间大小是变化的。

78、步骤3.3:为使无人机隐蔽收集的数据量最大化,构建即时奖励,因此使用在一个决策周期收集的数据量作为即时奖励,记为rt=wc[t]。

79、步骤四、针对步骤三所构建的强化学习框架,制定基于价值的深度强化学习算法来解决联合优化问题。在环境中不断训练深度神经网络直到收敛后,将每一时刻无人机的状态输入训练后的神经网络,根据网络输出的动作状态价值,获取无人机的最优动态路径规划和地面节点的调度策略。深度强化学习算法利用深度神经网络拟合q函数,当神经网络训练收敛后,通过将当前环境状态输入神经网络,神经网络输出不同可选动作的q值,智能体将选择具有最大q值的动作执行决策。重复利用q估计网络辅助选取每个状态下最大价值的动作,无人机每一决策周期的速度和方向被唯一确定,进而实现无人机隐蔽通信与最优轨迹规划。

80、步骤4.1:无人机首先建立两个神经网络,即参数为θ的q估计网络和参数为的目标q网络,其中q估计网络是为了对动作价值进行评估,而目标网络是为了进行动作选择和辅助训练。

81、步骤4.2:根据环境反馈的当前状态st基于∈-greedy策略选择动作at,得到下一时刻的状态st+1和奖励rt,并将{st,at,st+1,rt}存储到经验池用于后续训练,其中∈-greedy策略是以∈概率从所有可选动作中随机选择一个,用于学习探索,以1-∈概率根据q估计网络输出选择对应q值最大的动作。与传统深度强化学习不同的是,当q值最大的动作不满足累计隐蔽性约束时,该动作将被映射到仅功率为0,但无人机飞行速度和方向不变的动作,映射后的动作被称为候选动作。此外,在将经验存储到经验池时,该动作的奖励由执行候选动作得到的奖励替代。

82、步骤4.3:当经验池中数据溢出时,旧的经验将被新的经验替代。当经验池中的数据达到一定数量时,无人机将从经验池中随机抽取小批量经验数据用于神经网络训练更新。具体来说,首先将每一条经验{st,at,st+1,rt}中的状态st输入q估计网络,得到对应动作at的估计q值qθ(st,at),接着将状态st+1将输入到q估计网络中并根据q估计网络的输出选择q值最大的动作即再将状态st+1输入到q目标网络中得到动作的q值,称为目标q值其中和rt共同组成目标值其中γ∈[0,1]为折扣因子。损失函数l(θ)表示如下:

83、

84、q估计网络依据损失函数的导数进行梯度下降更新网络参数θ,即θ←θ-ηdl(θ)/dθ,其中η为学习率。在训练一定次数时,q目标网络通过复制q估计网络的参数θ的方式来更新自身网络参数

85、在训练的起始阶段,无人机将会在未知环境中进行随机动作选择,即采用随机策略选取无人机的速度、方向、调度的地面节点、调度节点的功率,并根据执行动作后的状态和计算得到的奖励构建经验条目{st,at,st+1,rt}。随着不断与环境进行交互训练,当q估计网络会逐渐收敛。通过将当前环境状态输入训练后的q估计网络得到每个动作的价值,无人机选取具有最大价值的动作执行,确定每个决策周期内无人机的运动速度和方向,节点调度情况和发射功率,并根据环境反馈得到后续状态。重复利用q估计网络辅助选取每个状态下最大价值的动作,无人机每一决策周期的速度和方向都能够被唯一确定,实现无人机隐蔽通信与最优轨迹规划。

86、有益效果:

87、1、与传统的窃听者位置已知且固定的隐蔽通信场景不同,本发明公开的一种感知辅助的智能无人机隐蔽通信与路径规划方法,通过利用深度强化学习算法,使合法无人机通过不断与环境交互逐渐具有预测窃听者行为的能力。通过在动态环境中不断优化q估计网络对每个状态下各个动作的价值估计,保障无人机的最优路径规划和有限无人机能量下隐蔽收集的数据量最大化。

88、2、本发明公开的一种感知辅助的智能无人机隐蔽通信与路径规划方法,针对窃听者无人机利用多个检测时隙来检测是否存在通信信号的问题以及窃听信道具体参数难以获取的特点,构建累计隐蔽容量表征方法,通过利用条件风险价值和信道统计特性构建累计隐蔽性约束,在合法无人机处度量了隐蔽性对功率选择、节点调度和路径规划的影响,进而保障无人机数据收集时的隐蔽性。

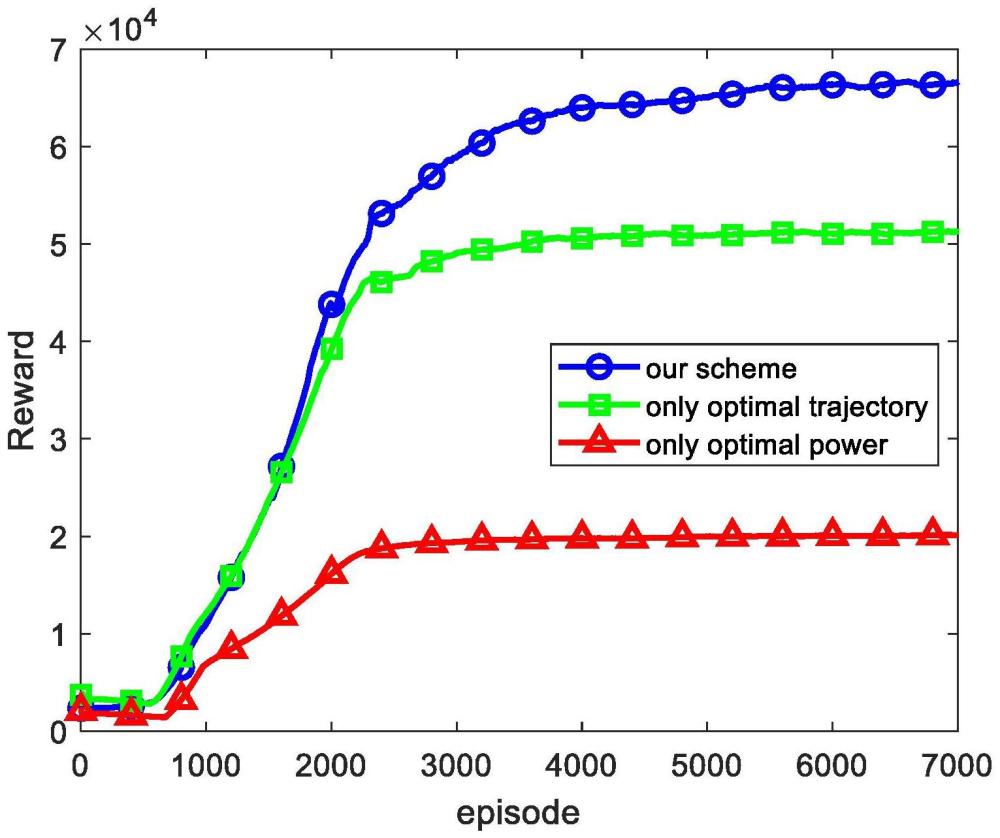

89、3、本发明公开的一种感知辅助的智能无人机隐蔽通信与路径规划方法,针对深度强化学习训练过程中无法保证合法通信行为需要对窃听者严格隐蔽的问题,利用累计隐蔽性约束和基于映射的方案屏蔽违反隐蔽性的动作,在避免隐蔽通信行为的暴露的同时,相比于不屏蔽动作的深度强化学习加速网络训练,进而提高智能无人机隐蔽通信与路径规划效率。

本文地址:https://www.jishuxx.com/zhuanli/20240802/237225.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。