一种基于多特征分层融合学习的跨模态行人重识别方法

- 国知局

- 2025-01-10 13:29:53

本发明属于图像处理,具体涉及一种基于多特征分层融合学习的跨模态行人重识别方法。

背景技术:

1、给定一个自然光或红外相机拍摄的查询图像,visible-infrared person re-identification(vi-reid)的目的是在红外或自然光库中检索相同身份的行人。随着监控摄像头的普及以及相关数据集的提出,vi-reid任务收到了大量研究人员的关注。

2、作为一个图像检索任务,vi-reid面临两个挑战:度量函数存在的数据偏见和度量与表征学习的不适配问题。

3、为了拉近类内间距以及模态差异,当前的方法可分成基于像素与基于特征两类。基于像素[aligngan,jsia]方法旨在通过生成模型生成对应模态着色风格的假图,假图用来辅助图像检索。但是由于模态差异大,风格迁移需要复杂的网络结构,这种方式并没有取得好的表现。

4、目前主流的方式是通过设计度量函数,通过限制模态间的特征距离来训练模型学习模态共存特征。mmn、agw和fbp-al基于经典的三元组策略,限制同类模态间与类间的相对距离来缓解模态差异。但这些方法每次仅优化一对样本,缺乏鲁棒性且容易陷入子优结果。hct和mpnaet提出约束样本点到模态中心的距离,一定程度缓解上述问题。但是模态中心是基于当前批量的特征均值,仍无法避免小批量带来的数据偏见。除此之外,度量函数从特征距离角度出发评估特征,而表征学习从身份表达角度评估特征,这一区别会影响模型训练。

技术实现思路

1、本发明的目的在于提供一种基于多特征分层融合学习的跨模态行人重识别方法,从时序角度进行特征的分层融合,帮助模型学习到更丰富的特征,有效缓解了模态差异。

2、为实现上述目的,本发明所采取的技术方案为:

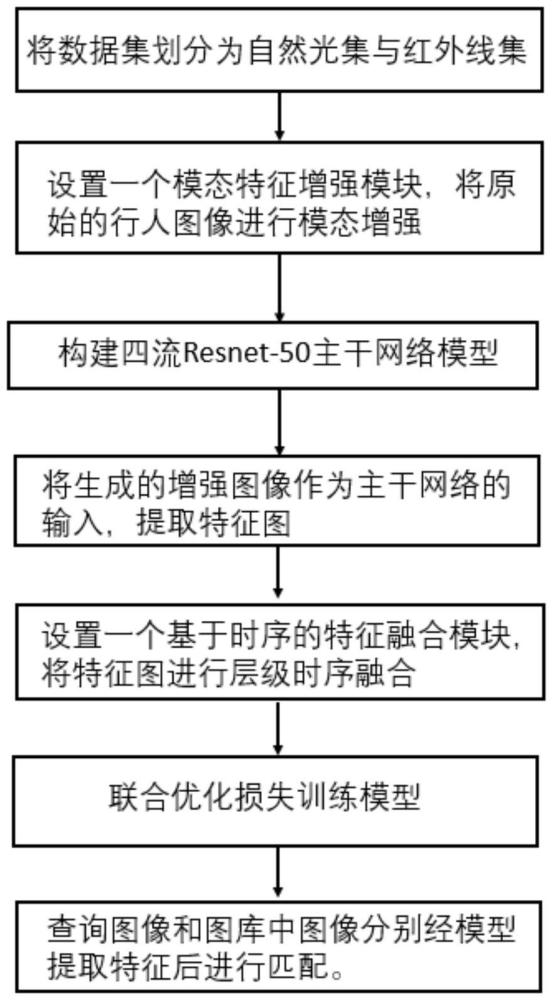

3、一种基于多特征分层融合学习的跨模态行人重识别方法,所述基于多特征分层融合学习的跨模态行人重识别方法,包括:

4、步骤s1、给定一张可见光模态图像/红外线模态图像作为查询图像,以及给定包含红外线模态图像/可见光模态图像的图像库;

5、步骤s2、加载多特征分层融合学习网络,所述多特征分层融合学习网络包括模态特征增强模块、四流resnet-50主干网络模型和基于时序的特征融合模块;

6、步骤s3、通过所述模态特征增强模块对可见光模态图像和红外线模态图像分别进行两种模态增强,得到可见光第一增强模态图像、可见光第二增强模态图像、红外线第一增强模态图像和红外线第二增强模态图像;

7、步骤s4、将可见光第一增强模态图像、可见光第二增强模态图像、红外线第一增强模态图像和红外线第二增强模态图像输入四流resnet-50主干网络模型,输出不同尺寸的特征图c2、c3、c4和c5;

8、步骤s5、将不同尺寸的特征图c2、c3、c4和c5输入基于时序的特征融合模块进行层级时序融合,所述基于时序的特征融合模块操作如下:

9、将特征图c3和c4分别经过1×1卷积和上采样统一成与特征图c2相同的尺寸,分别记为特征f3和f4,同时将特征图c2记为特征f2,将特征图c5经过1×1卷积和上采样统一成与特征图c2相同的尺寸,记为特征fori;

10、首先将特征ft传入lstm2网络进行处理,t∈[2,t]为层级,且最高层级t=4,然后将输出的结果与原始特征进行融合,得到融合后的特征用如下公式表示:

11、

12、然后对得到的特征进行注意力处理,得到特征用如下公式表示:

13、

14、最后将得到的特征与特征fori进一步融合,用如下公式表示:

15、

16、其中,set表示针对第t层级特征的注意力处理操作,表示第t层级的融合特征,fout表示基于时序的特征融合模块最终输出的融合特征,且表示可见光第一增强模态融合特征,表示可见光第二增强模态融合特征,表示红外线第一增强模态融合特征,表示红外线第二增强模态融合特征;

17、步骤s6、基于可见光对应的融合特征以及红外线对应的融合特征计算查询图像和图像库中图像的匹配度,提取图像库中匹配度最高的前top-k张图像作为重识别结果。

18、以下还提供了若干可选方式,但并不作为对上述总体方案的额外限定,仅仅是进一步的增补或优选,在没有技术或逻辑矛盾的前提下,各可选方式可单独针对上述总体方案进行组合,还可以是多个可选方式之间进行组合。

19、作为优选,所述对可见光模态图像和红外线模态图像分别进行两种模态增强,得到可见光第一增强模态图像、可见光第二增强模态图像、红外线第一增强模态图像和红外线第二增强模态图像,包括:

20、对于可见光模态图像xvis的第一种增强方式:先对原始的可见光模态图像xvis的三个通道xr,xg,xb进行随机加权得到退化图xds,再与原始的可见光模态图像xvis进行加权融合得到可见光第一增强模态图像用如下公式表示:

21、xds=α1×xr+α2×xg+α3×xb

22、

23、其中,xr,xg,xb分别为可见光模态图像xvis的r通道、g通道和b通道,α1、α2、α3为随机加权权重,属于[0,1],且α1+α2+α3=1,β1、β2为加权融合权重,属于[0,1],且β1+β2=1;

24、对于可见光模态图像xvis的第二种增强方式:在可见光模态图像xvis的三个通道中随机选择一个通道,并在随机选定的通道中,以预设系数加入其他两个通道的信息,用如下公式表示:

25、

26、其中,为可见光第二增强模态图像,randselect为随机选择操作,为在可见光模态图像xvis的三个通道中随机选择所选中的一个通道,为可见光模态图像xvis的三个通道中除所选中通道外的其他两个通道,(xr,xg,xb)为可见光模态图像xvis的三个通道,γ1、γ2、γ3为预设系数,属于[0,1],且γ1+γ2+γ3=1,0<γ2+γ3≤0.15;

27、对于红外线模态图像xir的第一种增强方式:对红外线模态图像的通道xir的像素值进行乘法倍增,用如下公式表示:

28、

29、其中,为红外线第一增强模态图像,δ为倍增系数,属于[0.01,0.5];

30、对于红外线模态图像xir的第二种增强方式:将图片进行随机翻转和/或随机擦除,用如下公式表示:

31、

32、其中,为红外线第二增强模态图像,randerase表示随机擦除函数,randflip表示随机翻转函数。

33、作为优选,所述四流resnet-50主干网络模型,包含四个分别处理可见光第一增强模态图像、可见光第二增强模态图像、红外线第一增强模态图像和红外线第二增强模态图像的分支,每个分支包含一个独立参数的子网络记为evis1、evis2、eir1和eir2,均由resnet-50网络的第一层实现;

34、所述四流resnet-50主干网络模型,还包含一个共享参数的子网络es,由resnet-50网络除第一层以外的剩余层实现。

35、作为优选,所述将可见光第一增强模态图像、可见光第二增强模态图像、红外线第一增强模态图像和红外线第二增强模态图像输入四流resnet-50主干网络模型,输出不同尺寸的特征图c2、c3、c4和c5,包括:

36、将可见光第一增强模态图像输入子网络evis1;

37、将可见光第二增强模态图像输入子网络evis2;

38、将红外线第一增强模态图像输入子网络eir1;

39、将红外线第二增强模态图像输入子网络eir2;

40、取子网络evis1、evis2、eir1和eir2的输出进行拼接,得到特征图c1;

41、将特征图c1输入子网络es,得到子网络es每层输出的特征图c2、c3、c4和c5。

42、作为优选,所述多特征分层融合学习网络的训练过程如下:

43、获取训练数据集划分为自然光集和红外线集,所自然光集中包含可见光模态图像,所述红外线集包含红外线模态图像;

44、将自然光集和红外线集输入所述多特征分层融合学习网络,根据所述多特征分层融合学习网络的输出计算联合优化损失进行训练更新。

45、作为优选,所述计算联合优化损失,包括:

46、

47、其中,为联合优化损失,表示异中心簇损失,表示id损失,表示模态间的三元组损失,表示四元中心簇损失;

48、所述id损失对可见光第一增强模态图像和红外线第一增强模态图像经过四流resnet-50主干网络模型得到的特征进行损失的计算,计算公式如下:

49、

50、其中,p是训练数据集中的类别个数,a表示第a个类别,qa表示第a个类别实际的标签分布概率,pa表示第a个类别预测的分布概率,ε为常数,y表示行人的类别标签;

51、所述异中心簇损失计算公式如下:

52、

53、其中,q是训练阶段批次中和每类图像的数量,f()是四流resnet-50主干网络模型的全连接层之前的输出,mean[a-b]是对象a和对象b之差的均值运算,表示训练阶段批次中第i张可见光第一增强模态图像,表示训练阶段批次中第i张红外线第一增强模态图像;

54、所述模态间的三元组损失计算公式表示为:

55、

56、其中,表示vis1和ir1模态间的三元组损失,表示输入来自vis1和ir1模态的正样本对和来自vis1模态的负样本对计算得到的三元组损失,表示输入来自vis1和ir1模态的正样本对和来自ir1模态的负样本对计算得到的三元组损失,vis1模态表示可见光第一增强模态图像对应的可见光第一增强模态,ir1模态表示红外线第一增强模态图像对应的红外线第一增强模态,与可用公式表示为:

57、

58、其中,m表示每次迭代随机选择的行人数量,b表示第b个行人,c表示第c个行人,ξ是间隔参数,表示vis1图像中第b个行人和ir1图像中第c个行人之间的欧式距离,表示vis1图像中第b个行人和ir1图像中第k个行人之间的欧式距离,表示ir1图像中第b个行人和vis1图像中第c个行人之间的欧式距离,表示ir1图像中第b个行人和vis1图像中第k个行人之间的欧式距离,并且b与c相同,表示同一个行人;k与b、c不相同,表示不同的行人,yb表示当前模态的第b个行人的类别标签,yc表示与yb不同模态的同一行人的类别标签,yk表示与yb和yc不同行人的类别标签,[z]+=max(z,0),z为函数输入;

59、所述四元中心簇损失计算公式表示为:

60、

61、其中,表示vis1和ir1模态间的中心簇损失,表示vis1和ir2模态间的中心簇损失,表示vis2和ir1模态间的中心簇损失,表示vis2和ir2模态间的中心簇损失,vis2模态表示可见光第二增强模态图像对应的可见光第二增强模态,ir2模态表示红外线第二增强模态图像对应的红外线第二增强模态;

62、将v1或v2记为v,将i1或i2记为i,则中心簇损失用如下公式表示:

63、

64、其中,d表示第d个类别,g表示第g个类别,ρ为预设参数,表示包含第d个类别的行人对应的vis融合特征的平均中心位置,表示包含第d个类别的行人对应的ir融合特征的平均中心位置,vis为vis1或vis2,ir为ir1或ir2,表示包含第g个类别的行人对应的vis或ir融合特征的平均中心位置,∥a-b∥2表示计算对象a和对象b之间的欧氏距离。

65、本发明提供的一种基于多特征分层融合学习的跨模态行人重识别方法,与现有技术相比,具有以下有益效果:

66、(1)本发明方法为了提取多样化的特征,从图像增强角度出发,通过对每种增强的图像提取特征来丰富模型可以学习到的网络。

67、(2)本发明方法首次从时序融合的角度考虑跨模态行人重识别问题。具体来说,面对得到的多样特征,本方法设计了一种基于时序的方法来分层融合所学习到的特征,有效缓解了模态差异,提高重识别准确度。

本文地址:https://www.jishuxx.com/zhuanli/20250110/353486.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表