一种基于多源特征的语音情绪识别方法及应用

- 国知局

- 2024-06-21 10:44:07

本发明涉及人工智能领域,具体地,涉及一种基于多源特征的语音情绪识别方法、一种基于多源特征的语音情绪识别装置、一种电子设备以及一种计算机可读存储介质。

背景技术:

1、随着人机交互技术的发展,语音交互应用日益广泛,语音情绪识别技术也受到越来越多关注。

2、在语音交互中,识别用户的情绪状态可以实现更智能的人机交互,但是传统的语音情绪识别技术主要是基于语音的声学特征,忽略了文本语义信息对情绪识别的重要作用。同时,现有技术多依赖于标准干净的语音信号,过分依赖语音自身的音频特征,而并未考虑实际场景中环境声音对语音情绪表达效果造成的影响,以至于现有多的语音情绪识别方式准确率较低,无法在复杂环境下准确识别语音情绪,并且对增强情绪语音识别效果较差,难以满足实际交互应用场景的需求。

技术实现思路

1、针对现有技术的以上缺陷或改进需求,本发明提出了一种基于多源特征的语音情绪识别方法及应用,旨在解决的传统语音情绪识别技术仅基于语音的声学特征、且依赖标准干净的语音信号导致语音情绪识别准确率较低,无法在复杂环境下准确识别语音情绪的问题。

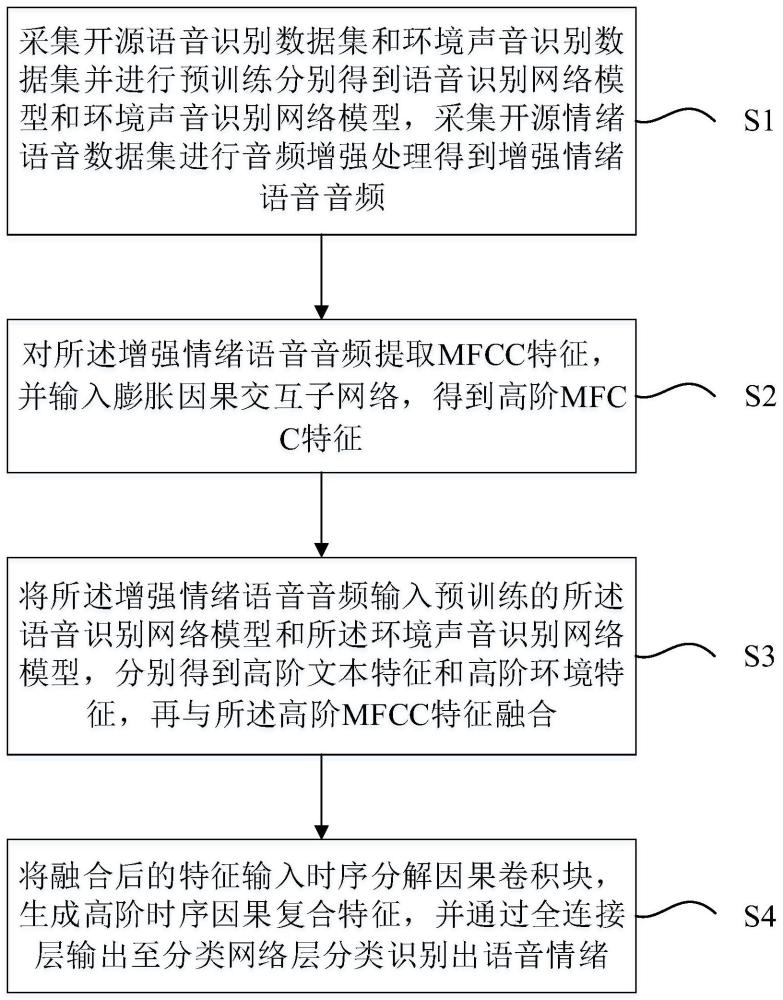

2、一方面,本发明提出了一种基于多源特征的语音情绪识别方法,包括:采集开源语音识别数据集和环境声音识别数据集并进行预训练分别得到语音识别网络模型和环境声音识别网络模型,采集开源情绪语音数据集进行音频增强处理得到增强情绪语音音频;对所述增强情绪语音音频提取mfcc特征,并输入膨胀因果交互子网络,得到高阶mfcc特征;将所述增强情绪语音音频输入预训练的所述语音识别网络模型和所述环境声音识别网络模型,分别得到高阶文本特征和高阶环境特征,再与所述高阶mfcc特征融合;将融合后的特征输入时序分解因果卷积块,生成高阶时序因果复合特征,并通过全连接层输出至分类网络层分类识别出语音情绪。

3、在本发明的一个实施例中,所述采集开源情绪语音数据集进行音频增强处理得到增强情绪语音音频,包括:对采集的所述开源情绪语音数据集通过添加白噪声达到预设的信噪比、时域随机抖动以及频域抖动,得到所述增强情绪语音音频。

4、在本发明的一个实施例中,所述环境声音识别网络模型由4层维度为1024的双向门控循环单元记忆网络堆叠,以及两层维度分别为1024和7的全连接层构成。

5、在本发明的一个实施例中,所述对所述增强情绪语音音频提取mfcc特征,输入膨胀因果交互子网络,得到高阶mfcc特征,包括:将所述增强情绪语音音频进行分帧,对每帧信号应用汉明窗进行傅立叶变换得到频谱表示,再通过梅尔滤波器组对频谱进行滤波并取对数,进行离散余弦变换后得到所述mfcc特征;将所述mfcc特征输入到膨胀因果交互子网络,得到高阶mfcc特征,所述膨胀因果交互子网络是由膨胀卷积和因果卷积结构构成的卷积网络。

6、在本发明的一个实施例中,所述膨胀因果交互子网络由两层膨胀因果网络构成,所述膨胀因果网络的输入序列先通过膨胀率为4的膨胀卷积核捕捉不同范围内的上下文信息,再输入右侧填充的因果卷积使输入序列顺序不变,最后进行批量归一化操作。

7、在本发明的一个实施例中,所述将所述增强情绪语音音频输入预训练的所述语音识别网络模型和所述环境声音识别网络模型,分别得到高阶文本特征和高阶环境特征,再与所述高阶mfcc特征融合,包括:将所述增强情绪语音音频输入到预训练的所述语音识别网络模型,提出该模型最后一层网络层的前一层的特征,即所述高阶文本特征;将所述增强情绪语音音频输入到预训练的所述环境声音识别网络模型,提出该模型最后一层网络层的前一层的特征,即所述高阶环境特征;将所述高阶mfcc特征、所述高阶文本特征以及所述高阶环境特征进行最大值融合,得到最大值融合特征。

8、在本发明的一个实施例中,所述将融合后的特征输入时序分解因果卷积块,生成高阶时序因果复合特征,包括:将所述最大值融合特征分解为奇序列和偶序列两个子时间序列,所述奇序列包含时间步为奇数的元素,偶序列包含时间步为偶数的元素;使用因果卷积将所述奇序列和所述偶序列分别映射到两个隐藏状态,并分别与另一序列的隐藏状态进行逐元素相乘,将元素相乘的结果与原序列进行残差连接,得到输出奇序列和输出偶序列;将所述输出奇序列和所述输出偶序列进行叠加,得到所述高阶时序因果复合特征。

9、另一方面,本发明还提出了一种基于多源特征的语音情绪识别装置,其包括:模型预训练模块,用于采集开源语音识别数据集和环境声音识别数据集并训练分别得到预训练的语音识别网络模型和环境声音识别网络模型,采集开源情绪语音数据集进行音频增强处理得到增强情绪语音音频;高阶特征获取模块,用于对所述增强情绪语音音频提取mfcc,输入膨胀因果交互子网络,得到高阶mfcc特征;高阶特征融合模块,用于将所述增强情绪语音音频输入预训练的所述语音识别网络模型和所述环境声音识别网络模型,分别得到高阶文本特征和高阶环境特征,再与所述高阶mfcc特征融合;语音情绪识别模块,用于将融合后的特征输入时序分解因果卷积块,生成高阶时序因果复合特征,并通过全连接层输出至分类网络层分类识别出语音情绪。

10、再一方面,本发明实施例还提出一种电子设备,包括:存储器和连接所述存储器的一个或多个处理器,所述存储器存储有计算机程序,所述处理器用于执行所述计算机程序以实现前述任意一个实施例所述方法的步骤。

11、又一方面,本发明实施例还提出一种计算机可读存储介质,其存储有可由访问认证设备执行的计算机程序,当所述计算机程序在访问认证设备上运行时,使得所述访问认证设备执前述任意一个实施例所述方法的步骤。

12、总体而言,通过本发明所构思的以上技术方案与现有技术相比,能够取得下列有益效果:

13、1)本发明提出的基于多源特征的语音情绪识别方法通过建立多源特征进行任务学习和高阶学习的端到端框架,融合语音、文本与环境三者信息互补训练,使得语音情绪的识别分类能够适应复杂环境、鲁棒性高,相比于传统的通过单一声学信号进行语音情绪识别的方式而言能够大幅提高识别准确率;

14、2)对采集的开源情绪语音数据集通过添加白噪声达到预设的信噪比、时域随机抖动以及频域抖动得到增强情绪语音音频,可以在不改变音频内容的情况下,通过破坏原始语音在时域上的连续性,增强模型学习时间信息的能力,提高对时域抖动的鲁棒性,增强模型的泛化能力;

15、3)进行高阶特征训练的膨胀因果交互子网络由两层膨胀因果网络构成,膨胀因果网络的输入序列先通过膨胀率设置为4的膨胀卷积核捕捉不同范围内的上下文信息,然后进入只在右侧填充的因果卷积层保证序列顺序不变,最后进行批量归一化操作,这样既扩大了感受野又保持了时序一致性,实现了高效的序列建模;

16、4)通过将高阶文本特征、高阶环境特征以及高阶mfcc特征进行最大值融合,可以突出不同考虑因素中最显著的特征,发挥多源特征融合的最大效用,后续得到更准确的特征识别效果;

17、5)通过将最大值融合特征分解为奇偶两个子时间序列,奇偶序列分别经过独立的因果卷积层,实现了更丰富的特征学习,最终有效提高语音情绪识别分类的准确性。

本文地址:https://www.jishuxx.com/zhuanli/20240618/21414.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表