语音转换方法、装置、电子设备和存储介质与流程

- 国知局

- 2024-06-21 11:56:47

本公开涉及音频处理,尤其涉及一种语音转换模型的训练方法、语音转换方法、语音转换模型的训练装置、语音转换装置、电子设备和存储介质。

背景技术:

1、语音转换(voice conversion)是指将一段输入语音,转换为特定说话人的音色,并且不改变音频内容的技术方法。

2、语音转换技术具有广泛的应用场景。在游戏娱乐中,通过语音转换,录音人员可以扮演不同的角色,达到想要的声音效果,从而可以为电影、动画、视频游戏等配音。在人机交互中,通过调整声音来匹配用户喜欢的角色,可以让语音助手变得更加具有亲和力和吸引力。语音转换技术允许普通用户将自己的声音转换为不同的风格或角色,应用场景广泛。

3、因此,提高语音转换后的音频效果具有重要意义。

技术实现思路

1、本公开提供了一种语音转换技术方案。

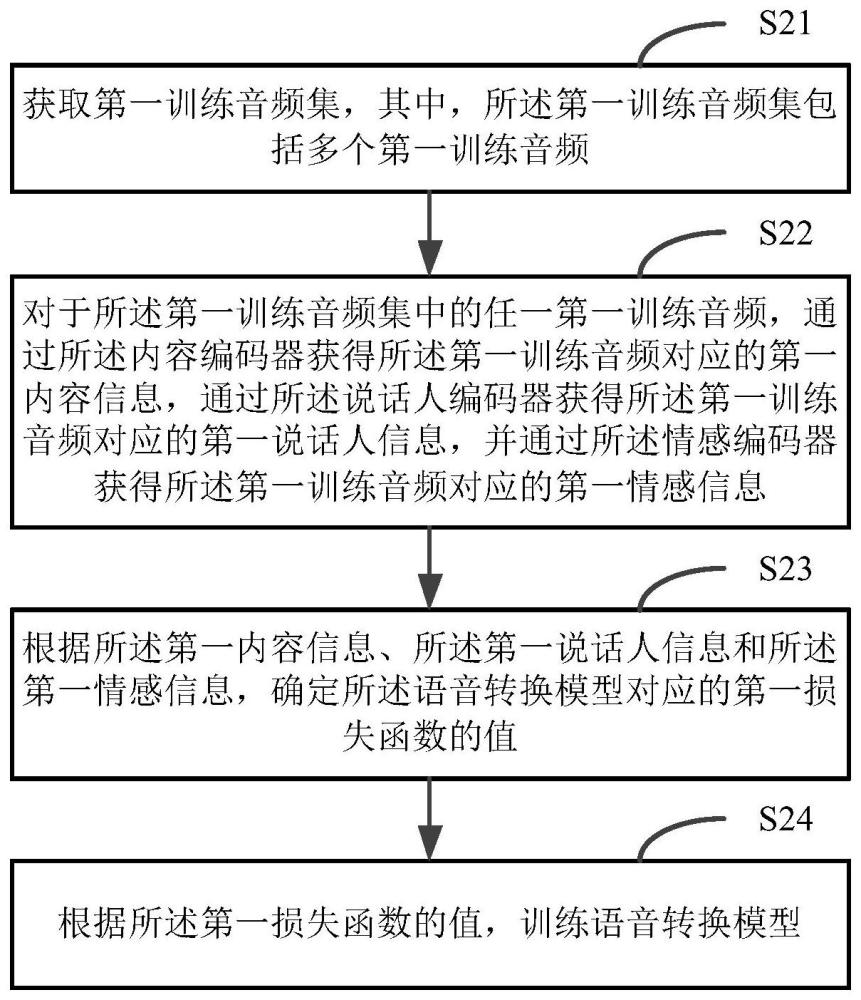

2、根据本公开的一方面,提供了一种语音转换模型的训练方法,所述语音转换模型包括内容编码器、说话人编码器和情感编码器,所述方法包括:

3、获取第一训练音频集,其中,所述第一训练音频集包括多个第一训练音频;

4、对于所述第一训练音频集中的任一第一训练音频,通过所述内容编码器获得所述第一训练音频对应的第一内容信息,通过所述说话人编码器获得所述第一训练音频对应的第一说话人信息,并通过所述情感编码器获得所述第一训练音频对应的第一情感信息;

5、根据所述第一内容信息、所述第一说话人信息和所述第一情感信息,确定所述语音转换模型对应的第一损失函数的值;

6、根据所述第一损失函数的值,训练语音转换模型。

7、在一种可能的实现方式中,所述语音转换模型还包括频谱编码器;

8、所述方法还包括:获得所述第一训练音频的频谱;通过所述频谱编码器对所述第一训练音频的频谱进行编码,得到所述第一训练音频的中间表示;

9、所述根据所述第一内容信息、所述第一说话人信息和所述第一情感信息,确定所述语音转换模型对应的第一损失函数的值,包括:根据所述第一训练音频的中间表示,获得所述第一训练音频对应的输出音频的隐空间表示;根据所述第一内容信息、所述第一说话人信息和所述第一情感信息,获得所述第一训练音频对应的输入音频的隐空间表示;根据所述第一训练音频对应的输出音频的隐空间表示与所述第一训练音频对应的输入音频的隐空间表示之间的相似度,确定所述语音转换模型对应的第一损失函数的值。

10、在一种可能的实现方式中,所述语音转换模型还包括转换模块;

11、所述根据所述第一训练音频的中间表示,获得所述第一训练音频对应的输出音频的隐空间表示,包括:

12、通过所述转换模块对所述第一训练音频的中间表示进行转换,得到所述第一训练音频对应的输出音频的隐空间表示。

13、在一种可能的实现方式中,所述语音转换模型还包括融合层;

14、所述根据所述第一内容信息、所述第一说话人信息和所述第一情感信息,获得所述第一训练音频对应的输入音频的隐空间表示,包括:

15、通过所述融合层对所述第一内容信息、所述第一说话人信息和所述第一情感信息进行融合,得到所述第一训练音频对应的输入音频的隐空间表示。

16、在一种可能的实现方式中,所述语音转换模型还包括解码器;

17、所述方法还包括:

18、通过所述解码器对所述第一训练音频的中间表示进行解码,得到所述第一训练音频对应的第一合成音频;

19、根据所述第一合成音频与所述第一训练音频之间的相似度,确定所述语音转换模型对应的第二损失函数的值;

20、根据所述第二损失函数的值,训练所述语音转换模型。

21、在一种可能的实现方式中,在所述通过所述内容编码器获得所述第一训练音频对应的第一内容信息之后,所述方法还包括:

22、通过第一说话人分类器对所述第一内容信息进行说话人分类,得到所述第一内容信息对应的第一说话人分类预测结果;

23、根据所述第一说话人分类预测结果和所述第一训练音频的说话人标签,得到所述第一说话人分类器对应的第三损失函数的值;

24、根据所述第三损失函数的值,对所述第一说话人分类器和所述内容编码器进行对抗训练。

25、在一种可能的实现方式中,在所述通过所述内容编码器获得所述第一训练音频对应的第一内容信息之后,所述方法还包括:

26、通过第一情感分类器对所述第一内容信息进行情感分类,得到所述第一内容信息对应的第一情感分类预测结果;

27、根据所述第一情感分类预测结果和所述第一训练音频的情感标签,得到所述第一情感分类器对应的第四损失函数的值;

28、根据所述第四损失函数的值,对所述第一情感分类器和所述内容编码器进行对抗训练。

29、在一种可能的实现方式中,在所述通过所述说话人编码器获得所述第一训练音频对应的第一说话人信息之后,所述方法还包括:

30、通过第二情感分类器对所述第一说话人信息进行情感分类,得到所述第一说话人信息对应的第二情感分类预测结果;

31、根据所述第二情感分类预测结果和所述第一训练音频的情感标签,得到所述第二情感分类器对应的第五损失函数的值;

32、根据所述第五损失函数的值,对所述第二情感分类器和所述说话人编码器进行对抗训练。

33、在一种可能的实现方式中,在所述通过所述情感编码器获得所述第一训练音频对应的第一情感信息之后,所述方法还包括:

34、通过第二说话人分类器对所述第一情感信息进行说话人分类,得到所述第一情感信息对应的第二说话人分类预测结果;

35、根据所述第二说话人分类预测结果和所述第一训练音频的说话人标签,得到所述第二说话人分类器对应的第六损失函数的值;

36、根据所述第六损失函数的值,对所述第二说话人分类器和所述情感编码器进行对抗训练。

37、在一种可能的实现方式中,还包括:

38、获取第二训练音频集,其中,所述第二训练音频集包括多个第二训练音频,且所述第二训练音频为所述第一训练音频或者所述第一训练音频对应的第一合成音频;

39、对于所述第二训练音频集中的任一第二训练音频,将所述第二训练音频输入鉴别器,通过所述鉴别器输出所述第二训练音频对应的音频类别预测结果,其中,音频类别包括真实音频和合成音频;

40、根据所述第二训练音频对应的音频类别预测结果和所述第二训练音频对应的音频类别标签,确定第七损失函数的值;

41、根据所述第七损失函数的值,对所述鉴别器进行训练。

42、在一种可能的实现方式中,在每次更新所述语音转换模型时,先根据所述第七损失函数的值优化所述鉴别器的参数,再根据其他损失函数的值优化所述语音转换模型的参数。

43、在一种可能的实现方式中,还包括:

44、将所述第一训练音频对应的第一合成音频输入鉴别器,通过所述鉴别器输出所述第一合成音频对应的音频类别预测结果,其中,音频类别包括真实音频和合成音频;

45、根据所述第一合成音频对应的音频类别预测结果,确定所述语音转换模型对应的第八损失函数的值;

46、根据所述第八损失函数的值,训练所述语音转换模型。

47、在一种可能的实现方式中,所述通过所述内容编码器获得所述第一训练音频对应的第一内容信息,通过所述说话人编码器获得所述第一训练音频对应的第一说话人信息,并通过所述情感编码器获得所述第一训练音频对应的第一情感信息,包括:

48、获得所述第一训练音频对应的第一内容向量、第一说话人特征向量和第一情感特征向量;

49、通过所述内容编码器对所述第一内容向量进行编码,得到所述第一训练音频对应的第一内容信息,通过所述说话人编码器对所述第一说话人特征向量进行编码,得到所述第一训练音频对应的第一说话人信息,并通过所述情感编码器对所述第一情感特征向量进行编码,得到所述第一训练音频对应的第一情感信息。

50、在一种可能的实现方式中,所述获得第一训练音频对应的第一内容向量、第一说话人特征向量和第一情感特征向量,包括:

51、通过语音识别模型提取所述第一训练音频对应的第一内容向量;

52、通过说话人识别模型提取所述第一训练音频对应的第一说话人特征向量;

53、通过情感识别模型提取所述第一训练音频对应的第一情感特征向量。

54、在一种可能的实现方式中,

55、所述通过语音识别模型提取所述第一训练音频对应的第一内容向量,包括:将所述第一训练音频输入语音识别模型,并将所述语音识别模型的隐藏层的输出作为所述第一训练音频对应的第一内容向量;

56、和/或,

57、所述通过说话人识别模型提取所述第一训练音频对应的第一说话人特征向量,包括:将所述第一训练音频输入说话人识别模型,并将所述说话人识别模型的最后一个隐藏层的输出作为所述第一训练音频对应的第一说话人特征向量;

58、和/或,

59、所述通过情感识别模型提取所述第一训练音频对应的第一情感特征向量,包括:将所述第一训练音频输入情感识别模型,并将所述情感识别模型的最后一个隐藏层的输出作为所述第一训练音频对应的第一情感特征向量。

60、根据本公开的一方面,提供了一种语音转换方法,包括:

61、获取所述语音转换模型的训练方法训练得到的语音转换模型;

62、通过所述内容编码器获得待转换音频对应的第二内容信息,通过所述说话人编码器获得目标音色音频对应的第二说话人信息,并通过所述情感编码器获得目标情感音频对应的第二情感信息;

63、通过所述语音转换模型根据所述第二内容信息、所述第二说话人信息和所述第二情感信息,生成第二合成音频。

64、在一种可能的实现方式中,所述通过所述内容编码器获得待转换音频对应的第二内容信息,通过所述说话人编码器获得目标音色音频对应的第二说话人信息,并通过所述情感编码器获得目标情感音频对应的第二情感信息,包括:

65、通过语音识别模型提取所述待转换音频对应的第二内容向量;

66、通过说话人识别模型提取所述目标音色音频对应的第二说话人特征向量;

67、通过情感识别模型提取所述目标情感音频对应的第二情感特征向量;

68、通过所述内容编码器对所述第二内容向量进行编码,得到所述待转换音频对应的第二内容信息,通过所述说话人编码器对所述第二说话人特征向量进行编码,得到所述目标音色音频对应的第二说话人信息,并通过所述情感编码器对所述第二情感特征向量进行编码,得到所述目标情感音频对应的第二情感信息。

69、根据本公开的一方面,提供了一种语音转换模型的训练装置,所述语音转换模型包括内容编码器、说话人编码器和情感编码器,所述装置包括:

70、第一获取模块,用于获取第一训练音频集,其中,所述第一训练音频集包括多个第一训练音频;

71、第一编码模块,用于对于所述第一训练音频集中的任一第一训练音频,通过所述内容编码器获得所述第一训练音频对应的第一内容信息,通过所述说话人编码器获得所述第一训练音频对应的第一说话人信息,并通过所述情感编码器获得所述第一训练音频对应的第一情感信息;

72、第一确定模块,用于根据所述第一内容信息、所述第一说话人信息和所述第一情感信息,确定所述语音转换模型对应的第一损失函数的值;

73、第一训练模块,用于根据所述第一损失函数的值,训练语音转换模型。

74、在一种可能的实现方式中,所述语音转换模型还包括频谱编码器;

75、所述装置还包括:第三编码模块,用于获得所述第一训练音频的频谱;通过所述频谱编码器对所述第一训练音频的频谱进行编码,得到所述第一训练音频的中间表示;

76、所述第一确定模块用于:根据所述第一训练音频的中间表示,获得所述第一训练音频对应的输出音频的隐空间表示;根据所述第一内容信息、所述第一说话人信息和所述第一情感信息,获得所述第一训练音频对应的输入音频的隐空间表示;根据所述第一训练音频对应的输出音频的隐空间表示与所述第一训练音频对应的输入音频的隐空间表示之间的相似度,确定所述语音转换模型对应的第一损失函数的值。

77、在一种可能的实现方式中,所述语音转换模型还包括转换模块;

78、所述第一确定模块用于:

79、通过所述转换模块对所述第一训练音频的中间表示进行转换,得到所述第一训练音频对应的输出音频的隐空间表示。

80、在一种可能的实现方式中,所述语音转换模型还包括融合层;

81、所述第一确定模块用于:

82、通过所述融合层对所述第一内容信息、所述第一说话人信息和所述第一情感信息进行融合,得到所述第一训练音频对应的输入音频的隐空间表示。

83、在一种可能的实现方式中,所述语音转换模型还包括解码器;

84、所述装置还包括:

85、解码模块,用于通过所述解码器对所述第一训练音频的中间表示进行解码,得到所述第一训练音频对应的第一合成音频;

86、第二确定模块,用于根据所述第一合成音频与所述第一训练音频之间的相似度,确定所述语音转换模型对应的第二损失函数的值;

87、第二训练模块,用于根据所述第二损失函数的值,训练所述语音转换模型。

88、在一种可能的实现方式中,所述装置还包括:

89、第一分类模块,用于通过第一说话人分类器对所述第一内容信息进行说话人分类,得到所述第一内容信息对应的第一说话人分类预测结果;

90、第三确定模块,用于根据所述第一说话人分类预测结果和所述第一训练音频的说话人标签,得到所述第一说话人分类器对应的第三损失函数的值;

91、第三训练模块,用于根据所述第三损失函数的值,对所述第一说话人分类器和所述内容编码器进行对抗训练。

92、在一种可能的实现方式中,所述装置还包括:

93、第二分类模块,用于通过第一情感分类器对所述第一内容信息进行情感分类,得到所述第一内容信息对应的第一情感分类预测结果;

94、第四确定模块,用于根据所述第一情感分类预测结果和所述第一训练音频的情感标签,得到所述第一情感分类器对应的第四损失函数的值;

95、第四训练模块,用于根据所述第四损失函数的值,对所述第一情感分类器和所述内容编码器进行对抗训练。

96、在一种可能的实现方式中,所述装置还包括:

97、第三分类模块,用于通过第二情感分类器对所述第一说话人信息进行情感分类,得到所述第一说话人信息对应的第二情感分类预测结果;

98、第五确定模块,用于根据所述第二情感分类预测结果和所述第一训练音频的情感标签,得到所述第二情感分类器对应的第五损失函数的值;

99、第五训练模块,用于根据所述第五损失函数的值,对所述第二情感分类器和所述说话人编码器进行对抗训练。

100、在一种可能的实现方式中,所述装置还包括:

101、第四分类模块,用于通过第二说话人分类器对所述第一情感信息进行说话人分类,得到所述第一情感信息对应的第二说话人分类预测结果;

102、第六确定模块,用于根据所述第二说话人分类预测结果和所述第一训练音频的说话人标签,得到所述第二说话人分类器对应的第六损失函数的值;

103、第六训练模块,用于根据所述第六损失函数的值,对所述第二说话人分类器和所述情感编码器进行对抗训练。

104、在一种可能的实现方式中,还包括:

105、第三获取模块,用于获取第二训练音频集,其中,所述第二训练音频集包括多个第二训练音频,且所述第二训练音频为所述第一训练音频或者所述第一训练音频对应的第一合成音频;

106、第五分类模块,用于对于所述第二训练音频集中的任一第二训练音频,将所述第二训练音频输入鉴别器,通过所述鉴别器输出所述第二训练音频对应的音频类别预测结果,其中,音频类别包括真实音频和合成音频;

107、第七确定模块,用于根据所述第二训练音频对应的音频类别预测结果和所述第二训练音频对应的音频类别标签,确定第七损失函数的值;

108、第七训练模块,用于根据所述第七损失函数的值,对所述鉴别器进行训练。

109、在一种可能的实现方式中,在每次更新所述语音转换模型时,先根据所述第七损失函数的值优化所述鉴别器的参数,再根据其他损失函数的值优化所述语音转换模型的参数。

110、在一种可能的实现方式中,还包括:

111、第六分类模块,用于将所述第一训练音频对应的第一合成音频输入鉴别器,通过所述鉴别器输出所述第一合成音频对应的音频类别预测结果,其中,音频类别包括真实音频和合成音频;

112、第八确定模块,用于根据所述第一合成音频对应的音频类别预测结果,确定所述语音转换模型对应的第八损失函数的值;

113、第八训练模块,用于根据所述第八损失函数的值,训练所述语音转换模型。

114、在一种可能的实现方式中,所述第一编码模块用于:

115、获得所述第一训练音频对应的第一内容向量、第一说话人特征向量和第一情感特征向量;

116、通过所述内容编码器对所述第一内容向量进行编码,得到所述第一训练音频对应的第一内容信息,通过所述说话人编码器对所述第一说话人特征向量进行编码,得到所述第一训练音频对应的第一说话人信息,并通过所述情感编码器对所述第一情感特征向量进行编码,得到所述第一训练音频对应的第一情感信息。

117、在一种可能的实现方式中,所述第一编码模块用于:

118、通过语音识别模型提取所述第一训练音频对应的第一内容向量;

119、通过说话人识别模型提取所述第一训练音频对应的第一说话人特征向量;

120、通过情感识别模型提取所述第一训练音频对应的第一情感特征向量。

121、在一种可能的实现方式中,所述第一编码模块用于:

122、将所述第一训练音频输入语音识别模型,并将所述语音识别模型的隐藏层的输出作为所述第一训练音频对应的第一内容向量;

123、和/或,

124、将所述第一训练音频输入说话人识别模型,并将所述说话人识别模型的最后一个隐藏层的输出作为所述第一训练音频对应的第一说话人特征向量;

125、和/或,

126、将所述第一训练音频输入情感识别模型,并将所述情感识别模型的最后一个隐藏层的输出作为所述第一训练音频对应的第一情感特征向量。

127、根据本公开的一方面,提供了一种语音转换装置,包括:

128、第二获取模块,用于获取如权利要求18所述的语音转换模型的训练装置训练得到的语音转换模型;

129、第二编码模块,用于通过所述内容编码器获得待转换音频对应的第二内容信息,通过所述说话人编码器获得目标音色音频对应的第二说话人信息,并通过所述情感编码器获得目标情感音频对应的第二情感信息;

130、生成模块,用于通过所述语音转换模型根据所述第二内容信息、所述第二说话人信息和所述第二情感信息,生成第二合成音频。

131、在一种可能的实现方式中,所述第二编码模块用于:

132、通过语音识别模型提取所述待转换音频对应的第二内容向量;

133、通过说话人识别模型提取所述目标音色音频对应的第二说话人特征向量;

134、通过情感识别模型提取所述目标情感音频对应的第二情感特征向量;

135、通过所述内容编码器对所述第二内容向量进行编码,得到所述待转换音频对应的第二内容信息,通过所述说话人编码器对所述第二说话人特征向量进行编码,得到所述目标音色音频对应的第二说话人信息,并通过所述情感编码器对所述第二情感特征向量进行编码,得到所述目标情感音频对应的第二情感信息。

136、根据本公开的一方面,提供了一种电子设备,包括:一个或多个处理器;用于存储可执行指令的存储器;其中,所述一个或多个处理器被配置为调用所述存储器存储的可执行指令,以执行上述方法。

137、根据本公开的一方面,提供了一种计算机可读存储介质,其上存储有计算机程序指令,所述计算机程序指令被处理器执行时实现上述方法。

138、根据本公开的一方面,提供了一种计算机程序产品,包括计算机可读代码,或者承载有计算机可读代码的非易失性计算机可读存储介质,当所述计算机可读代码在电子设备中运行时,所述电子设备中的处理器执行上述方法。

139、在本公开实施例中,通过获取第一训练音频集,其中,所述第一训练音频集包括多个第一训练音频,对于所述第一训练音频集中的任一第一训练音频,通过所述内容编码器获得所述第一训练音频对应的第一内容信息,通过所述说话人编码器获得所述第一训练音频对应的第一说话人信息,并通过所述情感编码器获得所述第一训练音频对应的第一情感信息,根据所述第一内容信息、所述第一说话人信息和所述第一情感信息,确定所述语音转换模型对应的第一损失函数的值,并根据所述第一损失函数的值,训练语音转换模型,由此在语音转换模型中对情感信息进行显式建模,可以控制语音转换后的音频中的情感效果,从而能够实现情感可控的语音转换,提高语音转换后的音频效果。

140、应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,而非限制本公开。

141、根据下面参考附图对示例性实施例的详细说明,本公开的其它特征及方面将变得清楚。

本文地址:https://www.jishuxx.com/zhuanli/20240618/24643.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表