一种综合性儿童音乐教学系统的制作方法

- 国知局

- 2024-06-21 14:13:11

本发明涉及音乐教育领域,更具体地说,本发明涉及一种综合性儿童音乐教学系统。

背景技术:

1、音乐教育被认为是未来的重点推行项目之一,技术进步推动音乐教育行业朝数据化和智能化方向发展,各种音乐教育软件的出现使音乐学习更加方便和趣味,因其所独有的方便性与趣味性吸引着更多的人们了解并使用,线上形式的开拓降低了音乐教学的门槛。

2、然而,音乐教育行业的快速发展面临着问题,刻板、功利化的学习方式缺乏趣味性,严重限制了孩子发展,并在很大程度上削减了音乐教育的效果,具体来看,传统乐器演奏方式复杂、乐理专业性太强、教育形式单一刻板以及缺乏创造力和探索性的培养等问题或已成为音乐类软件的通病。因此,如何让儿童进行有趣、有效的音乐启蒙,正是音乐教育市场的亟需之策。

技术实现思路

1、本发明针对现有技术中存在的技术问题,提供一种综合性儿童音乐教学系统,以解决上述背景技术中提出的问题。

2、本发明解决上述技术问题的技术方案如下:包括收集分析模块、旋律生成模块、智能对弹模块、智能编曲模块以及虚拟交互模块;

3、收集分析模块:利用audacity收集物品敲击声音的音频信号,应用小波变换将音频信号分解成不同频率层级的小波系数,创建可视化界面连接触摸屏幕,通过触摸屏幕收集原始儿童涂鸦图像;

4、旋律生成模块:构建mus ictransformer模型,利用midi格式的分解单音作为模型输入数据序列并转换成对应的输入嵌入向量,通过自注意力机制提取模型输入数据序列中的重要音符信息和音符上下文;

5、智能对弹模块:利用m id i格式的音乐数据作为模型输入数据序列,建立音乐词汇表,选择lstm搭建rnns模型并通过引入门控机制控制信息的累积速度,输入模型输入数据序列并利用模型生成下一个音符、节拍和和弦的预测结果;

6、智能编曲模块:连接mus i cgen平台选择音乐风格并设置曲目的参数,连接可视化界面中的摄像头捕获儿童的手部动作图像数据,构建手势识别模型,将模型的分类预测结果连接至可视化界面并添加儿童交互功能;

7、虚拟交互模块:连接mr端进行虚拟乐器的交互,通过空间映射技术将虚拟乐器放置在儿童周围的物理空间中,利用获取的深度信息结合kinect fusion理论进行三维重建;

8、在一个优选地实施方式中,所述收集分析模块利用audac ity收集物品敲击声音的音频信号并连接可触摸点击按钮,应用小波变换将音频信号分解成不同频率层级的小波系数,包括高频系数和低频信号,根据不同的时频特性区分音频信号的有用信号与噪音信号,通过阈值量化选取合理阈值去除高频成分的噪音信号,所述合理阈值的选取评估法则为:

9、

10、其中,t表示选取的合理阈值,δ表示噪音信号的均方差,n表示噪音信号的长度,对低频系数和阈值量化处理后的高频系数进行小波重构,用于获取去噪后的信号,所述小波重构具体公式为:

11、o=idwt(ca,cd)

12、其中,o表示去噪后的信号,ca表示低频系数,cd表示阈值量化处理后的高频系数,idwt()表示逆小波变换。

13、进一步地,创建可视化界面连接触摸屏幕,将物品敲击声音细分为沉闷、较沉闷、清脆以及较清脆四个类型,可视化界面中选择深蓝色圆形表示沉闷类型,选择橙色四边形表示较沉闷类型,选择紫色三角形表示较清脆类型,选择天蓝色正方形表示清脆类型,利用决策树将物品敲击声音的类型作为决策树根节点并划分不同的类型子集,对于每个非叶节点,选择物品敲击声音的类型中的最佳声音类型特征进行分类,当该非叶节点的基尼指数越小,判断该节点的纯度越高,该特征表示具有相似最佳声音类型特征的物品敲击声音属于同一类型,当该非叶节点的基尼指数越大,判断该节点的纯度越低,该特征表示具有相似最佳声音类型特征的物品敲击声音不属于同一类型。

14、进一步地,通过触摸屏幕收集原始儿童涂鸦图像,利用最小-最大归一化将原始儿童涂鸦图像的像素值缩小到指定范围,并从[0,255]范围映射到[0,1]范围内,所述最小-最大归一化公式为:

15、

16、其中q表示归一化后的儿童涂鸦图像的像素值,p表示原始儿童涂鸦图像的像素值,pmin表示原始儿童涂鸦图像的像素值的最小值,pmax表示原始儿童涂鸦图像的像素值的最大值,构建efficientnet模型,其中卷积层对输入的儿童涂鸦图像进行特征提取,利用relu作为激活函数引入非线性并使用卷积核对输入图像数据进行卷积运算,所述卷积运算具体公式为:

17、c(i,j)=\sum_(m)\sum(n)*i(i+m,j+n)\codt k(m,n)

18、其中c(i,j)表示儿童涂鸦图像特征图中的一个元素,i(i+m,j+n)表示儿童涂鸦图像的一个像素值,codt k(m,n)表示卷积核的权重,m、n分别表示卷积核的高度和宽度上的索引,i、j分别表示儿童涂鸦图像特征图中的高度和宽度上的索引,其中池化层对儿童涂鸦图像的边缘、纹理特征进行降维和下采样,并选择儿童涂鸦图像局部区域内的最大值,其中全连接层进行特征整合和转换,利用全连接层通过权重矩阵将特征映射到不同儿童涂鸦图像的类别上,利用softmax对全连接层的输出进行处理。

19、在一个优选地实施方式中,所述旋律生成模块构建musictransformer模型,利用midi格式的分解单音作为模型输入数据序列并转换成对应的输入嵌入向量,在输入嵌入向量中添加位置编码向量,引入自注意力机制对于每个位置的模型输入数据序列,通过加权求和表示与数据序列其他位置的相关性,通过自注意力机制提取模型输入数据序列中的重要音符信息和音符上下文,在多头自注意力子层中,通过矩阵变换获取查询向量、键向量以及值向量,其具体公式为:

20、

21、其中,αi表示注意力权重,q表示查询向量,ki表示键向量,dk表示键向的维度,vi表示值向量,其中每个头的注意力输出被连接并线性变换获取一个l×d维矩阵,前馈子层从前一个注意力子层获取l×d维矩阵输出,并在深度d维度上执行两层逐点密集层,利用记忆作为解码器的输入输出,并将其传递到后续的旋律生成中。

22、在一个优选地实施方式中,所述智能对弹模块利用midi格式的音乐数据作为模型输入数据序列,建立音乐词汇表,并将模型输入数据序列中的音符、节拍以及和弦元素映射到数字,将模型输入数据序列转换成时间序列数据,选择lstm搭建rnns模型,通过引入门控机制控制信息的累积速度,包括选择性加入新的信息,并选择性遗忘之前累积的信息,其中门控机制包括输入门、遗忘门以及输出门,其中输入门根据当前时间步的输入数据和上一时间步的隐藏状态,通过sigmoid激活函数计算输入门的激活值并转换为介于0和1之间的值,其具体公式为:

23、ul=γ(wl*[ht-1,xt]+bl)

24、其中,ul表示输入门的激活值,γ()表示sigmoid激活函数,wl表示权重矩阵,ht-1表示上一时间步的隐藏状态,xt表示当前时间步的输入,bl表示偏置项,其中遗忘门根据当前时间步的输入数据和上一时间步的隐藏状态,通过sigmoid激活函数计算遗忘门的激活值并转换为介于0和1之间的值,其具体公式为:

25、yf=γ(wf*[ht-1,xt]+bf)

26、其中,yf表示遗忘门的激活值,γ()表示sigmoid激活函数,wf表示权重矩阵,ht-1表示上一时间步的隐藏状态,xt表示当前时间步的输入,bf表示偏置项,其中输出门根据当前时间步的输入数据、上一时间步的隐藏状态以及当前时间步的细胞状态,通过sigmoid激活函数计算输出门的激活值并转换为介于0和1之间的值,其具体公式为:

27、to=γ(wo*[ht-1,xt]+bo)

28、其中,to表示遗忘门的激活值,γ()表示sigmoid激活函数,wo表示权重矩阵,ht-1表示上一时间步的隐藏状态,xt表示当前时间步的输入,bo表示偏置项,输入模型输入数据序列并利用模型生成下一个音符、节拍和和弦的预测结果,并将其作为输入的一部分继续生成,直到生成所需长度的音乐片段。

29、在一个优选地实施方式中,所述智能编曲模块连接musicgen平台选择音乐风格并设置曲目的参数,对生成的乐谱进行编辑和调整,将编曲导出并保存。

30、进一步地,连接可视化界面中的摄像头捕获儿童的手部动作图像数据,利用边缘监测提取手部特征,构建手势识别模型,利用relu作为激活函数引入非线性并使用卷积核对手部动作图像数据进行卷积运算,所述卷积运算具体公式为:

31、c(i,j)=\sum_(m)\sum(n)*i(i+m,j+n)\codt k(m,n)

32、其中c(i,j)表示手部动作图像数据中的一个元素,i(i+m,j+n)表示手部动作图像数据的一个像素值,codt k(m,n)表示卷积核的权重,m、n分别表示卷积核的高度和宽度上的索引,i、j分别表示手部动作图像数据中的高度和宽度上的索引,其中池化层对手部动作图像数据的手部的形状、轮廓以及运动轨迹的特征进行降维和下采样,并选择手部动作图像数据局部区域内的最大值,其中全连接层进行手部特征整合和转换,利用全连接层通过权重矩阵将特征映射到不同手部动作图像数据的类别上,利用softmax对全连接层的输出进行处理,将分类预测结果连接至可视化界面并添加儿童交互功能。

33、在一个优选地实施方式中,所述虚拟交互模块连接mr端进行虚拟乐器的交互,通过空间映射技术将虚拟乐器放置在儿童周围的物理空间中,基于视差原理的双目视觉方法、结构光方法和tof方法获取深度信息。

34、进一步地,利用获取的深度信息结合kinect fusion理论进行三维重建,将深度信息转换为三维点云数据,其中三维点云数据的每个点的坐标由深度图像中的像素位置和深度值构成,利用环境感知摄像头感知周围环境并提取特征点,通过将当前点云与已有的三维模型对齐,通过投影光线在场景中寻找对应的环境点云实现持续的三维场景重建。

35、在一个优选地实施方式中,具体包括以下步骤:

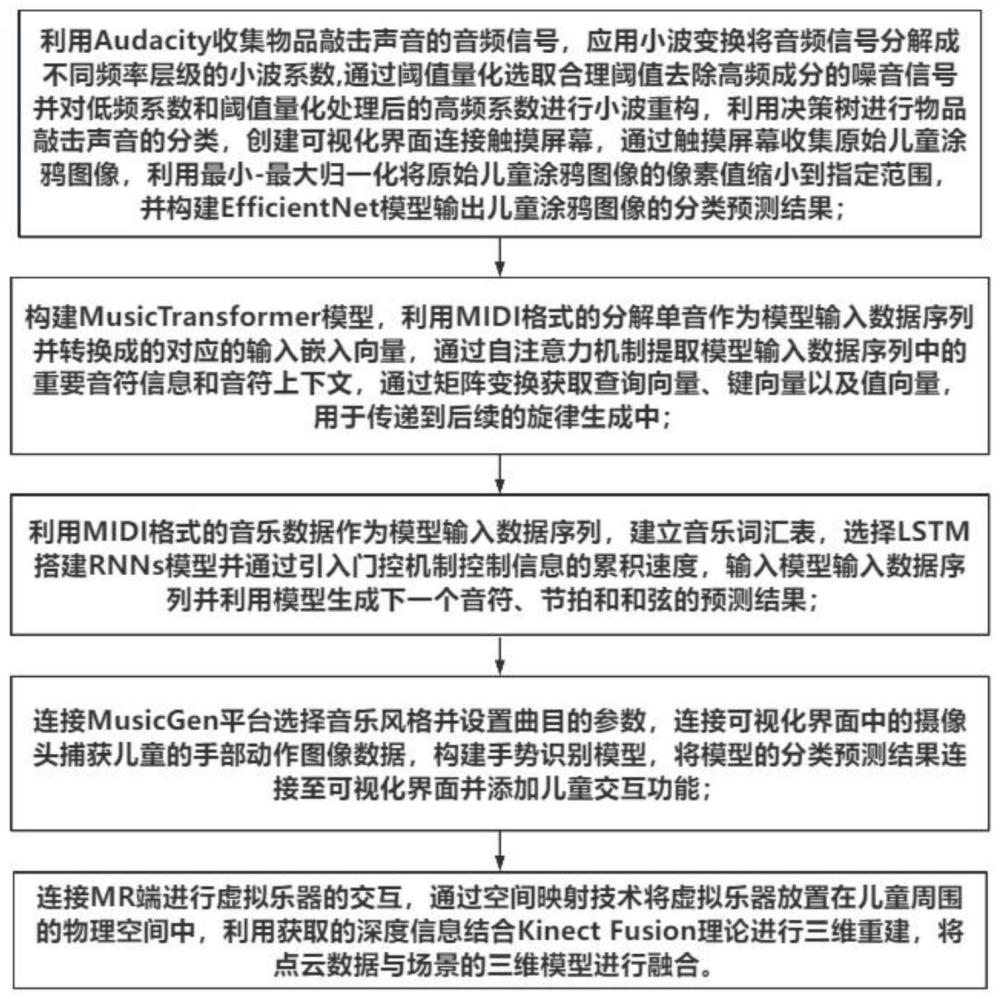

36、s101.利用audacity收集物品敲击声音的音频信号,应用小波变换将音频信号分解成不同频率层级的小波系数,通过阈值量化选取合理阈值去除高频成分的噪音信号并对低频系数和阈值量化处理后的高频系数进行小波重构,利用决策树进行物品敲击声音的分类,创建可视化界面连接触摸屏幕,通过触摸屏幕收集原始儿童涂鸦图像,利用最小-最大归一化将原始儿童涂鸦图像的像素值缩小到指定范围,并构建eff icientnet模型输出儿童涂鸦图像的分类预测结果;

37、s102.构建mus i ctransformer模型,利用midi格式的分解单音作为模型输入数据序列并转换成的对应的输入嵌入向量,通过自注意力机制提取模型输入数据序列中的重要音符信息和音符上下文,通过矩阵变换获取查询向量、键向量以及值向量,用于传递到后续的旋律生成中;

38、s103.利用m idi格式的音乐数据作为模型输入数据序列,建立音乐词汇表,选择lstm搭建rnns模型并通过引入门控机制控制信息的累积速度,输入模型输入数据序列并利用模型生成下一个音符、节拍和和弦的预测结果;

39、s104.连接mus i cgen平台选择音乐风格并设置曲目的参数,连接可视化界面中的摄像头捕获儿童的手部动作图像数据,构建手势识别模型,将模型的分类预测结果连接至可视化界面并添加儿童交互功能;

40、s105.连接mr端进行虚拟乐器的交互,通过空间映射技术将虚拟乐器放置在儿童周围的物理空间中,利用获取的深度信息结合ki nect fus i on理论进行三维重建,将点云数据与场景的三维模型进行融合;

41、本发明的有益效果是:通过小波变换将音频信号分解成不同频率层级的小波系数,提高了声音信号的清晰度和准确性,通过最小-最大归一化处理原始儿童涂鸦图像,有助于规范化图像数据,通过efficientnet模型构建有助于构建一个有效的图像分类模型,提高了图像分类的准确性和泛化能力,通过添加位置编码向量到输入嵌入向量中,有助于模型区分不同位置的音符,在处理序列数据时更好地捕捉音符之间的关系和顺序,通过自注意力机制引入有效地捕捉音符之间的依赖关系和重要信息,提高了模型对音乐序列的理解和表达能力,利用记忆作为解码器的输入输出,有助于模型保持对先前信息的记忆和利用历史信息生成连贯的音乐旋律,通过门控机制改善音乐序列生成的准确性和连贯性,有效地提升模型对音乐信息的处理能力,通过手势识别模型实现对儿童手部动作的识别和理解,增强儿童体验和参与感,利用引入relu作为激活函数捕获手部动作的形状、轮廓和运动轨迹的重要特征,通过可视化界面和儿童交互功能使儿童更直观地了解识别结果,并与系统进行互动,通过实时、高精度的空间映射技术帮助mr设备更好地理解儿童所在的环境。

本文地址:https://www.jishuxx.com/zhuanli/20240618/36740.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表