一种具身多智能体协同规划方法及装置

- 国知局

- 2024-07-30 09:27:39

本发明涉及具身智能领域,更具体的涉及一种具身多智能体协同规划方法及装置。

背景技术:

1、由于现实世界的复杂性,将大型语言模型(llm,large language model)的推理能力与具身智能体相结合是具有挑战性的。特别的,在多智能体协作任务,大语言模型需要通过规划使多个智能体的行为进行协同,具有很大的挑战。

2、llm具备大量关于世界的知识以此来进行决策,多智能体协作的规划需要llm之间沟通与推理从而产生规划结果,但由于llm缺乏任务相关的知识,只使用已编码的世界知识来进行规划可能导致llm在特定具身任务的推理中产生幻觉问题。解决该问题的直接思路是使用带有反馈的闭环控制来对规划的结果进行校正,一种方法是通过llm进行自我评价并生成反馈来改进llm的规划结果,另一种方法是利用外部环境进行物理验证,根据验证结果决定是否重新规划。

3、现有的依赖于物理验证或自我评价的方法存在需要频繁使用llm进行反馈的问题,且这些方法产生的反馈往往是稀疏的或启发式设计的,仍然缺乏有效的反馈机制来评估llm的规划结果。

技术实现思路

1、本发明实施例提供一种具身多智能体协同规划方法及装置,用于解决现有具身多智能体协作任务规划问题上存在需频繁使用llm进行反馈,以及缺乏有效反馈机制对llm的规划结果进行评估的问题。

2、本发明实施例提供一种具身多智能体协同规划方法包括:

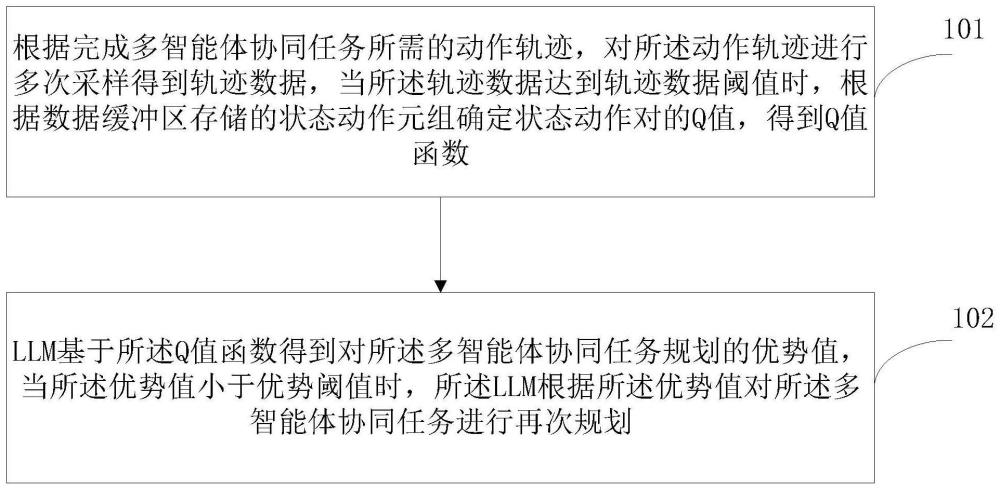

3、根据完成多智能体协同任务所需的动作轨迹,对所述动作轨迹进行多次采样得到轨迹数据,当所述轨迹数据达到轨迹数据阈值时,根据数据缓冲区存储的状态动作元组确定状态动作对的q值,得到q值函数;

4、llm基于所述q值函数得到对所述多智能体协同任务规划的优势值,当所述优势值小于优势阈值时,所述llm根据所述优势值对所述多智能体协同任务进行再次规划。

5、优选地,所述对所述动作轨迹进行多次采样得到轨迹数据之后,还包括:

6、当所述轨迹数据未达到轨迹数据阈值时,通过设定数据采集方式对所述动作轨迹进行多次采样得到采样数据,基于bert模型从所述采样数据中提取数据特征作为第一状态动作元组和第二状态动作元组,所述第一状态动作元组和所述第二状态动作元组按照先后顺序存储在所述数据缓冲区。

7、优选地,所述根据数据缓冲区存储的状态动作元组确定状态动作对的q值,得到q值函数具体包括:

8、根据确定长度的所述动作轨迹,通过下列公式确定当前时刻第一状态动作对的q值:

9、

10、其中,t表示所述动作轨迹的长度,表示t0时刻的第一状态动作对,表示t0时刻的状态,表示t0时刻的第一动作,γ表示折现因子,γ∈[0,1],表示经过t-t0次衰减后的折现因子,rt表示t时刻的环境奖励,表示t0时刻的第一状态动作对的q值。

11、优选地,所述根据数据缓冲区存储的状态动作元组确定状态动作对的q值,得到q值函数具体包括:

12、根据确定的第m个智能体的第二动作,得到从第1个智能体至第m个智能体的联合动作,基于蒙特卡洛估计确定当前时刻第二状态动作对的q值:

13、

14、其中,t表示所述动作轨迹的长度,表示当前时刻第二状态动作对的的q值,s表示状态,表示n个有序子集{1,...,m}的联合动作,n表示环境中智能体的数量,d表示数据缓冲区,i1:m代表的n个有序子集{1,...,m},-i1:m代表i1:m的补集,γt表示经过t次衰减后的折现因子,rt表示t时刻的环境奖励。

15、优选地,所述得到q值函数之后,还包括:

16、通过回归的方式学习所述q值函数,所述回归损失如下所示:

17、

18、其中,表示对数据缓冲区内所有状态联合动作对的q值的预测值与实际值的差值求期望,d表示数据缓冲区,表示n个有序子集{1,...,u}的联合动作,表示当前时刻第二状态动作对的的q值,qθ表示神经网络。

19、优选地,所述llm基于所述q值函数得到对所述多智能体协同任务规划的优势值,具体包括:

20、将当前时刻的第一状态动作对输入第一状态动作对的q值函数,得到第一状态动作对q值,将当前时刻的状态和等待动作输入第一状态动作对的q值函数,得到状态等待动作对q值,根据所述第一状态动作对q值、所述状态等待动作对q值和折现因子得到当前时刻第一动作的优势值;或者

21、按照设定顺序确定每个智能体的第二动作,根据第一个智能体至第m个智能体的联合动作以及第m个智能体的第二动作,确定当前时刻联合动作的优势值;

22、所述第一动作的优势值如下所示:

23、

24、所述联合动作的优势值如下所示:

25、a(s,a1:m-1,am)=q(s,a1:m-1,am)-q(s,a1:m-1)

26、其中,a(s,a)表示第一动作的优势值,q(s,a)表示第一状态动作对q值,q(s,w)表示状态等待动作对q值,a(s,a1:m-1,am)表示联合动作的优势值,q(s,a1:m-1,am)表示在前1:m个智能体动作的条件下,第m个智能体动作的值函数,q(s,a1:m-1)表示状态联合动作对q值。

27、优选地,所述llm基于所述q值函数得到对所述多智能体协同任务规划的优势值之后,还包括:

28、当第一动作的优势值大于优势阈值时,根据第一动作的优势值生成优势反馈;或者

29、当第二动作的优势值大于优势阈值时,将当前时刻第m个智能体的第二动作并入第一个智能体至当前时刻第m-1个智能体的联合动作,根据第一个智能体至当前时刻第m个智能体的联合动作对下一时刻第m+1个智能体进行动作规划。

30、本发明实施例提供一种具身多智能体协同规划装置,包括:

31、第一得到单元,用于根据完成多智能体协同任务所需的动作轨迹,对所述动作轨迹进行多次采样得到轨迹数据,当所述轨迹数据达到轨迹数据阈值时,根据数据缓冲区存储的状态动作元组确定状态动作对的q值,得到q值函数;

32、规划单元,用于llm基于所述q值函数得到对所述多智能体协同任务规划的优势值,当所述优势值小于优势阈值时,所述llm根据所述优势值对所述多智能体协同任务进行再次规划。

33、本发明实施例提供一种计算机设备,所述计算机设备包括存储器和处理器,所述存储器存储有计算机程序,所述计算机程序被所述处理器执行时,使得所述处理器执行上述任意一项所述的具身多智能体协同规划方法。

34、本发明实施例提供一种计算机可读存储介质,存储有计算机程序,所述计算机程序被处理器执行时,使得所述处理器执行上述任意一项所述的具身多智能体协同规划方法。

35、本发明实施例提供一种具身多智能体协同规划方法及装置,该方法包括:根据完成多智能体协同任务所需的动作轨迹,对所述动作轨迹进行多次采样得到轨迹数据,当所述轨迹数据达到轨迹数据阈值时,根据数据缓冲区存储的状态动作元组确定状态动作对的q值,得到q值函数;llm基于所述q值函数得到对所述多智能体协同任务规划的优势值,当所述优势值小于优势阈值时,所述llm根据所述优势值对所述多智能体协同任务进行再次规划。该方法通过从具体任务预采样的轨迹数据中学习q值,以此为基础衡量当前规划结果是否有益于完成当前任务。该方法为llm的每次规划结果产生优势值,根据优势值大小产生相应的强化优势反馈(reinforced advantage feedback,read)并决定是否需要对规划结果进行修正或重新规划。当q值网络学习效果较好时,能够通过优势值准确的度量当前动作对完成任务的贡献度,从而引导llm规划出贡献度更高的动作,进而减少完成任务所需的查询次数和环境交互次数。

本文地址:https://www.jishuxx.com/zhuanli/20240730/149501.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表