一种无人车及基于多模态融合的无人车导航方法、装置

- 国知局

- 2024-07-30 11:04:35

本发明属于无人车导航,尤其涉及一种无人车及基于多模态融合的无人车导航方法、装置。

背景技术:

1、本部分的陈述仅仅是提供了与本发明相关的背景技术信息,不必然构成在先技术。

2、无人车主要在室外环境中执行任务,而室外环境由于其复杂性和显著的动态性,对无人车导航任务提出了极大的挑战。作为自动驾驶技术的代表,无人车导航系统的性能直接关系到车辆在复杂、多变环境中的安全性、效率和可靠性。在当前的研究和应用中,大多数无人车导航算法主要依赖于单一模态数据,例如图像数据或激光雷达点云数据。然而,单一模态感知存在一些限制。图像数据虽然丰富,但缺乏对环境三维信息的全面理解,容易受到光照等环境因素的影响。激光雷达数据虽然能够提供空间信息,但通常是稀疏的,容易丢失关键信息。这使得在复杂的室外环境中,单一模态感知输入难以满足无人车导航需求。因此,将图像数据和激光雷达点云数据共同作为无人车感知输入对于提升无人车导航性能具有重要意义。

3、将图像数据与激光雷达点云数据进行模态融合可为无人车导航提供更丰富的环境信息与上下文信息,有助于提升无人车对环境的感知与理解,为导航决策提供强大支撑。然而,由于传感器的异质性,不同模态数据在数据结构上存在显著差异。另外,不同模态数据的信息丰富度也存在较大差异,以不同传感器数据共同作为算法输入时,算法需要准确提取数据之间的时空相关性,并消除无关信息的干扰。

4、发明人发现,现有技术为了实现基于多模态融合的无人车导航的目标,多使用transfomer网络完成无人车导航任务中的多模态融合。通过引入注意力机制,提取输入数据序列间的相关性,并根据注意力系数完成数据融合,注意力机制的加入使得无人车导航模型能够更加关注到对导航任务重要的信息,这样的数据处理方式在提升数据融合效果,但同时也产生了一些问题,该融合方式需要处理大量的数据,且不同模态的数据之间会有大量冗余,图像数据帧之间也有信息冗余,导致模型相对复杂,不仅会对决策造成一定干扰,而且推演运算所需时间长,其实时性很难满足环境的要求,尤其是在模型考虑多时间步输入或多视角输入的情况下,该问题更加明显,在一些对安全性能要求较高的场景中,这样的缺陷是十分致命的。

技术实现思路

1、为了解决上述背景技术中存在的至少一项技术问题,本发明提供一种无人车及基于多模态融合的无人车导航方法、装置,其首先提取出模态内最关键的信息再进行跨模态数据融合,融合过程中只传递该部分少量关键信息,提升无人车感知环境的能力,同时避免了模态间数据的完全访问,可以有效去除数据冗余,减少模型运算量,对模型运算速度有明显提升,有效增强了无人车导航的实时性和安全性。

2、为了实现上述目的,本发明采用如下技术方案:

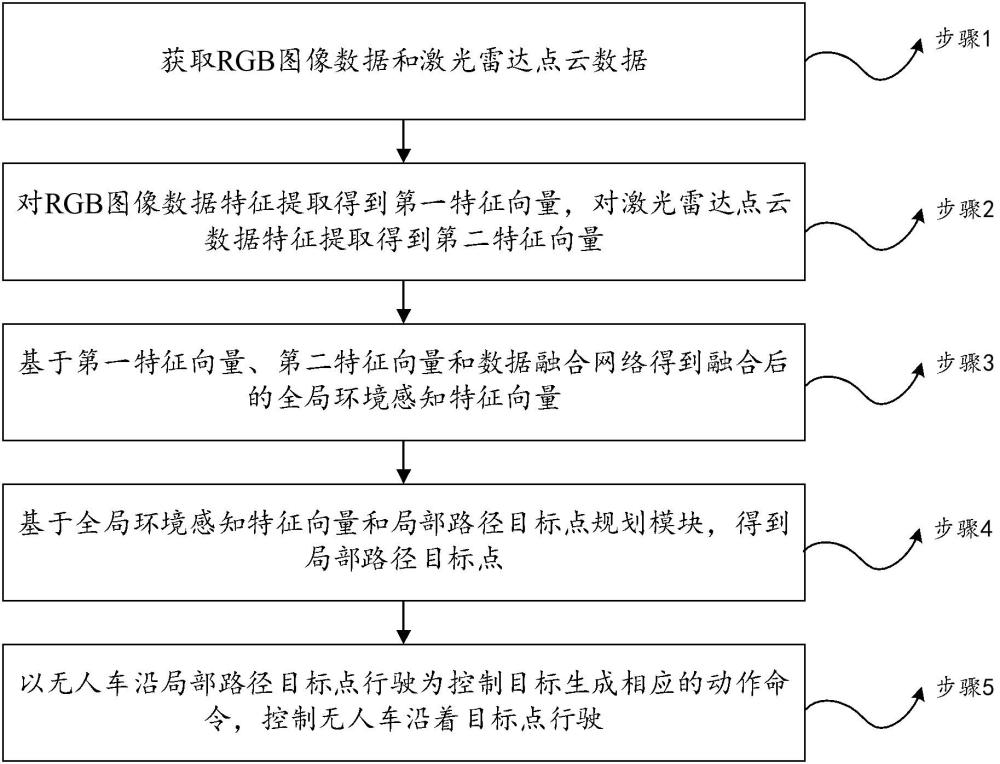

3、本发明的第一方面提供基于多模态融合的无人车导航方法,包括如下步骤:

4、获取rgb图像数据和激光雷达点云数据;

5、对rgb图像数据特征提取得到第一特征向量,对激光雷达点云数据特征提取得到第二特征向量;

6、基于第一特征向量、第二特征向量和数据融合网络得到融合后的全局环境感知特征向量;其中,数据融合网络的构建过程包括:将网络的前层作为模态内特征融合层级,在模态内特征融合层级中,分别提取第一特征向量和第二特征向量序列间的空间相关性;在网络的第层,进入模态间特征融合层级,融合不同模态经过模态内特征融合层级提取的特征,得到全局环境感知特征向量;

7、基于全局环境感知特征向量和局部路径目标点规划模块,得到局部路径目标点;其中,所述局部路径目标点规划模块包括多个gru单元,全局环境感知特征向量作为第一个gru单元的隐藏层输入,每个gru单元均以无人车t时刻的位置、目标点坐标以及隐藏层输入为输入,输出t+1时刻路径点与t时刻位置的相对坐标,基于该相对坐标和无人车t时刻的位置得到t+1时刻的目标点;

8、以无人车沿局部路径目标点行驶为控制目标生成相应的动作命令,控制无人车沿着目标点行驶。

9、进一步地,在融合不同模态经过模态内特征融合层级提取的特征后,为每个特征向量添加可学习位置编码,并将无人车的速度经过全连接网络编码后嵌入,得到新的特征向量,将新的特征向量再进行融合,将每个模态内的关键信息传送至融合通道。

10、进一步地,所述相应的动作命令包括转向命令、油门动作命令以及刹车动作命令。

11、进一步地,在控制无人车沿着目标点行驶时,使用pid控制策略进行底层动作控制,所述pid控制策略包括纵向pid控制器控制和横向pid控制器控制,其中油门和刹车由纵向pid控制器控制,转向由横向pid控制器控制,两个控制器相互独立。

12、进一步地,所述以无人车沿局部路径目标点行驶为控制目标生成相应的动作命令,控制无人车沿着目标点行驶,包括:

13、根据无人车需要经过的目标点坐标确定期望速度;

14、根据无人车当前的车速和期望速度,生成当前的车速和期望速度差值最小时对应的控制油门动作指令;

15、在预测的目标点中拟合出一条弧线,以使该弧线距离所有目标点的总距离最小,基于选定的目标点,计算目标点在弧线上的投影,根据投影计算得到期望角度,生成方向盘动作控制指令;

16、基于油门动作指令和方向盘动作控制指令控制无人车沿着目标点行驶。

17、进一步地,获取激光雷达点云数据后,对数据进行预处理,包括将激光雷达点云数据转换为固定分辨率的二维鸟瞰视角直方图。

18、进一步地,对rgb图像数据特征提取采用resnet-34,对激光雷达点云数据特征提取采用resnet-18。

19、本发明的第二方面提供基于多模态融合的无人车导航装置,包括:

20、数据获取模块,其用于获取rgb图像数据和激光雷达点云数据;

21、特征提取模块,其用于对rgb图像数据特征提取得到第一特征向量,对激光雷达点云数据特征提取得到第二特征向量;

22、特征融合模块,其用于基于第一特征向量、第二特征向量和数据融合网络得到融合后的全局环境感知特征向量;其中,数据融合网络的构建过程包括:将网络的前层作为模态内特征融合层级,在模态内特征融合层级中,分别提取第一特征向量和第二特征向量序列间的空间相关性;在网络的第层,进入模态间特征融合层级,融合不同模态经过模态内特征融合层级提取的特征,得到全局环境感知特征向量;

23、目标点规划模块,其用于基于全局环境感知特征向量和局部路径目标点规划模块,得到局部路径目标点;其中,所述局部路径目标点规划模块包括多个gru单元,全局环境感知特征向量作为第一个gru单元的隐藏层输入,每个gru单元均以无人车t时刻的位置、目标点坐标以及隐藏层输入为输入,输出t+1时刻路径点与t时刻位置的相对坐标,基于该相对坐标和无人车t时刻的位置得到t+1时刻的目标点;

24、导航模块,其用于以无人车沿局部路径目标点行驶为控制目标生成相应的动作命令,控制无人车沿着目标点行驶。

25、进一步地,特征融合模块中,在融合不同模态经过模态内特征融合层级提取的特征后,为每个特征向量添加可学习位置编码,并将无人车的速度经过全连接网络编码后嵌入,得到新的特征向量,将新的特征向量再进行融合,将每个模态内的关键信息传送至融合通道。

26、本发明的第三方面提供一种无人车。

27、一种无人车,包括第二方面所述的基于多模态融合的无人车导航装置。

28、与现有技术相比,本发明的有益效果是:

29、1、本发明基于一种高效的多模态特征融合网络,可以使各模态的数据首先提取出模态内最关键的信息再进行跨模态数据融合,融合过程中只传递该部分少量关键信息,提升无人车感知环境的能力,加深对环境的理解。

30、2、本发明基于一种高效的多模态特征融合网络,避免了模态间数据的完全访问,可以有效去除数据冗余,减少模型运算量,对模型运算速度有明显提升,有效增强了无人车导航的实时性和安全性。

31、3、通过分层式的方法,能够有效地结合全局路径规划和局部路径规划,将一个复杂的导航问题建模成一个动作决策问题和一个控制问题,使得无人车能够在复杂的城市交通环境中安全导航,实现从起点到终点的顺利行驶。

32、本发明附加方面的优点将在下面的描述中部分给出,部分将从下面的描述中变得明显,或通过本发明的实践了解到。

本文地址:https://www.jishuxx.com/zhuanli/20240730/155374.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。