一种维度驱动的去中心化联邦学习数据偏差处理方法

- 国知局

- 2024-07-31 22:55:32

本发明涉及物联网数据处理领域,尤其涉及一种维度驱动的去中心化联邦学习数据偏差处理方法(trustbcfl)。

背景技术:

1、物联网、大数据与以及深度学习技术的发展给人们的生活带来了便利,不仅极大地提高了生产效率优化资源管理,智能家居、智能交通等应用使得日常生活更加便捷,提高了生活质量;然而,随着个人隐私数据保护法律法规的日趋严格,从海量的物联网数据中获取高质量的标注数据的成本巨幅提升,使得训练数据普遍存在获取难和标签噪声等问题,通过联邦学习框架可以有效平衡数据隐私与数共享需求,进一步推动人工智能的发展。

2、联邦学习的主要关注点时数据隐私保护,但是联邦学习中模型精度与效率的提升成为研究的热点和难点;参与方的本地数据质量、模型聚合原则与算法选择以及中心服务器通信负载过重或遭受恶意攻击等是影响联邦学习中模型精度最主要的因素;因此,需要在保护数据隐私的前提下,实现高精度的模型训练。

3、在本地数据质量方面,由于成本问题缺乏高质量的标签,为了解决这一重要挑战,在集中式学习中,标签噪声处理以及校正方面涌现了一些有价值的工作,按照代表性技术路线分为损失修正方法和样本筛选方法;但在实际的联邦学习场景中,客户端数据集通常较小并且不同客户端的标签噪声水平差别很大,现有集中式的标签噪声处理方法在处理异质标签噪声时表现不佳。

4、在模型聚合原则与算法选择方面,需要防止干净数据集客户端变得恶意,避免其提交低质量的本地模型更新而影响最终模型,常用的模型筛选方法包括客户端验证、模型评估、异常检测和权重调整等,这些模型可以帮助筛选出高质量和可信度较高的客户端,但在模型筛选过程中缺少对客户端的隐私和数据安全的保障,因此检测标准、模型指标等的选择是研究的重点与难点。

5、由于传统联邦学习的中心服务器需要从客户端收集更新信息进行聚合操作,并且向这些客户端广播新的全局模型,对网络带宽要求很高;并且中心服务器发生故障而宕机、恶意破坏模型、从更新中收集客户端隐私等风险也都成为联邦学习亟待解决的问题。

技术实现思路

1、有鉴于此,本发明提供一种维度驱动的去中心化联邦学习数据偏差处理方法,平衡物联网数据隐私保护和可信共享的需求,进一步推动人工智能的发展,有效提高现有技术中联邦学习训练模型效率和精度。

2、为实现上述目的,本发明一种维度驱动的去中心化联邦学习数据偏差处理方法,包括以下步骤:

3、s1、对参加联邦学习的客户端进行注册并初始化模型,采用智能合约完成部署上链;

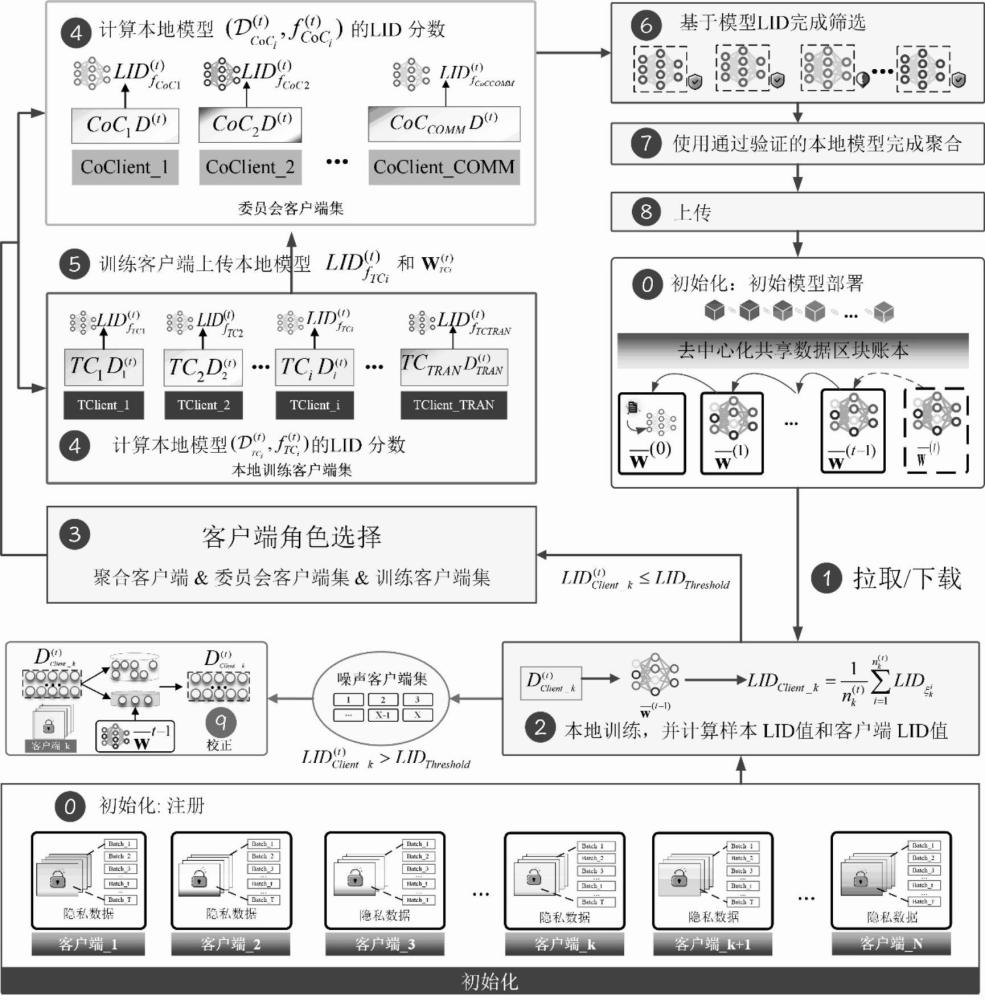

4、去中心化的联邦学习框架设计成区块链与联邦学习融合架构(trustbcfl),从数据和模型两个维度为全局模型提供双重保障,在数据层面使用基于局部内在维度(lid)的方法筛选出高质的数据;在模型层面以模型维度为依据,采用基于委员会的共识机制选出高质量的模型完成聚合;

5、s2、所有注册的客户端根据选择策略参与联邦学习,使用数据维度驱动的客户端角色分配,采用基于局部内在维度的方法给联邦学习的客户端的数据集进行评分;在每轮全局模型迭代开始时,根据客户端lid值对客户端角色重新进行分配,保证角色所包含节点的流动性;

6、s3、完成客户端角色分配后,所有训练客户端上传本地模型的lid值和本地模型权重给委员会;采用基于委员会共识的联邦学习本地模型筛选机制,对本地模型进行筛选;trustbcfl设置验证委员会,对所有训练者上传的模型lid值进行去中心化验证,提交的模型lid值在阈值范围内的训练客户端才能通过验证委员会的交叉评估,然后由聚合客户端完成模型聚合并更新全局模型;

7、s4、采用基于loss的噪声标签校正方法,使用最新的聚合模型的预测标签对被识别出的噪声样本进行重新标记,减少联邦客户端数据集中的信息丢失。

8、优选地,注册参与联邦学习的客户端clients数为n,每轮参与联邦学习的客户端clients数为k,委员会客户端(coclients)数为comm,进行本地训练的客户端(tclients)数为tran,则有tran=k-comm;设表示所有n个客户端的集合,表示所有委员会客户端的集合,表示所有训练客户端的集合;模型筛选阶段,验证合格的客户端集合记为,验证不合格的客户端集合记为;

9、记第个客户端()的本地数据集为,本地数据集中的样本数记为(||);记第t轮全局模型为,客户端k的本地模型表示为;记第t轮单个样本和本地模型权重的损失函数为,那么第个客户端的本地目标函数记为:

10、;

11、第个客户端局部梯度可表示为:

12、;

13、本地模型更新为:

14、;

15、其中,表示第t轮本地模型迭代的学习率;

16、聚合阶段有委员会客户端筛选质量较高的本地模型进行聚合,以每轮每个客户端的数据集质量和在上训练出的模型质量作为评判依据,所以局部梯度聚合为全局梯度:

17、;

18、;

19、其中,,表示验证通过客户端集合,表示第k个客户端数据集的权重,则每一轮更新的全局模型:

20、;

21、其中,表示全局学习率。

22、优选地,给定一组点x,一个参考点,以及在x中的k个最近邻,的最大似然估计(mle)为:

23、;

24、其中,表示x与其第i个最近邻之间的距离,表示x在k个最近邻中的最大距离;

25、在第t轮,客户端k的数据集,单个样本,该客户端k本地数据集中的样本数记为;对的每一个样本根据mle公式计算lid值,并对数据集所有样本的lid值累加求平均,得到客户端k的lid值:

26、。

27、优选地,所述角色包括委员会客户端、聚合客户端、本地训练客户端、噪声客户端和待命客户端;

28、在第t轮,客户端k的数据集,单个样本,该客户端k本地数据集中的样本数记为;对的每一个样本根据mle公式计算lid值,并对数据集所有样本的lid值累加求平均,得到客户端k的lid值:

29、;

30、在客户端lid值计算完成后,根据客户端lid阈值来分配客户端角色;客户端lid值大于阈值()的,则被认定为本轮的噪声客户端,直接进入步骤9噪声校正流程;客户端lid值在阈值范围内()的客户端,随机选择comm个客户端选为委员会客户端,并在委员会客户端中随机挑选一个为聚合客户端,其余的客户端为训练客户端。

31、优选地,基于委员会共识的联邦学习本地模型筛选机制对本地模型进行筛选,计算所有训练客户端和委员会客户端本地模型的lid值包括以下步骤:

32、所有训练客户端上传本地模型的lid值和本地模型权重给委员会;

33、所述委员会对每一个训练客户端上传本地的lid值进行验收,并通过共识机制筛选出合格与不合格的本地模型;

34、聚合客户端将被验证合格的训练客户端的本地模型权重聚合成本轮的全局模型并将本轮的全局模型发布上传到区块链;

35、在第t轮中选择客户端k时,根据在本地数据集上训练模型,通过mle公式计算(,)的lid分数,作为委员会客户端判断本地模型质量的依据。

36、优选地,所述共识机制先随机选择一个委员会客户端作为聚合节点,当聚合节点出现问题不能及时处理数据请求时,其他节点发起视图转换,转换成功后新的主节点开始工作;聚合节点以轮转的方式交替更换;委员会客户端共识的评判标准为本地模型的lid,即每一个委员会客户逐一对每一个训练客户端进行验证,通过委员会共识则完成模型更新的筛选,剔除训练行为不良的客户端。

37、优选地,所述共识机制是取各委员会评价值的平均值作为本地模型是否入选本轮聚合模型的标准,通过委员会投票数作为本地模型是否入选本轮聚合模型的标准,实际投票数超过一定比例可不等待掉线的委员会客户端;

38、评价标准采用欧氏距离进行计算:

39、;

40、其中,j表示实际参加评价的委员会客户端个数。

41、优选地,基于loss的噪声标签校正方法,,被识别为噪声客户端的客户端通过计算得到的每个样本的loss值,区分为噪声样本和干净样本;对所述噪声样本使用最新的全局模型的预测标签作为新标签对有噪声的样本进行重新标记,并设置置信度控制纠正力度。

42、与现有技术相比,本发明的有益效果是:

43、1、本发明采用区块链与联邦学习相结合的框架,在数据层面使用基于局部内在维度的方法能够筛选出高质的数据;在模型层面采用基于委员会的共识机制选出高质量的模型更新完成聚合;在数据和模型两个维度为全局模型提供了双重保障,解决了传统联邦学习的本地数据偏差问题和单点故障问题;

44、2、本发明采用区块链与联邦学习相结合的框架与传统的联邦学习相比,只有一个额外的lid分数,反映本地数据集质量和本地模型的预测能力,不会揭示原始输入数据的信息,有效平衡了数据隐私和数据共享需求;

45、3、本发明采用的选择策略使得作恶客户端得利的方式是谎报一个较小的lid,因此,自行上报的lid超过阈值的客户端可直接判定为噪声等级过高,直接进入校正模块,完成校正可在之后的轮次中参与训练,保证数据信息不丢失,又能减少低质量数据对全局模型的影响;并且,lid值在阈值范围内的客户端,建立委员会机制,根据客户端累计的lid和本地模型lid构成评分体系,以增加恶意节点作恶、破坏模型质量的成本,提高了系统的安全性;

46、4、本发明对噪声客户端的数据进行校正,减少了联邦客户端数据集中造成的信息丢失;

47、5、本发明在多个噪音水平和不同设置下,鲁棒性和优越性都胜过传统联邦学习方法。

本文地址:https://www.jishuxx.com/zhuanli/20240730/195348.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表