基于多视图融合和边界引导驱动的三维点云语义分割方法与流程

- 国知局

- 2024-07-31 23:06:08

本发明属于智能网联汽车环境感知,具体为基于多视图融合和边界引导驱动的三维点云语义分割方法。

背景技术:

1、基于激光雷达的语义分割在支持智能网联汽车全维感知和环境理解方面发挥着重要的作用。作为环境感知领域的关键组件,三维语义分割与人眼的功能类似,能够全面分析道路、障碍物、行人和其他关键要素的基本信息,进而从根本上提高智能网联汽车的路径规划和决策控制能力。

2、由于视觉图像对天气和照明变化的敏感性,近年来基于激光雷达点云的三维语义分割逐渐受到广泛关注。与二维图像相比,三维点云数据不仅提供了准确的环境几何距离信息,而且清晰地扫描和呈现了场景中元素之间的拓扑关系,并且点云数据对真实环境变化的适应性更强,与视觉图像相比,感知视野更广。

3、然而,在复杂背景交错的环境下,可驾驶区域和重要的目标元素对语义分割任务提出了严峻的挑战。现有研究试图解决这些挑战,但仍然面临类间语义冲突和边界分割不准确等问题。

4、针对上述问题,基于多投影融合的点云语义分割方法成为一个重要的研究方向。尽管其中的多视图融合技术具备一定的优势,但大多数研究主要面向输入级或输出级的融合,并未充分考虑来自不同投影视点的特征之间的相互作用,缺少对不同输入表示的内在联系的深入探索。因此,在复杂背景环境下,三维点云语义分割的准确率和实时性均有一定的提升的空间。

技术实现思路

1、本发明的目的在于:提出基于多视图融合和边界引导驱动的三维点云语义分割方法,该技术方案能够提高复杂背景环境下的三维点云语义分割的准确性和实时性。

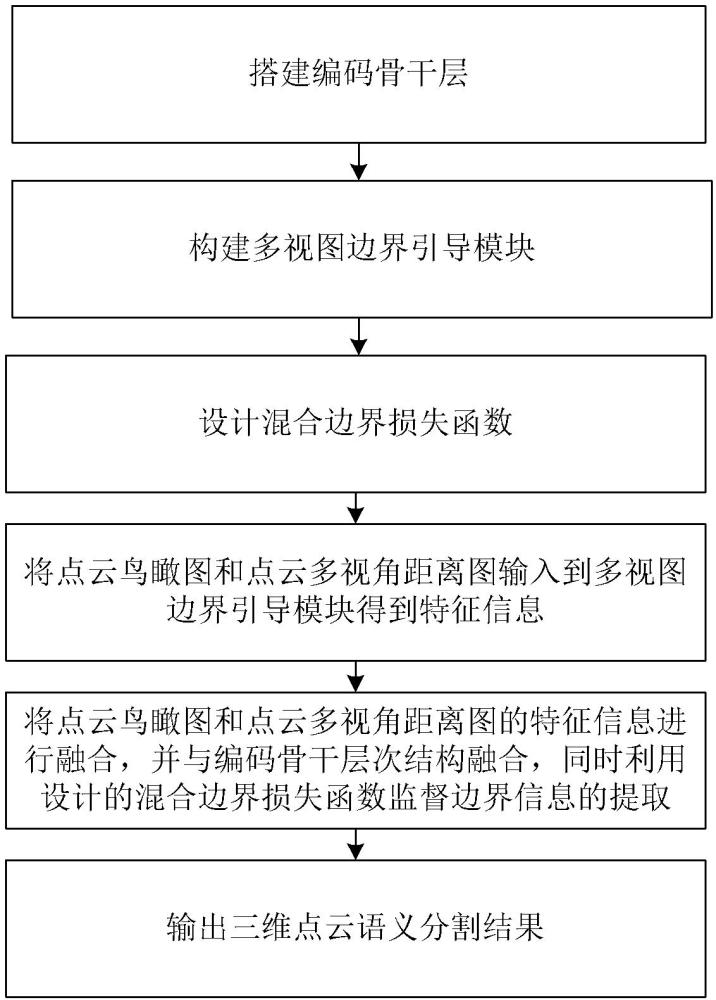

2、为实现上述目的,本公开实施例提供一种基于多视图融合和边界引导驱动的三维点云语义分割方法,包括:搭建编码骨干层;构建多视图边界引导模块,设计边界预测头;通过卷积运算扩展点云投影图像的通道数;根据通道数,将展开后的图像分割成形状相同的n个子图像;使用边界预测头生成原始图像与n个子图像之间的边界,得到子图边界;为每个子图像分配权重,将分配的权重与相应的子图相乘以获得加权子图;设计混合边界损失函数;将点云鸟瞰图和点云多视角距离图输入到多视图边界引导模块得到特征信息;将点云鸟瞰图和点云多视角距离图的特征信息进行融合,并与编码骨干层次结构融合,同时利用设计的混合边界损失函数监督边界信息的提取;输出三维点云语义分割结果。

3、基础方案的有益效果:通过构建多视图边界引导模块,能够充分利用点云数据的多视角信息。多视图可以捕捉点云数据中的不同特征和细节,从而更全面、更准确地理解点云的语义信息,有助于减少信息丢失和歧义,提高分割的准确性,多视图边界引导模块专注于边界区域的检测,这有助于减少计算量,因为系统只需要关注那些可能包含语义边界的区域,而不是整个点云。混合边界损失函数能够同时考虑不同尺度和不同视角下的边界信息,从而更有效地指导网络学习如何准确分割边界区域,有助于减少误分割的情况,从而提高分割的准确性和效率。将点云鸟瞰图和点云多视角距离图的特征信息进行融合,能够更好地捕捉点云数据的全局和局部特征,提高复杂背景环境下的三维点云语义分割的准确率。通过构建编码骨干层次结构,并将融合后的特征信息与编码骨干层次结构融合,可以充分利用骨干网络提取的特征表示。编码骨干层次结构通常具有较强的特征提取能力,通过与其融合,可以进一步提升分割结果的准确性和鲁棒性,同时利用层次化特征提取的优势,从粗到细地逐步提取特征,有助于减少计算冗余,提高处理速度。

4、本方案实现了复杂背景环境下准确、实时的三维点云语义分割,且适用于结构化和非结构化两类场景,有效地满足智能网联汽车对于精准全维感知和环境理解的需求。

5、本方案有效弥补了点云距离图可能因投影导致场景元素遮挡而丢失远处目标信息的不足,同时也弥补了点云鸟瞰图可能丢失目标垂直方向信息的缺点,进一步提高了三维点云语义分割的准确率,有效增强了智能网联汽车在复杂背景交错的挑战环境下的感知理解能力。

6、作为一种可实施的优选方案,通过计算实际边界与子图边界的相似值来分配权重,公式如下:

7、

8、

9、

10、式中,tb和fb分别表示实际边界和子图边界,tb和fb分别表示tb和fb中的边缘像素。max[d(tb, fb), d(fb, tb)]表示tb和fb之间的最大差值,表示相似值。

11、作为一种可实施的优选方案,所述边界预测头由两个全连接层组成,每层都有一个线性整流激活函数,用于学习非线性特征;采用dropout来防止过拟合,并使用单通道卷积的输出来预测边界信息。

12、作为一种可实施的优选方案,设计混合边界损失函数,包括以下内容:

13、边界损失函数如下:

14、

15、

16、式中,lbev和lriv分别表示点云鸟瞰图和点云距离图编码分支的损失,pb和pr分别表示点云鸟瞰图和点云距离图编码分支的边界预测结果,tb和tr分别为点云鸟瞰图和点云距离图的实际边界;

17、采用lovasz-softmax和交叉熵来表征实际点云与预测点云之间的不相似度 lrb,可表示为;

18、

19、式中,表示损失函数,表示交叉熵损失函数, tp和 pp分别表示语义点云的真值和预测的语义点云;

20、以 lbev、 lriv和 lrb之和作为总损失。

21、作为一种可实施的优选方案,将点云鸟瞰图输入到多视图边界引导模块,包括以下内容:

22、点云鸟瞰图在执行多视图边界引导模块处理后,得到第一处理结果;利用基于最大池化的多层感知机采集每个点云鸟瞰图网格的特征信息,得到第二处理结果;将第一处理结果与第二处理结果在通道级别进行连接,并使用卷积操作恢复通道维度。

23、作为一种可实施的优选方案,将点云多视角距离图输入到多视图边界引导模块,包括以下内容:

24、将通过球面投影的点云多视角距离图输入到多视图边界引导模块中,得到边界增强的点云多视角距离图图像和实际边界。

25、作为一种可实施的优选方案,将点云鸟瞰图和点云多视角距离图的特征信息进行融合,包括以下内容:

26、将点云鸟瞰图的特征图作为查询,将点云多视角距离图的特征图作为键和值;将点云多视角距离图的特征映射作为查询,将点云鸟瞰图的特征映射作为键和值。

27、作为一种可实施的优选方案,点云鸟瞰图和点云多视角距离图的特征信息进行融合,还包括以下内容:

28、利用多头注意力机制产生融合的点云鸟瞰图和融合的点云多视角距离图,公式如下:

29、

30、

31、式中,q、k、v分别表示查询、键和值,dk表示k的维度,i表示注意头的个数,headi表示第i个注意的输出。

本文地址:https://www.jishuxx.com/zhuanli/20240730/195950.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表