一种用于高效定位目标的深度卷积神经网络注意力机制的制作方法

- 国知局

- 2024-07-31 23:06:26

本发明涉及计算机视觉注意力,具体指一种用于图像目标定位的深度卷积神经网络的注意力机制。

背景技术:

1、深度卷积神经网络是计算机视觉领域中重要的研究方向,在图像分类、目标检测、语义分割等领域中取得了很多重要的成果,并且出现了一系列的优秀模型,比如vgg[1]、resnet[2]、yolo[3]、mobilenet[4-5]等模型。设计更高效的模型结构仍是当前研究者要解决的重要问题[6-7]。

2、在深度卷积神经网络中,注意力机制可以帮助神经网络集中地关注重要的信息,同时减少对不重要信息的关注,从而使卷积神经网络获得更好的性能。最具有代表的se-net(se)[8]注意力机制,利用二维全局池化对特征图的空间进行压缩,然后在通道维度进行特征学习,为各种深度的卷积神经网络架构带来明显的性能提升。然而,se注意力只考虑对通道间信息的编码,忽略了特征图的空间位置信息。随后,注意力模块在这两个方向的发展很突出:(1)聚合通道特征的方式;(2)结合通道维度与空间维度的方式。具体而言,cbam[10]同时使用平均池化和最大池化在通道维度和空间维度上聚合特性。gcnet[18]是一种依靠自注意力机制、非局部网络和挤压-激励网络等技术的改进而得到的轻量级注意力网络。sa[19]在空间注意力与通道注意力的基础上,引入了特征分组与通道置换,得到了一种轻量型的注意力机制。cbam[10],gcnet[18]、和sa[19]将空间注意和通道注意连续地结合起来。gsop[20]引入了二阶池化对整体图像进行高阶统计建模,增强了深卷积网的非线性建模能力。eca-net(eca)[21]采用了一个一维卷积滤波器来生成通道注意力权重,大大降低了se的模型复杂性。gsop[20]和eca[21]属于通道增强聚合的方式。然而上述的注意力网络中,要么缺乏对空间维度的长距离依赖;要么存在通道维关注对象的位置信息。虽然通过对通道的降维可以降低模型的复杂度,但它也破坏了通道及其权重之间的直接对应关系。

3、另外,bam[9]和cbam[10],虽然在空间维度上提取注意力信息,但是他们不但无法对视觉任务所必需的长距离依赖性进行建模[11],而且也降低输入特征图的通道维度。后来的coordinate attention(ca)[12]是通过将空间位置信息嵌入到通道注意力,使得移动网络利用位置信息在空间上捕捉长距离的相互关系,进而为许多卷积神经网络架构带来有效的性能提升。但是ca注意力同样降低了输入张量的通道维度,见图1,而且它应用在小模型上或者小bach size的模型训练中,往往会带来明显的伤害[13],见表1和表2。

4、图片的空间维度含有很重要的位置信息,然而现有的注意力机制要么不能有效地利用空间信息,要么在利用空间信息的同时,却以降低通道维度为代价。

技术实现思路

1、本发明提供一种用于高效定位目标的深度卷积神经网络注意力机制,其在不对输入特征图进行通道降维的情况下,就能获得很好的空间维度的位置注意力预测,还能同时保持注意力模块的轻便。

2、本发明所采用的技术方案为:

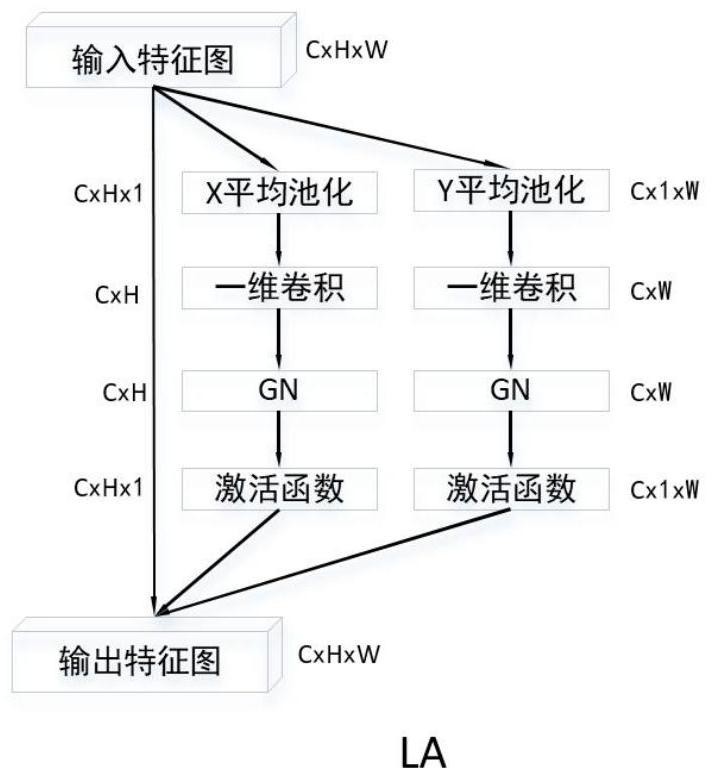

3、一种用于高效定位目标的深度卷积神经网络注意力机制,该注意力机制为定位注意力local atention la,在空间维度上采用条形池化strip pooling来获取水平和垂直方向的特征向量,该向量具有丰富的目标位置信息;针对上述两个方向的特征向量,使用一维卷积分别对其进行局部交互,随后利用分组归一化group nomalization,gn和非线性激活函数sigmoid独立地再将其编码以生成相应方向的注意力,最后以乘积运算将其组合得到最终的定位注意

4、该注意力机制的具体实现:设一个卷积块的输出为其中c表示输入特征图的通道,h、w则表示输入特征图的高和宽,使用条形池化strip pooling在两个空间范围(h,1)和(1,w)分别沿水平方向和垂直方向对每个通道进行平均池化;公式(1)和公式(2)表示高度h处的第c个通道的和宽度w处的第c个通道的特征向量,

5、

6、使用一维卷积对两个方向的特征向量进行局部交互,再使用分组归一化gn和激活函数对其编码,就得到水平和垂直方向的位置注意力表示,见公式(7)和公式(8);

7、yh=σ(gn(fh(zh))), (7)

8、yw=σ(gn(fw(zw))), (8)

9、其中,σ是非线性激活函数sigmoid;gn,group nomalization表示分组归一化;fh和fw表示一维depthwise convolution,作为水平和垂直方向的位置注意力表示;最后,通过公式(9)获得定位注意力块yc的输出;

10、yc=xc×yh×yw, (9)。

11、更进一步的:

12、对于所述的fh、fw和gn的超参数配置为:kernel_size=5,groups=in_channels,num_group=32;命名为la-b模块。

13、对于所述的fh、fw和gn的超参数配置为:kernel_size=7,groups=in_channels,num_group=16;命名为la-t模块。

14、对于所述的fh、fw和gn的超参数配置为:kernel_size=5,groups=in_channels/8,num_group=16;命名为la-s模块。

15、对于所述的fh、fw和gn的超参数配置为:kernel_size=7,groups=in_channels/8,num_group=16;命名为la-l模块。

16、本发明提出基于深度卷积神经网络的定位注意力(la)模块,该模块可以准确捕获感兴趣区域的位置,保持输入特征图通道维数不变,并保留其轻量的特征,如图2所示。本发明在imagenet[15]、ms coco[16]、pascal voc[17]上的实验结果(如表4、表5和表6)表明,本发明的定位注意力(la)方法比当前最先进的方法具有更高的精度,同时在参数量和复杂度上具有非常好的竞争性。

技术特征:1.一种用于高效定位目标的深度卷积神经网络注意力机制,其特征在于,该注意力机制为定位注意力localatention la,在空间维度上采用条形池化strip pooling来获取水平和垂直方向的特征向量,该向量具有丰富的目标位置信息;针对上述两个方向的特征向量,使用一维卷积分别对其进行局部交互,随后利用分组归一化group nomalization,gn和非线性激活函数sigmoid独立地再将其编码以生成相应方向的注意力,最后以乘积运算将其组合得到最终的定位注意力。

2.根据权利要求1所述的一种用于高效定位目标的深度卷积神经网络注意力机制,其特征在于,该注意力机制的具体实现:设一个卷积块的输出为其中c表示输入特征图的通道,h、w则表示输入特征图的高和宽,使用条形池化strip pooling在两个空间范围(h,1)和(1,w)分别沿水平方向和垂直方向对每个通道进行平均池化;公式(1)和公式(2)表示高度h处的第c个通道的和宽度w处的第c个通道的特征向量,

3.根据权利要求2所述的一种用于高效定位目标的深度卷积神经网络注意力机制,其特征在于,

4.根据权利要求2所述的一种用于高效定位目标的深度卷积神经网络注意力机制,其特征在于,

5.根据权利要求2所述的一种用于高效定位目标的深度卷积神经网络注意力机制,其特征在于,

6.根据权利要求2所述的一种用于高效定位目标的深度卷积神经网络注意力机制,其特征在于,

技术总结一种用于高效定位目标的深度卷积神经网络注意力机制,该注意力机制为定位注意力Local Atention LA,在空间维度上采用条形池化strip pooling来获取水平和垂直方向的特征向量,该向量具有丰富的目标位置信息;针对上述两个方向的特征向量,使用一维卷积分别对其进行局部交互,随后利用分组归一化Group Nomalization,GN和非线性激活函数Sigmoid独立地再将其编码以生成相应方向的注意力,最后以乘积运算将其组合得到最终的定位注意力。本发明在不对输入特征图进行通道降维的情况下,就能获得很好的空间维度的定位注意力,还能同时保持注意力模块的轻便。技术研发人员:徐伟,万毅受保护的技术使用者:北京三狮科技有限公司技术研发日:技术公布日:2024/7/29本文地址:https://www.jishuxx.com/zhuanli/20240730/195990.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表