基于多分支神经网络的动态协同推演处理方法及装置

- 国知局

- 2024-07-31 23:12:20

本发明涉及人工智能,具体涉及一种基于多分支神经网络的动态协同推演处理方法及装置。另外,还涉及一种电子设备及处理器可读存储介质。

背景技术:

1、近年来,随着人工智能和深度学习的快速发展,深度神经网络(deep neuralnetwork)已经在计算机视觉、自然语言处理等各种智能应用中取得了巨大的成功。深度神经网络通过对各类输入数据进行复杂的特征提取来实现精确推理,随着模型在深度和宽度方面的复杂度提升,推理过程对计算能力、存储资源和能耗提出了更高的要求。边缘计算的出现和物联网设备的普及导致网络边缘生成的智能服务需求激增,直接在资源受限的边缘设备上执行模型推理在计算能力、能源效率和时延方面提出了重大挑战。为此,目前已有大量的研究工作探索了在边缘设备上进行高效推理的方法,其中,利用多个设备的资源执行协同推理是一种有效的推理方法。此外,在推理执行期间,设备的实际可用资源与物联网设备生成的输入数据的处理难度具有波动性,并非所有的输入数据都需要相同量级的计算才能产生一个满足服务质量需求的推理结果。对所有输入数据执行相同的模型计算对于提升推演性能十分不利,特别是在设备资源受限的边缘计算场景下,对简单数据应用和困难数据相同的模型会造成资源浪费和时延增加。针对上述问题,动态推理技术成为一个重要的研究方向。

2、动态推理是一种新兴的神经网络模型推理技术,其意义在于能够在资源受限的边缘设备上实现高效、自适应的模型推理。模型动态推理方法通过动态调整推理计划,从而适应不同的输入数据、业务需求以及资源的波动。具体而言,实现动态推理的主要方法包括动态模型早退、动态省略局部模型计算以及动态选择模型变体等。基于并非所有的输入数据都需要相同的计算量来产生一个可靠的预测这一事实,动态模型早退作为一种有效的动态推理技术获得了广泛关注。动态早退基于多分支神经网络,利用不同分支来对输入数据应用不同量级的计算,在运行时定制每个输入数据的计算深度并提前终止推理过程,从而适应每个推理请求的输入数据推理难度或设备运行时的可用资源,实现推理精度和资源消耗之间的均衡。动态省略局部模型计算包括跳过某些网络块或卷积滤波器的计算,这些方法通常利用网络架构中的可训练的门控组件。然而,这使训练过程变得复杂,并限制了在不同硬件上有效部署的灵活性。动态选择模型变体是一种与动态模型早退更密切相关的方法,通过训练一系列具有不同时延和精度规格的模型,并将所有模型部署在目标设备上。在推理时,通过各种识别机制为每个输入选择最合适的模型,或将模型结构级联,并逐步传播到更复杂的模型,直到满足性能标准。对于困难的输入,可以通过许多级联阶段传播而不重复使用之前的计算可以获得更好的性能,然而这类方法对目标设备的内存提出了更高的要求,相对动态早退技术而言灵活性更差。上述方法均是针对单节点模型推理提出的动态推理技术,存在一定的局限性。因此,如何提供一种更为高效的基于多分支神经网络的动态协同推演处理方案成为亟待解决的技术问题。

技术实现思路

1、为此,本发明提供一种基于多分支神经网络的动态协同推演处理方法及装置,以解决现有技术中存在的动态协同推演处理方案局限性较高,导致实际的动态协同推理处理效率和性能较差,推理计算开销较大的缺陷。

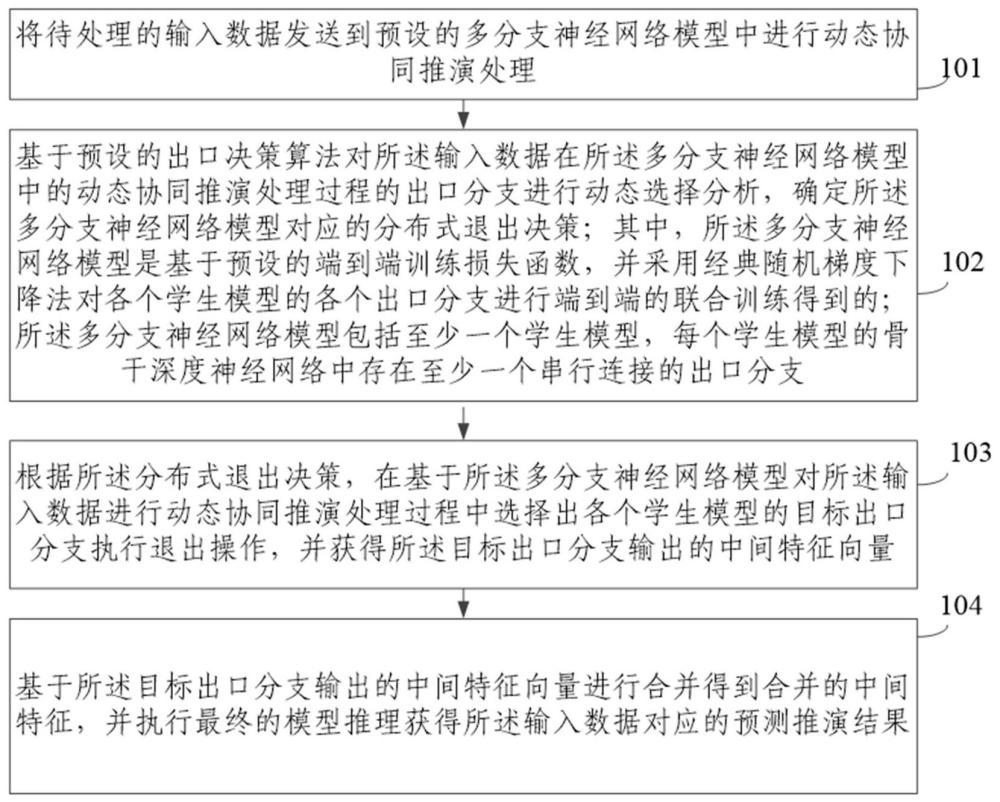

2、第一方面,本发明提供一种基于多分支神经网络的动态协同推演处理方法,包括:

3、将待处理的输入数据发送到预设的多分支神经网络模型中进行动态协同推演处理;

4、基于预设的出口决策算法对所述输入数据在所述多分支神经网络模型中的动态协同推演处理过程的出口分支进行动态选择分析,确定所述多分支神经网络模型对应的分布式退出决策;其中,所述多分支神经网络模型是基于预设的端到端训练损失函数,并采用经典随机梯度下降法对各个学生模型的各个出口分支进行端到端的联合训练得到的;所述多分支神经网络模型包括至少一个学生模型,每个学生模型的骨干深度神经网络中存在至少一个串行连接的出口分支;

5、根据所述分布式退出决策,在基于所述多分支神经网络模型对所述输入数据进行动态协同推演处理过程中选择出各个学生模型的目标出口分支执行退出操作,并获得所述目标出口分支输出的中间特征向量;

6、基于所述目标出口分支输出的中间特征向量进行合并得到合并的中间特征,并执行最终的模型推理获得所述输入数据对应的预测推演结果。

7、进一步的,所述基于预设的出口决策算法对所述输入数据在所述多分支神经网络模型中的动态协同推演处理过程的出口分支进行动态选择分析,确定所述多分支神经网络模型对应的分布式退出决策,具体包括:

8、获得输入的控制时延权重参数、出口分支个数及所述输入数据的平均推演时间上界;其中,所述控制时延权重参数为预设的控制所述多分支神经网络模型的预估精度和推演时延的相对权重参数,所述出口分支个数为所述多分支神经网络模型中所述学生模型中存在的出口分支的数量,所述平均推演时间上界为每个输入数据对应的最大推演时间;

9、基于所述预设的出口决策算法、所述控制时延权重参数、所述出口分支个数及每个输入数据的所述平均推演时间上界进行期望奖励分析,确定最大期望奖励的出口分支;

10、将最大期望奖励的出口分支作为所述多分支神经网络模型中各个学生模型对应的目标出口分支,基于所述多分支神经网络模型中各个学生模型对应的目标出口分支,获得所述多分支神经网络模型对应的分布式退出决策。

11、进一步的,在将待处理的输入数据发送到预设的多分支神经网络模型中进行动态协同推演处理之前,还包括:

12、确定所述多分支神经网络模型中各个学生模型的出口分支的端到端训练损失函数;其中,所述端到端训练损失函数用于联合训练所述多分支神经网络模型,使得所述多分支神经网络模型中的每个学生模型的各个出口分支都能有效学习到教师模型的知识;

13、基于所述端到端训练损失函数,并采用经典随机梯度下降法对所述多分支神经网络模型中的每个学生模型的各个出口分支进行端到端的联合训练,获得预设的多分支神经网络模型。

14、进一步的,所述基于所述预设的出口决策算法、所述控制时延权重参数、所述出口分支个数及所述输入数据的所述平均推演时间上界进行期望奖励分析,确定最大期望奖励的出口分支,具体包括:

15、在基于所述预设的出口决策算法、所述控制时延权重参数、所述出口分支个数及所述输入数据的所述平均推演时间上界进行期望奖励分析时,采用上置信界算法进行计算,获得最大期望奖励的出口分支。

16、进一步的,所述在基于所述预设的出口决策算法、所述控制时延权重参数、所述出口分支个数及所述输入数据的所述平均推演时间上界进行期望奖励分析时,采用上置信界算法进行计算,获得最大期望奖励的出口分支,具体包括:

17、针对第一个输入数据,选择所述多分支神经网络模型中串行连接的最后一个出口分支作为目标出口分支,记录相应的推理时延,并观测第一个输入数据在所述多分支神经网络模型中串行连接的各个出口分支输出的中间特征向量,用于计算每个出口分支观测到的平均奖励,获得观测信息;采用上置信界算法对所述观测信息进行分析,基于霍夫丁不等式来选择不确定性度量的目标取值参数;

18、对于之后的每个输入数据,基于所述控制时延权重参数、所述出口分支个数、所述输入数据的所述平均推演时间上界以及所述目标取值参数进行分析,获得最大期望奖励的出口分支。

19、进一步的,所述基于所述多分支神经网络模型中各个学生模型对应的目标出口分支,获得所述多分支神经网络模型对应的分布式退出决策,具体包括:

20、基于所述多分支神经网络模型中各个学生模型对应的目标出口分支,确定所述多分支神经网络模型中各个学生模型对应的退出决策,并基于所述各个学生模型对应的退出决策进行综合分析,形成所述多分支神经网络模型对应的分布式退出决策。

21、进一步的,所述多分支神经网络模型包括的至少一个学生模型分别运行在边缘集群的边缘设备中,用于多节点协同推演处理。

22、第二方面,本发明还提供一种基于多分支神经网络的动态协同推演处理装置,包括:

23、协同推演处理控制单元,用于将待处理的输入数据发送到预设的多分支神经网络模型中进行动态协同推演处理;

24、分布式退出决策分析单元,用于基于预设的出口决策算法对所述输入数据在所述多分支神经网络模型中的动态协同推演处理过程的出口分支进行动态选择分析,确定所述多分支神经网络模型对应的分布式退出决策;其中,所述多分支神经网络模型是基于预设的端到端训练损失函数,并采用经典随机梯度下降法对各个学生模型的各个出口分支进行端到端的联合训练得到的;所述多分支神经网络模型包括至少一个学生模型,每个学生模型的骨干深度神经网络中存在至少一个串行连接的出口分支;

25、分布式退出决策执行单元,用于根据所述分布式退出决策,在基于所述多分支神经网络模型对所述输入数据进行动态协同推演处理过程中选择出各个学生模型的目标出口分支执行退出操作,并获得所述目标出口分支输出的中间特征向量;

26、协同推演结果整合单元,用于基于所述目标出口分支输出的中间特征向量进行合并得到合并的中间特征,并执行最终的模型推理获得所述输入数据对应的预测推演结果。

27、进一步的,所述分布式退出决策分析单元,具体用于:

28、获得输入的控制时延权重参数、出口分支个数及所述输入数据的平均推演时间上界;其中,所述控制时延权重参数为预设的控制所述多分支神经网络模型的预估精度和推演时延的相对权重参数,所述出口分支个数为所述多分支神经网络模型中所述学生模型中存在的出口分支的数量,所述平均推演时间上界为每个输入数据对应的最大推演时间;

29、基于所述预设的出口决策算法、所述控制时延权重参数、所述出口分支个数及每个输入数据的所述平均推演时间上界进行期望奖励分析,确定最大期望奖励的出口分支;

30、将最大期望奖励的出口分支作为所述多分支神经网络模型中各个学生模型对应的目标出口分支,基于所述多分支神经网络模型中各个学生模型对应的目标出口分支,获得所述多分支神经网络模型对应的分布式退出决策。

31、进一步的,在将待处理的输入数据发送到预设的多分支神经网络模型中进行动态协同推演处理之前,还包括:

32、多分支网络联合训练单元,具体用于:

33、确定所述多分支神经网络模型中各个学生模型的出口分支的端到端训练损失函数;其中,所述端到端训练损失函数用于联合训练所述多分支神经网络模型,使得所述多分支神经网络模型中的每个学生模型的各个出口分支都能有效学习到教师模型的知识;

34、基于所述端到端训练损失函数,并采用经典随机梯度下降法对所述多分支神经网络模型中的每个学生模型的各个出口分支进行端到端的联合训练,获得预设的多分支神经网络模型。

35、进一步的,所述基于所述预设的出口决策算法、所述控制时延权重参数、所述出口分支个数及所述输入数据的所述平均推演时间上界进行期望奖励分析,确定最大期望奖励的出口分支,具体包括:

36、在基于所述预设的出口决策算法、所述控制时延权重参数、所述出口分支个数及所述输入数据的所述平均推演时间上界进行期望奖励分析时,采用上置信界算法进行计算,获得最大期望奖励的出口分支。

37、进一步的,所述在基于所述预设的出口决策算法、所述控制时延权重参数、所述出口分支个数及所述输入数据的所述平均推演时间上界进行期望奖励分析时,采用上置信界算法进行计算,获得最大期望奖励的出口分支,具体包括:

38、针对第一个输入数据,选择所述多分支神经网络模型中串行连接的最后一个出口分支作为目标出口分支,记录相应的推理时延,并观测第一个输入数据在所述多分支神经网络模型中串行连接的各个出口分支输出的中间特征向量,用于计算每个出口分支观测到的平均奖励,获得观测信息;采用上置信界算法对所述观测信息进行分析,基于霍夫丁不等式来选择不确定性度量的目标取值参数;

39、对于之后的每个输入数据,基于所述控制时延权重参数、所述出口分支个数、所述输入数据的所述平均推演时间上界以及所述目标取值参数进行分析,获得最大期望奖励的出口分支。

40、进一步的,所述基于所述多分支神经网络模型中各个学生模型对应的目标出口分支,获得所述多分支神经网络模型对应的分布式退出决策,具体包括:

41、基于所述多分支神经网络模型中各个学生模型对应的目标出口分支,确定所述多分支神经网络模型中各个学生模型对应的退出决策,并基于所述各个学生模型对应的退出决策进行综合分析,形成所述多分支神经网络模型对应的分布式退出决策。

42、进一步的,所述多分支神经网络模型包括的至少一个学生模型分别运行在边缘集群的边缘设备中,用于多节点协同推演处理。

43、第三方面,本发明还提供一种电子设备,包括:存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,处理器执行所述计算机程序时实现如上述任意一项所述的基于多分支神经网络的动态协同推演处理方法的步骤。

44、第四方面,本发明还提供一种处理器可读存储介质,所述处理器可读存储介质上存储有计算机程序,该计算机程序被处理器执行时实现如上述任意一项所述的基于多分支神经网络的动态协同推演处理方法的步骤。

45、本发明提供的基于多分支神经网络的动态协同推演处理方法,通过将输入数据发送到多分支神经网络模型中进行动态协同推演处理,基于出口决策算法对输入数据在多分支神经网络模型中的动态协同推演处理过程的出口分支进行动态选择分析,确定对应的分布式退出决策;根据分布式退出决策,在基于多分支神经网络模型对输入数据进行动态协同推演处理过程中选择出各个学生模型的目标出口分支执行退出操作,并基于目标出口分支输出的中间特征向量获得输入数据对应的预测推演结果,能够实现高效的动态协同推理,同时显著降低推理计算开销,从而优化整体的推理性能。

本文地址:https://www.jishuxx.com/zhuanli/20240730/196398.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表